|

|

|

|

|

| NUMERO 690 |

|

|

|

|

|

|

|

Edition du 22 Février 2013

|

|

|

|

|

Edito

L’avenir formidable souvent trop méconnu de l’Énergie Éolienne

Selon le Conseil Mondial pour l’Energie Eolienne, l’éolien représente 282 GW de puissance installée (+ 19 % en 2012, soit 45 GW supplémentaires) au niveau mondial (dont 35 % en Europe et 2,5 % en France) et cette énergie renouvelable reste de loin la plus importante après l’énergie hydraulique (750 GW installés) mais loin devant le solaire qui vient seulement de passer la barre des 100 GW. A titre de comparaison, la puissance mondiale installée en nucléaire est de l’ordre de 370 MW.

En terme de production effective d’électricité, l’éolien représente à présent plus de 500 TWh par an dans le monde, soit l’équivalent de la consommation totale d’électricité de la France mais même si cette production a été multipliée par trois en 5 ans, elle représente toujours moins de 3 % de la production électrique mondiale qui est de l’ordre de 21 000 TWH par an.

La puissance éolienne installée dans le monde devrait être multipliée par trois pour atteindre 910 GW en 2025 et le marché mondial de l'éolien devrait, pour sa part, plus que doubler au cours de cette période, passant de 21 à 47 milliards d'euros.

Le Président Obama a d'ailleurs souligné, le 13 février « qu'en 2012, l'énergie éolienne a représenté près de la moitié des nouvelles capacités de production d’électricité aux Etats-Unis ».

Hors énergies fossiles, qui assurent encore les deux tiers de la production électrique mondiale, la première source d’énergie renouvelable reste de loin l’hydraulique, 16 % de l’électricité mondiale, suivie par le nucléaire, environ 14 %.

En supposant que nous parvenions à stabiliser à son niveau actuel la production mondiale d’électricité et que nous visions l’objectif de faire passer la part d’électricité éolienne à 33 % d’ici 20 ans (la part du nucléaire et de l’hydraulique restant au même niveau), il faudrait installer environ 230 000 machines marines d’une puissance de 8 à 10 MW (production moyenne annuelle en mer de 30 millions de kWh), soit un peu moins de 12 000 éoliennes marines par an, un rythme élevé mais nullement hors de portée de l’économie mondiale.

Selon le récent rapport du cabinet de conseil GlobalData, le marché mondial de l’éolien marin va d’ailleurs continuer sa croissance et pourrait être multiplié par dix d'ici la fin de la décennie, passant de 5 gigawatts de puissance installée à 55 GW.

En Europe, on estime généralement que le coût moyen de production du kWh éolien terrestre tourne autour de 7 centimes d’euros (13 centimes sur mer) mais aux Etats-Unis, le Laboratoire National Lawrence Berkeley estime que le coût du kWh éolien tourne autour de 5 à 6 centimes d’euro et que l'électricité éolienne devient compétitive face au nucléaire et au gaz. Il est vrai que le coût moyen de production de l'électricité éolienne a été divisé par cinq en 30 ans et la puissance moyenne d'une machine a été multipliée par dix depuis 1980.

Néanmoins, en dépit de sa progression impressionnante, tant au niveau mondial qu’européen et national, il existe toujours de fortes oppositions au développement massif de l’éolien.

Parmi les nombreux arguments avancés par ces opposants, on trouve en bonne place des affirmations de nature économique et une prédiction récurrente : le développement de l’éolien entraînera inévitablement une explosion de la facture d’électricité pour les consommateurs.

Or, une étude publiée il y a quelques jours ne va pas manquer d’alimenter le débat sur la transition énergétique et sur la place que peut avoir l’éolien dans notre futur bouquet énergétique national.

Ce rapport, qui a été réalisé par le Cabinet E-CUBE Strategy Consultants et s’intitule "La valeur et les coûts de l'éolien sur le système électrique en France", est riche d’enseignements et démonte quelques idées reçues (Voir rapport).

Ce rapport souligne tout d’abord que l’augmentation de la part d’électricité éolienne devrait, à long terme, entraîner une diminution du prix de l’électricité.

L’étude table sur une baisse pouvant aller jusqu’à 10 % à l’horizon 2030 car cette électricité d’origine éolienne, dont le coût de production ne cesse de baisser, va se substituer à d’autres sources d’énergie qui, au contraire, ont un coût de production de plus en plus élevé : nucléaire (à cause du surcoût lié au renforcement de la sécurité) et fossiles.

Concrètement, la valeur de substitution de l’énergie pourrait atteindre le niveau du tarif d’achat actuel vers 2025 (82 euros le MWh) et l’éolien réduirait dans ce cas la facture d’électricité pour le consommateur à partir de cette échéance, entraînant à l’horizon 2030, une économie de 10 centimes d’euro par kWh éolien pour le consommateur.

Cette étude montre également que la montée en puissance de l’éolien peut contribuer à absorber les pics de consommation électrique hivernaux, comme l’a montré la situation réelle observée en décembre 2012, mois pendant lequel la part de l’éolien dans la production totale d’électricité est montée au niveau historique de 8 %.

Si nous parvenons, même avec deux ou trois ans de retard, à tenir nos objectifs et à passer de 7 500 MW éoliens installés en 2013 à 19 000 dans dix ans, nous serons alors en mesure de produire environ 55 TWH par an (10 % de notre production électrique annuelle) et l'éolien pourra, dans cette hypothèse, non seulement faire face à la consommation de pointe d'environ un million de ménages, mais également éviter le recours à l’utilisation d’une dizaine de centrales thermiques de 500 MW, réduisant de plusieurs millions de tonnes les émissions de gaz à effet de serre.

Autre idée reçue battue en brèche par ce rapport : la montée en charge de l’électricité éolienne va entraîner des coûts faramineux d’adaptation de notre réseau électrique. Cette analyse conteste cette affirmation et montre que le surcoût réel, directement imputable à l’éolien, pour la modernisation de notre réseau, sera de l’ordre de 0,1 centime d’euro le kWh éolien en 2020, ce qui est tout à fait supportable pour ERDF.

Enfin, ce rapport souligne que, contrairement à ce qu’affirment les opposants irréductibles à l’éolien, la forte progression de cette source d’énergie depuis 10 ans n’a pas nécessité la mise en service de centrales supplémentaires « d’équilibre », utilisant les énergies fossiles.

Cette étude, ainsi que différents travaux réalisés aux Etats-Unis et en Grande-Bretagne, confirme donc qu’il est tout à fait envisageable, tant sur le plan économique qu’industriel et technologique, de viser pour 2030 l’objectif des 20 % de la production mondiale d’électricité à partir de l’éolien, soit environ 5000 TWH éoliens, ce qui représente 8 500 éoliennes marines géantes à mettre en service chaque année pendant 20 ans dans le monde (Sur la base d'une hypothèse d’une croissance modérée de 20 % de la consommation électrique mondiale d'ici 2030).

Mais bien entendu, l’éolien ne saurait en aucun cas constituer à lui seul une panacée au défi énergétique majeur que nous devons affronter. Son développement massif n'a de sens et d'intérêt qu'en synergie intelligente avec, d'une part l'énergie solaire et la biomasse, comme sources propres d'énergie et, d'autre part, en articulation avec les nouvelles technologies puissantes de stockage de l'énergie (batteries liquides, stockage sous forme de gaz, d'air ou d'hydrogène) et enfin avec la gestion intelligente, décentralisée et interactive, en grille, du réseau électrique.

Il faut également le rappeler inlassablement, dans l’équation énergétique et climatique, les énergies renouvelables, certes indispensables, ne représentent qu’un tiers de la solution ; les deux tiers restants sont à chercher dans la réduction à la source de nos besoins en énergie et dans une véritable rupture en terme d’efficacité énergétique dans tous les domaines d’activités.

Il n’en demeure pas moins vrai, comme l’ont parfaitement compris l’Allemagne, la Grande-Bretagne, les Etats-Unis mais également la Chine ou le Japon, que l’énergie éolienne, principalement en mer, sera pendant au moins quelques décennies la source d’énergie propre la plus efficace et la plus rentable sur le plan économique pour la substitution massive aux énergies fossiles en matière de production électrique.

Souhaitons que la France, qui dispose à la fois d’un vaste domaine maritime, et des compétences technologiques et industrielles nécessaires à cette compétition (qui va également se jouer sur le terrain de la recherche de pointe en physique, mathématique, électronique et informatique pour concevoir des machines plus grandes, performantes et rentables) jette toutes ses forces dans cette bataille et devienne demain une référence d’excellence mondiale dans ce secteur stratégique.

René TRÉGOUËT

Sénateur Honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

Après un accident ou une intervention chirurgicale lourde, le patient doit généralement suivre une longue rééducation fonctionnelle pour retrouver toutes ses capacités physiques et son autonomie.

Afin de faciliter et accélérer cette réadaptation, des chercheurs allemands ont développé un nouvel outil technologique de "téléréadaptation", permettant au patient de pratiquer en toute sécurité ses exercices de physiothérapie à domicile ou même au travail (pendant les pauses ou le déjeuner).

Cet outil se compose d'une "Box", semblable aux décodeurs TV, d'une connexion Internet, d'une caméra et d'un microphone. A l'aide de ce système, le patient peut pratiquer chez lui, en regardant sa télévision, ou au bureau, en utilisant son smartphone, ses exercices personnalisés de rééducation.

Grâce au logiciel conçu pour cette application, les caractéristiques physiques de chaque patient sont cartographiées en 3D et intégrées dans un modèle informatique. Toutes ces données sont transmises en temps réel au centre de rééducation, où le thérapeute peut suivre le patient et adapter les exercices en fonction de sa progression.

Des capteurs de suivi de mouvement analysent les déplacements et gestes du patient et les comparent au modèle informatique choisi par le médecin. Le thérapeute ne reçoit pas seulement l'ensemble des mesures de mouvements de son patient mais également tous les paramètres vitaux dont il a besoin : tension, rythme cardiaque...

Article rédigé par Georges Simmonds pour RT Flash

Fraunhofer

|

|

|

|

|

|

|

|

|

Intel a annoncé le lancement prochain d'un service de télévision en ligne qui permettra de diffuser des programmes en direct et des services de vidéos à la demande. Cette annonce vient confirmer les informations rapportant que le groupe s'apprêtait à mettre un pied dans le marché américain des médias qui pèse 100 milliards de dollars.

Le plus gros fabricant mondial de microprocesseurs négocie actuellement avec des fournisseurs de contenus et a créé Intel media, une filiale entièrement dédiée au développement d'une plate-forme TV sur l'Internet.

Le service fonctionnera grâce à un boîtier qui diffusera des flux à la fois moins volumineux que ceux que peuvent transmettre les câblo-opérateurs et adaptés aux besoins des utilisateurs. Intel rejoint Apple, Amazon ou encore Google qui cherchent à s'attaquer au marché des médias dominé par ses acteurs historiques, Comcast ou DirectTV Group par exemple, mais aussi par les diffuseurs traditionnels comme Walt Disney et Time Warner.

Si le projet aboutit, il irait plus loin encore que ce que proposent Apple, Amazon et Netflix grâce à une offre conjuguant programmes diffusés en direct et services de vidéos à la demande. Le boîtier d'Intel doit être équipé d'une caméra chargée d'orienter l'utilisateur vers les contenus et de personnaliser les écrans publicitaires.

Le pari d'Intel est loin d'être gagné car le géant de l'électronique, qui a déjà raté plusieurs "trains" technologiques et numériques depuis 10 ans, sera en compétition frontale avec des sociétés comme Google, Apple, Western Digital ou Netflix, qui proposent déjà sur le Net des films, des émissions de télévision et des vidéos pouvant être visionnées sur PC, mobiles, téléviseurs et consoles de jeux. Intel va également se retrouver en concurrence avec des fabricants de téléviseurs comme Samsung, Sony, Panasonic et Sharp, qui vendent des téléviseurs "connectés", conçus pour exploiter et visualiser les images disponibles sur le Web.

Article rédigé par Georges Simmonds pour RT Flash

Techhive

|

|

|

|

|

|

|

|

|

Des chercheurs de l’Université de Washington viennent de développer une application baptisée « SpiroSmart » qui, en s’appuyant uniquement sur le microphone de l’iPhone, parvient à détecter des maladies respiratoires comme la bronchite ou la mucoviscidose.

Une fois l’application installée, l'utilisateur n'a plus qu'à souffler en direction du microphone. Ces signaux sonores sont alors transmis et analysés grâce à un algorithme spécifique qui calcule le flux respiratoire réel (volume et débit d’air inspiré et expiré). Il est ainsi possible de détecter avec précision d'éventuels problèmes respiratoires, tels que l'asthme, la fibrose kystique ou la bronchite chronique.

Les chercheurs ont constaté qu'ils pouvaient modéliser la trachée d'une personne et son appareil vocal de manière à remplacer le traditionnel spiromètre. Les chercheurs ont testé le système sur 52 volontaires en bonne santé, à l'aide d'un smartphone iPhone 4S et son microphone intégré. Les résultats ont montré que ce système était effectivement aussi fiable qu'un spiromètre portable, bien plus cher.

"Ces tests sont très prometteurs et ouvrent la voie à l'autocontrôle à domicile", a déclaré le Docteur Margaret Rosenfeld, pneumologue à l'Hôpital pour enfants de Seattle.

Article rédigé par Georges Simmonds pour RT Flash

UW

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

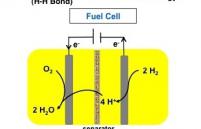

Concevoir des piles à combustible plus économiques est un enjeu industriel et technologique majeur. Des chercheurs américains ont mis au point un catalyseur à base de fer qui convertit directement l'hydrogène en électricité et pourrait permettre la construction de piles à combustible beaucoup moins coûteuse.

Un inconvénient majeur des piles à combustible actuelles est qu'elles utilisent du platine, un métal rare, mille fois plus cher que le fer. Mais le catalyseur développé par des chercheurs du Pacific Northwest National Laboratory utilise pour produire de l'hydrogène à partir du fer, une enzyme, l'hydrogénase, qui existe dans la nature. Ces enzymes, présentes dans de très anciennes bactéries, catalysent les protons, un des constituants du noyau atomique.

Grâce à plusieurs avancées sur la forme et les matériaux utilisés, les chercheurs parviennent, à l'aide de ce catalyseur, à séparer l'hydrogène à une vitesse de deux molécules par seconde, en utilisant une tension variant de 160 à 220 millivolts. Ces performances sont donc proches de celles des catalyseurs classiques bien plus onéreux, ce qui ouvre la voie à des piles à combustible bon marché.

Article rédigé par Georges Simmonds pour RT Flash

PNL

|

|

|

|

|

|

|

|

|

Ambri, une jeune société américaine fondée en 2007 par deux anciens élèves du MIT, David Bradwell et Donald Sadoway, a présenté son premier prototype de batterie liquide qui préfigure ce que pourrait être le stockage massif de l'électricité issue des énergies renouvelables.

La technologie mise au point par Ambri est radicalement différente de celle actuellement utilisée dans les batteries et repose sur un électrolyte liquide : lorsque la cellule est chauffée à environ 500°C, les composants de la batterie deviennent en effet liquides et peuvent tout simplement être stockés dans un grand réservoir et réutilisés à la demande, avec une durée de vie de plus de 10.000 cycles.

Avec ses électrodes en magnésium et antimoine, des matériaux simples et bon marché, ce type de batterie est simple, fiable et bien moins coûteux que les batteries solides. Il est particulièrement adapté au stockage massif de l'électricité produite par les parcs solaires ou éoliens qui se multiplient dans le monde et doivent être en mesure d'adapter leur production à l'évolution de la demande électrique.

Les deux fondateurs d'Ambri soulignent qu'aujourd'hui, aux USA, 99 % du stockage électrique s'effectuent à l'aide de la bonne vieille technique des SPT (Stations de Pompage-Turbinage). Cette méthode utilisée depuis un siècle est certes fiable et efficace mais elle souffre d'un handicap majeur : elle nécessite des sites présentant d'importants dénivelés et ayant des ressource en eau importantes. Du fait de ces contraintes, à peine 1 % d'un jour de production électrique aux Etats-Unis peut être stocké avec cette technologie.

Une station de pompage-turbinage hydraulique peut stocker l'électricité à un coût d'environ 100 $ par kWh et la technologie de batterie liquide d'Ambri revient encore à 500 $ par kWh mais ce coût pourrait baisser très rapidement car de telles batteries sont utilisables partout et sans limite de puissance.

Ambri devrait proposer d'ici la fin de l'année, son premier produit commercial, sous la forme d'un module ayant le volume d'un réfrigérateur. En interconnectant 80 de ces modules, il sera possible de disposer d'une méga-batterie liquide de 500 kilowatts, pouvant stocker deux mégawatts-heure, de quoi alimenter 70 foyers américains pendant une journée entière.

A plus long terme, le Texas avec ses immenses parcs éoliens est très intéressé par cette technologie qui pourrait lui permettre d'exploiter de manière encore plus rentable son potentiel éolien.

Article rédigé par Georges Simmonds pour RT Flash

MIT Technology Review

|

|

|

|

|

|

|

|

|

Des chercheurs de l'Université de Californie et de l'Université de Zhejiang en Chine, dirigés par Zhou Chongwu, ont développé un nouveau type de batterie lithium-ion très performante qui utilise des nanoparticules de silicium poreux à la place des anodes en graphite traditionnelles.

Ces batteries, qui pourraient être utilisées dans nos voitures électriques ou nos appareils numériques vers 2015, ont une capacité de stockage trois fois plus importante que les batteries actuelles et surtout, elles peuvent se recharger en 10 minutes.

Il y a a longtemps que les ingénieurs tentent d'utiliser le silicium dans les anodes de batteries mais ils se heurtaient à des problèmes de longévité et de capacité de charge. Mais l'équipe de Zhou a mis au point des nanofils de silicium poreux qui font moins de 100 nanomètres de diamètre et seulement quelques microns de long. Ces nanofils de silicium peuvent se dilater et se contracter sans rompre et leur surface leur permet de diffuser plus rapidement les ions de lithium, ce qui explique les performances de cette batterie.

Pour l'instant, ces batteries de nanoparticules de silicium ont une durée de vie de seulement 200 cycles de recharge, contre 500 en moyenne pour les batteries en graphite, mais les chercheurs pensent pouvoir rapidement surmonter cet obstacle.

Article rédigé par Georges Simmonds pour RT Flash

USC News

|

|

|

|

|

|

|

|

|

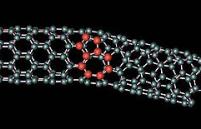

C'est à présent certain, les nanotubes de carbone sont appelés à remplacer un jour le silicium dans l'électronique. Mais avant d'en arriver là, de nombreux obstacles technologiques restent à surmonter.

Les nanotubes doivent être parfaitement alignés dans des grilles de haute densité et couvrir l'ensemble du substrat, ce qui constitue un vrai défi technique. Jusqu'à présent, la plus forte densité de nanotubes est inférieure à 50 tubes par micron mais une équipe américaine vient d'atteindre une densité de plus de 500 tubes par micron, ce qui constitue un record mondial et ouvre la voie vers l'après-silicium.

Pour atteindre ce résultat, les chercheurs ont utilisé une technique de fabrication appelée méthode de Langmuir-Schaefer, qui consiste à disperser des nanotubes semi-conducteurs préalablement dopés sur un film liquide. Cette technique permet une excellente répartition des nanotubes sur la totalité de la surface ainsi qu'une orientation uniforme. Les réseaux de nanotubes obtenus ont une pureté de 99 % et sont alignés avec un angle de 17° les uns par rapport aux autres.

Une telle augmentation de la densité permet des améliorations substantielles des propriétés physiques et électroniques des nanotubes et permet d'envisager des circuits électroniques souples et transparents.

Ces travaux montrent que les nanotubes de carbone sont bien placés pour remplacer le silicium qui va se heurter aux limites des lois de la physique vers 2023, quand la largeur des transistors descendra à seulement 5 nanomètres.

Article rédigé par Georges Simmonds pour RT Flash

Phys.org

|

|

|

|

|

|

|

|

|

L'hydrogène est un vecteur énergétique d'avenir mais encore faut-il parvenir à le produire de manière propre, en utilisant de préférence des énergies renouvelables, éolien, solaire et biomasse principalement. Mais, s'agissant de la biomasse, le procédé utilisé à l'heure actuelle nécessite une forte consommation d'énergie car la biomasse doit être séchée avant combustion.

C’est pourquoi des chercheurs de l'Université Friedrich-Alexander d'Erlangen-Nuremberg (Bavière) ont mis au point, dans le cadre du projet de recherche européen SusFuelCat, un procédé permettant de produire de l'hydrogène à partir de biomasse humide. Baptisée APR, cette technique repose sur le reformage en phase aqueuse par catalyse et permet une production d'hydrogène directement à partir de biomasse humide.

Le principal point fort de cette technique est sa sobriété énergétique puisqu'il n'est plus nécessaire de sécher à grand renfort de chaleur la biomasse utilisée. Autre avantage, avec ce système on peut également transformer l'eau contenue dans la biomasse en hydrogène. Enfin, et ce point est crucial, ce procédé est parfaitement propre : il n'émet que de la vapeur d'eau et aucun gaz à effet de serre, ni CO2.

L'innovation de ce procédé réside dans la catalyse très fine, modélisée par simulations informatiques, qui requiert peu de métaux nobles et utilise comme substrat un composé de carbone.

Article rédigé par Georges Simmonds pour RT Flash

EAI

FAU

|

|

|

|

|

|

|

|

|

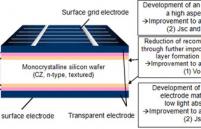

Panasonic vient d'annoncer un nouveau rendement record de 24,7 % sur ses cellules photovoltaïques de 98 micromètres d'épaisseur. D'après le fabriquant japonais spécialisé dans l'électronique, ce rendement est le plus élevé du marché mondial. Ce taux de conversion est de 0,5 point supérieur au précédent record en laboratoire pour des cellules à base de silicium cristallin.

La membrane de surface de cette cellule Panasonic permet le passage d'une plus grande quantité de lumière et ses électrodes autorisent une meilleure conversion de cette lumière en électricité. Par ailleurs, un tel rendement avec une épaisseur aussi faible va entraîner une réduction sensible des coûts de production.

Panasonic, déjà en pointe avec des cellules solaires de grande consommation d'un rendement de 21,6 %, entend s'imposer sur la marché des cellules solaires à haute performance. Avec des cellules aussi performantes, 10 m2 de panneaux solaires peuvent produire en moyenne, dans de bonnes conditions d'ensoleillement, 2 500 kWh par an, soit l'équivalent de la consommation électrique moyenne d'un ménage, hors chauffage.

Article rédigé par Georges Simmonds pour RT Flash

Solar Server

|

|

|

|

|

|

|

|

|

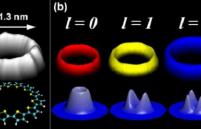

Des physiciens et chimistes de l’Institut de physique et chimie des matériaux de Strasbourg et du laboratoire de chimie des polymères (CNRS / UPMC) sont parvenus, pour la première fois, à synthétiser des anneaux de nanofils dans lesquels l’onde quantique électronique est totalement délocalisée.

Les mesures énergétiques de ces ondes par microscopie par effet tunnel ont montré que ces anneaux se comportent comme des résonateurs. Pour parvenir à cette conclusion, les chercheurs ont synthétisé sur une surface d’or, des fils et des anneaux nanométriques de polymères, constitués d’une alternance de quatre atomes de carbone et d’un atome de soufre.

En étudiant les résonances de l’onde électronique dans des fils et des anneaux de longueur donnée, les physiciens ont pu montrer que la longueur effective de l’anneau dépend de l’énergie de l’orbitale considérée. Cette corrélation s'explique par le fait que la molécule est un ruban et non un fil : il en résulte que l’électron est repoussé vers le bord externe de la structure sous l’effet de la force centrifuge, et cela d'autant plus fortement que l’énergie est importante.

En examinant la répartition spatiale de la fonction d’onde à l’aide d’un microscope à effet tunnel, les chercheurs ont montré que cette localisation de l’onde sur le périmètre d’un disque est tout à fait analogue à la localisation des « ondes de galerie » sonores sur la face intérieure du dôme de certains édifices religieux. Etant bien localisées sur le périmètre des anneaux, ces ondes devraient pouvoir être couplées entre elles.

Article rédigé par Georges Simmonds pour RT Flash

PRL

|

|

|

|

|

|

|

|

|

Si nos systèmes informatique et appareils numériques sont de plus en plus performants, c'est grâce à une miniaturisation toujours plus grande de leurs composants et circuits électroniques. Mais cette intégration se rapproche inexorablement des limites physiques et, d'ici 10 ans, la taille des transistors ne sera que de quelques atomes.

Certes, les transistors et puces en graphène et en nanotubes de carbone permettront de reculer les limites des composants électroniques mais ce n'est qu'un sursis et tous les géants de l'informatique et de l'électronique (IBM par exemple avec sa technologie tri-gate) travaillent sur la production industrielle de puces et de circuits en trois dimensions. Mais de tels composants posent de nouveaux et redoutables problèmes d'interconnexions verticales.

En s'inspirant de l'efficience des mécanismes à l'oeuvre dans le vivant et notamment des filaments d'actine, les biologistes et physiciens du CEA, du CNRS, de l’Université Joseph Fourier et de l’Inra à Grenoble, ont mis au point un système d'interconnexions auto-assemblées de structures microélectroniques en 3D.

Ces chercheurs ont eu l’idée de mettre à profit les capacités extraordinaires d’auto-assemblage de certains composés biologiques pour que ces connexions s'établissent spontanément et de manière évolutive, comme cela se passe en permanence dans les mécanismes de fonctionnement des cellules vivantes.

C’est notamment le cas des réseaux de filaments qui forment le squelette des cellules (cytosquelette). Ces filaments sont constitués d’actine et savent interagir entre eux pour former de nombreuses formes dont la structure spatiale et les propriétés mécaniques déterminent l'architecture cellulaire.

Ces scientifiques issus du CNRS, du CEA et de l'INRA ont mis au point une technique qui permet de contrôler, à l'aide d'un laser, l’auto-assemblage des filaments d’actine en 3D entre 2 plaques de verre. Il devient ainsi possible de produire à la demande des ponts d’actine de formes variées qui, une fois métallisées, peuvent servir de connexions électroniques.

La conductivité électrique, la stabilité et la modularité de ce type de connexions auto-organisées, ouvre une nouvelle voie très prometteuse pour la fabrication de puces et de circuits électroniques 3D à très hautes performances. Cette avancée montre à quel point l’étude fondamentale des mécanismes et processus biologiques est devenue une source d'inspiration irremplaçable pour parvenir à des innovations de rupture dans des domaines aussi variés que l'énergie, les matériaux, l'électronique ou les transports.

Article rédigé par Georges Simmonds pour RT Flash

Nature Materials

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Selon le dernier rapport de la NOAA américaine, (Administration Nationale pour l'Atmosphère et les Océans), la fonte de la glace en Arctique s'accélère, libérant des quantités croissantes de carbone emprisonné dans le pergélisol et contribue à l'augmentation de l'effet de serre.

Chaque année, au printemps, les écoulements d’eau liés à la fonte du pergélisol transfèrent du carbone des terres vers l’océan. L’accélération de la fonte des glaces provoque la formation de thermokarsts, des zones caractérisées par une dégradation du pergélisol.

En analysant plusieurs thermokarsts d’Alaska, les chercheurs ont constaté avec étonnement que ces thermokarsts ne contenaient que de faibles niveaux de matière organique dissoute, ce qui veut dire que le carbone acheminé jusqu’à l’océan par les eaux de fonte et le carbone des thermokarsts sont de nature différente. Ce dernier s'avère en effet plus réactif de 40 % à la lumière que le carbone organique libéré dans l’eau.

Il serait donc à craindre, selon cette étude, que le carbone qui s'écoule de la couche du pergélisol exerce un effet rétroactif plus puissant que prévu sur le réchauffement climatique. La hausse importante de la température de l'air en hiver serait donc à l'origine de l'augmentation récente des températures du pergélisol dans le grand nord canadien. L'étude souligne enfin que cette évolution rapide du pergélisol est cohérente avec la réduction historique de la surface et du volume de la banquise arctique.

Article rédigé par Gaël Orbois pour RT Flash

NOAA

|

|

|

|

|

|

|

|

|

Les océans sont l'élément majeur de la machine thermodynamique qu'est la Terre. Ils couvrent 71 % de la superficie de la Terre, recèlent la quasi-totalité de l'eau de la planète et reçoivent 90 % de l'énergie solaire.

La salinité qui dépend de la quantité de sel dissous dans l'océan joue un rôle clé dans les échanges océaniques et l'évolution du climat, par l'intermédiaire des courants marins qui transportent et redistribuent des quantités phénoménales de chaleur sur Terre.

L'étude montre notamment que le réchauffement mesuré dans les couches supérieures de l'océan s'explique par le réchauffement climatique anthropique résultant de l'accumulation du CO2 liée à la consommation d'énergies fossiles.

Ces travaux montrent que les modèles informatiques basés sur l'influence des seuls phénomènes naturels ne permettent pas d'expliquer l'évolution des niveaux de salinité ou de réchauffement observés depuis 1955 et qu'il est nécessaire d'intégrer le réchauffement provoqué par l'homme pour mettre en cohérence la théorie et les observations sur le terrain.

La salinité océanique étant fortement liée à l'évaporation, aux précipitations et aux apports en eau douce des fleuves, les analyses réalisées dans le cadre de cette étude révèlent des écarts croissants de salinité provoqués par une augmentation de l'évaporation des eaux de surface dans l'Océan Atlantique Nord qui se conjugue à une hausse des précipitations océaniques. L'une des conséquences majeures de cette évolution serait la modification du régime des pluies terrestres, marqué par des périodes de sécheresse de plus en plus longues et intenses dans certaines régions du monde.

Article rédigé par Gaël Orbois pour RT Flash

SIO

|

|

|

|

|

|

|

|

|

En utilisant les données transmises par le satellite européen Cryosat, une équipe de chercheurs vient de montrer, dans la revue Geophysical Research Letters, que le volume de glace de mer stockée près du Pôle Nord a chuté de 36 % en automne et de 9 % en hiver, entre 2003 et 2012.

D'autres études, basées sur des images satellitaires, avaient montré une baisse de la couverture de glace sur l'océan arctique mais Cryosat permet en plus aux scientifiques d'estimer le volume perdu, ce qui constitue évidemment une indication précieuse.

Lancée en avril 2010, cette petite sonde de 650 kg peut mesurer, grâce à son radar haute résolution, l'épaisseur de la banquise avec une précision inégalée de 2 cm. Les deux premières campagnes de mesures réalisées pendant les hivers 2010/2011 et 2011/2012 ont permis aux chercheurs de calculer que l'Arctique avait perdu 4300 kilomètres cubes de glace depuis 2008 durant la période automnale et environ 1500 kilomètres cubes pendant l'hiver.

Selon ces travaux, la diminution de l'épaisseur et du volume de glace enregistrée entre les hivers 2011 et 2012 aurait contribué à la réduction sans précédent de la surface de la banquise constatée en septembre 2012 : la surface de celle-ci était alors descendue à 3,6 millions de kilomètres carrés, un niveau jamais observé depuis le début des mesures.

Article rédigé par Gaël Orbois pour RT Flash

Cryosat

|

|

|

|

|

|

|

|

|

Une étude de l'IRD montre que les glaciers des Andes tropicales ont régressé d'un bon tiers depuis 30 ans, le rythme le plus élevé depuis 300 ans. Ces travaux retracent l'histoire de ces glaciers depuis leur maximum atteint pendant ce qu'on a appelé "Le petit âge glaciaire", entre 1650 et 1730.

L'ensemble des glaciers de Bolivie, d'Equateur, de Colombie et du Pérou sont affectés par cette fonte accélérée qui est de l'ordre de 35 % en moyenne, en seulement 40 ans. Cette évolution préoccupante confirme, sil en était besoin, la rapidité et l'ampleur du changement climatique dans cette région tropicale particulièrement sensible au réchauffement global.

Cette accélération du rythme de la fonte des glaces a été provoquée par l'évolution climatique rapide constatée sous les tropiques au cours des 60 dernières années et qui a entraîné un réchauffement atmosphérique de 0,7°C dans cette région des Andes. Si cette fonte se poursuit à un tel rythme, les plus petits glaciers andins risquent de disparaître totalement d'ici 2030, ce qui aurait des conséquences très préjudiciables pour l'accès à l'eau douce des populations locales.

Il faut en effet rappeler que, dans les Andes, les glaciers jouent un rôle majeur en matière d'irrigation, de production hydroélectrique et d'alimentation en eau : le sixième de l'eau consommée à La Paz, capitale de la Bolivie, provient des glaciers et cette part atteint un tiers pendant la saison sèche.

En analysant les moraines présentes sur les sommets, les scientifiques ont pu cartographier et dater les positions passées des glaciers au cours de leur régression amorcée à partir des années 1730. Cette méthode a été complétée par les photographies aériennes et les images satellitaires qui montrent une accélération du recul des surfaces glaciaires depuis 60 ans.

Article rédigé par Gaël Orbois pour RT Flash

Cryosphère

|

|

|

|

|

|

|

|

|

La population mondiale devrait passer de 7 à 9,3 milliards d'ici 2050, ce qui aura des conséquences majeures en matière d'élevage et pour l'agriculture. Dans cette perspective, on comprend à quel point la bonne conservation des graines et semences est un enjeu humain et économique important et cela d'autant plus que, sous l'action du réchauffement climatique, les semences de céréales sont de plus en plus contaminées par de nouvelles bactéries contre lesquelles il n'existe pas de traitement chimique efficace.

Les scientifiques de l'institut Fraunhofer, en Allemagne, ont mis au point, en utilisant la technologie des faisceaux d'électrons et des plasmas (FEP) de Dresde, une méthode particulièrement efficace d'extraction des germes des graines. A l'aide de faisceaux d'électrons soigneusement calibrés, ces chercheurs ont montré qu'il était possible de détruire l'ADN des organismes nocifs, moisissures, champignons, bactéries et virus, en quelques millisecondes sans altérer l'embryon situé au cœur de la graine.

Frank-Holm Rögner qui dirige ces recherches souligne que "Cette technique de faisceaux d'électrons accélérés à basse énergie est parfaitement efficace contre les pathogènes bactériens et fongiques et ne nécessite aucun agent. Elle est donc à la fois respectueuse de l'environnement et de la santé et les semences traitées peuvent être utilisées dans l'alimentation sans aucun danger."

Cette nouvelle technique, expérimentée avec succès depuis 2010, va entrer en phase industrielle à Güstrow fin juin 2013.

Article rédigé par Gaël Orbois pour RT Flash

Fraunhofer

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Le traitement hormonal substitutif (THS) est largement utilisé par les femmes pour traiter les symptômes de la ménopause, mais il n'est pas sans risque et peut, dans certains cas, accroître le risque de cancer du sein et de l'ovaire.

Des chercheurs de l’Université de Californie ont réalisé une étude auprès de 63 femmes ménopausées qui prenaient un THS depuis un an au moins, pour voir s'il existait un lien de causalité entre la variante génétique APOE-e4, facteur de risque accru de maladie d'Alzheimer, le traitement hormonal substitutif et la longueur des télomères, qui est un bon indicateur du vieillissement cellulaire.

Il a en effet déjà été démontré qu'il existait un lien entre la longueur des télomères, le déclin cognitif et la maladie d'Alzheimer et que posséder une copie d’APOE-e4 multipliait par quatre le risque de développer cette maladie. On sait par ailleurs qu'il y a un lien entre la longueur des télomères et les maladies neuro-dégénératives.

Dans cette étude, les chercheurs ont mesuré la longueur des télomères chez les femmes porteuses du gène APOE-e4 et ont pu évaluer l’effet du THS chez ces femmes. Ils ont constaté que les femmes ménopausées qui présentent cette variante APOE-e4 avaient un risque multiplié par six de raccourcissement des télomères.

Ce travail montre donc qu'il y a bien un lien entre la réduction de la longueur des télomères (marqueur du vieillissement) et la prise d'un traitement hormonal substitutif mais seulement pour les femmes porteuses d'une mutation sur le gène APOE-e4. En revanche, le lien entre THS et diminution du risque de démence ou de maladie d’Alzheimer n'est pas formellement démontré.

Article rédigé par Georges Simmonds pour RT Flash

PLOS

|

|

|

|

|

|

|

|

|

Selon une vaste étude québécoise réalisée par l'Université de Montréal, il y aurait une nette corrélation entre le poids des élèves et les résultats scolaires mais ce lien ne serait pas celui qu'on croit.

On pense en effet généralement que le surpoids d'un élève peut constituer un handicap en matière de réussite scolaire. Mais l'étude dirigée par la professeure Bisset est venue remettre en cause cette conviction : elle montre que l'obésité n'a pas d'incidence sur la réussite scolaire. En revanche, les chercheurs ont constaté avec étonnement que les enfants ayant un poids insuffisant entre quatre et sept ans ont des risques importants de connaître des difficultés scolaires.

Ces travaux ont analysé pendant huit ans une population de plus de 1000 enfants nés en 1997, en reprenant toutes les données scolaires, médicales et sociales les concernant. Au terme de cette étude, les aptitudes cognitives et scolaires des élèves ont été évaluées par un test cognitif standard (le Kaufman's Assessment Battery for Children) et par une évaluation des enseignants.

Les résultats sont sans appel : les enfants dont l'indice de masse corporelle (IMC) était en moyenne, et sur la durée, inférieur à la normale, ont obtenu pour l'ensemble des évaluations, des résultats sensiblement moins bons, cinq points d'écart, que ceux des enfants ayant un poids normal ou excessif.

Les chercheurs ont été surpris de constater que le quart des enfants étudiés avaient un poids insuffisant. Il reste à présent aux autorités scolaires, sociales et médicales, à partir de ces résultats, à prendre des mesures concrètes de prévention et d'information pour éviter qu'une telle situation ne perdure et compromette la réusitte scolaire des enfants concernés.

Article rédigé par Elisa Tabord pour RT Flash

Nature

|

|

|

|

|

|

|

|

|

Des chercheurs de l'Université Rice à Houston ont montré qu'il existait un lien direct entre le niveau de pollution de l'air à l'ozone et la fréquence des accidents cardiaques.

Dans cette étude, les auteurs ont analysé huit années de données portant sur la qualité de l'air et 11 000 cas d'accidents cardiaques enregistrés par les services médicaux d'urgence de Houston. Ils ont alors pu établir une nette corrélation entre ces arrêts cardiaques hors hôpital et l'exposition aux particules fines (particules en suspension inférieures à 2,5 microgrammes) et à l'ozone.

Les chercheurs ont constaté qu'une augmentation quotidienne moyenne de 6 microgrammes par jour des particules fines par m3 augmentait le risque d'accident cardiaque de 5 %. L'augmentation du niveau d'ozone de 20 parties par milliard pendant une à trois heures augmentait également le risque d'accident cardiaque dans les mêmes proportions.

En revanche, cette étude n'a pas montré de liens entre l'exposition au dioxyde d'azote, au dioxyde de soufre et au monoxyde de carbone et un risque accru de pathologie cardiaque.

Cette étude devrait pourvoir permettre une meilleur prévention et une prise en charge plus efficace des accidents cardiaques dus à la pollution, ce qui constitue un enjeu médical majeur quand on sait que chaque minute sans assistance diminue de 10 % les chances de survie pour une personne victime d'un accident cardiaque et que seule une personne sur 30 peut être sauvée sans intervention médicale, après un accident cardiaque.

Ces travaux vont également inciter les états fédérés à atteindre les normes fédérales prévues pour la concentration de l'ozone : 75 parties par milliard.

Article rédigé par Georges Simmonds pour RT Flash

Eurekalert

|

|

|

|

|

|

|

|

|

L'oxyde nitrique a une action vasodilatatrice remarquable (augmentation du diamètre des vaisseaux sanguins) permettant une irrigation sanguine optimale des fibres musculaires. Il actionne également la voie de signalisation cellulaire qui commande la production des protéines musculaires.

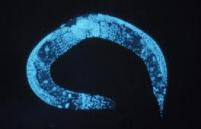

Une étude américaine dirigée par le Docteur Nudler montre que le vers Caenorhabditis elegans, largement utilisé dans les études sur le vieillissement, vit beaucoup plus longtemps lorsqu'il contient dans son intestin des bactéries capables de fabriquer de l'oxyde nitrique. Ces recherches confirment à quel point le microbiome, c'est-à-dire l'ensemble des dizaines de milliards de bactéries qui habitent notre corps, joue un rôle majeur sur notre santé et notre longévité.

"Notre niveau d'oxyde nitrique diminue à mesure que nous vieillissons et cette étude montre que les bactéries peuvent utiliser l'oxyde nitrique, non seulement pour leur propre avantage, mais aussi pour le bénéfice de leur hôte" explique le Docteur Nudler.

Ces travaux ont montré que C. elegans voyait sa durée de vie augmenter de 15 % lorsqu'il ingère des bactéries produisant de l'oxyde nitrique. Un marquage fluorescent a pu montrer que les bactéries productrices d'oxyde nitrique ont activé un ensemble de 65 gènes, dont certains sont impliqués dans la résistance au stress, la réponse immunitaire, et la longévité.

Les chercheurs ont également observé que l'oxyde nitrique produit par ces bactéries à l'intérieur des vers activait ces gènes par le biais de deux régulateurs, hsf-1 et daf-16. "Il est frappant de constater que l'oxyde nitrique produit par une simple bactérie peut avoir de tels effets bénéfiques sur l'organisme tout entier" souligne le Docteur Nudler.

Article rédigé par Georges Simmonds pour RT Flash

Science Daily

|

|

|

|

|

|

|

|

|

Une étude américaine réalisée par l’Université de Californie du sud a montré chez la souris qu'un régime à faible teneur en protéines pouvait avoir des effets bénéfiques sur le cerveau et diminuer les risques de maladies neurodégénératives.

Ces travaux ont démontré que des souris atteintes d'une forme avancée de la maladie d'Alzheimer présentaient moins de symptômes de la maladie si elles étaient soumises à un régime pauvre en protéines complété par des acides aminés spécifiques, toutes les 2 semaines pendant 4 mois. Ces souris ont vu leurs performances cognitives et leur niveau de protéine tau diminuer. Or, cette protéine est un marqueur biologique caractéristique de cette pathologie.

Les protéines alimentaires sont le principal régulateur alimentaire d'une hormone de croissance appelée IGF-1, associée au vieillissement. Selon ces recherches, il semble qu'un régime alimentaire à faible teneur en protéines soit capable de réduire les niveaux d'IGF-1 d'au moins 50 % et de multiplier par huit les niveaux d’une protéine qui bloque les effets de l'IGF-1 en se liant à elle.

L'étude précise cependant que beaucoup de personnes âgées fragiles n'ont pas une santé suffisamment bonne pour suivre un tel régime faiblement protéiné la moitié du temps. L'étude recommande donc que toute personne âgée qui se décide à suivre ce régime fasse un bilan médical préalable et soit suivie par un médecin.

Article rédigé par Georges Simmonds pour RT Flash

USCDSG

|

|

|

|

|

|

|

|

|

Un comité d'éthique d'un centre hospitalier japonais a donné son accord pour des recherches cliniques de médecine régénérative au moyen de cellules souches pluripotentes induites (iPS).

Ces recherches cliniques seront mises en oeuvre par la Fondation pour la recherche biomédicale et l'Innovation (Ibri) et concerneront dans un premier temps la dégénérescence maculaire liée à l'âge (DMLA), qui est la première cause de cécité des plus de 55 ans dans les pays industrialisés. Les chercheurs japonais essaieront de cultiver des cellules de la rétine et de les implanter pour rétablir la vision des patients malades.

Les cellules-souches pluripotentes induites (iPS) sont créées à partir de cellules adultes ramenées au stade embryonnaire grâce à l'activation de plusieurs gènes. Les cellules pluripotentes possèdent la capacité remarquable de pouvoir se différencier dans tous les types de cellules en fonction du milieu dans lequel elles évoluent. Autre avantage : contrairement aux cellules-souches prélevées sur des embryons humains dont l'utilisation pose des problèmes éthiques, l'usage de cellules iPS ne suscite pas de réserves ou d'opposition de nature religieuse ou morale.

Le Japon est un acteur majeur de la recherche en matière de cellules-souches et le gouvernement nippon a annoncé début janvier qu'il allait investir 110 milliards de yens (900 millions d'euros) pour la recherche sur les cellules-souches pluripotentes induites (iPS) au cours des 10 prochaines années, afin d'accélérer le développement de nouveaux médicaments et l'avènement de la médecine régénérative.

Rappelons que le professeur Shinya Yamanaka a obtenu le prix Nobel de médecine 2012 pour avoir mis au point une technique révolutionnaire permettant d'obtenir des cellules-souches pluripotentes. Le Japon a par ailleurs décidé la construction d'un nouveau centre de recherche à l'Université de Kyoto, qui servira de plaque tournante pour la recherche sur les cellules iPS.

Article rédigé par Georges Simmonds pour RT Flash

IPS

Yomiuri

|

|

|

|

|

|

|

|

|

Selon une étude publiée par l'Union internationale pour la conservation de la nature (UICN), près d'un reptile sur cinq dans le monde serait menacé d'extinction.

Parue dans la revue Biological Conservation, cette étude est la première analyse globale sur l'état de conservation des serpents, lézards, tortues, crocodiles et autres reptiles, selon l'IUCN. "Plus de 200 experts de renommée mondiale ont évalué le risque d'extinction de 1.500 reptiles de toutes les régions du monde sélectionnés de façon aléatoire", soit un échantillon représentant 16 % des espèces connues, explique l'organisation, associée à cette étude de la Société zoologique de Londres.

Parmi les reptiles menacés, 12 % seraient au bord de l'extinction, 41 % en danger et enfin, 47 % vulnérables. "L'étude estime par ailleurs que 50 % des tortues et 30 % des reptiles d'eau douce sont proches de l'extinction.

La menace pesant sur ces espèces de reptiles est particulièrement forte dans les régions tropicales, à cause de la réduction croissante des zones sauvages non exploitées à des fins agricoles, forestières ou urbaines. En France, la situation n'est pas meilleure et l’UICN estime que 7 espèces de reptiles sur 37 et 7 espèces d’amphibiens sur 34 sont menacées.

Article rédigé par Elisa Tabord pour RT Flash

IUCN

|

|

|

|

|

|

|

|

|

Une étude canadienne dirigée par Janet Werker, psychologue de l’Université de Colombie Britannique (Canada), montre qu'avant de savoir parler, des enfants vivant dans une famille bilingue sont capables de distinguer les différences grammaticales de deux langues dès l’âge de sept mois.

Des travaux antérieurs, menés par des chercheurs de l’Université Paris-Descartes, avaient déjà montré que les bébés savaient repérer la fréquence des mots dans la langue pour déterminer leur importance. Par exemple, en anglais les mots ‘the’ (le, la ou les) et le mot ‘with’ (avec) sont répétés plus souvent que d’autres mots dans la conversation, ce qui permet aux bébés de leur attribuer une valeur particulière.

Ces travaux montrent que des enfants élevés dans une famille bilingue utilisent la fréquence des tons et de la durée des réponses pour mieux distinguer deux langues, par exemple, l'Anglais et le Japonais où l’ordre des mots est inversé. Le cerveau des nouveau-nés aurait donc, comme le pense le grand linguiste Chomsky, la capacité innée d'isoler la structure grammaticale d'une langue ; c'est cette remarquable aptitude qui expliquerait la facilité déroutante avec laquelle les jeunes enfants parviennent à maîtriser aussi vitre la grammaire spécifique à une langue.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

|

|

|

|

|

|

|

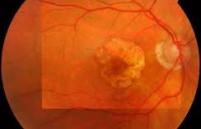

La dégénérescence maculaire liée à l’âge (DMLA) est une pathologie de la rétine provoquée par une dégénérescence progressive de la partie centrale de la rétine (macula). Elle se traduit par une diminution irréversible des capacités visuelles par privation de la vision centrale.

Cette maladie touche essentiellement les personnes âgées de plus de 50 ans et se présente sous deux formes : la forme humide qui évolue rapidement, et la forme sèche ou atrophique, plus lente, mais aussi plus destructrice, qui représente 80 % des cas et pour laquelle il n'existe aucun traitement curatif. En France, on estime que deux millions de personnes souffrent de cette maladie, soit près d'un adulte sur vingt et ce nombre pourrait doubler d'ici 20 ans sous l'effet du vieillissement de la population.

Dans ce travail, des chercheurs du service d'ophtalmologie du Centre hospitalier intercommunal de Créteil ont suivi, durant 3 ans, 263 patients, âgés de 55 à 85 ans et présentant des lésions précoces de la DMLA. Le but de cette étude était d’évaluer l’impact d’une supplémentation en oméga-3 sur l’évolution de ce trouble de la vision.

Dans cette étude, réalisée en double-aveugle contre placébo, la moitié des patients a reçu chaque jour 840 mg de DHA et 270 mg d'acide eicosapentaénoïque (EPA) à partir de capsules d'huile de poisson et l'autre moitié a reçu un placebo pendant 3 ans. Les résultats indiquent que la consommation régulière d'acides gras polyinsaturés (oméga-3 et oméga-6) réduit de 68 % le risque de survenue d'un type de DMLA particulier, la DMLA néovasculaire.

Après les maladies cardio-vasculaires, certaines maladies neurodégénératives et la dépression, il semblerait donc que ces acides gras polyinsaturés puissent également jouer un rôle préventif en matière de DMLA.

Article rédigé par Georges Simmonds pour RT Flash

Ophtalmology

|

|

|

|

|

|

|

|

|

Selon une étude australienne réalisée par l'équipe du Professeur Neil McLachlan, de l'École des sciences psychologiques de Melbourne, le fait que nous ayons une sensation d'harmonie et de mélodie en écoutant une musique est lié à l'apprentissage de notre cerveau et non à une capacité innée et "objective" de considérer comme "musique" une suite de sons.

"Notre étude montre que l'harmonie musicale n'est pas innée mais résulte d'un apprentissage du cerveau", souligne le Professeur McLachlan qui ajoute, non sans humour, "Si vous trouvez que certaines musiques, comme le jazz ou le rock, ressemblent à des cris de chats, c'est simplement parce que vous n'avez pas appris à les écouter avec la grille de lecture qui vous permet d'en comprendre les règles sonores, rythmiques et harmoniques".

Cette étude, qui a porté sur 66 volontaires, montre qu'un auditeur a besoin de se familiariser avec les sons créés par des combinaisons de notes pour "extraire" la mélodie et l'harmonie de la musique. Il a également été montré que les musiciens étaient beaucoup plus sensibles à la dissonance que les non-musiciens.

"Nous avons montré dans cette étude qu'en matière de musique, la beauté est dans le cerveau du spectateur et pas dans son oreille," ajoute le Professeur McLachlan.

Article rédigé par Georges Simmonds pour RT Flash

Medical Xpress

|

|

|

|

|

|

|

|

|

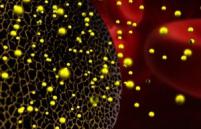

Des chercheurs américains de l'hôpital méthodiste de Houston, de l'Université du Texas et de l'Anderson Cancer Center, ont mis au point un nouveau traitement contre le cancer résistant de l'ovaire. Cette thérapie consiste à emprisonner des micro-ARN dans des nanoparticules de silicium qui vont servir de vecteurs pour amener ces ARN jusqu'à la tumeur à traiter.

Les premiers essais cliniques sur l'animal ont montré que cette thérapie pouvait réduire de 83 % la taille des tumeurs de l'ovaire et permettre de ralentir la croissance tumorale de cancers devenus réfractaires à la chimiothérapie.

"La résistance aux médicaments est un problème majeur en cancérologie", souligne le Professeur Mauro Ferrari, l'un des principaux auteurs de l'étude. "Notre travail montre que le transfert d'ARN vers les cellules cancéreuses permet non seulement une efficacité thérapeutique intrinsèque beaucoup plus grande mais rend à nouveau ces cellules malignes sensibles à la chimiothérapie classique."

Aux Etats-Unis, on estime qu'une femme sur 72 aura un cancer de l'ovaire au cours de sa vie. Ce cancer reste de mauvais pronostic à cause notamment de la résistance aux médicaments.

Les micro-ARN, ou siRNA, ont la capacité d'interférer avec l'expression des gènes. Dans le cas du cancer de l'ovaire, ils peuvent bloquer le gène EphA2, ce qui permet de stopper la prolifération cancéreuse.

Mais ces micro-ARN ne peuvent pas être injectés directement dans le sang du patient car ils seraient détruits avant d'atteindre leurs cibles tumorales. C'est pourquoi les chercheurs ont mis au point une "nanocapsule" lipidique, appelé nanoliposome, qui sert à la fois à protéger les micro-ARN et à les acheminer exactement jusqu'à la cible visée.

Article rédigé par Georges Simmonds pour RT Flash

Medical Xpress

|

|

|

|

|

|

|

|

|

Malgré des progrès significatifs dans la lutte contre le cancer durant les 50 dernières années, les différentes thérapies proposées ne sont pas capables de supprimer l'ensemble des cellules touchées.

Le patient atteint est ainsi soumis à d'éventuelles rechutes. Les équipes de recherche de Martin Röcken, de l'Université de Tübingen (Bade-Wurtemberg), et de l'immunologue Gert Riethmüller, de l'Université de Munich (Bavière), explorent les mécanismes de défense du système immunitaire qui peuvent, dans certaines conditions, annihiler la croissance du cancer.

Ils ont en effet démontré, en travaillant sur un modèle de cancer touchant les îlots de Langerhans (cellules endocrines du Pancréas), qu'il existe un mécanisme permettant de bloquer la croissance du cancer en mettant les cellules tumorales dans un état d'"hibernation".

Lorsque le système immunitaire ne peut pas détruire ces cellules, les protéines cytokines Interferon ( IFN-γ) et les protéines Facteur de Nécrose Tumorale (TNF) entrent en action, déclenchant en cascade la protéine CDKN2A (Inhibiteurs des Kinases Dépendantes des Cyclines).

Par la suite, des cellules "dormantes" d'animaux ont été isolées puis transplantées dans des souris immunodéficientes et saines, et les chercheurs n'ont pas observé de prolifération significative des cellules. Ce concept ouvre la voie à des thérapies permettant un rallongement de la durée de vie, tout en diminuant les effets secondaires inhérents au traitement anticancéreux.

"La maîtrise de ce mécanisme en chaîne, à l'aide de ces deux substances combinées, pourrait permettre "d'endormir" définitivement les cellules cancéreuses", souligne le Professeur Röcken, qui ajoute : "On ne pourra pas vaincre le cancer uniquement en essayant de détruire toutes les cellules malignes. Il faudra également apprendre, en utilisant différentes voies génétiques et moléculaires, à les maîtriser, ce qui reviendra à faire du cancer une maladie chronique qui ne pourra plus tuer le patient".

Article rédigé par Georges Simmonds pour RT Flash

Tagblatt

Nature

|

|

|

|

|

|

|

|

|

Une vaste étude, menée par l’Institut Français du Cerveau et de la Moelle épinière et cofinancée par Medtronic, a montré que la stimulation cérébrale profonde pouvait sensiblement diminuer les symptômes et améliorer la qualité de vie des malades souffrant de la maladie de Parkinson.

La stimulation cérébrale profonde consiste à stimuler électriquement une région précise du cerveau. Une électrode est implantée chirurgicalement dans le cerveau et reliée en sous-cutané par une extension à un neurostimulateur implanté près de la clavicule ou au niveau de l'abdomen.

L’étude Earlystim menée dans 8 centres français, dont l’hôpital neurologique de Bron et 9 centres allemands, a porté sur 251 patients, âgés en moyenne de 52 ans, atteints d’une forme précoce de la maladie de Parkinson depuis 7,5 ans et randomisés en 2 groupes : l’un traité par stimulation cérébrale profonde et par médicaments et l’autre par traitement médicamenteux seul.

Les chercheurs de l’Institut du Cerveau et de la Moelle épinière ont constaté, à l’issue de 2 années de traitement, une amélioration de la mobilité de 53 % (26 % pour la qualité de vie) chez les patients stimulés, par rapport aux patients du groupe-témoin, traités par médicament. S'agissant de la qualité de vie, le score moyen du groupe neurostimulation s’est amélioré de 7,8 points, alors qu'il a régressé de 0,2 points pour le groupe prenant uniquement des médicaments. Les chercheurs ont également constaté que la neurostimulation avait des effets positifs dans la récupération des capacités motrices, l’humeur et la sociabilité des patients.

Ces travaux soulignent cependant que des effets indésirables sont intervenus chez 54,8 % des patients du groupe sous neurostimulation, contre 44,1 % des patients sous médicaments.

Article rédigé par Georges Simmonds pour RT Flash

NEJM

|

|

|

|

|

|

|

|

|

En complément avec les progrès de la chimiothérapie, les vaccins thérapeutiques contre le cancer représentent une nouvelle voie thérapeutique très prometteuse. Ils ont pour objectif de stimuler certaines cellules du système immunitaire, dont les lymphocytes T-CD8, afin de faire régresser la tumeur. Ces types de vaccins suscitent beaucoup d’espoir mais certains ne confirment pas leurs bons résultats en essais cliniques alors qu’ils sont efficaces sur les modèles animaux.

Pour essayer de comprendre les raisons de ces déconvenues, l'équipe d' Eric Tartour (Inserm et Université Descartes) a testé chez la souris l’efficacité de deux voies d’administration différentes : la voie intra-musculaire d’une part, et la voie intranasale d’autre part.

Ces essais, qui ont été menés sur un vaccin expérimental contre les cancers muqueux oropharyngés, ont pu montrer que seule une vaccination par voie muqueuse fait régresser une tumeur localisée dans le poumon ou dans la sphère oto-rhino-laryngologique (ORL). Si l'on injecte le même vaccin par voie intramusculaire ou sous cutanée, il est sans effet.

"Nos résultats pourraient expliquer l'échec de vaccins anti-tumoraux visant à traiter les tumeurs muqueuses chez l'homme, et conduire à une modification des vaccins anti-cancer ciblant les tumeurs muqueuses", explique Eric Tartour, professeur à l’université Paris Descartes.

Ces travaux ont montré que la vaccination par voie muqueuse induit l’expression d’une protéine particulière (l’intégrine muqueuse CD49a) qui permet aux lymphocytes T-CD8 de bien migrer dans la tumeur pour y détruire les cellules cancéreuses.

A contrario, le blocage de cette molécule va empêcher les lymphocytes T d'arriver dans la tumeur muqueuse. L’intégrine CD49a semble donc indispensable au bon "guidage" des lymphocytes anti-tumoraux vers les cancers pulmonaires et ORL de type muqueux.

Les chercheurs ont confirmé ce mécanisme en constatant, après analyses des échantillons issus de patients atteints de cancer du poumon, une forte concentration de l’intégrine muqueuse CD49a sur les lymphocytes T-CD8.

Article rédigé par Georges Simmonds pour RT Flash

STM

|

|

|

|

|

|

|

|

|

Des chercheurs américains ont réussi à donner à des rats de laboratoire un «sixième sens» à l'aide d'un implant dans leur cerveau. Un dispositif expérimental a permis au rat de sentir par les sens du toucher un faisceau de lumière infrarouge, normalement invisible pour cet animal.

L'équipe de l'Université Duke a équipé des rats avec un détecteur infrarouge relié à des électrodes microscopiques qui ont été implantées dans la partie de leur cerveau qui traite l'information tactile.

Selon les chercheurs, il est envisageable, en théorie, qu'un patient dont le cortex visuel est endommagé puisse retrouver la vue grâce à un dispositif analogue, implanté dans son cerveau. L'auteur principal, Miguel Nicolelis, souligne que c'est la première fois qu'une interface cerveau-machine permet ce type de sensation chez l'animal. L'expérience montre également que des stimuli sensoriels peuvent être interprétés par une région du cerveau normalement affectée à d'autres tâches.

Comme le souligne le Professeur Nicolelis, de la Duke University, "Nous pourrions créer des dispositifs sensibles à tout type d' énergie, champs magnétiques, ondes radio, ou des ultrasons. Si nous avons choisi les infrarouges, c'est parce qu'ils n'interfèrent pas avec nos enregistrements électrophysiologiques."

Son collègue Eric Thomson ajoute : "La finalité des interfaces cerveau-machine est jusqu'à présent de restaurer une fonction motrice perdue dans le système nerveux central mais, pour la première fois, nous avons montré qu'une neuroprothèse pouvait également augmenter ou créer une fonction, par exemple, permettre à un animal d'acquérir un sixième sens."

Fait remarquable : il n'a fallu qu'un mois aux animaux pour qu'ils apprennent à associer parfaitement le signal dans le cerveau avec la source infrarouge. Autre enseignement de cette étude : la mobilisation du cortex pour "sentir" la lumière infrarouge n'a pas réduit sa capacité à traiter les signaux tactiles ordinaires.

Article rédigé par Georges Simmonds pour RT Flash

BBC

|

|

|

|

|

|

|

|

|

Les chercheurs de l’Inserm (Institut de recherche sur les cellules-souches et le cerveau), du CNRS et de l’Université Lyon 1 se sont appuyés sur les mécanismes d'apprentissage du cerveau pour développer un réseau de neurones conçu pour pouvoir apprendre une nouvelle langue.

Notre cerveau est capable de traiter en temps réel les premiers mots d’une phrase et d'anticiper la suite en utilisant une logique prédictive reposant sur la mémoire et le contexte. L'aire cérébrale associant cortex frontal et striatum joue un rôle majeur dans ce mécanisme très efficace.

La construction neuronale de type récurrente mise au point par les chercheurs s'inspire donc de celle à l'oeuvre dans le cerveau humain. Elle est capable de comprendre des phrases nouvelles, avec une structure grammaticale nouvelle mais elle sait également établir un lien entre deux phrases et peut même, comme notre cerveau, prédire la fin de la phrase avant qu'elle ne soit prononcée.

Afin de pouvoir démontrer les performances de leur réseau neuronal, les chercheurs l'ont intégré dans le robot humanoïde iCub. Quand un chercheur a demandé au robot iCub de désigner une guitare avant de déplacer un violon vers la gauche, le robot a répété la phrase et il a précisé qu’il avait bien compris l'instruction.

Ce système devrait permettre de mieux comprendre comment le cerveau traite la langue et comment, par exemple, il va réagir si un mot imprévu survient. Il pourrait donc éclairer les causes des dysfonctionnements linguistiques dans certaines maladies affectant le cerveau, comme Parkinson.

Ces recherches devraient également permettre de rendre, à terme, les robots plus intelligents en les dotant d'une véritable aptitude à apprendre. "Aujourd’hui, les ingénieurs ne peuvent tout simplement pas programmer toutes les connaissances requises dans un robot. Nous savons maintenant que la façon dont les robots vont acquérir leur connaissance du monde sera réalisable grâce à l'apprentissage - comme le font les enfants", souligne Peter Ford Dominey, l'un des chercheurs .

Article rédigé par Georges Simmonds pour RT Flash

PLOS one

|

|

|

|

|

|

|

|

|

Une des questions clés de la biologie est de comprendre comment les organismes vivants parviennent à s'adapter aussi rapidement et efficacement à des modifications importantes de leur environnement.

Un facteur clé de cette souplesse adaptative semble être la modularité généralisée des réseaux biologiques et notamment leur organisation fonctionnelle.

Les systèmes biologiques sont organisées en modules, avec des groupes d'unités fortement connectées entre elles mais peu connectées au reste du réseau. Les ingénieurs utilisent d'ailleurs des conceptions modulaires analogues : une voiture par exemple est faite d'un assemblage de modules : portes, châssis, moteur, rétroviseurs...

Cette modularité ne procure un avantage que sur le long terme alors que la sélection naturelle n'agit directement que sur le court terme, à chaque génération. Il est donc important de comprendre pourquoi les êtres vivants, des bactéries à l'homme, ont tous évolué vers des organisations modulaires.

A cette question centrale en matière d'évolution du vivant, une équipe internationale regroupant l'Institut des Systèmes Intelligents et de Robotique et les universités américaines du Wyoming et de Cornell, apporte une réponse intéressante : la modularité évoluerait en fait sous l'effet de la sélection naturelle pour réduire le nombre et la longueur des connexions du réseau considéré et optimiser ainsi son "coût" de fonctionnement.

Cette hypothèse, validée par plusieurs milliers de simulations numériques, permet d'expliquer la présence quasi-universelle de la modularité dans des réseaux biologiques aussi différents que des réseaux métaboliques, des réseaux de neurones ou des réseaux régulateurs de gènes.

Ce serait donc ce moteur fondamental de la "pression sélective" qui pousserait à réduire le coût des connexions entre les nœuds du réseau et à provoquer l'émergence de réseaux modulaires afin d'optimiser les performances du réseau.

Article rédigé par Georges Simmonds pour RT Flash

RSPB

|

|

|

|

|

|

|

|

|

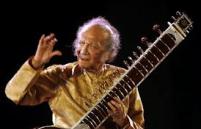

Une étude menée par l’Université Concordia et publiée dans la revue "Journal of Neuroscience" a montré que l'apprentissage de la musique avant l’âge de 7 ans avait des effets très bénéfiques sur le développement du cerveau. Ces recherches montrent notamment que les enfants ayant bénéficié d'une telle formation possèdent des connexions plus nombreuses et plus riches entre les différentes aires cérébrales.

Les chercheurs ont montré que la formation musicale avait un impact particulièrement positif sur le développement cérébral entre 6 et 8 ans et favorisait une excellente coordination psychomotrice et sensorielle.

Pour parvenir à ces conclusions, les chercheurs ont travaillé sur un ensemble de 36 musiciens adultes, divisés en deux groupes. Le premier groupe avait commencé son apprentissage musical avant 7 ans et le deuxième, après. Les examens et tests pratiqués sur ces deux groupes ont ensuite été comparés aux résultats obtenus chez un troisième groupe-témoin, sans formation musicale.

Chez les musiciens précoces, les scientifiques ont pu observer que la substance blanche du corps calleux était plus développée. Or, on sait que cette substance, faite de fibres nerveuses, relie les régions motrices droite et gauche du cerveau. Il apparaît en outre que, plus l'apprentissage musical a débuté tôt, plus cette richesse de connexion est grande.

Toutefois, ces recherches ont montré également qu'il n'y avait pas de différences notables, au niveau cérébral, entre les non-musiciens et les musiciens "tardifs".

"Notre étude montre que la formation est plus efficace en bas âge en raison de la plus grande sensibilité aux changements de certains aspects de l’anatomie cérébrale durant cette période", souligne le Professeur Zatorre qui ajoute que "Les musiciens précoces présentent des habiletés spécifiques et des différences physiologiques connexes."

Article rédigé par Georges Simmonds pour RT Flash

Concordia

|

|

|

|

|

|

|

|

|

Des travaux publiés par la revue américaine Neurology montrent que la neurostimulation, une technique qui consiste à injecter un courant électrique de faible intensité dans un nerf, diminue le nombre de migraines et entraîne une consommation moins importante de médicaments.

Dans ces recherches, le nerf stimulé est le trijumeau qui comporte 3 branches principales. La première parcourt le front et contourne les yeux et les deux autres branches traversent les joues et la mâchoire. Ces nerfs transmettent les sensations de la face vers le cerveau et sont donc impliqués dans la migraine.

Ces essais ont porté sur 67 personnes qui souffraient en moyenne d'une crise migraineuse par semaine. Ces patients ont été divisés en deux groupes : le premier recevait une stimulation électrique de 20 minutes par jour pendant trois mois et le deuxième groupe une stimulation factice.

Au terme de l'essai, les sujets du premier groupe ont vu leur nombre de jours avec migraine passer de 7 à 5 par mois alors que ce nombre n'a pas diminué pour les patients ayant reçu le traitement factice. Autre observation : les patients du premier groupe ont réduit de 37 % leur consommation de médicaments.

"Avec cette technique, nous avons constaté des effets positifs pour 4 patients sur dix, sans les effets secondaires des traitements de fond classiques", souligne le Professeur Jean Schoenen de l'Université de Liège.

Article rédigé par Elisa Tabord pour RT Flash

Neurology

|

|

|

|

|

|

|

|

|

Des chercheurs britanniques ont mis au point un nouveau traitement contre l'arthrite qui utilise les ressources du propre système immunitaire du patient pour lutter contre cette pathologie invalidante. Ce traitement repose sur une perfusion unique de la protéine de liaison d'immunoglobuline (BiP), fortement impliquée dans le processus inflammatoire.

"Cette percée est l'aboutissement de 15 années de travail et la mobilisation du système immunitaire des patients pour les aider à combattre cette maladie est une approche révolutionnaire", explique le Docteur Valerie Corrigall du Kings College de Londres, qui ajoute : "Outre le fait d'être une thérapie très prometteuse, ce traitement est bien moins coûteux que les thérapies actuelles".

Ces recherches ont par ailleurs montré qu'une seule injection intraveineuse de BiP déclenche rapidement une forte réponse anti-inflammatoire chez les patients, même si des injections de rappel sont à prévoir pour entretenir cette réponse immunitaire dans la durée.

La polyarthrite rhumatoïde est la deuxième forme la plus courante d'arthrite au Royaume-Uni. Elle touche plus de 400 000 personnes et 80 000 nouveaux cas sont constatés chaque année. Cette pathologie provoque des douleurs chroniques et des déformations articulaires, accompagnées de fatigue et d'une perte de l'autonomie de mouvements. On estime que 40 % des personnes atteintes de polyarthrite rhumatoïde risquent de perdre leur emploi dans les cinq ans en raison de leur maladie.

Article rédigé par Georges Simmonds pour RT Flash

KCL

|

|

|

|

|

|

|

|

|

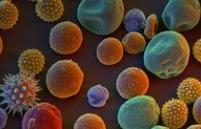

Des chercheurs anglais ont mis au point un nouveau vaccin contre le rhume des foins qui pourrait être plus efficace, moins invasif pour les patients et moins coûteux que les vaccins déjà disponibles.

Dans ces travaux, les scientifiques de l'Imperial College London et King College de Londres ont montré qu'une réduction significative de la sensibilité aux pollens de graminées était associée à une augmentation des «anticorps bloquants» dans la circulation sanguine.

Le rhume des foins touche une personne sur quatre au Royaume-Uni et provoque des réactions très pénibles : nez bouché, éternuements, yeux irrités et, dans certains cas, symptômes d'asthme. Ces symptômes peuvent finir par altérer la qualité de vie sociale et professionnelle des patients et, même si certains médicaments et aérosols peuvent temporairement soulager les symptômes, seule une désensibilisation complète, à l'aide d'un vaccin, peut s'attaquer aux causes de cette pathologie.

Les vaccins actuellement utilisés comportent de fortes doses d'allergènes, administrés par des injections sous-cutanée répétées, ce qui est contraignant pour le patient et coûteux pour la collectivité. Mais ces recherches montrent qu'avec une dose d'allergènes de seulement un centième de la dose habituelle, mais administrée dans l'épiderme (une zone très sensible sur le plan de la réponse immunitaire) en deux injections séparées de dix semaines, on obtient une réduction de 90 % de l'intensité de l'allergie aux pollens de graminées. En outre, aucun effet secondaire indésirable n'a été constaté.

Cette nouvelle approche dans le traitement des allergies pourrait être étendue à la prise en charge d'autres affections telles que l'asthme et les allergies alimentaires.

Article rédigé par Georges Simmonds pour RT Flash

KCL

|

|

|

|

|

|

|

|

|

Environ un tiers des habitants d'Europe et 80 % des Asiatiques souffrent de myopie.

Dans la myopie, le sujet voit les objets plus flous à mesure qu'il s'en éloigne car le cristallin est trop bombé et les rayons lumineux se décalent et se focalisent devant la rétine. Les complications à long terme de la myopie sont le décollement de la rétine, le glaucome et la dégénérescence maculaire.

Des membres du groupe de recherche CREAM (Consortium for Refraction And Myopia) ont réalisé une méta-analyse de 32 études sur la génétique de la myopie, dans des pays du monde entier. Ils ont ainsi pu identifier, chez 45 000 personnes, 24 nouveaux gènes prédisposant à la myopie et confirmer le rôle de deux autres gènes déjà identifiés. Ces gènes se répartissent statistiquement de la même façon dans les populations européennes et asiatiques, bien que la myopie soit beaucoup plus fréquente en Asie.

Ces recherches montrent que les porteurs de ces gènes ont un risque de myopie qui peut être multiplié par 10.

Article rédigé par Georges Simmonds pour RT Flash

KCL

|

|

|

|

|

|

|

|

|

Une étude américaine basée sur la comparaison de génomes d’enfants et de personnes âgées vient de révéler des marqueurs génétiques qui seraient déterminants dans l’espérance de vie.

Ces travaux, dirigés par Hakon Hakonarson, du Children's Hospital de Philadelphie (États-Unis), ont comparé un grand nombre de mutations génétiques chez des individus jeunes et des personnes âgées, afin d'identifier celles qui sont bénéfiques et celles qui, au contraire, induisent un risque accru de pathologies.

Ces altérations sont des variations du nombre de copies (VNC) d’un gène. Au cours des processus cellulaires, certains fragments d’ADN ne s'intègrent pas au bon endroit du génome et ces erreurs de localisation peuvent avoir trois types d'effets : néfastes, neutres ou bénéfiques.

En comparant les variations du nombre de copies identifiées chez 7 300 jeunes Américains avec celles identifiées chez 2 700 Islandais âgés de plus de 67 ans, les chercheurs partaient de l'hypothèse que les VNC les plus présentes chez les seniors devaient être plutôt bénéfiques, puisqu'ils avaient déjà atteint un certain âge, alors que les VNC trouvées chez les jeunes devaient être davantage porteuses de risques de maladies à venir.