|

|

Edito

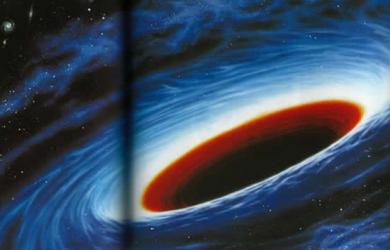

Les trous noirs recèlent-ils les secrets de l’Univers ?

Le 11 février dernier, une coopération scientifique internationale regroupant les équipes LIGO et VIRGO a annoncé la détection et l’enregistrement pour la première fois, le 14 septembre 2015, du passage d'une onde gravitationnelle. Cette infime déformation de l'espace-temps a été détectée avec 7 millisecondes d'écart par les deux instruments séparés par 3000 kilomètres et cette découverte extraordinaire, à laquelle j'ai consacré un éditorial récent (le 19 février dernier) a véritablement fait entrer la physique et la cosmologie dans une nouvelle ère.

Rappelons que le signal détecté est parfaitement en accord avec ce le cadre cosmologique théorique prévu lorsque deux trous noirs fusionnent. Ceux qui ont été observés avaient une masse respective de 29 et de 36 fois la masse du Soleil. La forme du signal complexe détecté par LIGO montre que les deux objets finissent par n'être plus qu'à quelques centaines de kilomètres l'un de l'autre. Or, seuls des trous noirs permettent d'expliquer une telle masse confinée dans une si petite zone de l'espace. Les scientifiques désignent ces trous noirs sous l'appellation GW150914. Le résultat de la fusion des deux astres est un nouveau trou noir d'une masse de 62 masses solaires, et non 65 masses solaires comme on pourrait s'y attendre. Les 3 masses solaires manquantes sont précisément celles qui ont été dissipées sous la forme d'énergie gravitationnelle. La quantité d'énergie libérée est colossale, elle répond à la fameuse loi d'Einstein E=mc² (l'énergie est égale à la masse multipliée par le carré de la vitesse de la lumière).

Les mesures réalisées ont permis de localiser cet événement cosmique très violent à quelque 1,3 milliard d'années-lumière. Sur son passage, l'onde gravitationnelle générée par ce cataclysme cosmique a déformé l'espace-temps et c’est cette "vague" gravitationnelle très brève qu’a détecté LIGO.

Les membres de la collaboration Ligo, qui ont analysé le signal GW150914 avec l’aide de leurs collègues européens de Virgo, ont également pu réaliser une estimation plus précise du nombre de flashs d’ondes gravitationnelles produits par des collisions de trous noirs atteignant la Terre chaque année, ainsi que le nombre de ceux suffisamment intenses pour être détectés avec aLigo et aVirgo. Et le résultat est incroyable : la Terre serait frappée en moyenne tous les quarts d’heure par une onde gravitationnelle produite depuis plus de 13 milliards d’années par les collisions de trous noirs quelque part dans l’univers observable. Ligo devrait donc être en mesure, lorsqu'il sera pleinement opérationnel, à l'automne 2016, de détecter et d'analyser une centaine de "vagues gravitationnelles" par jour...

Le 18 avril dernier, quelques mois avant cette découverte historique, le grand physicien Stephan Hawking, a fait à Harvard une conférence très remarquée sur ces objets fascinants que sont les trous noirs. Ces trous noirs sont, selon le physicien britannique qui a consacré sa vie à leur étude, des astres "plus étranges que tout ce qui a été imaginé par les auteurs de sciences fiction et ils pourraient bien être des portes de passage vers d’autres univers."

C’est en 1915, grâce à la théorie de la relativité générale d’Einstein, complétée par les travaux du physicien Karl Schwarzschild, que l’hypothèse de l’existence des trous noirs, objets cosmiques étranges résultant d’un effondrement gravitationnel, est devenue véritablement plausible. Mais il a toutefois fallu attendre 1994 pour que deux observations réalisées par le télescope spatial Hubble dans deux galaxies lointaines (M87 et NGC4258) confirment pour la première fois de manière indirecte (les trous noirs ne pouvant par nature être directement observés) la présence certaine de deux trous noirs.

Dès 1975, Stephen Hawking a émis l’hypothèse que certains phénomènes quantiques laisseraient présager que les trous noirs puissent émettre des radiations. Ce phénomène est aujourd’hui connu sous le nom "d’évaporation quantique" ou encore de "radiation de Hawking". Par la suite, Stephen Hawking a revu et complété sa théorie en apportant des hypothèses sur la perte d’information concernant les objets qui pourraient être engloutis par le trou noir.

En août 2015, Hawking a proposé de surmonter ce paradoxe de l'information perdue en présentant une hypothèse comme toujours, tout à fait passionnante : selon lui, l’information absorbée par un trou noir ne serait pas vraiment définitivement détruite et perdue car en fait elle ne pénètrerait pas à l'intérieur du trou noir mais resterait à sa périphérie, ce qu’on appelle son horizon, c'est-à-dire la limite en deçà de laquelle la lumière ne peut plus s’échapper, qui marque le diamètre physique de trou noir. Selon Hawking, l’information en 3D qui arrive dans le trou noir est convertie en une information 2D codée à la surface de l’horizon, sur le principe de l’hologramme. De ce fait, cette information peut être restituée par le trou noir en prenant la forme de cette fameuse "radiation de Hawking".

Le problème vient du fait que cette radiation – et la perte de masse qui lui est associée – est si faible, qu’il est très difficile d’en démontrer l’existence sur le plan expérimental. Mais cette incertitude pourrait peut-être être surmontée, si l’on en croit les récents travaux de Jeff Steinhauer, du département de physique de l’Institut de technologie Technion de Haïfa en Israël. Ce physicien travaille en effet sur des "trous noirs de laboratoire". Concrètement, il s’agit de reconstituer en laboratoire l’équivalent acoustique d’un trou noir en utilisant de l’hélium refroidi à des températures juste au-dessus du zéro absolu (-273,15°C) et en imprimant à ce gaz très froid un mouvement de rotation (Voir Science alert).

Or, Jeff Steinhauer affirme avoir observé des émissions d’énergie qui seraient l’équivalent des radiations de Hawking, obéissant précisément aux hypothèses formulées par le Britannique. Si ces résultats venaient à être confirmés, la nouvelle hypothèse de Stephen Hawking concernant la conservation de l’information entrant dans un trou noir s’en trouverait singulièrement confortée.

Mais si les propriétés des trous noirs restent mystérieuses et très débattues au sein de la communauté des physiciens, leur nombre et leur taille ne cessent également d'intriguer les scientifiques. Comme je l'évoquais dans mon éditorial du 19 février dernier, une équipe internationale d’astrophysiciens a ainsi détecté, il y a un peu plus d'un an, un trou noir absolument gigantesque, d'une masse de 12 milliards de fois supérieure à celle du Soleil de notre système. Fait encore plus troublant, ce monstre de l'espace, baptisé "SDSS J0100+2802"se situe à 12,8 milliards d'années-lumière de notre système solaire, ce qui signifie qu'il serait apparu seulement 875 millions d'années après la naissance de l'Univers. L'ennui est qu'un tel trou noir ne devrait pas exister dans le cadre cosmologique actuel...

Il y a quelques semaines, alors qu'ils traquaient les ondes radio les plus faibles émises dans l'Univers, des scientifiques de l'université de Cape Town et de Western Cape, en Afrique du Sud, ont fait une autre découverte stupéfiante : après avoir observé pendant trois ans des trous noirs supermassifs, ils ont constaté que leur activité semble synchrone, alors qu'ils se trouvent à des millions d'années-lumière de distance.

Ces chercheurs ont remarqué que les jets supermassifs des trous noirs étaient tous orientés dans la même direction et qu'ils tournaient tous de concert. Le problème est que ces trous noirs sont bien trop éloignés les uns des autres pour s'influencer, certains étant séparés par plus de 320 millions d'années-lumière. "Etant donné que ces trous noirs ne se connaissent pas les uns les autres, n'ont aucun moyen d'échanger des informations ou de s'influencer directement du fait des vastes échelles, cet alignement de rotation a dû avoir lieu pendant la formation de ces galaxies dans les premiers temps de l'Univers", explique le professeur Andrew Russ Taylor, principal auteur de l'étude.

Et justement, cette étrange "couplage" des alignements de rotation de ces trous noirs nous ramène à une théorie que j'avais également évoquée dans mon éditorial du 19 février dernier et qui est celle émise en 2000 par Niayesh Afshordi, astrophysicien au Perimeter Institute for Theoretical Physics à Waterloo (Canada). Selon ce physicien, notre Univers tout entier pourrait être issu d’un trou noir résultant de l’effondrement d’une étoile quadridimensionnelle, elle-même provenant d’un autre univers à quatre dimensions d’espace. Dans cette hypothèse, cette étrange synchronisation observée dans l'alignement de rotation de trous noirs très éloignés les uns des autres pourrait s'expliquer le fait que notre Univers soit lui-même né d'un trou noir.

Mais une autre observation, elle aussi très troublante, est à mettre en relation avec cette nouvelle physique des trous noirs qui émerge : en 2007, une équipe internationale de recherche, dirigée par Yair Krongold de l'université de Mexico et associant notamment des chercheurs du Harvard-Smithsonian Center for Astrophysics, a découvert, en utilisant les observations du satellite XMM Newton, que les trous noirs possédaient la particularité de contribuer, via des flux de gaz interstellaire, à la nucléosynthèse primordiale, processus par lequel les étoiles fabriquent les éléments chimiques (carbone, oxygène, azote) indispensables à l’apparition de la vie.

La galaxie NGC 4051 possède un trou noir central supermassif, comme presque toutes les galaxies de taille moyenne. En l'étudiant avec le satellite de l’ESA XMM Newton, les chercheurs se sont aperçu qu'un vent chaud de gaz, riche en élément lourds tels que l'oxygène, l'azote et le carbone, s'échappait à grande vitesse (jusqu’à trois millions de km/heure) en direction de l'espace intergalactique. Or, la production en quantité suffisante de ces éléments lourds est l'une des conditions essentielles à l'apparition de la vie et à la formation des premières cellules vivantes. Il semblerait donc qu'en favorisant la dispersion de ces éléments, les trous noirs géants aient contribué, peut-être de manière décisive, à produire les conditions physico-chimique indispensable à la naissance du vivant (Voir Harvard-Smithsonian Center For Astrophysics et Space Daily).

Il y a quelques semaines, un autre article de physique théorique publié par l'université Cornell est venu relancer une autre hypothèse, elle aussi très intéressante : les trous noirs seraient constitués de matière noire, cette étrange matière invisible qui constitue un peu plus du quart de l’Univers, contre seulement 5 % pour la matière ordinaire (Voir Cornell University Library). Selon ces travaux, si ces trous noirs sont en si grand nombre dans l'Univers, c'est peut-être parce qu'ils sont composés de matière noire. Simeon Bird de l’université de John Hopkins et ses collègues font en effet l'hypothèse que, compte tenu de la masse des trous noirs détectés, LIGO a pu détecter une paire de trous noirs primordiaux plutôt que des trous noirs astrophysiques lorsque des étoiles massives s’effondrent à la fin de leur vie.

L’équipe de LIGO a tenté de prédire toute la matière noire qui est composée de trous noirs primordiaux autour de cette masse et elle a calculé la probabilité que ces objets deviennent des systèmes binaires susceptibles de fusionner. Selon ces prévisions, il devrait y avoir quelques collisions dans notre galaxie chaque année, ce qui est en parfait accord avec le taux de détection du LIGO. Le futur télescope Einstein, qui va succéder à LIGO et sera capable de détecter les couples de trous noirs avant leur collision, devrait permettre de confirmer ou non cette hypothèse.

Il faut également souligner que, fin 2012, des scientifiques de l’Institut Max-Planck (MPI), ont découvert un gigantesque trou noir, baptisé NGC12777 et situé dans une toute petite galaxie (environ un quart du diamètre de la Voie lactée), située à 220 millions d’années-lumière de la Terre. Ce trou noir a une masse équivalente à 17 milliards de fois celle de notre Soleil. A lui seul, son centre représenterait onze fois l’orbite de Neptune autour du Soleil.

Ce trou noir est atypique non seulement par sa masse phénoménale mais surtout par la proportion de sa galaxie qu’il représente. Les trous noirs observés jusqu’aujourd’hui représentaient environ 0,1 % de la taille de leur galaxie. Mais NGC12777 équivaut à 14 % de sa galaxie et sa taille est telle que les scientifiques se demandent s’ils n’ont pas affaire à un nouveau type d’objet cosmique, le « trou noir galactique ».

Ce très gros trou noir, qui continue à prendre de la place dans une très petite galaxie, remet en question toutes les théories scientifiques sur ce sujet. NGC12777 ne se serait peut-être pas formé à la suite de l’effondrement d’une grosse étoile sur elle-même. Selon les astronomes, il a dû se former grâce à un autre mécanisme cosmique, jusqu'ici ignoré.

Un autre trou noir absolument gigantesque, ayant lui aussi une masse d’environ 17 milliards de fois celle de notre Soleil, a été découvert il y a quelques semaines, début avril, à 200 millions d’années-lumière de notre Terre. Ce trou noir géant se trouve au cœur de la galaxie elliptique NGC 1600, située dans une région peu dense de l’Univers qui n’était pas sensée abriter un tel monstre (Voir NASA). Ces découvertes récentes pourraient signifier que les trous noirs supermassifs sont bien plus nombreux que prévus et que leurs modes de formation sont multiples et encore largement inconnus.

Evoquons enfin l’expérience tout à fait décisive en cours, menée par Guy Perrin et son équipe du Laboratoire d’études spatiales et d’instrumentation en astrophysique (Lésia), qui vise à tester la relativité générale d’Einstein dans un champ extrêmement fort, en l’occurrence, celui qui se trouve au centre de notre galaxie (à 26 000 années-lumière de notre Terre), à proximité de Sagittarius A, un super-trou noir 4 millions de fois plus massif que le Soleil !

Dans cette expérience, les chercheurs français utilisent l’interféromètre Gravity qui, en combinant la lumière collectée par quatre télescopes du Very Large Telescope (VLT) situés dans le désert d’Atacama, au Chili, permet depuis la fin 2015 de disposer de l’équivalent d’un super-télescope de 140 mètres de diamètre. Ce nouvel instrument permet pour la première fois de repérer les blocs de matière, échauffés par les forces de marée exercées par le trou noir Sagittarius A. Comme le souligne le physicien Guy Perrin, « En mesurant leur trajectoire, nous pourrons analyser la métrique de l’espace-temps dans cette zone ». Cette expérience va donc permettre d’observer comment ce trou noir déforme l’espace autour de lui, mais également le temps, puisque Einstein a montré dans sa théorie de la relativité générale que le temps et l’espace formaient un continuum indissociable d’espace-temps.

Guy Perrin attend avec impatience les résultats de cette expérimentation, soulignant que « Si la théorie de la relativité générale fonctionne très bien pour décrire l’horizon du trou noir, elle rencontre ses limites dans la description de la singularité centrale, située au-delà de cet horizon. C’est pourquoi nous avons besoin d’englober la relativité générale dans une théorie plus fine, comme la théorie des cordes ou la gravitation quantique à boucles, ce que nous testerons dans les années qui viennent ».

Grâce à ces récentes et magnifiques avancées de la physique et de la cosmologie, nous savons à présent que non seulement les trous noirs existent bel et bien mais qu’ils sont présents en très grand nombre dans l’Univers et qu’il en existe une étonnante variété, les uns minuscules, les autres absolument gigantesques (plus de 20 milliards de fois la masse de notre soleil pour les plus massifs).

Mais les scientifiques reconnaissent humblement que maintenant qu’ils ont la certitude que les trous noirs existent et produisent ces fameuses ondes gravitationnelles qu’ils ont enfin réussi à détecter, ils sont confrontés à un nombre encore plus grand de questions sans réponse. L’un des mystères les plus fascinant qui accompagne ces objets cosmique énigmatiques est certainement cette étrange corrélation de rotation entre trous noirs distants qui vient d’être observée et n’est pas sans rappeler la corrélation qui persiste entre plusieurs photons issus d’une même source, même quand ceux-ci sont ensuite séparés par des distances astronomiques.

Il faudra sans doute attendre que physiciens, cosmologistes et mathématiciens parviennent enfin à articuler correctement la relativité générale et la mécanique quantique dans un nouveau cadre théorique plus vaste et plus complexe, pour que ces objets si déroutants se laissent peut être appréhender dans toutes leurs dimensions et nous dévoilent quelques-uns des secrets de notre Univers.

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

Une équipe de chercheurs de l'Université de Binghamton à New York a démontré qu'il était possible d'authentifier un individu de manière infaillible via les ondes cérébrales. Le but est de sécuriser l'accès à des lieux de haute sécurité, comme le Pentagone. Les ondes cérébrales désignent communément l'activité électrique du système nerveux du cerveau, que l'on peut enregistrer et mesurer avec des appareils comme les électroencéphalogrammes.

Ces chercheurs américains se sont intéressés aux potentiels évoqués visuels, c'est-à-dire à la réponse électrique d'un système nerveux soumis à une stimulation visuelle. En enregistrant ces potentiels évoqués sur différents sujets auxquels ils ont présenté des mots ou des images, les chercheurs se sont aperçus que chaque « réponse » était différente. L'ordinateur ainsi relié à l'expérience et chargé d'analyser les résultats a ainsi pu déterminer, avec un taux de réussite de 100 %, qui était l'individu connecté à l'encéphalogramme.

Un progrès par rapport à leurs récentes recherches, pour lesquelles la fiabilité de cette reconnaissance n'avait atteint « que » 97 %. Déjà impressionnant, mais insuffisant pour le marché que visent ces chercheurs, à savoir celui de la très haute sécurité.

Pour parvenir à ce score parfait, les scientifiques ont tout simplement ajouté aux mots présentés auparavant des images. Chaque individu, qui a son propre rapport avec ces mots et ses images, réagit d'une manière unique et génère un signal qui l'est tout autant. Reste une question essentielle : ces réactions aux images ou aux mots évoluent sans aucun doute à travers le temps. Il faudra aux scientifiques effectuer régulièrement des ajustements s'ils ne veulent pas que leur dispositif leur joue des tours.

Article rédigé par Georges Simmonds pour RT Flash

Science Daily

|

|

|

|

|

|

|

|

|

Des chercheurs du MIT et de la société PatternX ont mis au point une plate-forme baptisée AI² capable de détecter 85 % des cyberattaques dans un réseau ou un système. Pour atteindre cette performance, ils se sont appuyés sur différentes techniques d'intelligence artificielle. La plate-forme utilise des algorithmes d'apprentissage automatique non supervisé pour analyser des logs des systèmes et extraire des indicateurs de comportements suspects.

Ce résultat est ensuite soumis à un analyste de sécurité qui élimine les faux positifs, ce qui permet de créer un modèle d'apprentissage automatique supervisé. Celui-ci va ensuite venir en renfort de l'apprentissage non supervisé dans le prochain cycle de détection. Au fur et à mesure que les analystes corrigent les résultats, la plate-forme gagne en performance pour atteindre rapidement un taux de détection de 85 %.

Présentée à l'occasion de la conférence IEEE International Conference on Big Data Security, qui s'est déroulée à New York, selon MIT News, cette plate-forme a été testée sur 3,6 milliards de lignes de log, générées par des millions d’utilisateurs sur une période de trois mois. Pour autant, le travail de l’expert humain est resté raisonnable.

Le premier jour, il devait analyser 200 événements suspects. Quelques jours plus tard, il n’y en avait plus que 30 ou 40 pour lesquels la plate-forme avait encore un doute. Les autres événements étaient détectés avec un taux de confiance suffisamment élevé. Selon Kalyan Veeramachaneni, l’un des chercheurs qui ont participé à ce projet, cette méthode aurait l’avantage de ne pas trop solliciter les experts de sécurité avec des tâches répétitives.

Article rédigé par Georges Simmonds pour RT Flash

MIT

|

|

|

|

|

|

|

Des chercheurs du célèbre MIT ont développé un nouveau procédé qui permet au Wi-Fi de localiser les appareils électroniques et les personnes afin de n'établir une liaison Internet qu'avec le groupe d'utilisateurs identifiés. Ces scientifiques du laboratoire d’informatique et d’intelligence artificielle du MIT (CSAIL), dirigés par la professeure Dina Katabi, ont développé Chronos, un nouveau routeur capable de calculer seul la distance entre des personnes ou des smart devices et lui.

Dans une habitation, Chronos sait donc quelle pièce est occupée et laquelle est vide. Il peut ainsi définir le champ d’application du Wi-Fi dans l’habitat et l’envoyer aux membres de la famille où qu’ils se trouvent. Dans un magasin ou un restaurant, Internet n’est délivré qu’aux clients assis dans l’enceinte de l’établissement. Autre avantage de taille : avec ce système, le mot de passe devient obsolète !

Article rédigé par Georges Simmonds pour RT Flash

MIT

|

|

| ^ Haut |

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

Le Docteur Hanan Mohamed Al Kuwari, ministre de la Santé publique du Qatar, a inauguré le 16 avril dernier MACH 4 Omnicell à l’hôpital général Hamad. Il s’agit d’un nouveau système robotique destiné à réduire les temps d’attente des patients dans les pharmacies de l’hôpital.

MACH 4 est un système de pharmacie robotique. Il est la combinaison de deux robots en réalité, MEDIMAT et Speedbox. Ils travaillent alors ensemble pour gérer les prescriptions complexes et permettent également un déplacement rapide des articles les plus demandés. Leur capacité de stockage est assez impressionnante avec 14 000 packs pour les deux. De plus, le système MACH 4 pourrait distribuer jusqu’à 1200 prescriptions par heure.

Les capacités records de ce nouveau système de pharmacie robotique pourrait faciliter la travail des pharmaciens. En effet, ils ne peuvent traiter que jusqu’à 1800 prescriptions par jour. Il ne faudrait donc à MACH 4 qu’une heure trente pour en faire autant. Et pendant ce temps-là les pharmaciens peuvent être directement en contact avec le client. De plus, MEDIMAT et Speedbox peuvent aussi éviter au mieux les erreurs de lecture des ordonnances. L’efficacité serait d’autant plus grande. Cela va donc réduire considérablement le temps d’attentes pour les patients.

Il existe également un système de pharmacie robotisé semblable dans un autre hôpital Al Wakra. Le projet devrait être déployé plus largement dans les mois à venir. Ils pourront donc fournir des médicaments plus efficacement. Cela pourrait donner bien des idées. Imaginez de voir votre pharmacie équipée de ces robots et ainsi attendre beaucoup moins pour avoir vos médicaments. Ce sera possible.

Article rédigé par Georges Simmonds pour RT Flash

OBJET CONNECTE

|

|

|

|

|

|

|

|

|

Jibo est un petit robot aux formes rondes, à la surface blanche immaculée et doté d’un écran animé. « Son apparence est très particulière, c’est un robot qui ne se déplace pas mais possède trois axes de rotation lui permettant d’exprimer des émotions par sa posture. Il est doté d’un écran avec un œil unique, qui peut se changer en différentes formes en fonction de l’activité en cours : objectif d’appareil photo, texte, coeur…. Il peut aussi montrer des images ou des vidéos. » explique Roberto Pieraccini, à la tête de l’équipe chargée des fonctions conversationnelles chez Jibo. En somme, un robot-objet connecté et multifonction s'adressant au foyer familial.

Jibo a été conçu pour devenir un assistant virtuel à part entière, capable de prendre part à des discussions et de traiter des demandes complexes, comme de commander de la nourriture ou réserver un voyage. Doté de capacités d’apprentissages, il retient les préférences de son propriétaire. Et le fait qu’il soit doté d’un corps, contrairement à la plupart des assistants virtuels du marché, permet d’effectuer des combinaisons intéressantes. « Il peut faire de nombreuses choses dont les autres sont incapables, car ils ne possèdent pas de vision ou de capacités d’animation » affirme Roberto Pieraccini.

S’il est pour l’heure encore à l’état de prototype, ce robot offre un mélange intéressant entre les intelligences artificielles éthérées qui se multiplient et les robots dotés d’un corps perfectionné, mais aux capacités cognitives limitées. Combiné avec un système d’intelligence artificielle très avancé, comme celui actuellement développé par la start-up Viv, il pourrait devenir un connecteur offrant à son propriétaire un vaste contrôle sur les objets intelligents. En effet, il est également capable d’interagir avec les différents objets d’une maison connectée, et peut ainsi éteindre et allumer les lumières, lancer le chauffage avant que ses propriétaires ne rentrent chez eux…

Article rédigé par Georges Simmonds pour RT Flash

Popular Science

|

|

|

|

|

|

|

|

|

L'entreprise canadienne 4D Retail Technology, spécialisée dans les affichages électroniques intelligents pour les commerces, a présenté un robot capable de faire l'inventaire tout seul en se baladant entre les rayons : le Space Genius.

Ce « génie » est un robot monté sur un Segway, qui peut parcourir les allées d’une grande surface en une heure, pour réaliser automatiquement une analyse de tout l’inventaire, sans utiliser d’étiquettes RFID, mais uniquement avec « ses yeux ». Grâce à une technologie de capture 3D en ultra-haute définition, et d’analyse de l’image, le robot peut en effet compter très exactement le nombre de produits présents dans les rayons, et vérifier que tout est conforme aux attentes des clients et du magasin.

Le robot peut identifier les produits sur les différentes étagères et vérifier si l’étiquette de prix correspondante est la bonne, détecter des anomalies par rapport aux prix présentés en catalogues, alerter les fournisseurs si un produit qui n’est pas en stock arrive à épuisement dans un rayon, ou encore prévenir les employés qu’un produit n’est pas à sa place.

Le Space Genius peut aussi apporter des conseils de management et calculer qu’un produit qui se vend très bien mériterait d’avoir plus de mètres carrés de rayonnage, alors qu’un autre bénéficie de trop d’exposition par rapport à son attrait commercial. Le robot serait aussi capable d’identifier qu’un produit est mal situé dans un rayon, par exemple qu’il n’est pas assez visible par la clientèle, alors qu’il se vendrait très bien s’il était placé sur une étagère plus stratégique.

L'entreprise propose en outre une application qui permettra aux clients de faire leur liste de courses et de définir par avance leur parcours en magasin, pour être guidés comme avec un GPS à l’intérieur de la grande surface. Si un produit n’est plus disponible, l’application pourra immédiatement prévenir le client.

Article rédigé par Georges Simmonds pour RT Flash

Numerama

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

ExxonMobil a annoncé qu'il travaillait à une nouvelle technologie de captage du dioxyde de carbone (CO2) à partir de la production d'hydrogène, dans le but de combattre les risques liés au changement climatique.

"Avancer des technologies économiques et durables pour capturer le dioxyde de carbone de gros émetteurs telles les centrales électriques est une part importante des recherches d'ExxonMobil sur les solutions de réduction des émissions afin d'atténuer le risque de changement climatique", a déclaré Vijay Swarup, vice-président en charge de la R&D chez ExxonMobil, cité dans un communiqué. Le groupe pétrolier américain indique avoir déjà capturé plus de 6,9 millions de tonnes de dioxyde de carbone à des fins de séquestration en 2015 en utilisant des technologies déjà existantes.

Concrètement, ExxonMobil qui a noué un partenariat avec FuelCell Energy, spécialiste des centrales à piles à combustibles, souhaite, par reformage du gaz naturel, procédé consistant à séparer l'hydrogène du méthane, réussir à capturer davantage de résidus de CO2 pour pouvoir utiliser l'hydrogène comme combustible. Autrement dit, le groupe veut se passer des épurateurs classiques de gaz pour adopter la pile à combustible, ce qui permettrait de faire d'une pierre deux coups : la centrale à gaz va réduire ses émissions tout en produisant de l'électricité, assure ExxonMobil.

Cette nouvelle technologie permettrait en outre de réduire "substantiellement" les coûts associés à la capture du CO2 pour les centrales à gaz, poursuit le groupe texan sans donner les détails financiers de ce projet.

Pour l'instant, la technologie n'a été testée qu'en laboratoire. Il faudrait jusqu'à quatre ans pour débuter une expérimentation pilote à grande échelle, indique ExxonMobil.

Article rédigé par Georges Simmonds pour RT Flash

Hartford

|

|

|

|

|

|

|

|

|

Singapour est en pointe dans le développement de nouvelles techniques de construction. Le Precast Pre-finished Volumetric Construction – PPVC est une méthode de construction qui consiste à utiliser des modules de béton préfabriqué incluant second œuvre, finitions et accessoires. Ceux-ci sont ensuite assemblés sur site comme des legos. Des modules contenant des salles d’eau appelés Prefabricated Bathroom Units (PBU) sont souvent inclus à ces constructions.

La technique du PPVC diminue les besoins en main d’œuvre jusqu’à 50 % et réduit de 20 % les temps de construction. Singapour encourage activement le PPVC et le PBU dans les nouvelles constructions. Le BCA propose des financements afin de pallier aux coûts supplémentaires liés au transport, qui peuvent atteindre 15 % de plus qu’avec des méthodes traditionnelles. Enfin, dans le plan de vente de terrains du gouvernement de 2014, des conditions sont imposées aux constructeurs : 65 % des constructions doivent être en PPVC et 65 % des salles d’eau doivent être des PBU.

Les initiatives du gouvernement prennent réalité avec trois projets phares : la construction de résidences étudiantes au Nanyang Technological University ; l’extension de l’hôtel Crowne Plaza de l’aéroport Changi et enfin, un ensemble d’immeubles résidentiels à Camberra Drive qui est à ce jour le plus important projet de PPVC en Asie, voire dans le monde.

Le Virtual Design and Construction est un ensemble de solutions qui permettent d’optimiser la planification en amont afin d’avoir une meilleure gestion des projets. Une des étapes clef est la modélisation 3D des bâtiments avec des outils comme le Building Information Modeling (BIM). Avec de telles méthodes, tous les acteurs (designers, constructeurs, clients, producteurs de modules préfabriqués…) travaillent sur la même interface virtuelle afin de résoudre le maximum de problèmes avant la construction du bâtiment.

Singapour prépare aussi le futur en envisageant des solutions révolutionnaires d’impression 3D de bâtiments. C’est au Singapore center for 3D printing que la recherche est menée sur l’impression d’éléments structurels en béton pour construire des modules à assembler sur chantier. Le gouvernement a investi 135 millions d’euros dans ce centre pour trouver des solutions d’impression 3D dans le bâtiment. Pour ce faire, un ciment spécial sera conçu. Le projet sera présenté cette année au gouvernement pour accord et le premier prototype de bâtiment imprimé est attendu d’ici trois ans.

Article rédigé par Georges Simmonds pour RT Flash

DAIJIWORLD

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Une nouvelle étude présentée à l'occasion du colloque annuel de la société américaine de pédiatrie à Baltimore a confirmé l'existence d'un lien possible entre l'exposition des enfants à l'épandage de produits anti-moustiques et un risque accru de développer des troubles autistiques.

Pour arriver à ce constat, les chercheurs ont confronté le nombre d'enfants diagnostiqués comme autistes par région en fonction de l'utilisation des pesticides. Ils ont ainsi comparé ses résultats sur 16 villes aux alentours de New-York. Les scientifiques ont aussi pris en compte d'autres facteurs comme la richesse des foyers et le sexe des enfants. Résultats : les enfants exposés à l'épandage d’anti-moustiques par voie aérienne présentent un risque accru de 25 % d'être diagnostiqués comme autiste par rapport à ceux qui ne vivent pas dans ces zones.

"Nos données suggèrent que le moyen utilisé pour l'épandage impacte la santé", affirme le Docteur Steve Hicks. Cette étude s'inscrit dans une longue liste de travaux déjà menés pour prouver le lien entre l'exposition aux pesticides et l'autisme. Plusieurs éléments montrent que ces toxiques peuvent affecter des neurotransmetteurs même si "les effets exacts sur le développement du cerveau sont toujours à l'étude".

Reste que cette étude ne permet pas de savoir si les enfants diagnostiqués ont été en contact pendant la grossesse ou après leur naissance. Les chercheurs conseillent cependant aux habitants de ces régions de "rester à l'intérieur pendant l'épandage et de recouvrir les jardins et les jeux pour enfants."

Article rédigé par Georges Simmonds pour RT Flash

PASM

|

|

|

|

|

|

|

|

|

Pour mieux comprendre les récentes migrations de loups en Europe, des chercheurs allemands et tchèques ont émis l'hypothèse que ces animaux pouvaient détecter le champ magnétique terrestre et donc s'orienter... Comme il n'était pas possible de vérifier cette hypothèse avec des loups, peu collaboratifs en laboratoire, ces chercheurs ont demandé à 70 propriétaires de chiens de races et d'âges différents de noter l'orientation de leur animal pendant leurs petits et leur gros besoins (et en toute liberté !). Les chercheurs ont montré que sur les milliers de mesures ainsi réalisées, ces chères bêtes s'orientent préférentiellement selon l'axe Nord-Sud, lorsque le champ magnétique terrestre est stable.

De surcroît, ils tendent à éviter l'axe Est-Ouest. Il est possible que les chiens (aussi bien les mâles que les femelles d'ailleurs !) préfèrent cette orientation pour des raisons de confort, mais les auteurs proposent qu'ils pourraient ainsi recalibrer leur "GPS interne" par rapport aux informations visuelles qu'ils perçoivent de leur environnement. Un peu comme nous avons besoin de nous arrêter pour regarder la carte lors de nos promenades en montagne...

Les chiens et les loups ne sont pas les seuls à percevoir le champ magnétique terrestre. On sait depuis quelques années que les rats-taupes, qui passent leur vie sous terre, possèdent aussi cette faculté indispensable quand les repères visuels sont obscurs.

Plus récemment, la question a été examinée en laboratoire chez des souris (qui s'adaptent très bien à la vie en laboratoire, elles !). Lorsque les interférences extérieures sont atténuées, les souris s'orientent beaucoup mieux dans un labyrinthe si celui-ci est orienté dans l'axe du champ magnétique terrestre. Plusieurs mécanismes sont actuellement étudiés pour comprendre comment certains mammifères peuvent percevoir le champ magnétique terrestre (nanoparticules de magnétite, photoréaction "magnétosensible" dans la rétine) et il semble que selon leur habitat et leur mode de vie, ces mécanismes soient différents. Reste à savoir si certains humains ont pu conserver cette capacité à percevoir le Nord et de façon plus générale les champs magnétiques de faible amplitude ?

Article rédigé par Georges Simmonds pour RT Flash

ESG

|

|

|

|

|

|

|

|

|

On sait à présent que dans la maladie d'Alzheimer, Bêta-amyloïde et tau sont deux protéines anormales dont l’association est nécessaire (mais peut-être pas suffisante) pour déclencher la maladie. En effet, l’accumulation dans le cerveau de ces deux protéines conduit à son endommagement, ce qui cause la maladie d’Alzheimer. C’est ce qui ressort d’une étude menée par l’équipe de Pedro Rosa-Neto, neurologue clinicien au Douglas et professeur adjoint au département de neurologie, de neurochirurgie et de psychiatrie à l’Université McGill.

Cette découverte des chercheurs de l’Institut universitaire de santé mentale Douglas est une grande première qui vient remettre en cause les théories scientifiques qui existaient jusque-là sur la progression de la maladie d’Alzheimer.

Les scientifiques ont toujours soutenu qu’une seule des deux protéines Bêta-amyloïde et tau était responsable de l’évolution de cette maladie. L’innovation majeure qu’apportent Pedro Rosa Neto et son équipe met en exergue pour la première fois le fait que l’interaction entre ces deux protéines entraîne des dommages cérébraux chez des personnes qui ne présentent aucun trouble cognitif. "Nous avons constaté que les deux protéines conjuguent leurs effets toxiques individuels et provoquent ainsi un dysfonctionnement cérébral typique de la maladie d’Alzheimer", souligne le chercheur. Cette découverte remet ainsi en cause des théories scientifiques opposées qui voulaient qu’une seule des deux protéines soit responsable de la progression de la maladie.

Cette étude a été menée sur une période deux ans et a ciblé 120 personnes ne présentant aucun trouble cognitif. Cet échantillon était composé d’hommes et de femmes répartis également et âgés en moyenne de 75 ans. Les chercheurs se sont servis d’instruments éprouvés comme les scanneurs TEP pour mesurer le taux d’amyloïde et ils ont aussi analysé le liquide céphalo-rachidien pour mesurer le taux de la protéine tau.

C’est ainsi qu’ils ont pu identifier ceux des patients les plus à risques de développer la maladie d’Alzheimer. Les résultats de leur étude donnent des raisons d’espérer de réelles avancées en ce qui concerne la prévention et la stabilisation de cette maladie qui touche près de 48 millions de personnes dans le monde, selon un rapport de l’Organisation mondiale de la santé publié en 2015.

Jusqu’à maintenant, les essais cliniques thérapeutiques ciblaient un seul processus pathologique. Notre recherche ouvre la voie à de nouveaux traitements destinés à prévenir ou stabiliser la maladie d’Alzheimer. Par exemple, nous pourrions utiliser une combinaison de traitements pour contrer simultanément l’accumulation de protéines bêta-amyloïde et tau.

Article rédigé par Georges Simmonds pour RT Flash

NW

|

|

|

|

|

|

|

|

|

L'OMS vient d'annoncer que le paludisme avait été à nouveau éradiqué dans les régions d'Europe, d'Asie centrale et du Caucase. Dans ces zones qui correspondent à la "région Europe" de l'Organisation mondiale de la santé, le nombre de cas "indigènes" (transmis localement, et non importés par des patients immigrés) est tombé de 90.712 à zéro en l'espace de 20 ans. Le paludisme, affection qui provoque fièvre, maux de tête, frissons et vomissements, a touché 214 millions de personnes dans le monde, et en a tué 438.000 en 2015, selon l'OMS.

"2011 et 2012 ont vu une résurgence de la transmission du paludisme, en Géorgie (cas isolés) et en Grèce et Turquie du fait de l'importation depuis des pays où la maladie est endémique (Afghanistan, Inde et Pakistan", a expliqué l'OMS. "Cette résurgence a été contenue et, en 2014, la transmission indigène était confinée au Tadjikistan", a-t-elle rappelé.

C'est la deuxième fois que l'Europe, l'Asie centrale et le Caucase se débarrassent du paludisme, aussi appelé malaria. Alors que jusqu'à la fin de la Seconde Guerre mondiale il était "endémique dans la plupart des pays de l'Europe du Sud", du Portugal à la Grèce, les progrès de la santé publique avaient permis d'en libérer l'Europe, après un dernier cas en Yougoslavie en 1974.

Mais dans les années 1980-1990, avec les conséquences de guerres en Afghanistan et en Irak, la maladie était revenue en Asie centrale et en Turquie et, dans une moindre mesure, en Russie. Aujourd'hui, cette maladie potentiellement mortelle, due à une piqûre de moustique infecté, touche en premier lieu l'Afrique subsaharienne. "En 2015, 88 % des cas de paludisme et 90 % des décès dus à cette maladie sont survenus dans cette région", d'après l'OMS.

Article rédigé par Georges Simmonds pour RT Flash

OMS

|

|

|

|

|

|

|

|

|

Selon une étude publiée dans la revue médicale Molecular Psychiatry, le cannabis réduirait les performances cognitives en perturbant la libération de la dopamine, une hormone associée à de meilleures performances pour des tâches cognitives. Le cannabis a déjà été montré du doigt par une étude scientifique américaine pour affecter la mémoire, et par une étude suisse qui explique que fumer régulièrement du cannabis ferait perdre du vocabulaire. Cette nouvelle étude nous apprend qu'il réduirait nos capacités cognitives.

Les chercheurs de l'Université de Columbia (Etats-Unis) ont réalisé une étude avec 11 individus âgés de 21 à 40 ans dépendants au cannabis et ont comparé leurs analyses avec celles de 12 témoins en bonne santé et qui ne consomment pas ce psychotrope. Les scientifiques ont voulu analyser la libération de dopamine dans le cerveau des consommateurs de cannabis.

Ils ont constaté que les consommateurs de cannabis libèrent moins de dopamine dans les zones du cerveau impliquées dans l'apprentissage que le groupe témoin. « La libération de la dopamine est réduite dans le striatum, une zone du cerveau impliquée dans la mémoire de travail, le contrôle et l'attention », explique l'auteur principal, le Docteur Anissa Abi-Dargham, professeur de psychiatrie. « Cet effet est caractéristique du caractère addictif du cannabis ».

Article rédigé par Georges Simmonds pour RT Flash

NCBI

|

|

| ^ Haut |

|

|

|

|

|

|

|

Recherche |

|

|

Recherche & Innovation, Technologies, Transports

|

|

|

|

|

|

|

|

|

|

Si le covoiturage longue distance a explosé avec le formidable succès de Blablacar, le partage de trajets courts et quotidiens peine à décoller en France. Plusieurs collectivités et entreprises, qui avaient développé ces dernières années des plates-formes de mises en relation de leurs administrés et salariés, y ont pour la plupart renoncé.

Des millions de véhicules roulent pourtant à vide, chaque jour, sur les routes de France, notamment pour les trajets domicile / travail. Mais conducteurs et passagers ne veulent pas se retrouver dépendants les uns des autres pour leurs trajets de tous les jours. "Ce système suppose une rigidité très forte, antinomique avec la mobilité de proximité", juge Thomas Matagne, fondateur de la start-up Ecov.

Pour libérer les conducteurs des contraintes qui les empêchent de partager les places vides de leur véhicule, cette jeune pousse a imaginé une nouvelle façon d'aborder le covoiturage. Elle déploie des stations de covoiturage connectées dans les zones périurbaines et rurales, en partenariat avec les collectivités. On y trouve des bornes (développées par le leader français du parcmètre Parkeon) qui permettent aux passagers d'effectuer une demande de trajet. "Il leur suffit de posséder un téléphone mobile et une carte bleue pour s'inscrire", précise le fondateur de la société.

L'information est aussitôt diffusée sur Internet et sur un panneau à affichage variable installé en amont sur la route. Le passager reçoit alors une estimation du coût du partage des frais kilomètres (12 centimes du kilomètre, avec 60 centimes minimum, en plus d'un abonnement fixe d'1,99 euro par mois) et une estimation du temps d'attente. "Nous la réalisons grâce à un modèle mathématique basé sur le flux moyen de voitures qui passent devant la station à cette heure-ci", révèle Thomas Matagne. Si un conducteur s'arrête, le passager lui remet un ticket imprimé sur la borne de covoiturage qui lui permettra de recevoir son paiement.

Cette solution, baptisée "Covoit'ici" commence à séduire les collectivités locales. Une expérimentation de 24 à 36 mois a été lancée en novembre 2015 dans le parc naturel régional du Vexin, au nord-est de Paris, avec le soutien du Conseil Départemental de l'Oise, du Conseil Régional et de la Communauté urbaine Grand Paris Seine Oise. Vingt stations doivent être installées avant l'été. Chacune coûte environ 35 000 euros, soit l'équivalent d'une station Velib.

Article rédigé par Georges Simmonds pour RT Flash

L'Usine Digitale

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|