|

|

Edito

Le succès du lancement de la fusée Falcon Heavy ouvre une nouvelle ère de la conquête spatiale

Contre toute attente et en seulement cinq ans, SpaceX, la société fondée par l’entrepreneur visionnaire Elon Musk, a gagné son pari un peu fou : révolutionner l’industrie aérospatiale en reculant les limites technologiques des lanceurs et fusées actuelles, tout en ouvrant la perspective d’une baisse des coûts d’accès à l’espace qui était encore inimaginable au début de cette décennie.

Il y a d’abord eu l’incroyable exploit du 22 décembre 2015, jour où la mission ORBCOMM-2, qui a placé onze satellites en orbite basse à partir de Cap Canaveral, en Floride, a également réussi la prouesse de récupérer intact, seulement onze minutes après le décollage, le premier étage de cette fusée ; celui-ci a en effet réussi à redescendre en douceur, freiné par ses moteurs Merlin 1D, puis à atterrir exactement à l'endroit prévu, démontrant qu’il est possible de concevoir et d’utiliser à grande échelle des fusées à grande puissance récupérables et réutilisables.

Le 30 mars 2017, fort du succès du lancement de sa fusée Falcon-9 en 2015, une nouvelle mission SpaceX, toujours à partir de Cap Canaveral en Floride, a permis, pour la première fois à l’aide d’une fusée déjà utilisée, de mettre sur orbite le satellite du luxembourgeois SES et de récupérer à nouveau une partie du lanceur qui s’est reposée en douceur sur une barge dans l’océan Atlantique, huit minutes trente après le lancement.

Le 31 janvier 2018, le lanceur Falcon 9 de l'entreprise américaine a réussi à placer sur une orbite géostationnaire le satellite de télécommunications GovSat. Pour cette mission précise, SpaceX avait dès le départ de la mission annoncé que ses équipes ne tenteraient pas de reposer l'étage le plus coûteux de la fusée sur la barge. Le premier étage de ce lanceur Falcon 9, déjà récupéré d'un précédent lancement en mai 2017, devait donc, d'après le plan de vol de la mission, retomber en mer et y disparaître.

Mais les techniciens de SpaceX ont finalement décidé d'actionner ses moteurs (trois au lieu d'un seul comme c'est le cas habituellement dans la phase de descente) avant qu'il ne percute la surface de l'eau, pour le ralentir. Ces derniers ont alors imprimé une poussée beaucoup plus puissante mais beaucoup plus courte que de coutume dans ce genre d'opération, les réservoirs étant pratiquement vides à l'issue de la phase d'ascension.

Résultat, le premier étage a réussi à se poser en douceur à la surface de l'eau et ne s’y est pas désintégré. Il semblerait qu’ensuite ses réservoirs vides, demeurés intacts, aient pu, contre toute attente, jouer le rôle de flotteurs pour le corps de la fusée.

Enfin, le 6 février dernier, la fusée Falcon Heavy de SpaceX a décollé avec succès depuis Cap Canaveral en Floride, devenant le lanceur le plus puissant du monde depuis le dernier vol de la fusée soviétique Energia, en 1989. Après être resté en orbite autour de la Terre pendant cinq heures, la Falcon Heavy, qui dispose d’une capacité double de celle du plus gros lanceur actuel, le Delta-IV américain de Boeing et Lockheed Martin, s’est élancé vers Mars.

Avec ses 70 mètres de haut, ses deux boosters latéraux et au total 27 moteurs Merlin, Falcon Heavy délivre une poussée au décollage de 2 500 tonnes – l’équivalent de 18 Boeing 747. Cette puissance phénoménale devrait lui permettre d’envoyer 63,8 tonnes de matériel en orbite terrestre basse et jusqu’à 16,8 tonnes vers Mars.

Dotée de vingt-sept moteurs Merlin, le Falcon Heavy peut mettre en orbite plus de 54 tonnes, soit « une masse équivalente à un Boeing 737 chargé de ses passagers, équipage, bagages et carburant », précise SpaceX. Cette « superfusée » est constituée d’un assemblage de trois fusées de type Falcon-9, conçues pour être réutilisées. Deux des trois premiers étages, chacun haut de 70 mètres, ont déjà servi et reviendront se poser sur terre à Cap Canaveral. Le troisième, celui du milieu, dont la structure a été renforcée pour résister à la chaleur des deux autres, reviendra sur Terre un peu plus tard.

Dans ce vol historique du 6 février dernier, après deux minutes de vol, deux des lanceurs se sont détachés comme prévu de la fusée centrale qui a poursuivi sa route dans l’espace. Huit minutes et 20 secondes après s’être détachés, les deux boosters se sont posés quasiment simultanément sur deux zones d’atterrissage de Cap Canaveral, à quelques dizaines de mètres seulement l’une de l’autre.

Pour ce vol d’essai hors du commun, la fusée n’a pas emporté de satellites, mais la voiture électrique Tesla du milliardaire américain Elon Musk, fondateur de SpaceX. La destination de ce vol est l’espace lointain, à une distance à peu près équivalente de celle de Mars par rapport au Soleil.

Il n’est pas exagéré de dire, qu’en moins de cinq ans, l’ensemble de ces tirs et missions spatiales réalisés par SpaceX, en dépit de quelques inévitables échecs, a complètement bouleversé tout le secteur aérospatial et ouvert de nouvelles perspectives en matière de conquête spatiale, qui relevaient encore de la science-fiction au début de cette décennie.

Il s’agit d’une réussite d’autant plus éclatante pour cette jeune société et son charismatique fondateur, Elon Musk, qu’il y a encore trois ans, personne n’aurait misé un dollar sur ses chances de succès, dans un domaine d’activité aussi fermé et impitoyable que l’espace, de cet entrepreneur atypique et visionnaire.

Falcon Heavy, la fusée surpuissante de SpaceX, devrait à présent lancer en 2018 plusieurs satellites pour la NASA, l’opérateur saoudien Arabsat et l’américain ViaSat et réaliser également un vol privé autour de la Lune en 2019. Après avoir propulsé la Tesla d’Elon Musk dans l’espace, Falcon Heavy devrait en effet mettre sur orbite des charges utiles dès cette année.

Mais au-delà de ses prouesses techniques, SpaceX est devenue, grâce à sa maîtrise remarquable de ce concept révolutionnaire de fusées récupérables, un nouvel acteur incontournable et redoutable sur ce marché mondial, ô combien prometteur de l’espace. En démontrant qu’il peut placer à moindre fais des charges bien plus lourdes sur orbite haute, SpaceX entend bien chambouler le modèle économique des activités spatiales en divisant par dix, à poids égal, le coût de lancement d’ici dix ans. La société annonce déjà un tarif à 90 millions de dollars pour ses futurs lancements commerciaux. On mesure le chemin déjà parcouru quand on sait que le lanceur le plus lourd, la Delta IV Heavy d’United Launch Alliance, proposait en 2017 des tirs à 350 millions de dollars…

Le succès du lancement et de ce vol de la mégafusée Falcon Heavy devrait également permettre à Space X de décrocher des contrats pour la mise en orbite des satellites très lourds, notamment militaires, dont le nombre va sensiblement augmenter au cours de ces prochaines années. Dans ce domaines, Space X est bien placé pour devenir leader, dans la mesure où sa Falcon peut mettre sur orbite des charges deux fois plus lourdes que ne peut sa principale rivale – la fusée Delta IV Heavy de Boeing. La fusée est en effet en mesure d’emporter jusqu’à 64 tonnes de charge en orbite terrestre.

Mais surtout, en proposant une solution alternative de lancement pour les gros satellites à 90 millions de dollars le tir, grâce à sa maîtrise de la récupération et de la réutilisation des lanceurs, SpaceX va diviser par trois le coût moyen du lancement pour les charges lourdes. L’entreprise d’Elon Musk a d’ailleurs déjà convaincu deux clients, Arabsat, un consortium de communication par satellite de pays arabes, et l’armée de l’air américaine.

Mais, à l’autre extrémité de ce marché spatial en plein essor, SpaceX compte bien également – qui peut le plus, peut le moins – s’imposer sur le lucratif marché des mini et microsatellites. Les projets impliquant la mise en orbite basse terrestre (moins de 500 km), de ce type de satellite ne cessent de se multiplier, tant dans le domaine militaire que scientifique et industriel. L’un des atouts majeurs de ces « constellations » de satellites est de pouvoir réaliser des observations d’un même endroit du globe dans un laps de temps très rapproché.

Le secteur numérique est également particulièrement intéressé par ces réseaux satellitaires en orbite basse qui permettraient de déployer assez rapidement, et à faible coût, l’internet mobile dans les régions les plus reculées de la planète, ou d’améliorer la qualité de la couverture dans les mégapoles. Notons d’ailleurs que SpaceX développe son propre projet en la matière, puisque l’entreprise d’Elon Musk veut proposer un accès haut débit à l’internet partout dans la monde, grâce à la mise en orbite d’une constellation de près de 4.000 satellites.

Reste que, sur ce marché des petits satellites en orbite basse, SpaceX devra compter avec une concurrence de plus en plus rude. C’est ainsi que la société Vector, fondée par Jim Cantrell, un ancien de l’équipe SpaceX et basée à Tuckson (Arizona), ambitionne de révolutionner l’accès à l’espace en proposant des tirs à 1,5 million de dollars pour Vector R (50 à 66kg de charge utile), et 3,5 millions de dollars pour un tir de Vector H (150kg de charge utile. « Avec ces nouvelles offres à bas prix, et une fréquence de lancements élevée, de l’ordre de 500 par an, nous allons permettre à de nombreuses sociétés de lancer leurs projets spatiaux, ce qu’elles n’auraient pas pu faire avec les tarifs actuels », souligne Jim Cantrell.

Il est vrai que, selon la banque d’affaires Bank of America Merrill Lynch, le marché mondial de l’espace, pourrait être multiplié par huit au cours des 25 prochaines années, passant de 340 milliards de dollars par an, en 2017, à 2 700 milliards par an en 2045, soit environ 2 % du produit mondial brut prévu à cette échéance.

Mais le formidable développement des activités spatiales ne se limite plus au lancement et la mise sur orbite d’un nombre toujours plus grand de satellites autour de la Terre. A moyen et long terme, l’exploration, l’exploitation et la colonisation de l’espace proche (La Lune), et lointain - la planète Mars et certains astéroïdes riches en minerais précieux - représentent également des enjeux économiques et politiques majeurs. La Chine et l’Inde, les deux puissances émergentes de la planète, ne s’y sont d’ailleurs pas trompées et avancent à marche forcée dans d’ambitieux programmes d’exploration spatiale : pendant que la Chine s’apprête à réaliser une première mondiale en préparant une nouvelle mission Chang’e 3 et l’alunissage d’un rover sur la face cachée de la Lune, son nouveau rival spatial, l’Inde prépare activement la mission Chandrayaan 2 qui doit consister à faire alunir près du pôle Sud de la Lune son premier engin d’exploration, un petit rover bardé d’instruments de mesure et de capteurs destinés à approfondir la connaissance de notre satellite.

Pour accélérer la conquête spatiale, SpaceX a dévoilé, en septembre 2017, une ébauche du BFR, pour Big Falcon Rocket. Il s’agit d’une navette capable de se rendre sur la Lune et sur Mars avec des passagers. Trois fois plus puissante que la Falcon Heavy, cette fusée BFR devrait effectuer son premier vol dès 2020 et Elon Musk prévoit déjà deux vols cargo vers la planète rouge dès 2022, puis quatre en 2024, dont deux habités…

La fusée BFR, dont tous les éléments seront réutilisables, pourra transporter 150 tonnes de matériel, ce qui est jusqu'à dix fois plus que ce qu'autorisent les fusées actuelles. Elle se décompose en deux étages : les boosters et le compartiment, également équipé de moteurs, pour la charge utile emportée. Deux versions sont prévues : l’une avec une coiffe, dite « version cargo » pour transporter des satellites ou du matériel, une autre pour emmener des humains dans l'espace.

Avec la BFR, SpaceX veut mettre au point une fusée réellement polyvalente, un véritable « couteau suisse » de l’espace, qui sera en mesure de réaliser de nombreux types de missions, qui vont du ravitaillement de l'ISS à la colonisation de la Lune et de Mars. Ce monstre de puissance pourrait être équipé de six moteurs Raptor, quatre de 2,4 m de diamètre pour la propulsion dans le vide (1 900 kN de poussée) et deux de 1,3 m utilisables dans l'atmosphère (1 700 kN de poussée). Ces derniers sont redondants : si l'un tombe en panne, la fusée peut quand même se poser sur la terre ferme.

Loin d’être décousue et hasardeuse, la stratégie d’Elon Musk et de SpaceX apparaît à présent comme parfaitement cohérente. Elle repose sur trois paris tout à fait plausibles : le premier est qu’en réussissant à diviser par dix le coût moyen de mise en orbite d’une charge utile, on multiplie par cent le nombre de clients et de services potentiels et on fait entrer le secteur spatial dans l’ère de l’industrie de masse, avec à la clé un chiffre d’affaires global qui pourrait bien dépasser celui du numérique d’ici 2050.

Le deuxième est qu’on va assister bien plus vite que prévu à une convergence et une synergie fortement créatrices de valeur entre les activités spatiales et les services numériques. Enfin, le troisième pari, à plus long terme, est que la conquête, l’exploration et l’exploitation des immenses ressources de notre système solaire passent par l’installation d’une base permanente sur la Lune (peut-être en aménageant la gigantesque grotte de 55 km de long et 50 mètres de large découverte récemment dans le sous-sol lunaire et dans laquelle scientifiques et techniciens seraient à l’abri des radiations cosmiques) et ne pourront se faire qu’à partir d’un nouveau modèle de coopération économique entre le secteur public et privé.

Mais avant d’aller explorer notre satellite lunaire ou la planète rouge, cette fusée pouvant atteindre une vitesse de croisière de 27 000 km/h pourrait aussi être exploitée dès 2022 par SpaceX pour opérer des vols commerciaux pouvant relier, en à peine une heure, les principales villes de la planète.

Dans la vidéo de présentation de ce projet (Voir youtube), on peut d’ailleurs voir des passagers embarquer à New York, sur l'Hudson River, à bord d'une navette qui les emmène jusqu’à une base de lancement flottante installée au large. Une fois les passagers installés dans la capsule de transport, la fusée décolle et effectue un vol stratosphérique. Ensuite, ses boosters se détachent et reviennent à leur point de départ pour être réutilisés. Les passagers atterrissent enfin à Shanghai, seulement 39 minutes plus tard…

Il ne fait aujourd’hui plus de doute que notre siècle sera celui qui verra l’homme, non seulement partir explorer le système solaire mais s’installer de manière permanente sur d’autres mondes. Sans doute est-ce le destin de notre singulière espèce que de quitter son berceau terrestre pour aller essaimer dans le vaste Univers, à la recherche de nouveaux mystères et d’horizons toujours plus lointains…

J'avais fini de rédiger cet édito quand, avant-hier, Stephen Hawking nous a quittés. Je ne puis conclure ce plaidoyer pour la conquête de l'Espace sans rappeler ce qu'avait dit solennellement ce génie lors d'une conférence à Oxford, il y a moins de 2 ans : "Je ne pense pas", disait Stephen Hawking, "que nous survivrons encore 1000 ans sans nous échapper de notre fragile planète. Nous devons continuer à explorer l'Espace pour le futur de l'Humanité". "Je pense que l'Humanité n'a pas d'avenir si elle ne va pas dans l'Espace" avait-il ajouté avec insistance.

En conclusion de cette conférence, il ajoutait : "Notre image de l'Univers a beaucoup changé au cours de ces 50 dernières années et je suis heureux si j'y ai apporté une petite contribution..." C'était quelques mois avant sa mort.

Lors de son 70 ° anniversaire, il nous avait déjà délivré un message très fort : "Souvenez-vous de toujours regarder en haut vers les étoiles et pas en bas vers vos pieds".

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

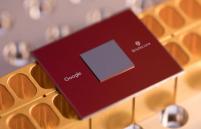

Désormais, il n'y a pas une semaine sans annonce fracassante, concernant la maîtrise de l'ordinateur quantique, censée renvoyer à l'âge de pierre le principe booléen sur lequel repose l'informatique depuis trois quarts de siècle. Il y a quelques jours, à l'occasion de la conférence annuelle de la société américaine de physique, qui s'est tenue à Los Angeles, Google a ainsi présenté sa nouvelle puce quantique baptisée "Bristlecone".

Google précise “avoir cherché à démontrer la suprématie quantique pour l’avenir, étudier la correction d’erreurs de premier et de second ordre en utilisant le code de surface et faciliter le développement d’algorithmes quantiques sur du matériel réel”.

L'objectif final de Google reste toutefois de parvenir au "Graal" de l'informatique : atteindre 49 qubits viables, seuil considéré comme le point de rupture vers la fameuse "suprématie quantique", à partir de laquelle nos ordinateurs actuels les plus puissants ne peuvent plus rivaliser en terme de puissance de calcul. Mais dans cette course aux qbits, Google s'est focalisé sur un point aussi essentiel que le nombre de qbits pouvant calculer simultanément : l’obtention du plus faible taux d’erreurs possible.

La stabilité des fameux qbits reste en effet très fragile et ceux-ci ont une fâcheuse tendance à la "décohérence quantique", ce qui les rend alors inutilisables pour le calcul. Les précédents systèmes quantiques présentés par Google affichaient un taux d’erreur de 1 % pour la lecture, de 0,1 % pour le “simple qbit” et de 0,6 % pour les portes logiques à deux qbits. Il semblerait que Google soit parvenu à conserver ces mêmes taux d'erreur assez faibles avec son Bristlecone.

Rappelons également, dans cette compétition technologique majeure, que Microsoft pourrait rapidement atteindre les 49 qbits et qu'IBM propose déjà une machine de 50 qubits. Le géant des microprocesseurs Intel, en partenariat avec une équipe de chercheurs de l’Université de technologie de Delft aux Pays-Bas, vient quant à lui de présenter le premier ordinateur quantique équipé de puces en silicium et reposant sur le principe de l'utilisation d'une paire de "spin-qbits" (Nature).

Enfin, une équipe australienne (Université de Nouvelle-Galles du Sud (Australie), a annoncé avoir réussi à concevoir une architecture combinant des millions de qubits, tout en conservant les technologies traditionnelles de fabrication des composants CMOS sur silicium (RT Flash).

Article rédigé par Georges Simmonds pour RT Flash

Google

|

|

|

|

|

|

|

|

|

Des chercheurs anglais, avec l’aide d’Eve, un « robot scientifique », ont découvert que le triclosan, un antibactérien largement utilisé dans la vie courante (dans les dentifrices ou les jouets, par exemple) était efficace pendant les différentes phases du cycle de vie du paludisme (hépatique et érythrocytaire).

On savait déjà depuis 2001 que le triclosan inhibait in vitro la propagation de Plasmodium falciparum. Or ce composé prévient la formation de la plaque bactérienne en inhibant l’enoyl réductase (ENR), une enzyme impliquée dans la production d’acides gras.

Les chercheurs supposaient que son action sur le parasite était due à une capacité à cibler l’ENR présente dans le foie. Mais des travaux postérieurs avaient battu cette idée en brèche. L’équipe britannique a découvert que le triclosan affectait la croissance des parasites en inhibant une autre enzyme, la dihydrofolate réductase (DHFR).

Cette dernière est la cible de deux antipaludéens, la pyriméthamine et le proguanil, mais la résistance à ces médicaments se développe, surtout en Afrique. Or le triclosan est capable de cibler et d’agir sur cette enzyme, même dans les parasites résistant à la pyriméthamine. Le triclosan inhibant l’ENR et la DHFR (la première impliquée dans le stade hépatique, et la seconde dans le stade sanguin), les chercheurs espèrent que ce composé cible le parasite dans ces deux phases.

Or les médicaments qui ciblent le parasite à ces deux phases de son cycle de vie (primaquine et tafenoquine) augmentent le risque d’hémolyse chez les patients présentant un déficit en G6PD, une affection très prévalente dans les régions impaludées.

Les auteurs notent aussi que le triclosan est utilisé dans des produits de consommation courante à des doses bien supérieures à celles utilisées dans cette étude, suggérant qu’il pourrait être employé avec peu de risque de toxicité à court terme. « Il pourrait s’agir de la première étape dans le développement d’une nouvelle classe d’antipaludéens », concluent-ils dans leur article.

Les chercheurs ont utilisé dans leur étude un « robot scientifique », doté d’une intelligence artificielle, nommé Eve. Développé par une équipe des universités de Manchester, Aberystwyth et Cambridge, ce robot automatise et accélère le processus de découverte des médicaments en testant automatiquement des hypothèses et en interprétant les résultats sur de nombreux composés les uns après les autres.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

| ^ Haut |

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

Initiée par la Faculté des ingénieurs de l’Université du Caire et l’Institut HIP (Héritage Innovation Préservation), la mission ScanPyramids, avec le concours du CEA, avait annoncé la découverte de cavités inconnues jusqu’à présent. Les premiers résultats datent en fait d’octobre 2016 et, depuis lors, les équipes scientifiques s’interrogent sur la manière d’explorer l’intérieur de ces cavités en les laissant intactes. Un robot ne pourrait-il pas se faufiler dans un trou de souris, résultat d’un perçage minutieux, puis atteindre ces recoins de pyramide toujours cachés aux yeux du monde ?

La mission ScanPyramids prend contact avec l’Inria (Institut national de recherche en informatique et en automatique) et ses experts-roboticiens. "A l’époque, nous ne savions pas réaliser ce genre de robot explorateur", admet Jean-Baptiste Mouret, chercheur et spécialiste en robotique et en intelligence artificielle. "Mais le challenge était intéressant". Le projet pour réaliser ce robot « minimalement invasif » est amorcé et, un an plus tard, les premiers détails techniques viennent d’être dévoilés : les chercheurs de l’Inria ne vont pas réaliser un seul robot miniature, mais deux. Le premier robot fait figure d’éclaireur et sert à établir l’état des lieux, en quelque sorte. Le second, qui ressemble à un petit dirigeable, est prévu pour se déplacer et examiner le site plus en détails, si possible ou si nécessaire.

"Le robot de reconnaissance est équipé d’une caméra, orientable dans toutes les directions, qui permet de produire des images panoramiques de 15 000 pixels de large", explique Jean-Baptiste Mouret. "Les trois torches bénéficient d’une puissance totale de 1500 lumens afin de percer l’obscurité. Le robot ne mesure que 3,5 centimètres de diamètre et il a fallu caser les moteurs, l’électronique…"

Relié à un câble transportant l’énergie et les données, ce robot se déplace à l’aide de roues et de chenillettes. "Celles-ci sont en contact permanent avec la paroi du trou pour assurer la propulsion, grâce au système de suspension que nous avons mis au point" détaille Jean-Baptiste Mouret. Le robot est aujourd’hui quasi-fonctionnel, bien qu’il demande encore à être éprouvé hors d’un laboratoire. A l’exception des composants électroniques et des axes, les prototypes ont été intégralement fabriqués en plastique, à partir d’une imprimante 3D Form 2.

Long de 30 à 35 centimètres dans sa configuration initiale, ce robot a l’avantage d’être modulaire. Les composants de propulsion sont indispensables, mais la plupart des autres pièces sont interchangeables. Une fois sa mission accomplie, le module de reconnaissance revient à son point de départ, est retiré puis remplacé par le robot d’exploration, qui emprunte le même chemin. Pour cette phase qui demande un robot mobile et même volant, les chercheurs de l’Inria ont imaginé et conçu un petit dirigeable, gonflé à l’hélium, et sa station d’accueil, autrement dit une mini-piste d’envol et d’atterrissage.

Le dirigeable est piloté à distance par un opérateur à l’aide un émetteur-récepteur radio, logé dans la station d’accueil. La « nacelle » embarque plusieurs composants, pour certains issus du modélisme, dont quatre moteurs, des projecteurs, une caméra analogique, un micro-contrôleur et surtout plusieurs capteurs qui aident à la navigation. Car l’engin est conçu pour être partiellement autonome. "Si la liaison radio est perdue, le robot doit retourner à sa base de lui-même", commente Jean-Baptiste Mouret. "Dans une situation normale, ces capteurs assistent le pilotage, pendant le vol, et l’atterrissage de précision sur la station d’accueil".

Le dépliement et le repliement de ce ballon, quand il est de retour sur la station d’accueil, donne toujours du grain à moudre aux chercheurs de l’Inria. "C’est en cours de réflexion, mais les astuces que nous mettons en œuvre commencent à fonctionner", se réjouit Jean-Baptiste Mouret. "Le robot volant requiert encore au moins un an de travail avant que nous n’obtenions un prototype fiable".

Article rédigé par Georges Simmonds pour RT Flash

Techniques de l'Ingénieur

|

|

|

|

|

|

|

|

|

Des chercheurs du MIT ont développé un process simple et à bas coût qui permet de produire des nanofibres de polyéthylène exceptionnellement rigides, solides et résistantes. Elles pourraient devenir un matériau de choix pour des nanocomposites ou des revêtements protecteurs.

Le nouveau procédé s’appuie sur une méthode d’électrofilage d’un gel (gel electrospinning). Les nanofibres de polyéthylène obtenues ont la particularité de présenter à la fois une forte rigidité, une forte ténacité et une forte résistance. Or, il est souvent difficile de trouver des matériaux dont l’extrême performance d’une de ses qualités n’affaiblit pas une autre.

Ainsi, une trop forte rigidité diminue souvent la ténacité et mène à des fractures du matériau. Mais dans ce cas, les propriétés des fibres obtenues équivalent voire surpassent celles que l’on peut trouver dans des matériaux comme le Kevlar ou le Dyneema utilisés pour les gilets pare-balles.

Ces recherches portaient à l’origine sur la fabrication de fibres de différentes tailles en dessous du micron et sur leur caractérisation. « Il n’y a pas beaucoup de nouveautés en matière de nanofibres de hautes performances depuis des années car ce qui existe déjà est très performant », explique Gregory C. Rutledge, superviseur de ces recherches, dans un article publié par le MIT. « Cependant, ces nouvelles fibres, comparées aux fibres de carbones ou aux fibres céramiques utilisées actuellement sont aussi résistantes mais plus tenaces à la fracture et ce dans une mesure très notable », poursuit-il.

Le procédé mis au point est très similaire au filage de gel (gel spinning) utilisé de manière courante, mais il se réalise en une seule étape et utilise des forces électriques à la place de forces mécaniques pour créer les fibres. Concrètement, le gel de polymère est extrudé via une seringue chauffée dans une chambre où est appliqué un champ électrique. Cela permet de produire des fibres de quelques centaines de nanomètres au lieu de fibres de l’ordre de 15 micromètres. Les chercheurs ont testé de multiples compositions pour le gel (différents solvants et concentration) et examiné les différentes fibres ainsi créées.

Il semblerait que plus les fibres sont fines plus leurs performances augmentent. Cette corrélation est pour le moment attribuée à un taux important de cristallinité, à l’orientation des cristallites (monocristaux isolés) combinés à des chaînes de polymères présentant peu de défauts et pouvant glisser facilement entre elles. Mais le fonctionnement exact n’est pas encore percé. Ce procédé présente l’avantage d’être facilement transposable à une échelle industrielle et ouvre des perspectives intéressantes pour la création de nouveaux matériaux composites.

Article rédigé par Georges Simmonds pour RT Flash

Techniques de l'Ingénieur

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Les chercheurs de l’Université d'État de Caroline du Nord ont développé une technique inédite pour imprimer directement des circuits métalliques, permettant ainsi la création d’appareils électroniques flexibles et extensibles. Exploitable avec différents métaux et substrats, cette technique est compatible avec les systèmes de production existants qui utilisent des procédés d'impression directe.

« L'électronique flexible est une technologie très prometteuse, mais elle induit, avec les techniques actuelles, des coûts de production considérables pour être exploitable », a indiqué Jingyan Dong, maître de conférences au sein du département Edward P. Fitts de Génie industriel et système de l’université.

La nouvelle technique fait appel à la technologie d'impression jet d'encre EHD (électrohydrodynamique), déjà appliquée à de nombreux processus industriels utilisant des encres fonctionnelles. L'équipe de Jingyan Dong remplace l'encre par des alliages métalliques possédant des points de fusion atteignant 60°C. Les chercheurs ont testé cette technique avec trois alliages et quatre substrats différents : verre, papier et deux polymères extensibles. « L'impression directe ne nécessite ni masque, ni gravure, ni gabarit. C'est ce qui permet de simplifier le processus », précise Jingyan Dong.

Les chercheurs ont testé la résilience des circuits sur un substrat de polymère et n'ont constaté aucune altération de la conductivité après avoir effectué 1000 flexions. Les circuits sont restés électriquement stables, même avec une contrainte de tension mécanique de 70 %.

Les chercheurs ont également découvert que les circuits pouvaient se « réparer » eux-mêmes en cas de rupture ou d'extension trop importante. « La température de fusion étant basse, lorsque la zone détériorée est chauffée à environ 70°C, le métal de chaque partie concernée se déplace vers l'autre et répare le défaut », indique Jingyan Dong.

Les chercheurs ont démontré les caractéristiques fonctionnelles de la technique d'impression en créant un capteur tactile à haute densité et une matrice de 400 pixels sur une surface d'un centimètre carré. Selon l'équipe de recherche, la technique est applicable à la production de capteurs portables ou d'autres appareils électroniques.

Article rédigé par Georges Simmonds pour RT Flash

AMT

|

|

|

|

|

|

|

|

|

Hysilabs, créée en 2014 par Pierre-Emmanuel Casanova, master de biotechnologie et Vincent Lôme, ingénieur en biotechnologie, propose une source d'hydrogène alternative qui ne repose pas sur le stockage sous haute pression dans des bonbonnes. "En fait, l'hydrogène que nous développons est stocké dans des vecteurs liquides", explique le jeune ingénieur. "Lorsqu'on mélange notre produit à l'eau, l'hydrogène est alors produit."

Ce concept, qui offre trois plus d'énergie à volume égale qu'une pile classique, pourrait équiper des vélos électriques, des téléphones, des lampes torches. Côté protection de l'environnement, la réaction chimique hydrogène-pile à combustible produit du sable, ce qui est donc moins polluant que les piles classiques.

Cette solution de rupture technologique dans les énergies tire parti des avantages de l'hydrogène sans les problématiques historiquement liées à son stockage et son transport. "Grâce à cette solution", souligne Pierre-Emmanuel Casanova, "on peut transporter pour un même volume sept fois plus d'hydrogène sous forme liquide que sous forme gazeuse. Nous sommes aujourd'hui dans une phase de pré-industrialisation."

La jeune pousse aixoise a opéré une levée de fonds de 2 millions d'euros qui vont lui permettre de continuer à travailler et se développer. "Nous sommes quatre, nous allons passer à huit, et nous allons déposer une dizaine de brevets", poursuit le cofondateur d'Hysilabs, une nouvelle fois primée en décembre lors du challenge Open Innovation, dans le cadre du forum Envirorisk.

Article rédigé par Georges Simmonds pour RT Flash

La Provence

|

|

| ^ Haut |

|

|

|

|

|

|

|

Espace |

|

|

Espace et Cosmologie

|

|

|

|

|

|

|

|

|

|

Une équipe d’astronomes s’appuyant sur le Green Bank Telescope, en Virginie-Occidentale, a identifié les signatures de la molécule benzonitrile (C6H5CN), empêtrée dans une masse de gaz et de poussière appelée nuage moléculaire 1 du Taureau, que vous retrouverez à 430 années-lumière de la Terre dans la constellation éponyme.

Ce nuage est également considéré comme la région de formation d’étoiles d’importance la plus proche du système solaire. Le cœur du benzonitrile est un hexagone à six carbones appelé benzène – une structure qui place le composé dans la classe des molécules dites aromatiques – et fait du benzonitrile un élément constitutif d’un groupe appelé hydrocarbures aromatiques polycycliques (HAP), qui contient beaucoup d’hexagones de carbone.

Comprendre d’où viennent ces molécules et comprendre leur rôle dans l’espace est donc un objectif clé de l’astronomie. Les scientifiques pensent que les HAP sont incroyablement communs dans l’Univers, mais les astronomes n’avaient à ce jour pas encore identifié une telle molécule dans l’espace. Cette nouvelle étude est une étape importante visant à comprendre comment des planètes comme la Terre ont obtenu leur carbone.

Si les HAP contiennent les ingrédients de la vie, ils en sont aussi les ennemis à cause de leur potentiel cancérigène. Ces molécules se retrouvent souvent sur Terre dans les gaz d’échappement des voitures et les émissions des cheminées. La raison pour laquelle elles sont si mauvaises pour notre santé est parce qu’elles sont difficiles à « briser » – leur anneau de carbone central est extrêmement stable et résistant aux réactions.

Par conséquent, notre corps à du mal à les détruire. Mais cette stabilité signifie également qu’elles peuvent rester pendant de très longues périodes dans l’environnement hostile de l’espace, bien qu’occasionnellement fissurées par des photons de très haute énergie.

Pour repérer le benzonitrile, l’équipe de chercheurs menée par le chimiste Brett McGuire de l’Observatoire national de radioastronomie (Virginie), s’est penchée sur le nuage moléculaire 1 du Taureau pendant plus de 35 heures. Le but de cette expérience a été de combiner toute la lumière recueillie en un seul ensemble de données dans le but de retranscrire la signature moléculaire. Chaque espèce chimique a des longueurs d’onde de lumière caractéristiques qu’elle émet ou absorbe, et qui dépendent de sa configuration précise. Le benzonitrile a fait connaître sa présence en émettant des photons dans la gamme radioélectrique du spectre électromagnétique.

Article rédigé par Georges Simmonds pour RT Flash

Science Post

|

|

|

|

|

|

|

|

|

Après plus de 10 années de recherche, l’Agence Spatiale Européenne a testé avec succès le premier propulseur utilisant les molécules présentes dans l’air comme carburant. Bien plus léger et beaucoup moins coûteux à fabriquer que les propulseurs actuels, il pourrait, d'ici quelques années, révolutionner la conquête spatiale.

Ce nouveau type de moteur peut collecter, compresser, charger électriquement et relâcher les molécules d’air. Le besoin en carburant chimique est ainsi supprimé. Seule de l’électricité est requise pour l’ionisation moléculaire, et celle-ci peut être produite via l’énergie solaire. Un tel dispositif pourrait servir de moyen de propulsion aux satellites présents en orbites basses.

Selon les tests effectués en laboratoire par l’équipe d’ingénieurs de l’ESA en charge du projet, le propulseur pourrait mouvoir une « nouvelle classe de satellites » pendant plusieurs années autour de planètes comme la Terre ou Mars. « Ces résultats signifient que la propulsion électrique utilisant l’air n’est plus uniquement une théorie mais est dorénavant un concept tangible, qui fonctionne et qui ne demande qu’à être développé pour servir, un jour, de base à un tout nouveau type de missions » explique Louis Walpot, chercheur à l’ESA.

L’Agence Spatiale Européenne a travaillé sur ce projet pendant plus de 10 ans. Son satellite GOCE, mesurant le champ gravitationnel de la Terre, a opéré pendant plus de 5 ans grâce à un système de propulsion similaire, tout en utilisant 40 kg de xénon comme propergol additionnel. Bien que la densité moléculaire de l’espace soit trop faible, une quantité suffisante de molécules peut être collectée en orbites basses pour servir de boost périodique aux satellites. Un tel boost est par exemple nécessaire pour « rehausser » ces derniers lorsque les couches atmosphériques extérieures les ralentissent et les entraînent progressivement vers la Terre.

La clé du fonctionnement de ce nouveau propulseur a été de trouver un moyen de collecter et compresser les rares molécules d’air plutôt que de simplement les faire rebondir dans la tuyère. Ensuite, la charge électrique et la ionisation sont des étapes cruciales afin de fournir l’accélération désirée.

Pour ce faire, les ingénieurs ont utilisé une chambre à vide située en Italie afin de simuler les conditions atmosphériques à une altitude de 200 km. En outre, le propulseur a été réglé pour simuler un satellite se déplaçant à 7.8 km/s. Sans embarquer de valves ou d’autres pièces mécaniques complexes, le propulseur requiert seulement l’énergie permettant de charger électriquement les molécules, de les accélérer et les éjecter. Les ingénieurs ont spécialement construit un système à deux étages pour le test. Le propulseur a d’abord été testé avec du xénon, puis avec un mélange d’oxygène-azote et enfin simplement avec des molécules d’air.

Si le prototype de l’ESA, développé par la société italienne Sitael, fonctionne avec de l’air résiduel composé principalement d’oxygène et d’azote, ce nouveau type de propulseur pourrait, en théorie, également fonctionner dans l’atmosphère d’autres planètes. Il serait par exemple possible, selon l'ESA, d'alimenter un tel moteur ionique en récupérant le dioxyde de carbone de Mars…

Article rédigé par Georges Simmonds pour RT Flash

Tech 2

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Selon les travaux d'une équipe de l'École de médecine de l'Université Washington à Saint-Louis (Missouri), le manque de sommeil favoriserait la pathologie cérébrale en jeu dans la maladie d'Alzheimer.

L'une des caractéristiques de cette pathologie cérébrale est la présence dans le cerveau de plaques dites amyloïdes, formées par des agrégats de peptides bêta-amyloïdes produits par les neurones. Selon la théorie de "la cascade amyloïde" (toujours privilégiée à ce jour quoique débattue), la synergie entre ces plaques et une autre protéine, la protéine tau phosphorylée, aboutirait à la dégénérescence des neurones chez le malade.

Pour mieux évaluer quel rôle joue le sommeil dans cette pathologie amyloïde cérébrale, Randall Bateman, premier auteur de l'étude, Brendan Lucey, professeur assistant de neurologie, et leurs collègues de l'Université Washington ont fait appel à huit volontaires de 30 à 60 ans, sans problèmes de sommeil ni cognitifs.

Chaque sujet pouvait, au hasard, faire une nuit normale, ne pas dormir, ou dormir avec un narcotique qui augmente le sommeil à ondes lentes (le plus profond et récupérateur). Chaque scenario durait 36 heures pendant lesquelles les personnes étaient surveillées. Surtout, ils portaient un cathéter lombaire qui permettait de récolter régulièrement un peu de liquide céphalorachidien pour mesurer les taux de peptides bêta-amyloïdes présents. Six mois plus tard, les huit participants sont revenus expérimenter un des trois autres scénarios dans les mêmes circonstances. Quatre sur les huit ont accompli les trois cas de figure.

Les résultats ont été sans appel : les taux de peptide bêta-amyloïde chez les personnes privées de sommeil étaient de 25 à 30 % plus élevés que ceux qui avaient dormi toute la nuit ! Quand à ceux qui avaient pris un narcotique, ils avaient des niveaux de bêta-amyloïde équivalents à ceux qui avaient dormi normalement. L'aide de médicaments n'apporte donc pas d'avantages pour un adulte en bonne santé sans problème pour dormir. "Cette étude est la démonstration la plus claire chez l'homme que la perturbation du sommeil conduit à un risque accru de maladie d'Alzheimer par un mécanisme bêta-amyloïde", assure Randall Bateman. Et ce, à cause de la surproduction du peptide délétère pendant la phase de privation de sommeil.

Selon ces chercheurs, chez beaucoup d'adultes âgés, la qualité du sommeil s'altère. Il en résulte que la concentration de peptide bêta-amyloïde durant la période de sommeil ne baisse plus aussi fortement que chez des sujets ayant un sommeil suffisant, ce qui entraîne en retour une augmentation du risque de formation de plaques de bêta-amyloïde dans le cerveau. Ces recherches montrent qu'il est très important pour les seniors de conserver un sommeil suffisant et de qualité et de consulter, lorsqu'ils constatent une altération durable de leur sommeil.

Article rédigé par Georges Simmonds pour RT Flash

AON

|

|

|

|

|

|

|

|

|

Jusqu’à tout récemment, la prévention contre le zona demeurait partielle en raison d’une efficacité relative du seul vaccin disponible, le Zostavax, en particulier chez les personnes âgées. Par exemple, comparativement à un placebo, ce vaccin diminue de 70 % le risque de zona chez les personnes de 50 à 59 ans, mais seulement de 18 % chez celles de 80 ans et plus.

L’arrivée sur le marché d’un nouveau vaccin (Shingrix) va permettre d’améliorer significativement cette protection. Ce vaccin non vivant (glycoprotéine E recombinante du virus VZV comme antigène) est combiné avec un adjuvant spécialement conçu pour renforcer la réponse immunitaire de façon à contourner le déclin normal du système immunitaire associé au vieillissement.

Les études cliniques réalisées pour démontrer l’efficacité de ce vaccin sont très concluantes : par exemple, une étude clinique de phase 3 à grande échelle, réalisée auprès de 15 411 participants répartis dans 18 pays, a montré que ce vaccin présentait une efficacité globale supérieure à 96 % pour les personnes âgées de 50 ans et plus et de 90 % pour celles âgées de 70 ans et plus.

Ces résultats spectaculaires font en sorte que le Shingrix a été homologué au Canada et est maintenant offert dans les cabinets médicaux et les pharmacies pour la prévention du zona chez les adultes de 50 ans ou plus. En diminuant drastiquement le risque de névralgies incapacitantes, ce vaccin représente une avancée majeure pour l’amélioration de la qualité de vie des personnes âgées.

Article rédigé par Georges Simmonds pour RT Flash

Le Journal de Montréal

|

|

|

|

|

|

|

|

|

Selon une étude américaine réalisée par des chercheurs des universités du Minnesota et de l’Alabama, le fait d'allaiter son bébé pendant au moins six mois réduit jusqu'à 47 % le risque des mères d'avoir un diabète de type 2 au cours de leur vie. Ces résultats seraient valables pour toutes les femmes, quelle que soit leur origine ethnique.

Cette découverte est particulièrement importante pour les Américaines noires qui allaitent le moins leurs enfants, précisent les chercheurs. Selon des données publiées notamment par l'American Diabetes Association, les femmes noires sont plus à risque de développer le diabète que les femmes blanches aux États-Unis. Cette étude a porté sur plus de 1200 femmes de 18 à 30 ans, dont 615 Noires ayant participé à des observations entre 1985 et 2015.

Les scientifiques estiment que le nombre élevé de femmes frappées par le diabète est lié à l’obésité. Les raisons qui expliquent les bénéfices de l'allaitement pour la santé des femmes ne sont toujours pas clairement déterminées. Les chercheurs estiment que la réponse se trouverait éventuellement du côté des hormones, qui agiraient peut-être comme des agents protecteurs. Le fait de ne pas allaiter affecterait ainsi l'équilibre hormonal.

Les résultats de cette étude pourraient avoir un impact sur les politiques sociales, notamment s'il faut encourager un allongement du congé maternité pour permettre aux femmes d'allaiter leurs enfants plus longtemps et de bénéficier pleinement de ces effets positifs sur la santé, ont avancé les scientifiques.

Déjà en 2009, des effets protecteurs de l'allaitement avaient été constatés chez les femmes ménopausées qui avaient allaité leurs bébés quand elles étaient plus jeunes. Celles-ci présentaient moins de problèmes cardiaques et de diabète que celles n'ayant pas donné le sein.

Une autre étude de l'Université du Manitoba a montré que l'allaitement diminue de plus de 60 % le risque d’asthme. D’autres recherches avaient révélé des bienfaits de l'allaitement pour la santé du nouveau-né et de sa mère, dont un risque moindre de cancer ovarien.

Article rédigé par Georges Simmonds pour RT Flash

JAMA

|

|

|

|

|

|

|

|

|

Des chercheurs américains de l'Université du Michigan ont mis au point un nouveau type de cartilage synthétique, fabriqué avec le même type de fibres que celui utilisé dans les gilets pare-balles, qui s'avère plus résistant que ceux testés à ce jour. Ce tissu artificiel pourrait éventuellement remplacer le cartilage naturel d'une personne dont l’usure cause des douleurs articulaires.

Le cartilage est un tissu souple, parfois élastique, que l'on trouve naturellement dans le corps humain à la surface des articulations entre les os et dans la cage thoracique, l'oreille, le nez, les bronches ou les disques entre les vertèbres.

La médecine tente de créer un cartilage artificiel depuis des décennies. Mais les résultats n’étaient jamais vraiment concluants, les tissus créés étant moins solides que le vrai cartilage. En outre, ils ne contenaient pas assez d’eau, une qualité nécessaire pour le transport des éléments nutritifs aux cellules environnantes. Le matériau créé par ces ingénieurs américains de l’Université du Michigan à Ann Arbor imite la rigidité, la solidité et la teneur en eau du cartilage naturel.

Le nouveau tissu est un mélange de polymères hydrogels, composé principalement d'eau et contenant des nanoversions de fibres utilisées pour fabriquer certains gilets pare-balles. Les tests montrent que deux versions de ce tissu artificiel, l’une contenant environ 70 % d'eau et l'autre environ 92 %, gardent bien leur forme lorsque le tissu est pressé ou étiré. Ce tissu égale ou dépasse la rigidité et la solidité du cartilage biologique.

Ce tissu artificiel sera éventuellement fort utile aux personnes qui souffrent d’arthrose (dont le cartilage est endommagé) et qui ne présentent pas de dommages aux os. Elles sont plus de 30 millions aux États-Unis et près de 5 millions au Canada. Souvent, elles doivent subir des remplacements complets du genou ou de la hanche. Si les chirurgiens pouvaient simplement remplacer le cartilage usé par ce matériau, cela réduirait le risque de complications chirurgicales. En outre, ce tissu pourrait aussi être utilisé pour toutes sortes de blessures sportives, des tendons aux ligaments endommagés en passant par les problèmes au dos.

Article rédigé par Georges Simmonds pour RT Flash

Radio-Canada

|

|

|

|

|

|

|

|

|

Une étude menée sur des patients épileptiques en cours de chirurgie par des chercheurs de l’Université de Californie à Berkeley a donné aux neuroscientifiques l’opportunité inédite de suivre le mouvement d’une pensée à travers le cerveau humain, allant de la source d’inspiration jusqu’à la réponse.

Les résultats de cette étude confirment le rôle du cortex préfrontal comme étant le coordinateur des interactions complexes entre différentes régions, reliant notre perception à l’action et agissant telle une véritable « colle des capacités cognitives ».

Pour mesurer le transfert des informations d’une zone à l’autre, les précédentes études reposaient sur des processus tels que l’électroencéphalographie (EEG) ou l’imagerie par résonance magnétique fonctionnelle (IRMf). L’étude a permis d’enregistrer l’activité électrique des neurones en utilisant une technique précise appelée électrocorticographie (ECoG).

Cela a nécessité la mise en place de centaines d’électrodes minuscules directement contre le cortex, permettant de fournir plus de détails que l’EEG ainsi que d’améliorer la résolution, en comparaison à l’IRMf.

Durant l’étude, chacun des 16 patients a effectué un certain nombre de tâches variées en fonction de la disposition individuelle des électrodes, tout en faisant suivre et surveiller leur activité neuronale. Les participants devaient écouter un stimulus et répondre, ou regarder des images de visages ou d’animaux sur un écran et effectuer une action. Certaines tâches étaient plus complexes que d’autres. Par exemple, une action dite simple impliquait uniquement le fait de répéter un mot, tandis qu’une action dite plus complexe, nécessitait de penser à l’antonyme d’un mot.

Les chercheurs ont surveillé dans le cerveau l’activité électrique d’une zone (comme les zones associées à l’interprétation des stimuli auditifs), allant du cortex préfrontal jusqu’aux zones requises pour former une action, comme le cortex moteur. Bien que les résultats n’aient pas été une surprise, ils ont clairement mis en évidence le rôle du cortex préfrontal dans la réalisation de l’activité.

Lors de la réalisation de certaines tâches, sa contribution était assez limitée. Mais pour d’autres tâches, la zone travaillait dur car elle devait gérer les signaux de plusieurs parties du cerveau afin de coordonner la reconnaissance des mots et peut-être rechercher des souvenirs, avant de mettre au travail tout un tas de muscles pour fournir une réponse.

« Ces études très sélectives ont prouvé que le cortex frontal est l’orchestrateur, reliant les éléments entre eux pour fournir un résultat final. C’est la colle de la cognition », explique le neuroscientifique Robert Knight, de l’Université de Californie à Berkeley. Le cortex préfrontal est resté actif tout au long du processus de pensée, comme on peut s’y attendre d’une région multitâche du cerveau.

Plus le transfert d’une zone à l’autre est rapide et plus les gens réagissent rapidement à un stimulus. « Les études IRMf constatent souvent que, lorsqu’une tâche devient de plus en plus difficile, il y a plus d’activité dans le cerveau, et en particulier dans le cortex préfrontal », explique l’auteur principal de l’étude, Avgusta Shestyuk.

En revanche, ce qui s’est révélé être une surprise pour les chercheurs, a été le niveau de détails quant au timing très précis dans chaque région du cerveau. En effet, certains des domaines de réponse s’activaient remarquablement tôt, souvent durant le stimulus, suggérant que même avant que nous ayons une réponse complète à portée de main, notre cerveau est déjà en train de préparer les différentes parties du cortex nécessaires à l’action à venir.

Article rédigé par Georges Simmonds pour RT Flash

Trust My Science

|

|

|

|

|

|

|

|

|

Dans les cellules, les protéines emballent étroitement les longs filaments de l'ADN dans un complexe ressemblant à un collier de perles, nommé chromatine. Pour la première fois, des scientifiques de l'EPFL ont pu montrer comment la chromatine se déplace, ce qui devrait permettre de mieux comprendre comment sa structure aide à réguler l'expression des gènes.

La longueur totale de l'ADN dans une cellule est comprise entre deux et trois mètres. Pour pouvoir tenir à l'intérieur des cellules, l'ADN est enroulé autour de petits fuseaux de protéines, formant ainsi des filaments de molécules appelés nucléosomes. Les nucléosomes s'enroulent ensuite pour former des fibres entremêlées. Ce complexe est nommé chromatine, il organise et compacte l'ADN dans le noyau de la cellule, mais en même temps il rend difficile l'accès de la machinerie cellulaire à l'ADN.

Jusqu'ici, les études structurelles de la chromatine ne nous ont fourni qu'une vision statique de la manière dont l'ADN est organisé dans les cellules. Comment la machinerie de l'expression des gènes peut-elle accéder à l'ADN enfoui dans la chromatine ? Pour répondre à cette question, il faut une vision plus dynamique du matériel génétique.

Le laboratoire de Beat Fierz à l'EPFL, en collaboration avec le groupe de Claus Seider à l'Université de Düsseldorf, vient de réussir à observer les mouvements réels de la chromatine, au moyen d'une combinaison unique de protéines et de chimie de l'ADN, et de deux approches complémentaires en spectroscopie par fluorescence de cellule unique. Ce travail révèle pour la première fois la structure interne et les déplacements de la chromatine, répondant ainsi à une question non-résolue dans la recherche sur la chromatine.

Les chercheurs ont découvert que les nucléosomes, à l'intérieur des fibres de chromatine, forment des piles qui s'effondrent rapidement et se reforment en l'espace de quelques millisecondes. Ces paquets courts de nucléosomes contiennent quatre nucléosomes et environ 800 paires de bases d'ADN, formant ainsi l'unité de base de l'organisation de la chromatine. Une protéine responsable du silençage des gènes (protéine hétérochromatine 1α) peut bloquer les interactions du nucléosome et compacter encore plus la chromatine, empêchant ainsi la machinerie d'expression des gènes d'accéder à l'ADN.

La découverte de tels modes dynamiques rapides à l'intérieur des fibres de chromatine offre de nouvelles perspectives sur la manière dont divers processus peuvent accéder à l'ADN (ou être empêchés de le faire), tels que les facteurs de transcription, ou la machinerie pour la transcription, la réplication ou la réparation de l'ADN.

Article rédigé par Georges Simmonds pour RT Flash

EPFL

|

|

|

|

|

|

|

|

|

Trois inventeurs français ont mis au point un aspirateur qui vogue sur l'eau pour ramasser les détritus qui flottent dans les ports : le "Jellyfishbot", ou robot-méduse. Ce curieux engin mesure 70 cm, pèse 16 kilos et traîne derrière lui un simple filet dans lequel viennent s'amasser papiers, feuilles ou encore canettes au fur et à mesure de ses allers et venues entre les coques des bateaux.

Télécommandé à distance, le prototype sera bientôt équipé d'un laser afin de détecter "les obstacles et de collecter les déchets de manière autonome", explique l'un de ses créateurs, Nicolas Carlesi, doctorant en robotique et intelligence artificielle.

Équipé de "lingettes", le robot peut également absorber les hydrocarbures produits par les moteurs des embarcations à quai et qui brillent à la surface de l'eau. "Je suis passionné de voile, de plongée sous-marine, et j'ai toujours été frappé de voir la pollution sur le littoral méditerranéen, alors je me suis dit qu'il fallait faire quelque chose et me servir de mes connaissances", raconte le trentenaire.

En se faufilant dans les lieux exigus, le "jellyfishbot", d'une autonomie de 7 à 8 heures grâce à ses deux batteries, est plus efficace que les salabres (sortes d'épuisettes) maniées par les employés des port, et surtout plus rapide, vante M. Carlesi.

Vendu 8.000 euros, le robot intéresserait la métropole d'Aix-Marseille, avec laquelle la petite société basée à Aubagne (Bouches-du-Rhône) se dit en "discussion avancée", son co-fondateur espère équiper deux à trois ports de la Côte-d'Azur d'ici la saison estivale, et une dizaine à fin 2018.

Article rédigé par Georges Simmonds pour RT Flash

FR 3

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|