|

|

|

|

|

| NUMERO 886 |

|

|

|

|

|

|

|

Edition du 10 Février 2017

|

|

|

|

|

Edito

Pollution de l’air : comment s'attaquer aux racines du mal ?

Prenant une mesure radicale qui continue de susciter de vifs débats, la Ville de Paris a décidé, depuis le 1er juillet 2016, d’interdire la circulation dans la capitale de tous les véhicules datant d'avant 1997. En outre, depuis le 16 janvier 2017, les automobilistes parisiens doivent apposer une vignette écologique Crit'Air sur leur pare-brise s’ils veulent pouvoir circuler, sous certaines conditions, dans Paris. Progressivement, cette interdiction des véhicules va continuer à s’étendre et devrait conduire à une disparition complète des véhicules diesel de toute nature dans Paris à l’horizon 2020.

Il est vrai que la question récurrente de la pollution sur la santé a pris une dimension nouvelle depuis qu’en juin 2012 le centre de recherche sur le cancer (CIRC), basé à Lyon, a reconnu que les fumées résultant de l’utilisation des moteurs diesel étaient cancérigènes, notamment à cause des particules fines qu’elles contiennent et qui pénètrent au plus profond des alvéoles pulmonaires

Depuis cette publication du CIRC, ce débat n’a cessé de prendre de l’ampleur et la communauté scientifique estime qu’il y aurait chaque année, en France, entre 15 000 et 48 000 décès prématurés (selon les études épidémiologiques retenues), qui seraient provoqués par cette seule pollution aux particules fines. Concernant la région parisienne, une récente étude estime que la pollution de l'air serait responsable de 2 441 morts chaque année à Paris et 4 166 dans la proche banlieue.

On se doute, certes, depuis plusieurs décennies que la pollution de l’air, qu’elle provienne de l’industrie, des transports ou encore de certains modes de chauffage, doit avoir des conséquences médicales et sanitaires néfastes. Mais celles-ci ont été longtemps difficiles à évaluer car les effets de la pollution sur la santé sont diffus et s’étalent sur de très longues périodes de temps. Pourtant, plusieurs études épidémiologiques très solides ont tiré la sonnette d’alarme depuis une bonne dizaine d’années.

Dès 2005, une remarquable étude britannique conduite par le professeur Knox, de l’Université de Birmingham, montrait, en s’appuyant sur l’analyse des dossiers médicaux de 12 000 enfants décédés de cancer ou de leucémie entre 1953 et 1980, que le fait d’être exposé à une forte pollution de l’air à moins de 500 mètres d’un grand axe routier ou d’un site industriel polluant multipliait par 12 le risque pour un enfant de décéder d’un cancer. Fait aggravant, l’étude révélait également que ce risque de cancer augmentait sensiblement chez les enfants dont les mères avaient vécu pendant la grossesse à proximité d’une source de pollution de l’air.

Depuis ces travaux de référence du professeur Knox, d’autres études ont montré que la pollution de l’air a également des conséquences très néfastes en matière cardio-vasculaire. Une étude européenne publiée en décembre dernier, et portant sur 41 000 personnes vivant dans cinq pays européens, a par exemple montré que l’exposition à long terme à la pollution de l’air ambiant augmentait le risque d’hypertension. Selon ces recherches, le fait de vivre dans une zone urbaine polluée augmenterait autant les risques d’hypertension que le surpoids…

Cette étude montre notamment que l’exposition à chaque tranche supplémentaire de cinq microgrammes de particules fines augmente le risque d’hypertension artérielle d’un cinquième pour les habitants vivant dans les quartiers soumis à une forte pollution de l’air, par rapport à ceux vivant dans les zones urbaines les moins touchées par cette pollution.

Mais ce que l’on sait moins et qu’on commence à découvrir, c’est que cette pollution de l’air pourrait également avoir un impact très néfaste sur le fonctionnement de notre cerveau. Il y a quelques semaines, début janvier, une étude canadienne dirigée par le docteur Hong Chen, de l’Institut de santé publique canadien, a montré que le fait de vivre à moins de 50 mètres d’une voie de circulation importante augmenterait de 7 % le risque de développer une démence. Et à 100 m de distance, ce risque supplémentaire de démence serait encore de 4 %.

Cette vaste étude épidémiologique, qui a porté sur l’observation pendant 11 ans d’une population totale de 6 millions d’habitants, estime que 7 à 11 % des cas de démence pourraient être liés au simple fait d’habiter à moins de 50 m d’un axe routier important. Selon cette étude, l’exposition prolongée à une concentration importante de particules fines mais également de dioxyde d’azote (NO2) aurait des effets très délétères sur le cerveau en favorisant un processus inflammatoire affaiblissant notre système immunitaire.

Dans leur protocole d’analyse, ces chercheurs canadiens ont essayé de mesurer l’impact de cette pollution atmosphérique sur l’incidence de trois pathologies neurodégénératives : les démences, la sclérose en plaques et la maladie de Parkinson.

Au terme d’un gigantesque travail de recueil et d’analyse de données, ces chercheurs ont comptabilisé, de 2001 à 2012, environ 250 000 cas de démence, 9 000 cas de sclérose en plaques et 32 000 cas de maladie de Parkinson. De manière très intéressante, ces scientifiques ont constaté qu’il existait une relation très nette entre le fait d’avoir son domicile à proximité d’un grand axe routier et le risque de développer une démence. En revanche, l’étude n’a pas permis d’établir une telle relation de cause à effet en ce qui concerne le risque de maladie de Parkinson et de sclérose en plaques. Cette étude canadienne confirme et complète une autre étude publiée le 1er janvier 2017 et réalisée par des chercheurs de Harvard. Selon ces recherches, le risque de développer une maladie neurodégénérative augmente de manière proportionnelle à l’augmentation de la concentration de particules fines dans l’air.

Comme l’étude canadienne, cette étude américaine est d’autant plus solide qu’elle repose sur l’analyse d’un très grand nombre de dossiers médicaux. Les chercheurs d’Harvard ont en effet passé au crible l’évolution de la situation médicale de 9,8 millions d’américains, vivant dans une cinquantaine de métropoles américaines. Corroborant les conclusions de l’étude canadienne, le résultat de cette étude est également sans appel : pour chaque augmentation d’un microgramme par mètre cube d’air de la concentration de particules fines, le risque d’être hospitalisé dans l’année augmente de 8 % pour une démence et de 15 % pour une maladie d’Alzheimer.

Au niveau mondial, on ne s’en étonnera guère, l’exposition à une forte pollution de l’air fait également des ravages. Dans une étude publiée en mars 2014, l’OMS a évalué à 7 millions le nombre de personnes qui sont victimes chaque année d’une mort prématurée provoquée par ce type de pollution.

L'UNICEF souligne pour sa part que cette pollution de l’air, qui a augmenté de 10 % depuis 10 ans dans les zones urbaines de la planète, provoquerait de décès d’au moins 600 000 enfants de moins de cinq ans chaque année.

S'agissant de la France, la situation est tout aussi préoccupante : en juin 2016, une étude de Santé Publique en France a en effet évalué à 48 000 morts prématurées les effets de la pollution de l’air due aux particules fines. L'étude précise que 34 000 décès seraient évitables. Selon ce rapport, le coût sanitaire et humain de la pollution de l’air se situerait au troisième rang, derrière celui du tabac (78 000 morts) et de l’alcool (49 000 morts) et cette pollution représenterait une perte d’espérance de vie pour une personne âgée de 30 ans pouvant dépasser les deux ans.

Mais la pollution de l'air n'est pas seulement un drame humain et un fléau sanitaire, elle est également une charge financière tout à fait considérable pour notre pays, comme l'a bien montré un remarquable rapport publié par le Sénat en juillet 2015. Intitulé « Pollution de l’air, le coût de l’inaction », ce rapport estime que la pollution de l’air en France coûte chaque année 101,3 milliards d’euros. Deux fois plus que le tabac (47 milliards d’euros).

La commission d’enquête sénatoriale, présidée par le sénateur de Meurthe-et-Moselle Jean-François Husson, a réalisé pour la première fois un travail très complet visant à estimer la charge financière globale de la mauvaise qualité de l’air. L’évaluation inédite intègre non seulement les dommages sanitaires de la pollution, mais également ses conséquences sur les bâtiments, les écosystèmes et l’agriculture. Comme le souligne Jean-François Husson, « La pollution n’est pas qu’une aberration sanitaire, c’est aussi une aberration économique ».

Il est vrai que depuis 30 ans, selon une étude de l’INSEE publiée en avril 2013, la pollution globale de l’air n’a pratiquement pas régressé, du fait notamment de l’augmentation de la population du parc automobile et des déplacements individuels. Entre 1980 et 2015, le parc automobile français est passé de 21 à 32 millions de véhicules, soit une augmentation de 55 %. Et même si depuis quatre ans la part des véhicules diesel vendue chaque année est passée de de 66 à 38 %, il faudra, en l’absence de mesures politiques fortes, au moins 20 ans à notre parc automobile pour éliminer totalement l’ensemble des véhicules diesel.

Mais ce défi humain et économique majeur que représente la pollution de l’air est d’autant plus difficile à relever que, contrairement à bien des idées reçues, le secteur des transports n’est pas le plus polluant, notamment en matière d’émissions de particules fines qui sont les plus néfastes pour la santé. Selon plusieurs études, dont celle réalisée par le Centre Interprofessionnel Technique d’Etudes de la Pollution Atmosphérique (Citepa), le secteur des transports ne serait responsable que de 15 % à 20 % des émissions de particules fines en France. Le secteur agricole émettrait pour sa part environ 20 % des particules fines. Enfin, le secteur industriel et le chauffage des bâtiments, seraient respectivement émetteurs de 30 % des particules fines présentes dans l’air.

La polarisation très médiatisée concernant la pollution liée aux transports serait donc l’arbre qui cache la forêt des autres sources de pollution qui, bien que très importantes, restent largement sous-estimées ou même ignorées du grand public et des medias. On sait par exemple à présent que dans certaines régions de montagne, l’engouement tout à fait louable pour le chauffage au bois, réputé naturel et écologique, est en fait responsable d’une pollution importante et néfaste par les particules fines, pollution qui peut parfois dépasser dans certains secteurs celle liée au transport routier.

Cette situation s’explique assez simplement par le fait que seuls les poêles et chaudières à bois récents sont parfois équipés de filtres à particules et que ces derniers restent onéreux et doivent être régulièrement nettoyés pour conserver leur efficacité.

Si nous voulons réduire de manière massive et durable la pollution de l’air dans un délai raisonnable, c’est-à-dire moins d’une dizaine d’années, nous devons accepter de considérer ce problème dans toute son ampleur, sa diversité et sa complexité. Nous devons notamment mettre en place une fiscalité environnementale globale et intelligente qui favorise la transition vers les énergies renouvelables mais intègre également la variable constituée par le niveau final réel de pollution et l’impact sur la santé humaine.

Mais cela ne suffira pas et il faut également que nous sachions mobiliser des ressources financières et humaines beaucoup plus importantes pour accroître notre effort de recherche fondamentale dans les domaines stratégiques de la production et du stockage propres de l’énergie. Les États-Unis et le Japon ont bien compris cette nécessité et travaillent sur des programmes de recherche à long terme, visant notamment à mettre au point des piles à combustible domestiques et des panneaux solaires hybrides assurant une production conjointe entièrement propre d’électricité et de chaleur.

Notre pays doit suivre cette voie car seul cet effort de recherche et d’innovation sur le long terme nous permettra à la fois de disposer d’un nouveau et puissant moteur d’emploi et de compétitivité économique et d’améliorer de manière décisive notre qualité de vie en réduisant massivement et de manière irréversible les effets dévastateurs de la pollution de l’air.

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

Des chercheurs américains de l'Université d'Harvard et de l'Hôpital de Boston ont conçu un ingénieux "robot souple", qui entoure le cœur fatigué pour l’aider à battre. Ce dispositif a été testé avec succès chez le porc et pourrait, d’ici plusieurs années, représenter une véritable alternative à la greffe cardiaque.

La principale originalité de ce nouveau système d’assistance ventriculaire est avant tout de ne pas être en contact direct avec le sang. Un net avantage sur les dispositifs existants car cela réduit la formation de caillots. Résultat : la prise d’anticoagulants par le patient ne serait plus nécessaire.

Les chercheurs se sont inspirés de l’anatomie cardiaque et ont réussi à fabriquer un manchon en silicone qui utilise de fausses fibres musculaires en polyuréthane activées par une pompe à air pour permettre les contractions pulsées de l’organe. En tournant et en se comprimant autour du cœur via le manchon, les faux muscles permettent finalement au cœur fatigué de se contracter et donc d’assurer sa fonction de pompe, redistribuant le sang oxygéné vers l’organisme.

Le manchon est, lui, fixé au cœur via des sutures et une interface de gel pour aider à une meilleure friction entre le dispositif et le cœur. Autre particularité, il peut se personnaliser selon la zone de faiblesse présentée par le cœur, soit au niveau du ventricule gauche, soit du droit. Les tests chez l’animal ont été concluants et déjà des brevets ont été déposés.

"Cette recherche démontre l’intérêt de la robotique souple pour potentiellement réduire le fardeau des maladies cardiaques et améliorer la qualité de vie des patients", a déclaré Ellen T. Roche, premier auteur de l'article. Ce travail ouvre en effet de nouvelles options de traitement pour les personnes souffrant d'insuffisance cardiaque. En France, un million de personnes sont concernées par cette affection.

Article rédigé par Georges Simmonds pour RT Flash

Harvard

|

|

|

|

|

|

|

|

|

Des chercheurs de l’EPFL (Lausanne-Suisse) ont mis au point une technique qui permet d'inscrire des motifs de taille nanométrique à la surface et à l’intérieur de fibres en polymères. Ces fibres inédites pourraient être prometteuses pour guider la régénération de nerfs, produire des effets optiques, ou créer le tissu artificiel et les pansements intelligents de demain.

Pour réaliser leurs dessins nanométriques, les scientifiques sont partis d’une technique existante, utilisée dans le domaine des fibres optiques : le fibrage à chaud (thermal drawing). Traditionnellement, on grave ou imprime des dessins de taille millimétrique sur une "préforme", soit une version macroscopique de la fibre désirée. La préforme est chauffée afin qu’elle change de viscosité, puis étirée comme du plastique fondu pour former une fibre mince, qui durcit à nouveau.

Avec l’étirement, la taille des motifs rétrécit, mais leurs proportions et leur positionnement restent intacts. La méthode classique pose toutefois problème. Il est impossible de préserver les dessins au-dessous du micromètre. « Lorsque l’on étire la fibre, la tension de surface du polymère structuré induit une déformation puis une disparition des motifs en dessous d’une certaine taille, de l’ordre de quelques microns », explique Fabien Sorin.

Pour surmonter cet obstacle, les chercheurs de l’EPFL ont eu l’idée de placer la préforme gravée dans une construction en sandwich, avec un polymère sacrificiel. Ce dernier protège les motifs lors de l’étirement en atténuant la tension de surface. Il peut être "jeté" une fois l’étirement terminé. Grâce à cette astuce, il a été possible de doter différentes fibres de minuscules motifs très complexes. « Nous avons produit des motifs de 300 nanomètres, mais nous pourrions aisément descendre jusqu’à quelques dizaines de nanomètres », affirme le chercheur.

C’est la première fois que des motifs si petits et si complexes peuvent être inscrits sur une fibre souple à très grande échelle. « La technique permet d’obtenir des motifs plus petits de deux ordres de grandeur que ce qui existe dans la littérature », indique Fabien Sorin. « Nous pourrions par ailleurs l’appliquer sur des kilomètres de fibres, avec des coûts tout à fait raisonnables ».

Afin de montrer les possibilités d'application de leur technique, les scientifiques, en collaboration avec la Chaire Fondation Bertarelli de technologie neuroprosthétique, dirigée par Stéphanie Lacour, ont utilisé leurs fibres pour guider in vitro de manière ordonnée des neurites issues d’un ganglion spinal (ganglion situé sur le nerf rachidien). Un pas encourageant pour l’utilisation de telles fibres pour la régénération de nerfs ou la fabrication de tissu artificiel.

Article rédigé par Georges Simmonds pour RT Flash

EPFL

|

|

|

|

|

|

|

|

|

Une équipe de recherche du célèbre MIT américain travaille sur un projet de recherche baptisé "fabrication additive vivante" qui consiste à modifier un objet imprimé en 3D en l'illuminant.

Cette approche repose sur l'ajout au matériau de nouveaux polymères mis au point par les chercheurs. Lorsque ces polymères sont éclairés par des LED bleues, ils modifient la composition chimique et les propriétés mécaniques du matériau. Ils peuvent aussi être utilisés pour fusionner plusieurs pièces imprimées en 3D. "L’idée est d’imprimer un objet pour pouvoir ensuite le transformer ou l’étendre grâce à la lumière", résume Jeremiah Johnson, professeur de chimie au MIT et auteur de l’article sur ce projet publié dans la revue ACS Central Science.

Les chercheurs du MIT avaient élaboré une première version de cette technique en 2013. Après impression, ils utilisaient les rayons UV pour briser certains polymères, créant des molécules très réactives appelées radicaux libres. Un procédé qui permettait de transformer la pièce à l’infini, mais qui endommageait le matériau et était incontrôlable car les molécules étaient trop réactives.

Les polymères qu’ils ont récemment élaborés réagissent aussi à la lumière, mais d’une manière légèrement différente. Chaque polymère contient des composés chimiques qui se comportent comme des accordéons. Ces composés chimiques, baptisés TTC, s’activent à la lumière. Lorsqu'une LED bleue éclaire le polymère, de nouveaux monomères se créent. Résultat : le matériau s’étend.

Les chercheurs peuvent aussi incorporer des monomères qui modifient les propriétés mécaniques d'un matériau, comme la raideur, et ses propriétés chimiques, comme l'hydrophobie (la non-solubilité dans l’eau). Cette technologie est prometteuse car elle permettrait de concevoir des objets encore plus complexes grâce à l’impression 3D. Mais elle n’est pas sans contrainte. Les polymères nécessitent un environnement sans oxygène pour pouvoir être activés. Les chimistes du MIT cherchent donc d’autres catalyseurs qui pourraient être utilisés en présence d’oxygène.

Article rédigé par Georges Simmonds pour RT Flash

ACS

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Selon la dernière étude de Négawat, association qui vise à promouvoir la consommation des énergies renouvelables, les opérations d’efficacité énergétique et de sobriété vont permettre de diminuer la consommation d’énergie de 63 % d'ici 2050. Ce rapport estime que la France peut être entièrement alimentée à partir d’énergies renouvelables en 2050.

D’une part, "le fonctionnement des 58 réacteurs nucléaires actuels n’étant pas prolongé au-delà de la quatrième visite décennale (environ 40 ans), le dernier d’entre eux est arrêté en 2035", écrivent les auteurs qui ont décidé de ne pas prendre en compte l’EPR en construction à Flamanville qui devra démarrer en 2018.

D’autre part, "le charbon, puis le pétrole et enfin le gaz fossile, auxquels se substitue peu à peu le gaz d’origine renouvelable, sont progressivement ramenés à des niveaux marginaux, qui ne correspondent plus qu’à des usages (non énergétique)", juge le rapport. Ainsi, les énergies renouvelables assurent à cet horizon un approvisionnement qui frise les 1 000 TWh fournis à 50 % par la biomasse solide et l’éolien et à 30 % par le solaire et le biogaz. "Combiné à la réduction de la demande, cet accroissement est suffisant pour contrebalancer la fin programmée des énergies fossiles et du nucléaire", ajoutent les auteurs.

L’association Négawatt estime que cette transition s’effectue sans hausse des émissions de CO2 du pays et s’accompagne d’un gain économique. L’investissement de cette transition s’élèverait à 1160 milliards d’euros mais générerait un solde positif de 700 milliards d’euros par rapport au scénario tendanciel en 2050. Par ailleurs, Négawatt attend la création nette de 380 000 emplois par cette transition énergétique.

Article rédigé par Georges Simmonds pour RT Flash

Usine Nouvelle

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

D’après une étude réalisée par l'Université américaine de l'Oregon, le niveau de la mer pourrait augmenter de 6 à 9 mètres dans le futur. Pour arriver à cette conclusion, l’équipe de chercheurs a réalisé 104 enregistrements des températures de la mer à la surface (SST) à partir de 83 carottes de sédiments analysées. Ces dernières contenaient différents éléments chimiques liées à la température de l’eau, comme par exemple le rapport entre le magnésium et le calcium présents dans les coquilles des foraminifères, un type de plancton. Grâce à ces analyses, ils ont découvert que notre planète avait atteint un pic de température pendant les ères glaciaires, il y a 129 000-116 000 ans.

Ensuite, en comparant les résultats avec la base de données d’un centre d’études anglais concernant les SST enregistrées dans les périodes 1870-1889 et 1995-2014, les scientifiques ont pu constater plusieurs faits intéressants. Premièrement, si l’on compare les SST de ces deux périodes, on observe qu’il y a eu une hausse de 0,5°C des températures des océans. Jeremy Hoffman, l’auteur de l’étude, souligne : « Un demi-degré ça ne semble pas beaucoup, mais, en termes de température globale des océans, c’est un aspect assez significatif ».

Encore plus surprenant, en comparant la période la plus récente et celle d’il y a 125 000 ans, on s’aperçoit qu’il n’y a presque aucune différence dans les SST des deux (0.1±0.3°C de différence). Bref, les deux températures sont presque identiques, mais avec une différence considérable au niveau de la mer : les océans de l’époque étaient plus répandus que ceux d’aujourd’hui, avec un niveau de la mer de 6 à 9 mètres de plus.

Par conséquent, cette découverte nous offre une prévision de ce qui pourrait survenir dans les prochaines décennies. Ce qui est important, selon les scientifiques, c’est de calculer combien de temps il nous reste pour pouvoir faire face à cette problématique environnementale. Mais cela ne sera pas facile, car les deux contextes climatiques restent très différents : à l’époque, la Terre avait une inclinaison et une orbite qui exposaient son pôle septentrional à un ensoleillement majeur, alors que dans le contexte actuel, les gaz à effet de serre recouvrent notre atmosphère.

Article rédigé par Georges Simmonds pour RT Flash

Science

|

|

|

|

|

|

|

|

|

La consommation de viande a un impact majeur sur l'utilisation des terres agricoles et le climat : selon les calculs de AsapSCIENCE, 25 milliards de poulets, 1,5 milliard de vaches et un milliard de moutons et de cochons fouleraient ainsi le sol terrien. Cette prolifération d’animaux, qui n’ont d’autre destin que celui d’être mangé, entraîne diverses conséquences négatives pour notre planète et constitue la principale cause du réchauffement climatique.

Sans l'élevage intensif d'animaux, les terres qu’ils foulent - approximativement de la taille du continent africain - seraient utilisées pour planter des cultures de légumes, de fruits ou de céréales. Par ailleurs, la vie végétale pourrait reprendre le dessus, ce qui permettrait de freiner les effets du réchauffement climatique. Les animaux et l'agriculture liée à leur alimentation (soja, notamment) sont en effet à l’origine de 15 % des émissions de gaz à effet de serre, soit plus que la totalité des émissions de CO2 liées aux transports (voitures, avions, etc...).

Le retour d’arbres ou de végétaux sur ces terrains permettrait d’absorber davantage de CO2. Autre avantage, l’absence de bêtes d’élevage réduirait énormément la consommation d’eau dans le monde entier. Actuellement, l’utilisation d’eau douce est consacrée à 70 % pour l’agriculture. Cela concerne évidemment les cultures de végétaux mais surtout l’élevage,70 % de la surface agricole mondiale utilisée pour le bétail.

En élevage industriel, la production d’un kilogramme de bœuf absorbe par exemple 13.500 litres d’eau. C’est bien plus élevé que la consommation nécessaire à la culture de céréales telles que le riz (1.400 litres) ou le blé (1.200). En 2002, un tiers des céréales produites et récoltées dans le monde avait directement servi à nourrir le bétail. Cela représentait au niveau mondial 670 millions de tonnes, soit assez pour nourrir trois milliards d’êtres humains. Une étude parue en 2013 note que l’« empreinte eau » des Européens liée à leur alimentation pourrait baisser de 23 % à 38 % en diminuant ou supprimant la part de la viande dans les repas.

Gourmande en eau et en céréales, la production de viande l’est aussi en terres. La FAO estime que 70 % de la surface agricole mondiale est utilisée soit pour le pâturage du bétail, soit pour la production de céréales destinées à les nourrir. Le manque de terres agricoles pousse aussi à la déforestation : 91 % des terres « récupérées » dans la forêt amazonienne servent ainsi aux pâturages ou à la production de soja qui nourrira plus tard le bétail. Et moins de forêts, c’est moins d’émissions de dioxyde de carbone absorbées.

Article rédigé par Georges Simmonds pour RT Flash

Youtube

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Les résultats d'un essai clinique britannique de traitement combiné contre le cancer du pancréas, marque peut-être une rupture thérapeutique dans le traitement du cancer du pancréas.

Ces résultats montrent que 29 % des patients qui se sont vu administrer une combinaison de deux médicaments de chimiothérapie (la gemcitabine et la capécitabine) vivent encore au moins cinq ans. Le pourcentage est de 16 % pour ceux qui reçoivent seulement le médicament de chimio (la gemcitabine) du traitement standard du National Health Service (NHS), le système de santé publique du Royaume-Uni.

L'écart entre les deux pourcentages est important, car il pourrait conduire à une amélioration des perspectives pour les personnes atteintes du cancer du pancréas, un des plus redoutables. « Nous espérons que cela pourrait mener à une véritable étape de changement dans le traitement de ce lourd cancer, offrant une chance à plus de patients qui ont subi une chirurgie de vivre plus longtemps et sans effets secondaires », commente Leanne Reynolds, responsable de la recherche au Pancreatic Cancer UK .

Pour les chercheurs, cette nouvelle formule de traitement pourrait jusqu'à doubler le nombre de patients qui vivent encore cinq ans après le diagnostic de la maladie. Malheureusement, cette avancée ne pourrait bénéficier qu'aux patients qui ont eu une chirurgie, et dans la majeure partie des cas, elle n'est pas prodiguée, car le cancer est trop avancé. Le cancer du pancréas est effectivement l'un des plus difficiles à traiter et présente des chances de survie parmi les plus faibles.

Article rédigé par Georges Simmonds pour RT Flash

The Guardian

|

|

|

|

|

|

|

|

|

Un rapport du Centre Britannique du Cancer prédit une baisse de 15 % du taux de mortalité liée au cancer au cours des deux prochaines décennies, ce qui se traduirait par environ 400 000 décès en moins. En 2014, pour 100 000 habitants, le Royaume-Uni a dénombré 331 morts par cancer mais ce chiffre devrait ainsi descendre à 280 d’ici 2034.

Le Docteur Harpal Kumar, Directeur du Cancer Research UK, a déclaré que 75 % des personnes diagnostiquées en 2034 devraient survivre à leur cancer pendant au moins 10 ans. Pour atteindre ce chiffre, les progrès dans la détection, le diagnostic et les traitements devront se poursuivre pour les cancers du sein, du côlon et les leucémies. Et l’accent devra être mis, en termes de recherche, sur les cancers actuellement difficiles à traiter comme les cancers du pancréas, du poumon, de l’œsophage et les tumeurs cérébrales.

Néanmoins, le Cancer Research UK a averti que les taux de survie resteront certainement très faibles en cas de tumeurs du cerveau ou de cancer du pancréas, à moins que les investissements dans la recherche augmentent. Les décès par cancer du cerveau devraient donc rester stables au cours des 20 prochaines années avec un taux de survie à 5 ans de 20 % ; de même en cas de cancer du pancréas, avec un taux de survie à 5 ans de 3 %.

Ces prévisions optimistes sont à mettre en relation avec la baisse continue de la mortalité réelle par cancer dans tous les pays développés : aux Etats-Unis, une étude récente montre par exemple que la mortalité par cancer (ramenée à la population) a chuté de 25 % depuis un pic en 1991. Ce recul résulte surtout d'une diminution constante du tabagisme combinée aux avancées médicales dans la détection précoce des tumeurs et leurs traitements.

Cette baisse équivaut à une réduction de 2,1 millions de décès entre 1991 et 2014, précise ce rapport annuel de l'American Cancer Society (ACS). Ce document a été publié récemment dans la revue médicale CA (Journal for Clinicians). La fréquence du cancer au cours des dix dernières années est restée stable parmi les femmes et a diminué de près de 2 % par an parmi les hommes. Le taux de mortalité de cette pathologie a baissé d'environ 1,5 % annuellement chez les deux sexes.

Article rédigé par Georges Simmonds pour RT Flash

Cancer Research

|

|

|

|

|

|

|

|

|

Une équipe de chercheurs de la Vrije Universiteit Brussel (VUB) a réussi à utiliser des cellules tumorales comme un « vaccin » contre cette même tumeur. Ces travaux se sont concentrés sur les cellules dendritiques, qui font partie du système immunitaire et permettent de déclencher les réponses immunitaires appropriées à un danger contre l’organisme. Les scientifiques pensaient jusqu’ici que ces cellules, chez les patients cancéreux, étaient inhibées, de sorte que le système immunitaire – qui combat les maladies dans des circonstances normales – reste bloqué.

L’équipe, menée par Professeur Van Ginderachter, a découvert deux nouveaux types de cellules dendritiques, qui activent quand même le système immunitaire chez des patients atteints d’une tumeur. Cela ouvre les portes à un nouveau traitement contre le cancer, dans lequel les cellules sont extraites de tumeurs chirurgicalement retirées, puis sont utilisées pour « vacciner » le patient. Le système immunitaire du patient est ainsi activé, ce qui freine le développement d’une tumeur ou son apparition.

Cette nouvelle immunothérapie doit encore être testée au-delà de l’étude qui a été menée. « La prochaine étape sera de voir si les vaccins marchent aussi chez d’autres patients, en dehors de l’étude. Nous pourrons ainsi découvrir si nous pouvons réduire les tumeurs existantes et empêcher l’apparition de nouvelles tumeurs », conclut Professeur Van Ginderachter.

Ces recherches confirment que si l'on sélectionne ces bonnes cellules dendritiques à partir de tumeurs de souris et si on les administre - comme un vaccin - à des souris, on arrive à induire des réponses immunitaires plus fortes. L'intérêt principal est que ces cellules dendritiques provenant de la tumeur portent les antigènes de cette tumeur. Les antigènes sont très différents d'une tumeur à l'autre, ce qui complique les approches de vaccination. Le vaccin permet donc de cibler précisément les antigènes qu'il faut cibler.

Article rédigé par Georges Simmonds pour RT Flash

La Libre

|

|

|

|

|

|

|

|

|

Le déclenchement de l'autisme pourrait-il être lié avec un déséquilibre du microbiote intestinal ? C’est en tout cas l'hypothèse surprenante qu'avance une équipe de l’Université d’État de l’Arizona qui travaille sur une approche novatrice en se concentrant sur l’amélioration du microbiome de l’intestin par transplantation ou greffe de microbiote fécal.

Le microbiote intestinal, ou flore intestinale, est l’ensemble des micro-organismes qui se trouvent dans le tube digestif. Le microbiome étant "l’aire de vie" de ces bactéries. Le microbiote est doté de gènes et d’un métabolisme propre, dont il est nécessaire de comprendre les rôles.

Son rôle principal est métabolique : il dégrade les substrats non digérés par l’intestin grêle. La dégradation de ces composés (glucides et protéines contenus dans les fibres alimentaires) génère la production de nombreux métabolites. De multiples travaux scientifiques ont montré l’importance du microbiote sur le développement et la maturation de notre système immunitaire. Il constitue une barrière naturelle aux bactéries diverses qui nous entourent.

D’autres études ont déjà montré que le microbiote intestinal influence aussi notre système nerveux central. De nombreux neurotransmetteurs, agissant sur notre humeur, sont produits par les bactéries de notre tube digestif et sont des pistes de recherche pour expliquer l’action du microbiote intestinal sur notre cerveau. Les bénéfices de la transplantation du microbiote fécal qui consiste en l’introduction, souvent par coloscopie ou lavement, des selles d’un donneur sain dans le tube digestif d’un receveur ont déjà été documentés par plusieurs études.

La pratique est déjà courante dans certains pays, et ce traitement permet la récupération complète de la fonction intestinale chez 90 % des patients. Le recours principal à cette greffe de microbiote intervient plus fréquemment en cas d’infection résistante à C. difficile.

Cependant, une étude récente a montré que des combinaisons spécifiques de bactéries intestinales peuvent produire des substances qui peuvent à leur tour affecter la myéline et provoquer des comportements d’évitement sociaux. Par ailleurs, de précédentes études de la même équipe avaient déjà montré des liens entre les symptômes de l’autisme et la composition et la diversité des microbes intestinaux du patient.

Les chercheurs de Arizona State University, de la Northern Arizona University, l’Ohio State University et de l’Université du Minnesota ont mené cette étude sur 18 participants atteints de troubles du spectre autistique, âgés de 7 à 16 ans. Les participants ont suivi un programme de traitement de 10 semaines comprenant des antibiotiques, un lavement intestinal et de greffes de microbiote fécal durant 8 semaines.

Ce programme montre des bénéfices à long terme, dont : une amélioration moyenne de 80 % des symptômes gastro-intestinaux associés aux troubles du spectre autistique, une amélioration de 20 à 25 % des comportements autistiques et enfin une amélioration des compétences sociales et des habitudes de sommeil.

Article rédigé par Georges Simmonds pour RT Flash

Eurekalert

|

|

|

|

|

|

|

|

|

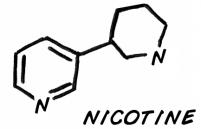

On sait que les patients schizophrènes sont souvent fumeurs pour compenser les déficits dus à leur maladie ou pour les soulager des lourds effets secondaires de leur traitement (léthargie, perte de motivation,…). Le cortex préfrontal (région associée à la cognition : la prise de décision et la mémoire de travail) est une des zones altérées chez les patients présentant des troubles psychiatriques comme la schizophrénie, qui peuvent s’accompagner d’un tabagisme intensif. Dans une situation non pathologique, l’activité du cortex préfrontal est modulée par des neurotransmetteurs (l’acétylcholine) via les récepteurs nicotiniques situés à la surface des cellules nerveuses.

Récemment, la mutation génétique CHRNA5, codant pour une sous-unité du récepteur nicotinique, a été identifiée comme étant associée aux troubles cognitifs des schizophrènes et à la dépendance au tabac. Dans cette étude, les chercheurs de l’unité de Neurobiologie intégrative des systèmes cholinergiques (Institut Pasteur /CNRS), dirigée par Uwe Maskos, ont introduit le gène humain CHRNA5 chez la souris afin de reproduire les déficits cérébraux caractéristiques de la schizophrénie, à savoir les troubles comportementaux lors des interactions sociales et des tâches sensorimotrices.

Grâce à une technique d’imagerie in vivo, ces chercheurs ont pu constater une activité diminuée des cellules du cortex préfrontal chez les individus portant la mutation CHRNA5. Ils sont parvenus à identifier précisément le type de neurones dont l’activité était affectée par la mutation génétique.

« Les travaux portant sur ce modèle de la maladie montrent également que lorsque nous administrons de la nicotine, celle-ci se fixe sur les récepteurs nicotiniques des interneurones, et influence l’activité des cellules pyramidales du cortex préfrontal qui retrouvent un état d’excitation normal » explique Fani Koukouli, première auteure de l’étude.

« L’administration répétée de nicotine rétablissant une activité normale du cortex préfrontal laisse présager une possible cible thérapeutique pour le traitement de la schizophrénie » déclare Uwe Maskos, principal auteur de l’étude. La molécule thérapeutique devra alors présenter la même forme que la nicotine sans en avoir les effets nocifs (dépendance, vieillissement cellulaire, accélération de l’activité cardio-vasculaire…).

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

|

|

|

|

|

|

|

Des recherches menées par l'INSERM, sur une cohorte de 883 enfants, montrent que les comportements impliqués dans la balance énergétique et connus pour influencer le risque d’obésité interviennent très tôt dans la vie de l'enfant : ainsi, plus les garçons passent de temps devant des écrans à 2 ans, plus ils ont un pourcentage de masse grasse corporelle élevé à 5 ans. Chez les filles, ce sont celles qui passent le moins de temps à jouer en plein air à 2 ans qui présentent un risque accru de développement de la masse grasse. Pour limiter le risque d’obésité, il apparaît donc essentiel de prévenir au maximum l'installation de ces comportements dès cet âge, d’autant plus qu’ils tendent à se maintenir de la petite enfance à l’enfance, puis de l’enfance à l’âge adulte.

Ces résultats sont les premiers du genre, explique Sandrine Lioret, qui a co-encadré ce travail avec Patricia Dargent-Molina : "Différentes études ont été réalisées chez des enfants d’âge scolaire. Elles avaient déjà démontré que la sédentarité (mesurée à partir du temps passé devant les écrans), une moindre activité physique et la consommation d’aliments de forte densité énergétique étaient liées au surpoids. Mais on manquait de données prospectives chez les enfants de moins de 3 ans".

Démarrée en 2003, cette étude a suivi des couples mère-enfant à Poitiers et Nancy, dès le début de la grossesse jusqu'aux 10 ans de l'enfant. "Les parents ont répondu à plusieurs questionnaires au cours du suivi. Ils ont aussi été questionnés sur la fréquence de consommation d'une trentaine de groupes d'aliments couvrant l’ensemble de l’alimentation. L’ensemble de ces données ont ensuite été analysées et rapportées aux données anthropométriques à 5 ans : le pourcentage de masse grasse (mesurée par impédancemétrie) et l'indice de masse corporelle (IMC).

On a tendance à croire que les jeunes enfants sont spontanément et suffisamment actifs, mais la littérature révèle qu’ils consacrent l’essentiel de leur temps à des activités sédentaires et qu’il existe une grande variabilité interindividuelle pour l’activité physique. Ces résultats suggèrent l’importance de promouvoir et d’encourager les jeux en plein air dès le plus jeune âge et de limiter l’exposition aux écrans.

Article rédigé par Georges Simmonds pour RT Flash

INSERM

|

|

|

|

|

|

|

|

|

Des chercheurs de la prestigieuse école de Médecine de Yale (USA) ont montré qu'en stimulant une zone spécifique du cerveau, il était possible de contraindre des souris à adopter des comportements de prédation face à des objets inertes et totalement inadaptés à les nourrir.

Ce brusque changement de comportement est provoqué par une lumière envoyée vers une zone très précise de leur cerveau. Des chercheurs de la Yale University, qui publient leurs travaux dans la revue Cell, affirment avoir identifié un circuit de neurones qui coordonne, chez la souris, le comportement de prédation.

Les chercheurs ont utilisé l'optogénétique. Cette technique a révolutionné les neurosciences dans la première moitié des années 2000, permettant par exemple d'effacer puis ranimer des souvenirs chez des rats, ou encore créer de faux souvenirs chez des souris.

On manipule le génome d'un animal pour que ses cellules neuronales soient "forcées" de s'activer lorsqu'elles sont soumises à une lumière émise par une fibre optique implantée directement dans le cerveau de l'animal. On peut ainsi commander l'activation des neurones de façon très précise, et réversible (contrairement aux manipulations génétiques qui "désactivent" définitivement un ou des gènes donnés).

L'équipe dirigée par Ivan de Araujo, professeur associé de psychiatrie à l'école de médecine de Yale (Connecticut) et spécialiste de la neurobiologie de l'alimentation, a ainsi "fabriqué" des souris pour pouvoir manipuler leur comportement agressif. Laser éteint, les souris agissaient normalement, sans réagir si elles croisaient un bout de bois ou un morceau de plastique.

Mais que les scientifiques allument la lumière... et les rongeurs "sautaient sur l'objet, le tenant entre leurs pattes et le mordant comme s'ils essayaient de le capturer et de le tuer", raconte le chercheur. Les auteurs obtenaient les mêmes résultats en stimulant les neurones chimiquement plutôt qu'avec de la lumière.

Article rédigé par Georges Simmonds pour RT Flash

Cell

|

|

|

|

|

|

|

|

|

On sait que plus de la moitié des enfants autistes présentent un profil moteur altéré, sans que cela ne soit pour autant retenu dans l’évaluation diagnostique de l’enfant.

Une étude réalisée par des chercheurs du CNRS et de l'Inserm de Grenoble a tenté d’évaluer les capacités motrices d’enfants autistes à l’aide de la batterie d’évaluation des mouvements chez l’enfant (M-ABC), en les comparant à des enfants témoins, contrairement à la majorité des études antérieures se cantonnant à une comparaison avec des sujets avec troubles de l’apprentissage, de la coordination ou des retards de développement.

Vingt-deux garçons âgés de 9 à 11ans ont participé à l’étude : 11 enfants autistes sans déficience intellectuelle, scolarisés en milieu ordinaire et avec un niveau modéré d’activité physique hebdomadaire et 11 enfants témoins. L’évaluation s’est faite par l’intermédiaire des tests moteurs du M-ABC, réalisés dans des conditions similaires. Celui-ci permet d’aborder chacune des 3 dimensions suivantes : maîtrise de balles (réception et lancé), dextérité manuelle (tracé de précision et manipulation d’objets de différentes tailles), équilibre (appui unipodal au sol ou bipodal sur une poutre, marche de précision, saut ou marche en double tâche).

A l’analyse, des différences significatives sont retrouvées entre les enfants autistes et témoins pour les 3 items, et plus spécifiquement sur les tests où il faut « viser » et « marcher/sauter ». De fait, « viser » nécessite un traitement simultané des informations visuelles et proprioceptives : le contrôle du placement des bras et de l’ensemble du corps doit se faire en intégrant le contrôle visuel de la trajectoire, ce qui crée un conflit entre les entrées sensorielles et une incoordination visuo-manuelle pour l’enfant autiste.

Par ailleurs, au niveau de la dimension « équilibre » interviennent deux modes distincts : pour l’équilibre statique - ne requérant aucune coordination spécifique, aucune différence n’émerge. A la différence du test d’équilibre dynamique, à savoir marcher/sauter, où la mauvaise exploitation des feedbacks visuels ainsi que le déficit de coordination générale pénalisent l’enfant autiste.

Ainsi, d’après cette étude, les différences motrices entre enfants autistes et enfants témoins touchent préférentiellement les activités faisant intervenir la vision et la coordination. La motricité globale de l’enfant autiste semble être altérée par un conflit visuo-moteur, sans sous-estimer que d’autres voies de contrôle pourraient également entrer en jeu.

Article rédigé par Georges Simmonds pour RT Flash

Science Direct

|

|

|

|

|

|

|

|

|

Des chercheurs de la la Columbia University (New York) ont montré que la désorientation spatiale observée dès les premiers stades de la maladie d’Alzheimer serait due à l’accumulation de protéine tau dans les neurones excitateurs (et non inhibiteurs) du cortex entorhinal, entraînant leur perte et une sous-activité du GPS du cerveau. Cette découverte chez la souris pourrait aider à perfectionner les tests cognitifs pour détecter le plus tôt possible la maladie d’Alzheimer et développer de nouvelles approches thérapeutiques.

« Notre étude montre que la pathologie tau s’accumule uniquement dans les neurones excitateurs du cortex entorhinal (et épargne les neurones inhibiteurs), affectant ainsi les cellules de grilles, des neurones importants pour la mémoire spatiale », explique au "Quotidien" le Professeur Abid Hussaini, qui a codirigé avec le Docteur Karen Duff (Columbia University à New York) l’étude publiée dans la revue "Neuron".

« Cette étude est la première à montrer un lien entre les cellules de grilles (“grid cells”) et la maladie d’Alzheimer », s’enthousiasme le neuroscientifique norvégien Edvard Moser. En 2005, les époux Edvard et May-Britt Moser découvraient les cellules de grilles, la seconde composante du système de géoposition (GPS) du cerveau, plus de 30 ans après la découverte des "cellules de lieu" par l’Anglo-Américain John O’Keefe. En 2014, les trois neurochercheurs ont été récompensés par le prix Nobel de médecine pour leurs travaux sur le GPS du cerveau.

Environ 3 personnes sur 5 atteintes de la maladie d’Alzheimer développent des difficultés à s’orienter dans l’espace, d’abord dans les lieux nouveaux puis les lieux familiers, et s’égarent. Cette désorientation spatiale est souvent l’un des premiers symptômes de la maladie. Or, le cortex entorhinal, situé sous l’hippocampe et jouant un rôle essentiel pour la navigation et la mémoire spatiale, est l’une des premières structures cérébrales qui est affectée par l’accumulation d’enchevêtrements neurofibrillaires, composés en majorité de protéine tau. Jusqu’ici, personne n’avait été capable de montrer comment la pathologie tau pouvait conduire à des difficultés de navigation.

Hongjun Fu et coll. ont étudié un modèle animal : une souris transgénique qui accumule la protéine tau humaine principalement dans le cortex entorhinal (CE). Ils montrent que la pathologie tau chez ces souris âgées s’accompagne d’une perte des neurones excitateurs dans le CE, d’une baisse d’activité des cellules de grilles, et de troubles de la mémoire spatiale. Ainsi, la pathologie tau, en épargnant les cellules inhibitrices, perturbe l’équilibre entre les neurones excitateurs et inhibiteurs et diminue la décharge des cellules de grilles.

« Cette étude montre clairement que la pathologie tau débutant dans le cortex entorhinal peut conduire à des défauts de décharge des cellules de grille et sous-tend la détérioration de la cognition spatiale dans la maladie d’Alzheimer », commente le Professeur Eric Kandel, prix Nobel et directeur du Kavli Institute pour la Recherche cérébrale à la Columbia University.

Article rédigé par Georges Simmonds pour RT Flash

Medical Xpress

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|