|

|

Edito

Les données massives (Big Data) bouleversent les sciences de la vie et la médecine

Bien qu’elle soit diffuse et encore peu visible, une révolution est en marche, non seulement dans le domaine de la biologie et de la médecine, mais plus largement, dans l’ensemble du secteur de la santé : il s’agit des données massives (big data). D’après Orange Healthcare, les données de santé devraient être multipliées par 50 d’ici 2020, par le biais notamment des développements de la génomique, des équipements médicaux connectés, de l’informatisation des dossiers patients, ainsi que de l’utilisation des applications mobiles santé et des capteurs d’activité.

Le premier enjeu est d’abord de nature économique car l’exploitation intelligente des données massives est en train de faire tomber les frontières entre disciplines, métiers et pratiques, en permettant de réaliser très rapidement des analyses comparatives sur d’immenses quantités d’informations, ce que l’être humain seul ne peut pas faire. Le résultat de cette avancée scientifique est l’émergence d’une nouvelle médecine « 4P », c’est-à-dire prédictive, préventive, personnalisée et participative.

Selon Statista, le marché mondial de la santé numérique devrait passer de 135 à 233 milliards de dollars d’ici 2020. En 2016, 73 millions d’appareils de santé étaient connectés à travers le monde. En 2020, ils seront 161 millions selon une étude de Grand View Research. Selon la dernière étude de Juniper Research, le nombre d’utilisateurs de m-santé (M-Health) passera, pour sa part, de 50 millions en 2015 à 157 millions dans le monde en 2020. Cette explosion de la médecine et de la santé numériques personnalisées sera d’autant plus forte qu’elle répond aux défis liés à la hausse de la durée de vie moyenne de la population mondiale, qui dépasse à présent les 70 ans et à l’augmentation de la prévalence dans les pays développés des maladies dites « de civilisation » (cancer, maladies cardio-vasculaires, diabète, maladie d’Alzheimer).

Dans moins de 10 ans, la grand majorité des seniors, mais également des patients souffrant de maladies chroniques, seront équipés en permanence de dispositifs portables de surveillance médicale, directement intégrés aux vêtements et dans les objets de la vie quotidienne et connectés à l’Internet des objets de santé (IoT). Ces « wearables » (bracelets, montres, ou vêtements connectés), représentent déjà près des deux tiers du marché des appareils médicaux connectés et ils permettront demain de récupérer en permanence une masse considérable et très précieuse de données médicales et sanitaires.

L’analyse intelligente de ces informations à l’aide de machines dotées d’une puissance de calcul exaflopique et utilisant l’intelligence artificielle aura au moins trois conséquences majeures. Premièrement, elle conduira à repenser totalement la classification des principales pathologies. Deuxièmement, elle permettra de réaliser un vieux rêve de la médecine : concevoir des médicaments sur mesure qui évolueront dans le temps pour chaque patient et chaque pathologie traitée. Enfin, cette généralisation de la santé numérique permettra de recouper un nombre incalculable de types de données et de mettre en œuvre une véritable « prospective épidémiologique » qui pourra, par exemple, mesurer, avant la réalisation d’une infrastructure ou la construction d’une usine, l’impact sanitaire et médical de ces projets sur les populations voisines concernées.

Si cette révolution des « DMM3 » (donnés massives médicales) est possible, c’est parce que les organismes de recherche possèdent à présent une puissance de calcul colossale, associée à des capacités de stockage tout aussi impressionnantes. A Lyon par exemple, la plate-forme européenne d’immunomonitoring « Platine », gérée par le Centre Léon Bérard de lutte contre le cancer et l’Inserm, offre aux médecins un outil très efficace d’aide à la décision thérapeutique en cancérologie et en infectiologie, en permettant l’analyse du statut immunologique initial des patients.

Microsoft et Median Technologies, l'expert français des logiciels d'aide à l'interprétation de l'imagerie médicale en 3D pour la cancérologie, ont conclu en 2016 un partenariat visant à mettre au point de nouvelles méthodes pour la détection, le diagnostic et le suivi des cancers à partir de l'analyse des données massives. Concrètement, Median va installer son système révolutionnaire Ibiopsy, qui est capable de détecter les phénotypes de divers cancers à travers l'extraction et la mesure de biomarqueurs d'imagerie - indicateurs clés pour le diagnostic et le traitement en oncologie - sur la plate-forme cloud Azure de Microsoft. Le but est de proposer, dès la fin 2017, un outil efficace. Comme le précise Fredrik Brag, PDG de Median. « L'utilisation des méthodes de traitement des big data va permettre l'analyse en temps réel de ces biomarqueurs d'imagerie, qui est essentielle pour détecter de manière précoce des cancers et mettre en place de nouvelles stratégies thérapeutiques personnalisées ».

Le mathématicien lyonnais de réputation mondiale, Cédric Villani, est également convaincu que l’exploitation des données massives va révolutionner la médecine et permettre notamment de faire des pas de géant dans la lutte contre le cancer. Il soutient le projet Epidemium, lancé conjointement en 2015 par le laboratoire Roche, en pointe dans les traitements anticancéreux, et La Paillasse, un laboratoire communautaire. Epidemium a pour ambition d’utiliser de façon systématique les données statistiques des grandes bases de données afin de les croiser pour, par exemple, détecter ou évaluer des situations à risque. Parmi les outils novateurs qui constituent Epidemium, on trouve par exemple Baseline, une plate-forme qui développe une base de données issues d'une centaine de pays et recensant une myriade de facteurs de risques liés au cancer : âge, poids, obésité, alimentation, alcool, cholestérol…

Cédric Villani pense que demain, chaque médecin aura son assistant algorithmique qui lui permettra de connaître avec la plus grande précision les probabilités de survenue pour telle ou telle pathologie pour un patient particulier. Une fois la maladie déclarée, ces outils de modélisation mathématique pourront également prédire l'évolution spécifique d'une pathologie chez un malade, en prenant en compte un très grand nombre de paramètres. Enfin, ces mêmes outils pourront également mesurer en temps réel et adapter, si besoin, l’efficacité de la stratégie thérapeutique choisie.

Pour parvenir à cette médecine interactive et entièrement individualisée, les différents acteurs concernés travaillent sur l’harmonisation et l’interopérabilité des données provenant de sources très hétérogènes. Par exemple, Kaiser Permanente a créé un programme intitulé HealthConnect, dont le but est de regrouper tous les rapports et enregistrements de santé au sein d’un même système. Ce programme a déjà permis de réduire les dépenses globales de santé de 1 milliard de dollars aux Etats-Unis.

Autre exemple, à Pittsburgh la Health Data Alliance regroupe et recoupe les données issues de sources variées, incluant les enregistrements de santé, les rapports des assurances, les capteurs d’objets connectés, les données génétiques et même les réseaux sociaux. L’objectif est de dresser le profil le plus complet possible d’un patient, afin de pouvoir lui proposer une prise en charge médicale globale et personnalisée, qui intègre sa personnalité et son histoire individuelle.

S’appuyant sur son ordinateur Watson, IBM travaille sur un outil d’aide à la décision qui saura analyser et comparer les recherches médicales existantes sur n’importe quel sujet afin de synthétiser et de résumer ces informations pour le médecin. Celui-ci pourra alors choisir le meilleur traitement pour son patient, en utilisant ces ressources de recherche intelligente qui lui éviteront de faire de fastidieuses recherches d’information. Fin 2016, Watson a été utilisé par des chercheurs de l’Université de North Carolina School pour superviser 1000 cas de cancer diagnostiqués par des oncologues. Résultat : dans 99 % des cas, Watson a proposé le même traitement que celui des médecins spécialistes... Mais cette expérimentation a montré également que les cancérologues participant à cette étude avaient omis dans 30 % des cas des options envisagées par le logiciel d’IBM. Pourquoi ? Tout simplement parce que, contrairement à Watson, qui avait ingurgité les études les plus récentes, ces spécialistes n'étaient pas toujours au courant, faute de temps disponible, des toutes dernières recherches en oncologie...

Face à ces résultats, l'Association américaine d'oncologie clinique se dit persuadée que des avancées majeures dans le traitement du cancer ne sont possibles que si les oncologues et les chercheurs peuvent avoir accès à l'ensemble des informations qui existent sur la maladie. Elle a créé CancerLinQ, un système d'apprentissage rapide en oncologie. CancerLinQ utilise le traitement analytique du big data pour récupérer les données réelles de patients depuis les dossiers médicaux informatisés. CancerLinQ permettra la mise en jour permanente du dossier médical personnel électronique du patient, ainsi que la surveillance des mesures de qualité clinique en temps réel et l’identification de groupes de patients anonymes partageant les mêmes caractéristiques, permettant aux médecins de comprendre comment d'autres patients similaires aux leurs ont été traités.

Il y a quelques jours, IBM a présenté son projet Watson Clinical Review Imaging, qui sera disponible dans deux ans, et vise à étendre et à généraliser l’utilisation de son outil d’intelligence artificielle Watson à l’ensemble du champ médical, qu’il s’agisse de la recherche ou des applications cliniques. Cet outil croisera les données et remplira les dossiers de santé de patients. À partir de ces croisements, Watson pourra identifier les patients susceptibles d’avoir besoin de soins intensifs.

L’intelligence artificielle sera d’abord utilisée pour diagnostiquer les patients ayant une sténose aortique, c’est-à-dire un rétrécissement aortique. Watson croisera l’imagerie cardiaque avec les dossiers médicaux pour repérer les patients nécessitant un suivi plus poussé. L’objectif étant à terme de repérer les autres maladies cardiaques comme la thrombose veineuse, les troubles de la valve aortique ou la cardiomyopathie, puis d’établir des traitements pour des listes de patients à surveiller qu’elle aura au préalable effectuées. IBM a déjà effectué des tests dans une étude pilote mais a refusé de donner des chiffres sur le nombre de patients qui ont été signalés pour un suivi, se contentant juste de dire que Watson a fait une grande différence.

Soulignons enfin qu’il y a quelques semaines, une remarquable étude présentée par le Docteur François Diévart à l’occasion des Journées européennes de la Société française de cardiologie (JESFC 2017) et qui n’aurait pas été réalisable sans les données massives, a fait sensation et est venue remettre en cause un dogme scientifique pourtant solide.

Selon cette vaste étude canadienne CANHEART, portant sur plus de 600 000 individus, le HDL ne devrait plus être considéré comme un facteur spécifique du risque cardiovasculaire. Habituellement présenté comme le "bon cholestérol", le HDL-cholestérol fait l'objet de recommandations pour augmenter son niveau sanguin, à l'inverse du LDL-cholestérol. Sur cette question, la Haute autorité de santé (HAS) précise qu’un taux de HDL-c ≥ 0,60 g/l (1,5 mmol/l) constitue « un facteur protecteur » de la fonction cardiovasculaire. Ces recommandations s'appuient notamment sur l'étude épidémiologique menée à Framingham, aux Etats-Unis, qui a associé les niveaux les plus bas de HDL à une majoration du risque cardiovasculaire, indépendamment des autres facteurs de risque, comme le LDL.

Mais cette étude CANHEART (Cardiovascular Health in Ambulatory Care Research Team), menée par Dennis Ko et ses collègues de l'Institute for Clinical Evaluative Sciences de Toronto (Canada) vient de bouleverser ces certitudes bien établies. Ce travail a analysé les données de 631 000 individus qui ne présentaient pas d'antécédents de maladie cardiovasculaire et étaient âgés en moyenne de 57 ans. Cette cohorte dont les patients présentaient un taux de HDL moyen de 0,55 g/L a été suivie pendant cinq ans.

Cette étude montre qu'un faible taux de HDL (< 0,51 g/L) est bien corrélé à une mortalité accrue, toutes causes confondues. A l’opposé, un niveau élevé de HDL est associé à une majoration de la mortalité non cardiovasculaire, pour un HDL > 0,70 g/L chez les hommes et un HDL > 0,90 g/L chez les femmes. L'effet préventif du HDL apparaît pour des taux compris entre 0,51 et 0,90 g/L, la mortalité d'origine cardiovasculaire étant alors au plus bas. Selon le Docteur Diévart, « cette étude rendue possible par les big data change la donne en montrant qu’il existe une relation complexe entre le HDL et que le pronostic et que le HDL ne peut plus être considéré comme un facteur de risque cardiovasculaire ». Ce récent exemple, qui a beaucoup impressionné la communauté scientifique, montre à quel point l’exploitation généralisée des données massives ne modifie pas seulement l’ensemble des perspectives thérapeutiques mais remet en cause les fondements même de la connaissance scientifique et médicale.

Il ne fait à présent plus de doute que dans des maladies graves mais complexes, dans lesquelles sont impliqués de très nombreux facteurs biologiques, génétiques et environnementaux, je pense notamment au cancer et à la maladie d’Alzheimer mais aussi à l’autisme ou à la dépression, l’exploitation des donnés massives à l’aide des nouveaux outils d’intelligence artificielle de type Watson va permettre des avancées majeures, tant sur le plan fondamental, que clinique et thérapeutique.

Face à cette immense révolution de la connaissance qui a commencé, notre Pays, comme le souligne avec force Cédric Villani, doit absolument se donner les moyens de conserver son excellence dans les domaines de la recherche en mathématiques, mais également rechercher une plus grande indépendance dans le domaine stratégique de la puissance de calcul et des nouveaux outils informatiques, ce qui suppose une recherche européenne plus intégrée, plus puissante et plus visionnaire.

Très concrètement, l’Europe doit tout mettre en œuvre pour se doter la première des futures machines à la puissance de calculs exaflopiques qui vont permettre, en traitant mille fois plus rapidement qu’aujourd’hui les données massives biomédicales, une accélération fantastique dans la connaissance des mécanismes les plus complexes du vivant. C’est à ce prix que nous pourrons demain faire face aux immenses défis humains, économiques et sociaux liés au vieillissement, que va devoir affronter notre société au cours de ce siècle.

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

Air Liquide vient d'inaugurer à St-Priest près de Lyon son premier centre d’opération à distance. Ce centre permet le pilotage à distance de la production de 22 unités du groupe en France, afin de contrôler la production, d’optimiser leur consommation énergétique et de les fiabiliser grâce à de la maintenance préventive.

Derrière leurs écrans d’ordinateurs, les analystes du centre de contrôle à distance Air Liquide observent les données qui transitent dans leur système depuis les vingt-deux sites de production français. Sous leurs yeux, différents paramètres (azote, oxygène, etc.) s’affichent, permettant de contrôler et optimiser la production mais également mieux anticiper les pannes.

« L’objectif est de faire de la donnée un actif essentiel de notre industrie », commente Louis-François Richard, Directeur général d’Air Liquide France Industrie. Air Liquide supervise ainsi 22 usines de production en France pour répondre aux différentes demandes des clients. « Cela fait près de 15 ans que l’on stocke des données, ce qui représente un milliard de données par jour, au niveau mondial » précise Olivier Delabroy, en charge de la transformation numérique pour le groupe Air Liquide. Comment utiliser 15 ans de données pour optimiser la performance énergétique ? L’entreprise nous donne l’exemple d’une solution en cours de déploiement, en Espagne.

La technologie et les algorithmes développés en interne analysent les quinze années d’historique pour identifier si, à un moment, on a réussi à faire fonctionner cette même usine d’Espagne de façon optimale et avec le moins d’énergie. « Nous allons chercher le 0,1 % de gain d’énergie », commente Olivier Delabroy. « C’est un réel enjeu pour nous. » Des paramètres sont mis à disposition de l’opérateur pour qu’il puisse lui-même ajuster les ratios et optimiser un peu plus son usine.

Air Liquide s’est lancé il y a un an dans un projet d’usine du futur appelé « Connect ». Ce projet repose sur trois piliers : le centre national d’optimisation à distance de Saint-Priest, la diffusion des technologies digitales au sein des équipes et la transformation des métiers. « Les trois marqueurs de ce projet sont l’innovation ouverte en interne et en externe, une promesse technologique et humaine et un outil incroyable » commente Louis-François Richard. « Nous avons été novateurs dans ce projet. Il a été co-construit par des opérateurs et start-up pour réaliser des applications répondant aux besoins et réalités du terrain. »

Nous avons eu la possibilité de découvrir quatre start-up qui participent à la digitalisation du groupe. Le DG d'Air Liquide précise quelles sont ces 4 start-up : AMA développe une solution basée sur des lunettes connectées permettant au porteur des lunettes de partager sa vision avec un expert distant pour de la télé-expertise et téléassistance en temps réel. Speachme propose des vidéos techniques et explicatives sur l’utilisation des machines. Imag’ing scanne les usines en 3D pour proposer des plans digitaux précis des lieux. WeDo Studios est spécialisée dans l’accompagnement des entreprises et dans la conception de services innovants.

Article rédigé par Georges Simmonds pour RT Flash

Air Liquide

|

|

|

|

|

|

|

|

|

Un groupe de recherche international piloté par le CNR et le Politecnico de Milan a effectué une étude sur la faisabilité des circuits photoniques (guide d’onde) dans des plates-formes en diamant capables de fournir une puissance de calcul infiniment supérieure à celle des ordinateurs traditionnels.

Ces dispositifs innovants permettraient de résoudre des problèmes très complexes comme les prévisions des changements climatiques, les variations du marché des actions ou les diagnostics médicaux, à savoir IRM, en augmentant de manière exponentielle leur sensibilité et résolution.

L’étude a permis de réaliser le premier prototype de circuit quantique intégré en diamant, une plate-forme permettant d’intégrer dans la même puce les sources de qubit (les bits quantiques) et les guides d’onde optiques. Les circuits photoniques sont l’analogue optique des circuits électriques, mais ce sont les photons, les quanta lumineux, à être transportés le long des parcours optiques.

Pour la création de ce type de parcours, des impulsions laser femtosecondes ont été utilisées et permettent de modifier les caractéristiques physiques du diamant. En traçant des lignes qui constituent le circuit, elles mettent en contact les défauts dans le diamant qui peuvent être utilisés comme des bits quantiques.

En effet, dans la maille cristalline du diamant, il y a des défauts, tels que les lacunes d’azote (nitrogen vacancy-NV) : c’est le cas si, à la place de deux noyaux de carbone, un atome d’azote occupe la place adjacente à celle d’un atome de carbone vacant. Ces défauts ont une disposition aléatoire à l’intérieur du diamant et ont des propriétés spéciales : le spin électronique du centre NV peut être utilisé comme bit quantique en augmentant la vitesse de calcul de façon exponentielle par rapport aux ordinateurs actuels, ayant des bits normaux, c’est-à-dire les électrons. Par le biais d’une exposition à un laser à femtosecondes, il est possible de créer des centres NV aux positions souhaitées, en contrôlant ainsi le schéma des circuits quantiques.

Article rédigé par Georges Simmonds pour RT Flash

CNR

|

|

| ^ Haut |

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

Un drone va être présenté par Airinov lors du Salon de du matériel agricole SIMA. Son prix relativement abordable le rend accessible aux agriculteurs pour réaliser la supervision de leurs parcelles. Ce drone de surveillance de parcelles agricoles eBee SQ que présentera Airinov, filiale de Parrot, au salon du matériel agricole SIMA, ne coûte que 10 000 euros. Celui-ci offre des informations sur l’état de santé des plantes et leur besoin en engrais. Cette aile robuste dispose du pilotage automatique, d’une autonomie de vol de 45 minutes et est adaptée à un usage intensif.

Elle permet à l’agriculteur de cartographier lui-même des centaines d’hectares en un seul vol. Car c’est l’objectif d’Airinov : aller vers un drone à la ferme et non à plusieurs exploitations. "Cette aile volante, qui est plus robuste et a une meilleure autonomie que la précédente, a été simplifiée pour être utilisée par l’exploitant", explique Erick Lebrun, directeur marketing d’Airinov. "Le nouveau capteur dont dispose cette aile est un produit de Parrot : le Sequoia".

La machine recueille des images de la parcelle – grâce à son capteur d’images doté de quatre objectifs – pour ensuite réaliser une photogrammétrie. Cette dernière permet de reconstituer ensuite une carte plate avec quatre longueurs d’onde, révélant l’état de santé des plantes et leur besoin en azote.

Ces cartographies sont compatibles (ISObus, une norme de communication entre le tracteur et les outils) avec la plupart des GPS de tracteur et leur permettent de réaliser de façon automatique – lorsqu’ils sont équipés de la technologie – et à bonne dose l’épandage. "Avec notre drone, nous sommes capables d’acquérir une donnée à 30 centimètres près", précise Erick Lebrun. "Mais on la dégrade pour nous adapter à la technologie. Si le matériel évolue, on pourra fournir des cartes beaucoup plus précises".

Article rédigé par Georges Simmonds pour RT Flash

Industrie & Technologies

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Une équipe américaine dirigée par Norman Yao (Université Californie) est parvenue à créer le premier "cristal temporel". A l'origine, c'est le prix nobel de physique Frank Wilczek qui a théorisé le cristal temporel en 2012. Un cristal temporel, c'est tout simplement un élément dont les atomes forment une structure qui se répète dans l'espace, mais aussi dans le temps.

Cela n'a pas l'air de grand chose, mais derrière cette découverte se cache un nouvel état de la matière, que l'on pensait impossible. Et même si on est pour l'instant en plein dans la recherche fondamentale, les cristaux temporels pourraient bien servir dans le futur de mémoire pour les ordinateurs quantiques, précise l'université californienne de Berkeley.

Pour arriver à observer ces cristaux, les chercheurs ont dû utiliser des lasers pour modifier le comportement d'atomes d'ytterbium, un métal rare. Pour les physiciens, un cristal n'est autre qu'un certain nombre d'atomes qui sont dans un état d'équilibre, stable. Ils sont agencés d'une certaine manière, qui se répète dans l'espace, précise Science et Vie. Un cristal temporel, c'est la même chose, sauf que la structure des atomes se répète dans l'espace et dans le temps.

Cela veut dire que l'état quantique des atomes oscille en rythme, sans dépenser de l'énergie. D'où la comparaison de Norman Yao, auteur principal de l'étude. Ce qui est incroyable, c'est que cette oscillation a lieu dans un état qui est normalement "stable", où il n'y a pas de mouvement dans le temps.

Article rédigé par Georges Simmonds pour RT Flash

Physical Review Letters

|

|

|

|

|

|

|

|

|

D'ici 2030, l'Inde sera prête à extraire l'hélium-3 sur la Lune pour l'utiliser comme source d'énergie, selon l'agence IANS qui se réfère au récentes déclatations du professeur de l'Organisation indienne de recherche spatiale (ISRO), Sivathanu Pillai.

Selon ce scientifique indien, les gisements de cette ressource sont si riches que tous les pays pourraient en profiter. Les chercheurs russes le confirment. Ainsi, Vladislav Chevtchenko, chef du département des recherches de la Lune et des planètes de l'Institut d'astronomie de l'Université de Moscou, estime que les réserves en hélium-3 sur le satellite naturel de la Terre seraient suffisantes pour fournir aux terriens de l'énergie pendant 5 000 ans.

L'hélium-3 est un isotope non radioactif de l'hélium dont la fusion générerait d'énormes quantités d'énergie, le tout sans déchets radioactifs. Cependant, cet élément n'est présent qu'en très faible quantité sur la Terre. Sur la Lune, les réserves de cet isotope précieux, selon des estimations prudentes, seraient d'environ 500 000 tonnes. La fusion nucléaire d'une tonne d'hélium-3 avec 0,67 tonne de deutérium libère une énergie équivalente à environ 15 millions de tonnes de pétrole.

Article rédigé par Georges Simmonds pour RT Flash

India

|

|

| ^ Haut |

|

|

|

|

|

|

|

Espace |

|

|

Espace et Cosmologie

|

|

|

|

|

|

|

|

|

|

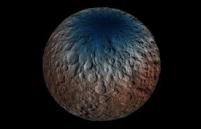

Des molécules organiques, de longues chaînes carbonées pas encore identifiées, ont été identifiées sur une surface de 1000 kilomètres carrés autour du cratère Ernutet, situé dans l'hémisphère nord de Cérès. "C'est la la première fois que l'on détecte clairement des molécules organiques depuis l'orbite d'un astre situé dans la ceinture principale d'astéroïdes", se réjouit Maria Cristina De Sanctis, principale auteure d'une étude publiée dans la revue Science. Une première que l'on doit au spectrographe VIR de la sonde Dawn qui est en orbite autour de la planète naine Cérès depuis le mois de Mars 2015.

Il existe d'autres zones, plus petites, riches en matières organiques à l'ouest et à l'est du cratère Ernutet et des molécules similaires ont également été trouvées dans une très petite zone à l'intérieur du cratère Inamahari, à environ 400 kilomètres d'Ernutet. La détection de ces molécules complète le panorama fourni par les données issues de la sonde Dawn depuis 2015 : elles révèlent une planète riche en glace d'eau, en argiles ammoniaquées et en différents sels (sodium et magnésium).

Une liste à laquelle s'ajoutent maintenant les molécules organiques qui sont des éléments constitutifs de la vie sur Terre. Bien d'autres critères sont évidemment nécessaires pour que cette dernière puisse éclore mais dans un passé très lointain, Cérès s'est formée au tout début de l'histoire du système solaire et, probablement très loin du Soleil, cet astre a pu avoir des conditions favorables à son développement.

D'autant plus que les scientifiques estiment que ces molécules organiques ont été produites sur la planète et non pas "importées" lors d'un impact avec un météorite ou une comète. Ils travaillent maintenant à mieux cerner les conditions géologiques dans lesquelles ces molécules se sont formées. Ils profiteront encore des nouvelles données qu'enregistre chaque jour la sonde Dawn qui fonctionnera jusqu’à épuisement de ses batteries.

Article rédigé par Georges Simmonds pour RT Flash

Science

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

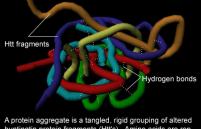

Une équipe de l'Inserm à Grenoble a montré que la huntingtine joue un rôle important au cours du développement cérébral et ce rôle est modifié lorsque la protéine est mutée. Ceci suggère que des anomalies seraient présentes dans le cerveau des patients atteints de la maladie de Huntington bien avant l’apparition de leurs premiers symptômes.

La maladie de Huntington est une maladie génétique neurologique à caractère héréditaire et dominant qui touche environ 5 cas pour 100 000 individus. Toute personne porteuse d’une mutation sur un seul allèle du gène codant pour la huntingtine va développer les symptômes de cette maladie. Cette dernière apparaît le plus souvent à l’âge adulte, généralement entre 30 et 50 ans, et entraîne des problèmes moteurs, sensoriel et cognitifs. Les patients perdent progressivement leurs capacités physiques et mentales, aboutissant à un état grabataire.

La maladie de Huntington est caractérisée par la dégénérescence de certains neurones du cerveau, en particulier ceux du striatum et du cortex, la région la plus externe du cerveau. Jusqu’à présent, les chercheurs se sont surtout focalisés sur le stade auquel apparaît la maladie, c’est-à-dire chez l’adulte, pour tenter d’expliquer ces pertes neuronales.

Cependant, la huntingtine est exprimée au cours du développement embryonnaire et elle y joue un rôle essentiel. En effet, des expériences chez la souris ont montré que l’absence de huntingtine provoque une mort in utero précoce. Dans l’étude menée par l’équipe de Sandrine Humbert, les chercheurs ont empêché la production de la huntingtine normale et fait produire la version mutante, responsable de la maladie de Huntington, dans le cortex de souris. C’est alors qu’ils ont observé une série d’anomalies au cours du développement.

Le cortex est composé de six couches de cellules neurales aux caractéristiques et fonctions différentes. Ces couches se forment progressivement, de la partie interne vers la partie externe du cortex, grâce à la prolifération et la migration des cellules nerveuses. Pour cela, ces cellules passent d’une forme multipolaire, en étoile, à une forme bipolaire, ovale, afin de s’accrocher à des câbles le long desquels elles migrent. Or, en cas de déficience de la huntingtine, la transition multipolaire/bipolaire se fait mal, empêchant les neurones de bien s’accrocher à leur câble.

Reste à savoir si ces anomalies du développement sont à la base de manifestations cliniques observées chez les patients atteints de la maladie de Huntington. Des travaux en cours dans un autre laboratoire ont montré que l’expression de la huntingtine mutante seulement au cours du développement embryonnaire conduit à certains signes de la maladie de Huntington chez la souris adulte.

Article rédigé par Georges Simmonds pour RT Flash

Inserm

|

|

|

|

|

|

|

|

|

Des scientifiques français (Laboratoire de neurosciences de l’Université de Poitiers) et belges (Institut de recherche en biologie humaine et moléculaire de Bruxelles) viennent de montrer qu'il était possible de réparer un cerveau abîmé grâce à une greffe de neurones obtenus à partir de cellules souches, à condition toutefois que les neurones ainsi fabriqués soient identiques à ceux de la région lésée.

Après une greffe de neurones, les chercheurs ont pu observer, chez plusieurs animaux, le rétablissement fonctionnel des zones lésées du cerveau. Une première mondiale obtenue, qui plus est, au niveau du cortex cérébral, une des structures les plus complexes chez les mammifères.

En transplantant des neurones du cortex pour rétablir des connexions lésées, les scientifiques ont aussi mis en évidence un point fondamental : réparer le cerveau ne serait possible que par des neurones identiques à ceux de la région lésée. Ce postulat d’une restauration possible uniquement entre cellules d’une même famille met particulièrement en relief une seconde découverte faite par une équipe suédoise : la mise en évidence de nouveaux types cellulaires dans le cerveau.

Il s'agit notamment d’une sous-classe de neurones présente dans le cortex et d'une catégorie inconnue d'oligodendrocytes, ces cellules fabriquant la myéline et servant d’isolants électriques aux prolongements des neurones. Selon Jens Hjerling-Leffler, un des co-auteurs de l’étude, « Ces recherches vont nous aider à mieux comprendre comment les cellules cérébrales répondent aux maladies ou aux blessures ».

Neuron

|

|

|

|

|

|

|

|

|

La polyarthrite rhumatoïde est une pathologie auto-immune dont l’origine reste difficile à cerner. De récentes recherches américaines mettent en évidence le rôle inédit d’une bactérie, Aggregatibacter actinomycetemcomitans. Selon ces travaux, elle interviendrait dans le déclenchement et le maintien de la maladie chez les patients.

C'est en analysant le liquide gingival enflammé, puis en comparant les protéines qu’il contient avec celles présentes au sein des articulations d’une personne touchée par la polyarthrite rhumatoïde, que les scientifiques ont pu établir ce lien de cause à effet.

Encore plus intéressant, les scientifiques ont pu ensuite isoler le responsable à l’origine de ces modifications si particulières. Il s’agit d’une bactérie appelée Aggregatibacter actinomycetemcomitans ou Aa. Elle est capable d’induire des changements dans les protéines de l’organisme via la production d’une toxine. Si les chercheurs se sont lancés sur cette piste, ce n’est cependant pas par hasard.

En effet, certains patients souffrant de polyarthrite rhumatoïde présentent également une inflammation chronique entre les gencives et les dents. Dans cette inflammation des tissus de soutien de la dent, appelée parodontite, plusieurs germes prolifèrent, dont la fameuse bactérie Aa. L’hypothèse d’une origine bactérienne orale n’est en soi pas nouvelle. Néanmoins, c’est la première fois qu’il est montré que les modifications induites par la bactérie Aa sont similaires à celles observées dans les articulations des patients.

Ces résultats soulignent l’importance que pourrait avoir l’hygiène bucco-dentaire pour la prévention et le contrôle de la polyarthrite rhumatoïde. Même s’il est prouvé que le terrain génétique intervient dans environ 30 % des cas, l’existence d’une parodontite doit être décelée et traitée chez les patients.

Article rédigé par Georges Simmonds pour RT Flash

Science

|

|

|

|

|

|

|

|

|

Le projet Dynamo (DYNAmic Models), mené par Stanley Durrleman, responsable du centre de neuro-informatique (équipe ARAMIS) au sein de l’Institut du cerveau et de la Moelle épinière (ICM) à Paris et le Professeur Harald Hampel, neurologue et psychiatre à l’Institut de la mémoire et de la maladie d’Alzheimer (CHU La Pitié Salpétrière, Paris) vise à créer un modèle numérique de l’évolution du cerveau au cours de la maladie d'Alzheimer, afin de fournir aux soignants un outil de médecine personnalisée et prédictive.

Pour rappel, la maladie d’Alzheimer est une maladie neurodégénérative qui touche 225 000 nouveaux cas par an en France. Causée par l’agrégation progressive de deux protéines anormales dans le cerveau (Amyloïde-A-béta et P-Tau), elle présente une phase silencieuse (sans symptômes) qui peut durer de 10 à 15 ans jusqu’à l’arrivée des premiers signes cliniques (perte de mémoire, de repères, troubles cognitifs) survenant en majorité après 65 ans.

Aujourd’hui, on ne sait diagnostiquer la maladie qu’après l’apparition des tout premiers symptômes, c’est-à-dire au moins une décennie après que la pathologie cérébrale a débuté. Ce qui serait la raison de l’échec des traitements testés lors des essais cliniques, prescrits trop tardivement pour enrayer le processus.

Selon les chercheurs, l’idéal serait donc de repérer la maladie bien avant qu’elle ne se déclare cliniquement pour pouvoir agir plus précocement. Pour ce faire, l’équipe de Dynamo a accès aux données médicales de milliers de patients (imagerie, tests biologiques, génétiques, tests neuropsychologiques) de la cohorte publique américaine ADNI, composée de près de 1500 malades à différents stades de la maladie d’Alzheimer. Mais aussi celles de 350 volontaires de la cohorte française Insight (CHU Pitié Salpétrière, Paris), âgés de 55 à 90 ans, non malades au départ mais exprimant une plainte mnésique et dont certains individus seulement développeront une maladie d'Alzheimer.

Pour le Profeseur Hampel, un tel modèle numérique permettrait une prise en charge précoce pour le patient et sa famille, comprenant des mesures de prévention pour reculer la survenue des premiers symptômes. Une prévention qui peut s'avérer cruciale. "Si l’on repoussait actuellement de cinq ans l’apparition de la maladie d’Alzheimer , on diviserait le nombre de patients atteints par deux !"

Article rédigé par Georges Simmonds pour RT Flash

Dynamo

|

|

|

|

|

|

|

|

|

Un régime alimentaire adapté pourrait-il réduire les symptômes de la schizophrénie ? Peut-être, si l'on en croit des chercheurs de l’Université de Manchester. Ceux-ci ont en effet montré que le fait de supplémenter en vitamine B des patients atteints de ce grave trouble mental permet de réduire les symptômes dits résiduels.

Cette étude a porté sur 832 patients schizophrènes sous traitement. Tous ont un point commun : ils ont intégré un essai clinique qui évalue l’impact d’une supplémentation en vitamines B6, B8 et B12 sur leur maladie. Compléter les médicaments habituels avec ces nutriments semble efficace sous certaines conditions.

« Une forte dose de vitamines B pourrait être utile pour réduire les symptômes résiduels chez les personnes atteintes de schizophrénie », résume Joseph Firth, co-auteur de la méta-analyse. Autrement dit, ces compléments alimentaires permettent d’améliorer l’efficacité du traitement et de s’attaquer aux symptômes résistants. L’ampleur du résultat varie toutefois selon les études.

Un autre élément influence l’impact des vitamines administrées : le timing. Plus la maladie est récente, plus la supplémentation semble efficace. De même, les patients qui souffrent d’une carence en vitamines, d’origine génétique ou alimentaire, tirent un plus grand bénéfice de l’expérience.

« Cela pourrait constituer une avancée importante, étant donné que nous avons désespérément besoin de nouveaux traitements pour cette pathologie », conclut Joseph Firth. De fait, nombre de patients présentent une rémission dans les premiers mois du traitement. Mais au bout de 5 ans, 80 % d’entre eux ont rechuté.

Article rédigé par Georges Simmonds pour RT Flash

Cambridge Core

|

|

|

|

|

|

|

|

|

Une étude américaine réalisée par des chercheurs du Laboratoire Jackson (Bar Harbor, Maine), dirigés par le Docteur Pete Williams, a montré que le nicotinamide peut directement protéger les cellules ganglionnaires de la rétine. "Le nicotinamide pourrait offrir une nouvelle classe thérapeutique pour le glaucome", précise le Docteur Pete Williams.

L'étude montre que chez la souris prédisposée au glaucome, une supplémentation orale en nicotinamide (vitamine B3), donnée en prévention ou en traitement, permet de protéger le nerf optique et la vision. Cette découverte pourrait offrir contre le glaucome une thérapie ciblant directement la rétine vieillissante. Un essai clinique est en vue. "L’ampleur de l’effet protecteur de cette vitamine est surprenante. Cependant, même si nous avons grand espoir d’une application clinique chez l’homme, des essais cliniques sont maintenant nécessaires pour déterminer l’efficacité et la sécurité chez les patients souffrant du glaucome", précise le Docteur Williams.

Le glaucome figure parmi les maladies neurodégénératives les plus fréquentes, affectant plus de 70 millions de personnes. Cette maladie de l’œil est caractérisée par la perte progressive des cellules ganglionnaires de la rétine, sous l’influence de facteurs comme l’âge ou une pression intraoculaire trop élevée. C’est la première cause de cécité irréversible dans le monde.

Pour mieux comprendre les mécanismes à l’origine du glaucome, l’équipe du Professeur Simon John (Jackson Laboratory, Maine) a étudié une souris prédisposée au glaucome et déterminé (par séquençage ARN) quels changements moléculaires surviennent dans les cellules ganglionnaires de la rétine sous l’influence du vieillissement et de l’hypertonie oculaire.

Ils ont découvert des anomalies mitochondriales précédant la neurodégénérescence, et ils ont constaté une baisse avec l’âge des taux rétiniens de nicotinamide adénine dinucléotide (NAD+) en corrélation avec la neurodégénérescence. Puisque la NAD est importante pour de nombreuses réactions cellulaires, y compris pour l’énergie cellulaire, les chercheurs ont supposé que ses taux réduits pouvaient rendre les neurones plus vulnérables au stress engendré par l’hypertonie oculaire. Dès lors, en augmentant les taux de NAD, pourrait-on offrir une protection ?

Deux stratégies ont été évaluées avec succès. Les souris prédisposées au glaucome ont été traitées par nicotinamide oral (une forme de vitamine B3), un précurseur qui se transforme en NAD dans l’organisme. Cette vitamine B3 protège effectivement contre le glaucome, lorsqu’elle est donnée en prévention (6 mois) ou en thérapie (après l’hypertonie oculaire, pendant 3 mois). Elle normalise les anomalies mitochondriales, réduit la dégénérescence du nerf optique, prévient la perte des cellules ganglionnaires de la rétine et protège la vision.

À une dose encore plus forte, elle est extrêmement protectrice, avec 93 % des yeux traités dépourvus de lésion du nerf optique (comparé à 70 % avec la dose plus faible), une protection « sans précédent et inattendue », selon les chercheurs. Ils ont aussi évalué l’efficacité d’une injection oculaire unique d’une thérapie génique (Nmnat1, via un vecteur viral) visant à augmenter l’expression d’une enzyme clé pour la production de NAD, et ont constaté une protection ; 70 % des yeux traités ne présentent aucune lésion du nerf optique. La combinaison des 2 approches (supplément et thérapie génique) accentue la protection (84 % des yeux sans glaucome). "Le nicotinamide se trouve dans notre alimentation, et son profil de sécurité est bon, même à hautes doses", précise le Docteur Williams qui espère le succès des essais cliniques.

Article rédigé par Georges Simmonds pour RT Flash

Eurekalert

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|