|

|

|

|

|

| NUMERO 919 |

|

|

|

|

|

|

|

Edition du 20 Octobre 2017

|

|

|

|

|

Edito

Les éruptions volcaniques ont changé le destin de l’Humanité

Depuis la nuit des temps, les éruptions volcaniques ont jalonné l’histoire de notre planète et plus récemment, l’histoire de l’Humanité. Bien que moins dévastatrices et moins meurtrières que les tremblements de terre, ces éruptions, en raison de leur visibilité et de leur dimension spectaculaire, et parfois apocalyptique, ont toujours profondément marqué les sociétés et civilisations et certaines, comme celle du Santorin, sous l’Antiquité, ou du Vésuve, au début de notre ère, se sont inscrites dans notre inconscient collectif de manière indélébile.

Les plus grandes éruptions des 2.000 dernières années ont laissé des marques toujours observables à l’intérieur de la calotte glaciaire de l’Antarctique. En 2014, des chercheurs, sous la direction de Michael Sigl et Joe McConnell du Desert Research Institute du Nevada (DRI), ont procédé à une analyse minutieuse des dépôts de poussière de sulfate présents dans la glace. Ils ont ainsi pu retracer une histoire très complète des éruptions volcaniques survenues au cours de cette période.

Selon cette vaste étude, il y aurait eu au moins 116 éruptions volcaniques au cours des deux derniers millénaires, dont certaines d’une puissance suffisamment gigantesque pour émettre des panaches de poussières de sulfate qui ont voyagé jusqu’au pôle sud (Voir article Phys.org).

En étudiant les différents niveaux de dépôts de sulfate, les scientifiques ont pu établir le calendrier et le classement des éruptions volcaniques les plus violentes de ces 2.000 dernières années. Parmi celles-ci, il faut citer celle qui eut lieu près de la Crète, sur l’ile de Thera –appelée aujourd’hui Santorin – vers 1646 avant notre ère). Cette éruption, d’une violence inouïe, fit plusieurs dizaines de milliers de morts et aurait été cent fois plus puissante que celle du Vésuve qui détruisit, seize siècles plus tard, la ville romaine de Pompéi.

Cette éruption aurait également provoqué, conjuguée à d’autres facteurs économiques et politiques, l’effondrement de la brillante civilisation minoenne sur l’île de Crète, à 110 km au sud, au travers d’un gigantesque tsunami. Le souvenir de ce cataclysme volcanique perdure jusqu’à aujourd’hui chez les peuples méditerranéens et a peut-être été à l’origine de la légende du continent englouti de l’Atlantide ; il pourrait également expliquer l’origine des dix plaies d’Egypte mentionnées dans le Livre de l’Exode.

Toujours selon cette étude, deux éruptions énormes auraient déposé 35 % du sulfate en Antarctique : celle du Samalas en Indonésie (à proximité du mont Sinjani sur l'île de Lombok) et celle du Kuwae en 1452, situé dans l'archipel du Vanuatu, près des iles Shepard. Ces deux éruptions auraient joué un rôle majeur dans l'apparition du "petit âge glaciaire", une période marquée par un net refroidissement du climat dans l'hémisphère Nord entre le début du XIVème siècle et le milieu du XIXème siècle.

L’étude mentionne également l’éruption du Huaynaputina situé au Sud du Pérou. Celle-ci eut lieu le 19 février 1600 et fut la plus forte jamais enregistrée dans la période historique en Amérique du Sud. A la suite de l'explosion, d’énormes coulées de boue détruisirent de nombreux villages sur leur passage et certaines de ces coulées atteignirent la côte de l’Océan Pacifique, pourtant distante de 120 km. Quant aux pluies de cendres, elles retombèrent dans un rayon de 500 kilomètres et l’agriculture de cette région, située aux confins du chili, du Pérou et de la Bolivie, mit 150 ans à retrouver le niveau de productivité qu’elle avait avant cette explosion.

Entre 1783 et 1785, le Laki, une chaîne de volcans islandais comptant environ 130 cratères, entra en éruption. Ce gigantesque nuage, équivalent à plus de trois fois les émissions annuelles actuelles de toute l’Europe, toucha notre continent, porté par des vents favorables, à partir de l’été 1783. Il provoqua un grand nombre de victimes par maladies respiratoires et eut également des conséquences catastrophiques sur le climat en favorisant des tempêtes de grêle dévastatrices. L’un des effets de cette éruption islandaise fut de détruire une grande partie de la récolte de blé en France en 1788, ce qui fut à l’origine d’une hausse considérable du prix du pain, facteur qui lui-même alimenta le mécontentement populaire qui allait conduire à la Révolution française…

Alors que l’Empire connaissait ses derniers feux, le Tambora, un volcan situé sur l'île de Sumbawa en Indonésie, connut le 10 avril 1815, une éruption volcanique catastrophique, considérée comme l'une des plus meurtrières de l'Histoire. Entendue à plus de 2.000 kilomètres aux alentours, l'éruption a causé l'éjection de quelque 160 kilomètres cubes de roches incandescentes et d'un volume tout aussi considérable de cendres volcaniques. La catastrophe aurait directement causé la mort de plus de 10.000 personnes et aurait entraîné famine et maladies, aboutissant à un bilan dépassant les 70.000 morts. Elle aurait généré d'importantes anomalies climatiques, notamment une importante chute des températures. 1816 a par la suite été baptisée "l'année sans été".

Toujours en Indonésie, l’explosion en 1883 du volcan Perbuatan, sur l’île de Krakatoa, a eut lieu en 1883, éjectant plus de 20 km3 de cendres à 80 km d’altitude, ce qui provoqua un abaissement la température mondiale moyenne de 0,25° C l'année suivante et entraîna un dérèglement climatique mondial d’au moins cinq ans. Quant aux pertes humaines, elles atteignirent au moins 34 000 personnes, principalement victimes du tsunami de 40 mètres de haut qui ravagea une grande partie de l’archipel indonésien.

Il faut encore citer l’éruption du Santa Maria, au Guatemala, en 1902, qui fut l’une des plus grandes éruptions du 20e siècle et provoqua la mort d’au moins 6 000 personnes. La même année eut lieu la terrible éruption de la Montagne Pelée qui a marqué à jamais la Martinique et raya de la carte la ville de St-Pierre, provoquant au moins 30 000 morts.

L’éruption du Novarupta, qui eut lieu en Alaska, en 1912, fut sans doute la plus grande éruption volcanique du 20ème siècle. Elle éjecta environ 30 km3 de magma et de cendres dans les airs, soit trois fois plus que le Pinatubo en 1991 et son panache de cendre monta jusqu’à 40 km d’altitude.

L’éruption du Mont St-Hélène, en mai 1980, libéra une quantité d'énergie équivalente à 27 000 fois la puissance dégagée par une bombe atomique comme celle d'Hiroshima (soit approximativement 350 mégatonnes d'équivalent TNT) et éjecta plus de 4 km3 de matière. Cette éruption tua 57 personnes et fut la plus dévastatrice de l’histoire des Etats-Unis, tant sur le plan humain qu’économique, avec des dégâts estimés à plus d’un milliard de dollars.

Le 13 novembre 1985 eut lieu l’éruption particulièrement destructrice du Nevado del Ruiz, un volcan situé au centre de la Colombie. Ejectant plus de 5 km3 de cendres et de gaz, ce volcan tua plus de 25 000 personnes, ce qui fait de cette éruption la 4ème plus meurtrière depuis un siècle, après celles du Tambora en 1815, du Krakatoa en 1883 et de la Montagne Pelée en 1902.

Enfin, l’éruption du Pinatubo aux Philippines, en 1991, a projeté plus de 10 km3 de matière et 20 millions de tonnes de soufre dans l’air et a créé une colonne de cendres qui monta jusqu’à 35 km dans l’atmosphère, causant une baisse des températures mondiales d’environ 0,5°C au cours de l’année suivante. Heureusement, grâce à une évacuation bien organisée, cette éruption, qui aurait pu être bien plus meurtrière, ne fit que 1000 victimes.

Il est frappant de constater que toutes ces éruptions majeures, outre les pertes humaines qu’elles provoquèrent, eurent également des effets considérables et dévastateurs sur le climat et les productions agricoles et entraînèrent parfois des conséquences économiques sociales et politiques majeures, émeutes, révolutions, changement de régime…

En 2016, une étude internationale dirigée par Matthew Toohey, du Centre de recherche sur les océans GEOMAR Helmholtz à Kiel, (Allemagne) a montré que deux éruptions volcaniques, dont l’origine n’a pas encore pu être située avec précision, survenues à quelques années d’intervalle, en 536 et 540 de notre ère, avaient obscurci le ciel de l'Europe pendant plus d'une année, et abaissé la température de deux degrés avec des conséquences dramatiques sur l’agriculture (Voir UiO). Cette chute brutale et prolongée de la température eut un effet dévastateur sur l'agriculture, provoquant une famine dans la plus grande partie de l'Europe et contribua sans doute à l’effondrement économique et démographique de l’Occident au cours de la seconde moitié du VIème siècle et peut-être également au déclenchement de la terrible pandémie de peste qui frappa l’Europe en 542.

En mars 2014, une étude du Laboratoire américain Lawrence Livermore a par ailleurs montré que, bien qu’aucune éruption majeure n’ait été enregistrée depuis 2000, leur fréquence a permis de compenser l’impact des gaz à effet de serre sur le climat. On savait déjà qu’en rejetant d’énormes quantités de dioxyde de soufre, une puissante éruption volcanique est capable d’entraîner à elle seule une baisse des températures au niveau mondial. C’est ce qui s’est passé en 1991, lors de l’éruption du Pinatubo qui a provoqué une baisse des températures mondiales de 0,4°C pendant trois ans en réduisant l’ensoleillement.

Mais cette étude américaine qui porte sur les 17 éruptions survenues depuis 1999, a montré que même les phénomènes volcaniques de faible intensité ralentissent le réchauffement climatique. Les « petits » volcans expulsent eux aussi dans la stratosphère des particules réfléchissant les rayons du soleil et ces travaux montrent que, par un effet de synergie totalement ignoré jusqu’à présent, l’ensemble de ces éruptions, bien que de faible intensité considérées isolément, ont provoqué une réduction d’ensoleillement considérable, de l’ordre de 7 % entre 2000 et 2009. Quant aux éruptions plus récentes, elles pourraient, selon ces recherches, être responsables de 15 % du décalage existant entre les températures attendues et celles enregistrées entre 1998 et 2012.

En mars 2015, une autre étude réalisée par des chercheurs du CNRS, de l'IRD, du CEA et de Météo‐France est parvenue, pour la première fois, à associer des simulations climatiques, des mesures océanographiques récentes et des informations historiques sur l’évolution climatique (Voir Nature). Ces recherches ont pu montrer que les particules émises lors d'éruptions volcaniques majeures refroidissent l'atmosphère par un effet "parasol", réfléchissant les rayons du soleil. Bien que ces particules volcaniques aient un effet atmosphérique direct relativement court, de l’ordre de deux à trois ans, elles modifient pendant plus de 20 ans la circulation océanique de l'Atlantique nord, qui relie courants de surface et courants profonds, et module le climat européen. Il s’en suit un ralentissement des courants océaniques locaux et une augmentation de la salinité des océans. Ce dernier phénomène vient perturber la vitesse des grands courants, qui influencent le climat. Selon Didier Swingedouw qui a dirigé cette étude, « Les volcans pourraient peser sur la moitié des variations du climat observées ».

En 2015, une équipe regroupant de chercheurs de l’Université de Genève et de l’Institut Laplace a réussi à développer un nouveau modèle informatique qui a pour la première fois calculé avec précision le refroidissement engendré par les deux plus grandes éruptions du dernier millénaire, les éruptions du Samalas et du Tambora, toutes deux survenues en Indonésie en 1257 et 1815 (Voir Nature).

Ce modèle intègre une multitude de paramétres, comme la localisation des volcans, la saison de l'éruption, la hauteur d'injection du dioxyde de soufre et il intègre un module microphysique capable de simuler le cycle de vie des aérosols volcaniques. Ce nouvel outil a permis de montrer que les éruptions de Tambora et du Samalas, en Indonésie, ont induit, à l'échelle de l'hémisphère nord, un refroidissement moyen de trois ans, oscillant entre 0,8 et 1,3°C pendant les étés 1258 et 1816.

Enfin il faut souligner que, si les volcans ont un effet bien plus important qu’on ne l’imaginait encore récemment sur le climat, il semble que l’inverse soit également vrai : selon une récente étude suisse de l’Université de Genève, le réchauffement climatique en cours agirait en effet sur le niveau d'activité magmatique et par conséquent sur les éruptions volcaniques.

En étudiant plus particulièrement l’évolution de la salinité de la Méditerranée à l’époque messinienne, il y a six millions d’années, ces chercheurs ont découvert que la diminution du poids causée par l'assèchement marin stimulait la production de magma. Selon Pietro Sternai qui a dirigé ces travaux, la fonte accélérée des glaces provoque un important transfert de charge des continents vers les océans, ce qui aurait pour effet d’augmenter sensiblement la production de magma sur les continents et de la diminuer dans les océans. Selon ce chercheur reconnu, la baisse de poids sur les continents pourrait avoir eu des conséquences sur des éruptions récentes de volcans tels que l'Eyjafjallajökull en Islande en 2010.

Quant aux outils et méthodes de prévisions des éruptions volcaniques, ils ont également effectué des pas de géants au cours de ces dernières années. En 2014, une équipe grenobloise de l'Institut des Sciences de la Terre a démontré qu’il était possible, en analysant le bruit sismique enregistré sur le Piton de la Fournaise lors de deux éruptions, d'utiliser l’analyse du bruit sismique pour la prévision des éruptions volcaniques.

En utilisant des capteurs extrêmement sensibles sur le Piton de la Fournaise (île de La Réunion) ces chercheurs sont parvenus à capter et à interpréter les modifications caractérisant les infimes vibrations provenant du cœur du volcan et porteuses d’informations précieuses sur le risque d’éruption, une semaine environ avant que celle-ci survienne, ce qui pourrait laisser le temps aux autorités d’organiser une évacuation en bon ordre des populations concernées.

Enfin, en juin dernier, une équipe de recherche de l’Institut des Sciences de la Terre (ISTerre) en France a annoncé une avancée majeure dans la prévision du comportement d’un volcan en utilisant l’assimilation de données, la même technique utilisée dans les prévisions météorologiques (Voir Frontiers in Earth Science). L’assimilation de données est un concept qui vise à combiner les outils de modélisation mathématique et informatique et la multitude de données de toute nature provenant du terrain. Il devient ainsi possible de reconstituer l’état de l’écoulement d’un fluide géophysique, comme le magma par exemple. Concrètement, les scientifiques utilisent des systèmes GPS et radar par satellite qui mesurent les mouvements du sol au cours de la phase d’inflation d’un volcan. En combinant ces données avec des équations mathématiques, par la méthode de l’assimilation de données, les chercheurs peuvent formuler des prévisions précises en temps réel.

Cet outil d’une grande efficacité devrait permettre d’ici quelques années de prévoir, avec une fiabilité beaucoup plus grande, les éruptions des volcans actifs proches des zones habitées. Le but étant évidemment de disposer du temps nécessaire à une bonne évacuation des populations menacées. Ces chercheurs se disent persuadés qu’un jour il sera possible d’établir des prévisions volcaniques quotidiennes, comme cela existe déjà pour les bulletins météo !

En attendant que ces nouveaux outils soient tout à fait opérationnels, il faut se réjouir des progrès déjà effectués par les systèmes de surveillance actuels, combinant observation satellitaire et capteurs sur le terrain. Grâce à ces dispositifs de plus fiables, les autorités indonésiennes ont pu notamment organiser l’évacuation de 150 000 personnes à Bali où le volcan du mont Agung, qui culmine à plus de 3.000 mètres d'altitude, montre des signes inquiétants de réveil depuis le mois d'août et pourrait entrer en éruption. Rappelons que la dernière éruption de ce volcan, en 1963, avait fait plus de 1 600 victimes.

On comprend mieux l’intérêt de parvenir à une prévision plus fiable et plus précoce des éruptions volcaniques quand on sait qu’il existe sur Terre plusieurs « supervolcans », comme celui de Yellowstone dans le Wyoming, aux Etats-Unis. Ce monstre américain est certes endormi depuis 70 000 ans mais sa dernière éruption massive, il y a 600 000 ans a été d’une violence tout simplement inimaginable et a expulsé, selon les spécialistes, 2 500 km3 de magma et de cendres dans l’atmosphère. Cette éruption véritablement cataclysmique a donc été 600 fois plus forte que celle du Mont St-Hélène, en Alaska, en 1980 et 15 fois plus violente que celle du Tambora, en 1815, pourtant considérée comme la plus importante du dernier millénaire…

Si le Yellowstone, qui possède le plus grand réservoir de magma au monde (il a été estimé en 2015 à 10 400 km3) connaissait demain une éruption similaire, les conséquences seraient incalculables et absolument dramatiques : toute vie serait détruite dans un rayon d’au moins 500 km autour du volcan et la moitié ouest des Etats-Unis serait dévastée par les énormes retombées de cendres expulsées. Le climat de la Terre connaîtrait un brusque refroidissement d’au moins 10 degrés pendant une bonne dizaine d’années et les rendements agricoles s’effondreraient, provoquant sans doute d’importantes famines dans de nombreuses régions du monde.

On le voit, l’étude et la compréhension des volcans ne relèvent pas seulement de la connaissance fondamentale de notre planète mais pourraient aussi nous permettre de limiter les conséquences désastreuses d’une éruption volcanique hors norme. Souhaitons que notre pays, qui dispose d’une recherche mondialement reconnue dans ce domaine complexe de la vulcanologie, poursuive ses efforts pour mieux comprendre, dans leur extrême diversité, les 1511 volcans aujourd’hui actifs dans le monde et mieux protéger les 500 millions de personnes qui vivent à proximité de ces « Portes de la Terre » qui, depuis l’aube des temps, ont fasciné les hommes.

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

Selon une étude de l’Université de Standford, parue en 2013, les quelque 500.000 data centers existants dans le monde consommeraient environ 30 milliards de Wh d’électricité par an, soit l’équivalent de la production de 30 centrales nucléaires.

Sur les disques durs actuels, le stockage de données se fait à l’aide d’une petite tête magnétique, qui parcourt le disque dur, un peu à la manière d’une aiguille de lecture sur un disque en vinyle. C’est le principe de l’aimantation (soit par commutation magnétique ou courants électriques à spin polarisé). Mais cela exige des courants électriques relativement élevés qui chauffent les matériaux et entraînent une importante perte d’énergie par dissipation de chaleur (effet Joule). On estime par exemple que 40 % de l’énergie des ordinateurs est perdue par dissipation de chaleur.

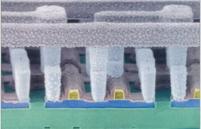

Des chercheurs du projet SPIN-PORICS, financé par l’UE, ont développé un nouveau matériau prometteur présentant des propriétés similaires à celles d’une éponge. Ce projet SPIN-PORICS (Merging Nanoporous Materials with Energy-Efficient Spintronics) a créé des prototypes de mémoires magnétiques nanoporeuses à partir d’alliages de cuivre et de nickel (CuNi).

L’équipe du projet a signalé avoir pu obtenir une réduction de la coercivité magnétique de 35 %, atteignant ainsi la consommation d’énergie nécessaire pour réorienter les domaines magnétiques et enregistrer ainsi les données. Selon le professeur Jordi Sort, coordinateur du projet, « ce nouveau concept peut contribuer à réduire l’énergie consommée par les ordinateurs, l’informatique et le traitement des données magnétiques en général. La mise en œuvre de ce matériau dans les mémoires d’ordinateurs et d’appareils mobiles peut présenter de nombreux avantages, principalement au niveau de l’économie d’énergie directe réalisée au niveau des ordinateurs et du gain d’autonomie des appareils mobiles. »

Article rédigé par Georges Simmonds pour RT Flash

Techniques de l'Ingénieur

|

|

|

|

|

|

|

|

|

Les avancées considérables réalisées dans le domaine de la robotique ces dernières années sont impressionnantes mais la généralisation des robots à tous les domaines d'activités dépendra en grande partie de leur capacité d'intégration à des environnements complexes. C’est sur cette problématique qu’une équipe de chercheurs du MIT, dirigée par l’ancien étudiant Yu Fan « Steven » Chen, s’est penchée en développant un petit robot autonome haut comme trois pommes mais bourré de technologie.

Son but : pouvoir simplement circuler entre les gens en assimilant la manière dont ils marchent pour ne pas les gêner. L’idée est de le rendre le plus discret possible, tout en lui permettant de respecter les subtils codes sociaux qui peuvent exister entre les personnes. Une mission réussie avec brio après une phase de test grandeur nature réalisée dans un bâtiment du MIT, le Ray and Maria Stata Center.

Comme le détaille l’article du site d’information du MIT, la conception de ce petit robot a posé quatre problèmes et défis techniques majeurs : la localisation, la perception, le contrôle et la planification de mouvement.

Les trois premiers domaines ont pu faire l’objet d’une solution facile, grâce à des technologies existantes. Une caméra RGB, des webcams, un capteur de profondeur et un laser LiDAR se chargent de la perception du petit robot, tandis que la localisation est permise par l’utilisation d’algorithmes open-source pour cartographier son environnement. Niveau contrôle, les avancées sur la conduite autonome ont pu servir, puisque ce sont les méthodes standard qui ont été utilisées pour rendre le petit appareil indépendant — une partie sur laquelle Ford, qui finance le projet, a sûrement pu apporter son expertise.

Pour la planification de mouvement, l’équipe du MIT en charge du projet a dû innover et développer sa propre solution afin d’anticiper les trajectoires des personnes partageant le même espace. « Nous voulons qu’il circule naturellement au milieu des gens et qu’il ne soit pas intrusif, » explique Michael Everett, co-auteur de l’étude. « Nous voulons qu’il suive les même règles que tout le monde ».

Pour cela, l’équipe a utilisé l’apprentissage par renforcement grâce à des simulations afin d’entraîner le robot à prendre différents chemins en fonction de la vitesse et la trajectoire des autres objets se déplaçant dans le même environnement. Différentes normes sociales (américaines) ont été ajoutées à cette phase d’entraînement, afin d’apprendre au robot a passer sur la droite plutôt que la gauche, par exemple.

À terme, ce genre de technologie pourrait être incorporé dans différents robots-travailleurs, comme des livreurs autonomes ou des appareils d’aide dans les hôpitaux ou les universités, afin qu’il épouse le contexte plutôt que de se faire remarquer.

Article rédigé par Georges Simmonds pour RT Flash

Numerama

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Mis en service le 1er septembre dernier, le « E-XFEL » pour European X-Ray Free Electron Laser (Laser à électrons libres et à rayons X européen), est désormais le plus grand laser à rayons X du monde.

Il est situé à 38 mètres de profondeur près de Hambourg en Allemagne dans un immense complexe de 3,4 km de long. Cet instrument développé par 300 chercheurs au sein du DESY (Deutsches-Elektronen-Synchrotron) a coûté 1,2 milliard d’euros et a été principalement financé par l’Allemagne, la Russie, et plus modestement d’autres pays européens, dont la France. Cette installation unique au monde prend la forme d'un tube de 1,7 km de long correspondant à l’accélérateur à électrons. Les électrons sont extraits de la matière par un premier laser optique puis, en sortie de tunnel, par un second laser.

Grâce à la longueur d’onde extrêmement petite des rayons émis, pouvant aller jusqu’à 0,05 nm, combinée à une vitesse d’obturation de l’ordre du milliardième de seconde, les chercheurs peuvent à présent obtenir des images d’une netteté jamais atteinte des atomes, et même de les voir en mouvement.

Cet outil technologique assez extraordinaire devrait permettre de filmer en temps réel des réactions biologiques et chimiques ultrarapides, ce qui permettra de mieux comprendre le fonctionnement des cellules, des enzymes et des protéines, et concevoir de nouveaux médicaments.

Article rédigé par Georges Simmonds pour RT Flash

E-XFEL

|

|

| ^ Haut |

|

|

|

|

|

|

|

Espace |

|

|

Espace et Cosmologie

|

|

|

|

|

|

|

|

|

|

Selon deux chercheurs français du MNRAS, Jean-Loup Bertaux, du Laboratoire atmosphères, milieux, observations spatiales (CNRS/UPMC/Univ. Versailles–Saint-Quentin-en-Yvelines), et Rosine Lallement, du laboratoire Galaxies, étoiles, physique et instrumentation (Observatoire de Paris/CNRS/Université Paris Diderot), la matière organique découverte massivement dans le noyau de la comète “Tchouri” par la sonde Rosetta n'aurait pas été fabriquée au moment de la formation du système solaire, mais auparavant, dans l'espace interstellaire.

Terminée en septembre 2016, la mission Rosetta de l’ESA a révélé que la matière organique représente près de 40 % de la masse du noyau de la comète « Tchouri » (67P Churyumov-Gerasimenko). Composée de molécules à base de carbone, d’hydrogène, d’azote et d’oxygène, elle constitue l’une des briques de base de la vie telle que nous la connaissons sur Terre.

Voilà 70 ans que l’analyse du spectre de la lumière des étoiles montre partout dans le milieu interstellaire des absorptions inconnues, à des longueurs d’ondes bien précises : les « Diffuse interstellar bands » (DIB), attribuées à des molécules organiques complexes, qui constitueraient « le plus grand réservoir connu de matière organique dans l’Univers » selon l’astrophysicien américain Theodore Snow.

Cette matière organique interstellaire est généralement proportionnelle à la matière interstellaire dans son ensemble, sauf dans le cas d’un nuage très dense, comme une nébuleuse proto-solaire : au cœur de la nébuleuse, où la matière est encore plus dense, les DIB plafonnent, voire diminuent.

C’est le signe que les molécules organiques qui provoquent les DIB disparaissent, par agglutination les unes aux autres. Une fois collées ensembles, elles ne peuvent plus absorber autant que lorsqu’elles flottent librement dans l’espace.

Ce type de nébuleuse primitive finit par former, par contraction, un système solaire comme le nôtre, composé de planètes… et de comètes. Or, on sait depuis la mission Rosetta que les noyaux de comètes se sont formés par accrétion hiérarchique dans la nébuleuse : les petits grains se sont collés les uns aux autres pour former des grains plus gros, lesquels se sont agglomérés à leur tour jusqu’à atteindre la taille d’un noyau de comète, de quelques kilomètres.

Les molécules organiques provoquant les DIBs et préexistantes dans les nébuleuses primitives n’ont donc probablement pas été détruites mais ont pu faire partie des grains constituant les noyaux cométaires, où elles sont toujours 4,6 milliards d’années plus tard.

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Aujourd'hui, on considère qu'un asthmatique sur six répond mal aux thérapies actuelles, à base de corticoïdes inhalés et bronchodilatateurs à action prolongée. Au cours de ces dernières années, une meilleure connaissance des mécanismes biologiques de l'inflammation des voies respiratoires a permis l'apparition des thérapies à base d'anticorps monoclonaux, comme l'omalizumab, déjà disponible ou le mépolizumab, le reslizumab ou le tralokinumab, en phase finale d'essais cliniques chez l'homme.

A l'occasion du dernier Congrès européen de pneumologie, une étude clinique réalisée en double aveugle contre placebo a confirmé, sur les formes d’asthme réfractaires, l'efficacité du tezepelumab, un anticorps monoclonal humanisé qui bloque l'action d'une cytokine.

Cet essai a notamment montré que le tezepelumab améliorait sensiblement la fonction pulmonaire et réduisait le niveau d'inflammation chez les participants. L'étude conclue que le tezepelumab constitue un agent immunomodulateur très prometteur dans le traitement de l'asthme persistant non contrôlé.

Article rédigé par Georges Simmonds pour RT Flash

NEJM

|

|

|

|

|

|

|

|

|

A l'occasion du congrès annuel de l'Association Européenne pour l'Etude du Diabète (EASD), qui vient de se terminer à Lisbonne au Portugal, trois études intéressantes ont été présentées et ouvrent de nouvelles perspectives dans le traitement et la prise en charge du diabète.

Tout d'abord, des chercheurs grecs de l’École Médicale Universitaire d'Athènes ont constaté que le fait de prendre 6 repas quotidiens au lieu des trois repas traditionnels (à apport calorique journalier égal) permettait aux personnes obèses présentant un diabète de type 2 de mieux contrôler leur taux de sucre sanguin.

Ces travaux montrent que le fait de fractionner son alimentation en six repas permet une diminution sensible du taux d'hémoglobine glyquée (marqueur de la glycémie), chez les diabétiques de type 2. Chez les prédiabétiques, cette règle des six repas permet par ailleurs de lisser les pics d'insuline chez les patients présentant une forte intolérance au glucose, en retardant le temps mis par le glucose pour atteindre son niveau maximal après l'ingestion de sucres. Cette étude montre également que cette règle des six repas permet aux patients d'arriver plus vite à satiété et de ne pas prendre de poids.

La seconde étude, réalisée par des chercheurs anglais, a porté sur 12.000 individus âgés de 30 à 65 ans. Elle montre que les sujets qui consomment le plus de lait (entier ou écrémé), présentent une meilleure répartition entre leur masse grasse et leur masse maigre (os, muscle ), ce qui réduit les risques de maladies métaboliques comme le diabète de type 2. De manière intéressante, ces travaux précisent que cet effet protecteur semble limité au lait et ne concerne pas les autres produits laitiers, comme le beurre, le fromage ou les yaourts.

Enfin, la dernière étude a été menée pendant onze ans auprès de 3.000 hommes et femmes diabétiques par des chercheurs de l'Université de Porto. Elle montre que les femmes diabétiques qui consomment le plus de caféine présentent un risque de mortalité plus faible que celles qui boivent peu ou pas de café.

Selon ces travaux, la consommation régulière d'une seule tasse de café par jour permettrait, chez ces patientes, une diminution de la mortalité toutes causes confondues (diabète, cancer et maladies cardiovasculaires) de 51 %...

Article rédigé par Georges Simmonds pour RT Flash

EASD

|

|

|

|

|

|

|

|

|

Des chercheurs de l'Institut interdisciplinaire des neurosciences (CNRS/Université de Bordeaux) et du Bordeaux Imaging Center (CNRS/Université de Bordeaux/Inserm) ont découvert un nouveau mécanisme permettant le stockage de l'information dans les synapses ainsi qu'un moyen de contrôler ce stockage.

On le sait, nos neurones communiquent entre eux par l'intermédiaire de plus d'un million de milliards de synapses, de toutes petites structures de la taille d'un dixième de cheveu, au fonctionnement extrêmement complexe. Le processus de plasticité synaptique, c'est-à-dire le fait que la synapse adapte son fonctionnement à l'activité neuronale, a été découvert il y a presque cinquante ans et a conduit la communauté scientifique à le proposer comme un élément fonctionnel primordial de la mémorisation et de l'apprentissage.

Les récepteurs de neurotransmetteurs –présents au niveau des synapses– jouent un rôle clé dans la diffusion des messages nerveux. Récemment, la même équipe avait découvert que les récepteurs de neurotransmetteurs n'étaient pas immobiles comme on le pensait, mais au contraire en agitation permanente. Ils avaient alors suggéré que le contrôle de cette agitation par l'activité neuronale pouvait être capable de moduler l'efficacité de la transmission synaptique en contrôlant le nombre de récepteurs présents à un instant donné dans une synapse.

Dans ces nouveaux travaux, deux équipes sont allées plus loin dans la compréhension des mécanismes de stockage de l'information dans le cerveau. Les chercheurs ont combiné des techniques de chimie, d'électrophysiologie et d'imagerie pour mettre au point une méthode inédite d'immobilisation des récepteurs au niveau des synapses.

Grâce à cette méthode, les mouvements des récepteurs sont stoppés, ce qui permet d'étudier l'impact de leur immobilisation sur l'activité cérébrale et les capacités d'apprentissage. Ils ont ainsi démontré que le mouvement des récepteurs était indispensable aux processus de plasticité synaptique en réponse à une activité neuronale intense.

Les chercheurs ont ensuite exploré le rôle direct de la plasticité des synapses dans l'apprentissage. En apprenant à des souris à reconnaître un environnement particulier, ils ont pu mettre en évidence que le gel du mouvement des récepteurs permettait de bloquer l'acquisition de cette forme de mémoire, démontrant ainsi l'implication de la plasticité synaptique dans ce processus.

Cette nouvelle découverte ouvre des perspectives pour le contrôle de la mémoire. Le protocole de mémorisation testé ici active une zone particulière du cerveau : l'hippocampe. Les chercheurs souhaitent maintenant déterminer si le mécanisme qu'ils ont découvert peut être généralisé à d'autres formes d'apprentissage et donc, à d'autres zones du cerveau.

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

|

|

|

|

|

|

|

Des chercheurs américains du Virginia Tech ont réussi à mettre en évidence certains des nombreux bénéfices médicaux et nutritionnels de l'oleuropéine, une molécule présente dans l'huile d'olive, tels que la perte de poids et la prévention du diabète de type 2.

Le diabète de type 2, touchant 92 % des diabétiques, est une maladie caractérisée par une concentration trop élevée de sucre dans le sang. L'insuline, une hormone, sert à faire baisser cette concentration. Dans un cas de diabète de type 2, elle n'est souvent plus produite en assez grande quantité, ou ne fait plus aussi bien effet, on parle alors d'insulinorésistance.

Ils ont découvert que l'oleuropéine boostait les cellules productrices d'insuline et bloquait une autre molécule, appelée amyline, formant des agrégats nocifs dans un diabète de type 2. De ces deux manières distinctes, l'oleuropéine aide à prévenir l'apparition de la maladie.

"Notre travail fournit de nouvelles connaissances sur une question de longue date, à savoir pourquoi les produits dérivés de l'olive peuvent être antidiabétiques", a déclaré Bin Xu, auteur principal de l'étude. Cette découverte pourrait permettre d'élaborer de nouveaux médicaments pour lutter contre le diabète de type 2 et l'obésité.

Article rédigé par Georges Simmonds pour RT Flash

Virginia Tech.

|

|

|

|

|

|

|

|

|

Selon l'essai PACIFIC, présenté à l'occasion du Congrès de la Société Européenne d’oncologie médicale (European Society for Medical Oncology, ESMO) 2017 à Madrid, un nouvel anticorps du type PD-L1, le durvalumab, améliore la survie sans progression chez les patients avec un cancer du poumon avancé de stade III non résécable.

Environ un tiers des patients diagnostiqués avec un cancer bronchique non à petites cellules (CBNPC) sont déjà à un stade III localement avancé. Le traitement standard – qui consiste en la combinaison d’une chimiothérapie à base de sels de platine et de radiothérapie – permet une survie sans progression d’environ 8 à 10 mois et seuls 15 % des patients sont toujours en vie à 5 ans. « Mais aucune avancée notable n’a eu lieu pour ce type de cancer au cours des dernières années » souligne le Docteur Luis Paz-Ares, oncologue médical qui a présenté cette étude.

Le durvalumab (AstraZeneca) est un anticorps monoclonal humain expérimental qui vise le ligand de la protéine de mort programmée 1 (PD-L1). L’expression du PD-L1 permet aux tumeurs d’éviter d’être détectées par le système immunitaire en se liant à la protéine PD-1 sur les lymphocytes T cytotoxiques.

En bloquant l’interaction du PD-L1 avec les protéines PD-1 et CD80 sur les lymphocytes T, le durvalumab contrecarre les tactiques de la tumeur visant à éluder le système immunitaire et de fait, booste celui-ci.

Le durvalumab est en cours d’expérimentation dans le cadre d’un vaste programme d’essais cliniques (en monothérapie ou en association avec le tremelimumab) portant sur le cancer bronchopulmonaire à grandes cellules, le cancer vésical, le cancer cervico-facial, le cancer de l'estomac, le cancer du pancréas, le CHC et les leucémies. Le durvalumab a reçu le 1er mai 2017 une autorisation accélérée de l’Agence américaine des produits alimentaires et médicamenteux (US Food and Drug Administration, FDA) comme traitement de deuxième intention du cancer urothélial (CU) localement avancé ou métastatique. Les premiers résultats de cet essai montre que le durvalumab a diminué le risque de progression de 48 %, ce qui est considéré comme très encourageant.

"Même s’il est nécessaire d’attendre plus longtemps pour vérifier l’effet sur la survie à long-terme, le durvalumab apparait, dès à présent, comme un médicament prometteur après chimioradiothérapie chez les patients avec un CBNPC de stade III non résécable" a conclu l’orateur.

Article rédigé par Georges Simmonds pour RT Flash

Esmo

|

|

|

|

|

|

|

|

|

Des chercheurs écossais de l’Université de Glasgow ont mis au point une nouvelle technique qui permet de développer, en laboratoire, des échantillons d'os minéralisés tridimensionnels adaptés aux besoins des chirurgies reconstructives, maxillo-faciales et orthopédiques.

La technologie avait été développée au départ pour détecter les ondes gravitationnelles, elle l’est aujourd’hui pour générer des greffes osseuses tissées pour la chirurgie de l’os. L'os est le deuxième tissu le plus greffé après le sang et « on en a besoin » dans les chirurgies reconstructives, maxillo-faciales et orthopédiques.

Aujourd’hui cependant, les chirurgiens ne peuvent récupérer que des quantités limitées d'os vivants du patient pour utilisation dans un greffon, les tissus osseux d'autres donneurs pouvant entraîner le rejet. De plus ces « dons osseux » ne comportent pas de cellules capables de régénérer l'os, ce qui limite la taille des réparations osseuses.

Mais grâce à la technique développée par ces chercheurs, et appelée le nanokicking, il devient possible de transformer les cellules mésenchymateuses en « amalgame » osseux en 3D. Ces greffes osseuses vivantes en 3D pourraient t d'ici quelques années réparer ou remplacer des sections d'os endommagées. Les cellules souches mésenchymateuses, naturellement produites par le corps humain dans la moelle osseuse, ont le potentiel de se différencier en toute une gamme de cellules spécialisées pour former des tissus tels que l'os, le cartilage, le ligament, le tendon et le muscle.

Le nanokicking soumet les cellules à des vibrations ultra-précises à l'échelle nanométrique alors qu'elles sont suspendues à l'intérieur de gels de collagène. Le processus de nanoculture transforme les cellules dans les gels en un « amalgame » osseux qui pourrait théoriquement être utilisé pour guérir des fractures osseuses et combler l'os là où il est lésé. L'utilisation de cellules mésenchymateuses propres aux patients (autologues) permettrait de plus d’éviter le problème du rejet.

Le Docteur Matthew Dalby, professeur d'ingénierie cellulaire à l'Université de Glasgow, co-auteur de l’étude, explique que l’usage du nanokicking constitue une avancée majeure pour certaines thérapies médicales. Selon l’auteur, le processus en est au stade où il est facilement reproductible et abordable.

Article rédigé par Georges Simmonds pour RT Flash

Uofgcce

|

|

|

|

|

|

|

|

|

Des chercheurs allemands (Jülich, Hambourg, Düsseldorf), en collaboration avec l'Université de Maastricht, ont élucidé la structure d'une fibrille amyloïde à une résolution jamais atteinte, de 4,0 angströms (0,4 nanomètre), soit l'échelle de l'atome.

Cette représentation en 3D obtenue par cryo-microscopie électronique (cryo-ME) révèle des détails de structure jusque-là inconnus, qui vont permettre de mieux comprendre le développement des dépôts pathologiques et l'influence des facteurs de risque génétiques. La cryo-ME, une nouvelle technologie, a permis de révéler comment les protéines amyloïdes bêta s'agencent en strates et en quinconce et en protofilaments.

Les protofilaments s'enroulent deux par deux pour former une fibrille et plusieurs fibrilles emmêlées forment les plaques amyloïdes. Ce travail montre pour la première fois la position exacte des protéines et leurs interactions. Les protofilaments emmêlés ne sont pas à la même hauteur et les molécules Abêta s'emboîtent comme une fermeture éclair. La structure révèle pour la première fois l'architecture des fibrilles amyloïdes bêta.

Cette nouvelle structure détaillée va permettre de mieux comprendre certaines variations génétiques associées à un risque augmenté de la maladie. Ces mutations stabilisent les fibrilles en changeant l'architecture de la protéine à différents endroits. Par exemple, ceci explique pourquoi deux mutations décrites en Islande portant sur la portion N terminale d'Ala2 modifient différemment le risque d'Alzheimer, l'une étant protectrice en déstabilisant la fibrille, l'autre pathogénique en en augmentant la stabilité.

Article rédigé par Georges Simmonds pour RT Flash

Science

|

|

|

|

|

|

|

|

|

Une vaste étude épidémiologique américaine a montré que, pour les patients souffrant d'un cancer du côlon à faible risque, une chimiothérapie courte serait tout aussi efficace, réduirait les effets secondaires du traitement et améliorerait leur qualité de vie.

Ces travaux, menés au Mayo Clinic Cancer Center à Rochester, au Minnesota (Etats-Unis), avaient pour objet de déterminer si un traitement chimiothérapique de trois mois était aussi efficace que s'il durait six mois chez les personnes atteintes d'un cancer du côlon de stade 3. Environ 400.000 nouveaux cas sont diagnostiqués chaque année dans le monde.

L'étude a révélé qu'un traitement de trois mois était presque aussi efficace et qu'il entraînait moins d'effets secondaires comme des lésions nerveuses. Aussi, celui-ci est susceptible de devenir un nouveau protocole de soins, en particulier chez les patients avec un faible risque de malignité.

Pour l'étude, les chercheurs ont analysé les données provenant de six essais cliniques incluant près de 13.000 malades en Amérique du Nord, en Europe et en Asie. Dans l'ensemble, 74,6 % des patients ayant bénéficié d'une thérapie de trois mois n'avaient plus de cancer trois ans après, contre 75,5 % chez ceux traités pendant six mois. On note, en outre, une très sensible diminution des effets indésirables chez les patients ayant bénéficié de la chimiothérapie la plus courte.

Article rédigé par Georges Simmonds pour RT Flash

ASCO

|

|

|

|

|

|

|

|

|

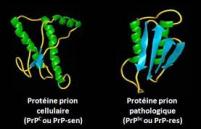

Pour la première fois, des chercheurs de l’Inra ont montré qu’une unité élémentaire, formée d’un trimère de protéines, est nécessaire et suffisante à la réplication des prions, redoutables agents pathogènes.

Responsables de maladies qui touchent notamment l’homme et les animaux d’élevage, les prions sont des particules protéiques infectieuses, dépourvues de matériel génétique. La protéine du prion existe sous deux formes, une forme normale, associée à des fonctions biologiques, et une forme mal repliée infectieuse, capable de recruter d’autres protéines en leur transmettant cette conformation aberrante. La protéine du prion, sous sa forme infectieuse, forme des assemblages de taille diverse.

Décrypter les modalités de la réplication et de la propagation des prions représente un challenge auquel se sont employés les chercheurs de l’Inra. Ils viennent de franchir une étape décisive, révélant l’existence, au sein des assemblages de prions, d’un déterminant structural élémentaire qui renferme les informations nécessaires et suffisantes à la réplication de ces agents pathogènes non conventionnels.

Explorant l’architecture des assemblages de prions, les scientifiques ont mis en évidence que ceux-ci sont composés d’unités élémentaires, suPrP, constituées d’un trimère de protéines. Communes à plusieurs souches, ces unités élémentaires constituent une caractéristique générique des prions et contiennent l’information nécessaire et suffisante à leur réplication.

Ces briques élémentaires sont extrêmement résistantes aux agents biochimiques habituellement capables de détruire les composés cellulaires protéiques. Plus encore, lorsque deux unités élémentaires sont liées, elles deviennent alors pathogènes. Les liaisons qui unissent ces deux unités élémentaires, de type hydrophobes, sont cependant très fragiles.

A la faveur de leurs expériences, les scientifiques de l’Inra suggèrent que, dans les conditions physiologiques, les assemblages de prions et les unités élémentaires sont en équilibre tel que les unités élémentaires puisse être libérées lorsqu’elles sont en faible quantité ou au contraire captées lorsqu’elles sont en excès. L’existence de cet équilibre permet donc à l’unité élémentaire de participer activement à la propagation du prion dans les cellules ou dans les tissus sur fond de dépolymérisation des assemblages de prion.

L’ensemble de ces résultats révèle, chez le prion, l’existence d’une brique élémentaire dont le réarrangement structural signe le caractère infectieux. Nécessaire et suffisante à la propagation du prion, au sein d’un tissu infecté, cette brique pourrait se révéler être une cible thérapeutique d’intérêt, ouvrant ainsi la porte à de possibles perspectives contre les maladies à prion qui restent à ce jour fatales pour l’homme et les animaux.

A court terme, la caractérisation de sa taille et de ses propriétés d’absorption devrait permettre aux industriels de santé de développer des techniques de rétention et de décontamination mieux adaptées et plus performantes.

Article rédigé par Georges Simmonds pour RT Flash

INRA

|

|

|

|

|

|

|

|

|

En France, le cancer du col de l'utérus est le 12ème cancer le plus répandu chez les femmes : il se développe en moyenne 10 à 15 ans après une infection par un papillomavirus. D'après les statistiques, chaque année, 2797 nouveaux cas sont diagnostiqués dans l'Hexagone et l'âge moyen au diagnostic est de 51 ans. Mais selon une nouvelle étude menée par l'Université américaine d'Alabama et publiée dans la revue spécialisée The Lancet, le Gardasil 9 serait efficace pour prévenir l'apparition de la maladie.

Ce nouveau vaccin contient cinq génotypes d'infections à papillomavirus humains de plus que la précédente version. Ceux-ci sont, à eux seuls, responsables de près de 20 % des cancers cervicaux et de 30 % des lésions précancéreuses du col de l'utérus. Pour en arriver à cette conclusion, les chercheurs américains ont travaillé avec 14 215 femmes dans 18 pays : la moitié des volontaires ont été vaccinées avec le Gardasil (c'est-à-dire l'ancienne version du vaccin) et l'autre moitié avec le Gardasil 9 (la nouvelle version du vaccin, donc). Verdict : les résultats ont montré une efficacité de 97,4 % dans le second groupe de test.

Selon les autorités sanitaires, le vaccin reste la meilleure protection contre le cancer du col de l'utérus, responsable de 274 000 décès dans le monde chaque année. Ainsi, depuis 2017, un rapport du Haut Conseil de la Santé Publique (HCSP) recommande de vacciner les jeunes filles avec le Gardasil 9 à deux doses entre 11 et 14 ans et à trois doses entre 15 et 19 ans

Article rédigé par Georges Simmonds pour RT Flash

CIDRAP

|

|

|

|

|

|

|

|

|

Une étude menée menées conjointement par l'American Institute for Cancer Research (AICR) et le World Cancer Research Fund (WCRF), a montré que la consommation quotidienne de céréales complètes, comme le riz et le pain complets, permet de réduire le risque de développer un cancer colorectal.

Ces recherches confirment d'autres travaux qui avaient déjà mis en lumière les bienfaits d'une alimentation riche en fibres pour se prémunir de cette maladie. Pour rédiger cette méta-analyse, l'équipe a passé en revue 99 études menées à travers le monde sur près de 29 millions de personnes.

Les chercheurs ont trouvé que la consommation quotidienne d'environ trois portions de céréales complètes, soit 90g, réduisait le risque de cancer colorectal de 17 %. Leurs résultats ont aussi montré que d'autres aspects d'une alimentation équilibrée pouvaient abaisser ce risque, mais les associations n'étaient pas aussi claires.

Ils ont noté les bienfaits du poisson et des aliments contenant de la vitamine C, comme les oranges, les fraises et les épinards, pour faire reculer les risques de développer un tel cancer. Leur analyse a aussi montré que l'activité physique pouvait avoir des effets protecteurs chez les sportifs en comparaison avec les personnes sédentaires.

L'équipe a souligné qu'il existait par ailleurs de nombreux facteurs aggravant le risque de ce cancer, comme la consommation régulière de viandes et charcuteries industrielles, le fait de manger du porc et du bœuf en grande quantité (plus de 500 grammes cuits par semaine), l'alcool (plus de deux verres d'alcool par jour), sans oublier le fait d'être obèse ou en surpoids.

Article rédigé par Georges Simmonds pour RT Flash

Consumer Reports

|

|

|

|

|

|

|

|

|

Il y a quelques semaines, une équipe de recherche américaine de l’Université de Californie du sud (USC) mettait en évidence, sur un même gène, un groupe de huit mutations génétiques communes aux troubles du spectre autistique et à la schizophrénie.

Cette fois, c'est une équipe de recherche en psychiatrie au CEA-Neurospin, avec l'Institut Mondor de Recherches Biomédicales (INSERM) et les hôpitaux universitaires Henri-Mondor, AP-HP, qui vient de montrer qu'un variant génétique associé à de multiples troubles psychiatriques altère un réseau préfronto-limbique, ce qui augmenterait le risque de développer la schizophrénie ou un trouble bipolaire.

Les chercheurs se sont focalisés sur une variation du gène SNAP25, impliquée dans la neurotransmission et associée à la schizophrénie, au trouble bipolaire mais également à l'hyperactivité/trouble de l'attention. Les chercheurs ont combiné une étude d'association génétique chez 461 patients atteints de schizophrénie, une construction génétique in vitro et une approche dite d'« imagerie génétique ».

Les résultats révèlent que la variation du gène SNAP25 change l'expression de la protéine associée dans le cerveau, ce qui impacterait le traitement de l'information entre les régions cérébrales impliquées dans la régulation des émotions. Cette hypothèse est confirmée par l'étude d'imagerie génétique, combinant IRM anatomique et fonctionnelle de repos ; celle-ci montre en effet que dans les deux cohortes, le variant à risque est associé à un plus grand volume d'une zone cérébrale, l'amygdale, et une connectivité fonctionnelle préfronto-limbique altérée.

Cette étude confirme l'existence d'un facteur de risque commun à la schizophrénie et au trouble bipolaire : la variation du gène SNAP25. Ces pathologies lourdes très fréquentes touchent chacune 1 % de la population adulte. Cette découverte, comme celle, connexe, des chercheurs californiens, confirme qu'il existe très probablement des mutations et mécanismes génétiques communs aux principales pathologies psychiatriques.

Article rédigé par Georges Simmonds pour RT Flash

Journal des neurosciences

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|