|

|

|

|

|

| NUMERO 917 |

|

|

|

|

|

|

|

Edition du 06 Octobre 2017

|

|

|

|

|

Edito

Vers un carburant solaire à base de CO2 !

Publiée le 18 septembre dernier dans la très sérieuse revue « Geosciences », sous le titre, « Le budget-carbone et la trajectoire pour limiter le réchauffement climatique mondial à 1,5 degré », une étude internationale mérite toute notre attention. Selon ces travaux dirigés notamment par les professeurs Richard Millar (Université d’Oxford), Jan S. Fuglestvedt (Centre international de recherche sur le Climat et l’Environnement d’Oslo) et Michael Grubb, du collège Universitaire de Londres, il est encore possible de limiter la hausse de la température mondiale à 1,5°C, comme le préconise les accords de Paris (Voir étude).

Toutefois, si cette équipe internationale souligne qu’il est encore possible d’atteindre cet objectif d’une limitation de la hausse des températures à 1,5°C, elle ajoute immédiatement qu’il faudra, pour y parvenir, réduire nos émissions de CO2 à un rythme sensiblement plus important que celui envisagé par les Accords de Paris.

L’étude rappelle que, depuis l'ère préindustrielle, la température moyenne de la Terre a déjà gagné 0,94°C. Selon ces travaux, le « budget-carbone » total de l’Humanité à ne pas dépasser pour rester dans les limites de ce degré et demi de réchauffement global serait un peu plus important que prévu, de l’ordre de 880 gigatonnes de CO2 à partir de 2015. Pour Richard Millar, chercheur à l'Université d'Oxford et principal auteur de cette étude, « Limiter les émissions de CO2 en deçà de 880 gigatonnes à partir de 2015, soit l’équivalent de 20 années d'émissions de CO2 au niveau actuel, permettrait probablement d'atteindre l'objectif de Paris de limiter le réchauffement à 1,5°C ».

Reste que pour décarboner massivement l’économie mondiale, et notamment la production d’énergie (qui reposera encore aux deux tiers sur les énergies fossiles en 2040 d’après de récentes études prospectives), la montée en puissance des énergies renouvelables et le doublement prévu de l’efficacité énergétique ne suffiront pas. Il va falloir également mettre en œuvre à une échelle industrielle de puissants moyens de capture et stockage du CO2 (CSC), cette capture se faisant à la source dans un premier temps, avant d’être complétée par des technologies encore expérimentales qui devraient permettre d’extraire d’ici quelques années le CO² directement de l’atmosphère.

Le projet de recherche Gassnova en Norvège a récemment montré que, contrairement aux idées reçues, la capture et le stockage du CO2 pouvaient être économiquement viables. Ce projet vise à capturer le CO2 émis par une cimenterie, un site d’incinération de déchets et une usine de production d’engrais et à le transporter par bateau vers la côte sud de l’Angleterre où il doit être enfoui sous les fonds marins à partir de 2020.

Mais ce CO2 récupéré dans l’air, grâce à différentes technologies complémentaires ne pourrait-il pas, au lieu d’être exclusivement voué à être enfoui sous terre ou sous la mer, être recyclé, transformé et finalement réutilisé pour produire des substances chimiques à forte valeur ajoutée, et pourquoi pas des carburants, qui deviendraient alors « neutres » dans le bilan-carbone, puisqu’ils seraient issus du CO2 qu’ils ont eux-mêmes émis lors de leur utilisation.

Depuis une dizaine d’années, plusieurs équipes de recherche de par le monde travaillent sur cette idée qui ne cesse de progresser. Depuis 2005, le Professeur Jacob Karni de l’Institut Weizmann à Rehovot travaille ainsi à mettre au point un procédé qui permet de transformer le CO2 en « syngas » ou gaz synthétique.

Cette technologie, en cours d’industrialisation par la société NewCO2Fuel, consiste à injecter à haute température (900 degrés) de l’eau et du CO2 à travers une membrane, alimentée par un courant électrique. Ce processus transforme alors le CO2 en syngas (gaz synthétique constitué de carbone et d’hydrogène) qui peut être utilisé pour obtenir du gas-oil synthétique ou produire de l’électricité.

La beauté de ce procédé à présent bien maîtrisé et qui devrait être industrialisé dès l’année prochaine, est qu’il est autosuffisant en énergie. Il permet en effet de transformer le CO2 et l’eau en combustible, en n’utilisant que l’énergie perdue par l’usine et de l’énergie solaire.

En France, l’équipe de Gilles Flamant (CNRS), travaillant sur le site du four solaire d’Odeillo, a montré en 2008 qu’il était possible de produire, grâce à l’énergie solaire concentrée, du dioxyde de carbone et hydrogène d’une part, monoxyde de carbone et hydrogène de l’autre, aptes à être transformés en hydrocarbures à longue chaîne de molécules, utilisables dans les moteurs actuels. Même si, pour l’instant, la production de cet « hydrogène solaire » a un coût plus élevé que celui de la filière traditionnelle, la baisse continue des prix des concentrateurs pourrait le rendre compétitif d’ici 5 ans.

En Allemagne, les chercheurs d’Audi, en collaboration avec Sunfire, spécialiste de la fabrication de fil à combustible, ont mis au point en 2015 un procédé qui permet d’obtenir de l’e-diesel et ne nécessite comme matières premières de base que de l’eau et du dioxyde de carbone. Cette technologie allemande utilise de l’électricité exclusivement issue d’énergies renouvelables – éolien, solaire, ou hydroélectrique – pour produire de l’hydrogène (H2) par électrolyse à haute température (800°C) L’hydrogène est ensuite mélangé avec du dioxyde de carbone (CO2) fourni par une unité de production de biogaz. Ce mélange de dioxyde de carbone et d’hydrogène est ensuite utilisé pour obtenir du monoxyde de carbone (CO), de l’hydrogène et de l’eau, éléments qui permettent la production d’un pétrole de synthèse qui n’a plus qu’à être raffiné pour devenir un e-diesel d’excellente qualité, tout à fait compatible avec les moteurs actuels.

Fin 2016, des chercheurs américains de l’Oak Ridge National Laboratory (ORNL), dirigés par le chimiste Daniel Nocera, ont pour leur part découvert une réaction électrochimique prometteuse qui permet de convertir avec un rendement de l’ordre de 60 % du dioxyde de carbone (CO2) en éthanol. La clé de cet étonnant processus qui s’amorce à l’aide d’une tension de seulement 1,2 V réside dans un nouveau catalyseur constitué de nanoparticules de cuivre incrustées dans des pics de carbone. Ce procédé simple et peu coûteux pourrait être utilisé à grande échelle dans les centrales productrices d’énergie utilisant des combustibles fossiles et pourrait également devenir un remarquable outil de stockage massif de l’énergie, en transformant une partie des pics de production issue des énergies solaires et éoliennes en éthanol.

En juillet 2016, des chercheurs de l'Institut Paul Scherrer PSI et de l'ETH Zurich ont pour leur part présenté un processus chimique permettant d'utiliser l'énergie thermique du soleil pour produire directement des carburants hautement énergétiques – méthane, essence et le diesel - qui peuvent être utilisés directement, mais aussi stockés dans des réservoirs ou être injectés dans le réseau gazier. Ce procédé repose sur l’utilisation d’une combinaison de matériaux, à base d'oxyde de cérium et de rhodium. Il permet donc de stocker l'énergie solaire sous forme chimique, sans avoir recours au procédé Fischer-Tropsch, lourd et complexe, ce qui constitue une rupture technologique majeure.

Enfin, il y a quelques semaines, une équipe de chercheurs du Laboratoire d’électrochimie moléculaire (Université Paris Diderot/CNRS), dirigée par Marc Robert et Julien Bonin, a présenté un procédé capable de transformer le dioxyde de carbone en méthane, directement utilisable pour des applications de chauffage ou de transport, à l’aide de lumière solaire et d’un catalyseur moléculaire à base de fer. Ces résultats ouvrent une nouvelle voie vers la production de «carburant solaire» et le recyclage du CO2 (Voir CNRS).

Techniquement, ce procédé consiste à remplacer les atomes d’oxygène du dioxyde de carbone par des atomes d’hydrogène. Ce résultat est obtenu en ajoutant de petites quantités d’alcool afin d’apporter les protons nécessaires. Mais pour déclencher cette réaction, il est bien entendu nécessaire de disposer d’une source d’énergie suffisante. Il s’agit dans ce cas du rayonnement solaire produit par un simulateur solaire et un filtre qui sélectionne des longueurs d’ondes supérieures à 400 nm.

Cette avancée technologique est d’autant plus remarquable que, contrairement à la quasi-totalité des catalyseurs connus, qui utilisent des métaux rares et précieux, les deux chercheurs ont développé un catalyseur à base de fer, un métal abondant, accessible et peu coûteux. Certes, d’autres catalyseurs à base de fer avaient déjà été expérimentés mais aucun n’avait permis d’aller au-delà du monoxyde de carbone et de produire in fine du méthane. L’originalité de ce catalyseur mis au point par ces chercheurs du CNRS réside dans le fait qu’il possède des propriétés s’inspirant de celle des porphyrines, des molécules transportant le dioxyde dans le sang.

En outre, ce processus fonctionne à pression et température ambiantes et n’a besoin que du soleil comme seule source d’énergie. Cette belle découverte française démontre donc qu’il est possible de stocker l’énergie solaire renouvelable en différents types de composés et carburants compatibles avec les infrastructures industrielles et les réseaux d’énergie existants.

Concrètement, il devient possible d’obtenir à l’aide de ce procédé de l’acide formique (H-COOH), un composé qui pourrait entrer dans le fonctionnement des piles à combustible des voitures du futur et présente moins de risques que l’hydrogène pur, particulièrement inflammable. Cette technique permet également d’obtenir du méthanol (CH3OH), un autre composé alcoolique indispensable à l’industrie chimique et aéronautique. Comme le souligne Marc Robert, « grâce à notre découverte, le CO2 peut enfin rentrer dans le cycle vertueux de l’économie circulaire car il est transformé en carburant, et au cours de la combustion, celui-ci libère du CO2 qui peut être à nouveau transformé en méthane ».

On comprend mieux l’engouement pour ces carburants de synthèse quand on sait que, selon une récente étude réalisée par l’équipementier Bosch, l’essor de ce type de carburant conjugué à l’électrification du parc automobile, pourrait permettre une économie de 2,8 gigatonnes de CO2 entre 2025 et 2050. Toujours selon cette étude, les carburants de synthèse pourraient représenter 40 % du total des carburants en 2040 et 100 % vers 2050.

Face à cet enjeu majeur, tant sur le plan technologique industriel et environnement que représente la production massive et propre de carburants de synthèse neutres en carbone, notre pays, qui a la chance de disposer à la fois d’une recherche scientifique de niveau mondial et d’une industrie pétrochimique particulièrement performante, doit sans tarder lancer un grand programme de recherche fédérant les compétences et les moyens publics et privés pour devenir leader mondial dans cette course technologique vers les carburants propres.

Parallèlement, l’État doit faire preuve dans ce domaine d’un grand volontarisme politique et fixer une feuille de route précise visant à mettre fin le plus rapidement possible à l’exploitation et à l’utilisation du pétrole naturel et de ses dérivés et à leur substituer ces composés et carburants du futur, qui sont appelés à devenir, dans le cadre d’une économie globale de capture, de récupération et de valorisation du CO2, l’un des leviers indispensables pour diminuer drastiquement nos émissions de CO2 et lutter contre le changement climatique dont les effets dévastateurs, comme nous avons pu le voir au cours de ces dernières semaines avec une succession de tempêtes et d’ouragans tropicaux d’une violence sans précédent, se manifestent à présent clairement et ne feront que s’intensifier si nous ne mobilisons pas toutes nos forces pour conserver une planète vivable.

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

Philips a mis au point une technologie très innovante qui vise à empêcher le piratage des films en salle, à l'aide de caméras. La technologie anti-piratage présentée par Philips s'inspire du procédé Ambilight, qui génère un halo lumineux d'ambiance sur certains téléviseurs du constructeur.

Le procédé consiste à envoyer sur l’écran une lumière avec une modulation de fréquence spécifique, différente de la fréquence d’affichage du film, qui va engendrer un problème de synchronisation si l’écran est filmé par un caméscope, un smartphone ou une tablette. La vidéo résultante est ainsi perturbée par des bandes parasites qui défilent sur l'écran lors de l'affichage.

L’invention de Philips est conçue pour que la source de lumière ne perturbe pas les spectateurs avec un changement de la couleur et de l’intensité en fonction du contenu du film. Par exemple, l’intensité baisse quand l’image est sombre et la couleur passe au bleu si l’image à une dominante bleue. Cela implique donc que le programme qui gère la source de lumière parasite soit conçu en fonction de chaque film ou qu’un système analyse en temps réel l’image pour choisir la teinte et l'intensité de la lumière.

L'industrie mondiale du cinéma, les distributeurs, les salles de cinémas, les magasins de vidéos et les opérateurs de pay-per-view, perdent chaque année des milliards de dollars à cause du piratage.

Article rédigé par Georges Simmonds pour RT Flash

01net

|

|

| ^ Haut |

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

Une équipe de chercheurs de l’Université libre de Bruxelles a réussi a développer une main robotisée ayant des capacités auto-régénérantes. Pour obtenir ce résultat, ils ont développé un polymère pouvant soigner lui-même les blessures microscopiques, en utilisant la réaction dite de Diels-Alder.

Le polymère qu’ils ont créé est constitué de réseaux covalents thermoréversibles. Ainsi, ce polymère est auto-cicatrisant en cas de liaisons par percement, déchirement ou coups portés sur le polymère. Il suffit simplement d'un peu de chaleur pour qu'il se répare de lui-même...

Les chercheurs ont créé trois robots mous qu’ils ont recouvert de ce polymère : une pince souple, une main souple et des muscles artificiels. La capacité régénérante de ces robots est essentielle puisque, s'il est plus sécurisé pour un humain d'interagir avec un robot mou, son principal défaut est qu'il peut être facilement endommagé. Avec cette découverte, les chercheurs de l'Université libre de Bruxelles apportent une innovation essentielle dans le développement de la robotique molle.

Article rédigé par Georges Simmonds pour RT Flash

ULB

|

|

|

|

|

|

|

|

|

Des scientifiques de l’EPFL ont créé le premier robot fonctionnel entièrement activé par vide d’air : composé de pièces souples, il bouge lorsque l’air est aspiré hors de celles-ci. L’assemblage des pièces peut être reconfiguré pour accomplir différentes tâches, comme par exemple grimper aux murs ou encore saisir des objets.

À la manière de contractions musculaires, les composants souples du robot peuvent être activés en y créant une dépression (vide d’air). Et c’est par succion que le robot arrive à saisir des objets, ou encore à adhérer à une paroi verticale et y grimper.

L’utilisation du vide d’air fait de ce robot un outil modulaire d’une grande souplesse, pouvant être configuré pour des tâches différentes, et avec des applications possibles en recherche et dans le domaine industriel. Les composants souples à aspiration sont une apparition récente dans le monde de la robotique.

Contrairement aux systèmes pneumatiques plus répandus qui fonctionnent par injection d’air comprimé, qui nécessitent des composants rigides pour hautes pressions, et qui peuvent poser des risques d’explosion en situation extrême, les robots à aspiration sont souples, moins dangereux, et de construction plus simple.

Article rédigé par Georges Simmonds pour RT Flash

EPFL

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Une équipe française du CNRS a découvert une enzyme qui permet aux microalgues de transformer certains de leurs acides gras en hydrocarbures à l’aide de l’énergie lumineuse. Cette enzyme, qui a été baptisée FAP (pour Fatty Acid Photodecarboxylase), est d’un type très rare car seules quatre enzymes utilisant la lumière ont été identifiées jusqu’à présent dans le monde vivant.

Cette découverte, publiée dans la prestigieuse revue "Science", est d’autant plus importante que, dans un contexte de transition énergétique, la production d’hydrocarbures, utilisant le CO2 atmosphérique et limitant donc le rejet dans l’atmosphère de carbone stocké dans le sous-sol, est devenue un enjeu majeur.

La chlorelle est une algue verte unicellulaire d'eau douce faisant partie des quelques microalgues cultivées industriellement et candidates pour la production de molécules carbonées riches en énergie. Des chercheurs du CEA, du CNRS, de l’ESRF, de l’Inserm, et des Universités Aix-Marseille, Grenoble Alpes et Paris-Sud ont découvert chez cette microalgue une enzyme qui lui permet de transformer certains de ses acides gras en hydrocarbures à l’aide de la seule énergie lumineuse. « C’est une avancée majeure dans l’identification de mécanismes du vivant permettant la conversion des acides gras des cellules en hydrocarbures et cela ouvre une nouvelle voie en vue de la synthèse d’hydrocarbures par des micro-organismes à une échelle industrielle », précisent les auteurs.

L’expression dans la bactérie E. coli du gène codant pour la principale de ces enzymes candidates a mis en évidence la production d’hydrocarbures, démontrant que cette enzyme était nécessaire et suffisante pour synthétiser des hydrocarbures. La caractérisation de l’enzyme pure a révélé qu’elle était capable de couper un acide gras en une molécule d’hydrocarbure et une molécule de CO2 et que cette activité nécessitait de la lumière.

La découverte de cette enzyme baptisée FAP (acronyme anglais pour acide gras photo-décarboxylase) revêt un grand intérêt d’un point de vue fondamental car à ce jour, seulement quatre biocatalyseurs capables d’utiliser l’énergie lumineuse (photoenzymes) ont été découverts.

La FAP est au moins dix fois plus rapide que la meilleure enzyme de synthèse d’hydrocarbures connue et utilise la lumière, ce qui pourrait en faire un outil biotechnologique très efficace pour la synthèse d’hydrocarbures, soit par conversion in vitro d’huiles, soit par conversion in vivo des acides gras de bactéries, levures ou microalgues.

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

|

|

|

|

|

|

|

Découverte en 1839, la pile à combustible convertit l'énergie chimique de combustion de l'hydrogène en énergie électrique. Dans ce processus, aucun gaz à effet de serre n'est produit mais la pile à combustible utilise néanmoins comme catalyseurs des métaux rares et coûteux, tel le platine, pour l'oxydation de l'hydrogène et la réduction de l'oxygène.

Ces dernières années, l'identification de biocatalyseurs, des enzymes aux propriétés remarquables, a relancé très activement la recherche : leur activité de transformation de l'oxygène, mais surtout de l'hydrogène, est comparable à celle du platine. L'activité des hydrogénases était, jusqu'à récemment, inhibée par l'oxygène et donc incompatible avec une utilisation en pile.

Depuis plusieurs années, des chercheurs du laboratoire de Bioénergétique et ingénierie des protéines (CNRS/Aix-Marseille Université) développent une nouvelle génération de biopiles. Ils ont remplacé le catalyseur chimique (le platine) par des enzymes bactériennes : à l'anode, l'hydrogénase (clé de conversion de l'hydrogène dans de nombreux microorganismes), et la bilirubine oxydase à la cathode.

Ils ont donc identifié une hydrogénase active en présence d'oxygène et résistante à certains inhibiteurs du platine comme le monoxyde de carbone. En collaboration avec le Centre de recherche Paul Pascal (CNRS/Université de Bordeaux), ils ont aussi exploré la biodiversité pour identifier des enzymes thermostables qui résistent à des températures entre 25° et 80°.

En incorporant progressivement les deux enzymes thermostables dans une architecture carbonée, les chercheurs ont apporté une solution au problème de protection des enzymes contre des espèces chimiques générées lors de la réduction de l'oxygène et qui altèrent l'activité des enzymes. La pile peut ainsi fonctionner sans perte de performance pendant plusieurs jours.

Grâce à cette architecture contrôlée et aux propriétés intrinsèques des enzymes, les chercheurs sont parvenus pour la première fois à quantifier la proportion d'enzymes participant effectivement au courant, mettant en évidence que les courants délivrés par le biocatalyseur sont très proches des objectifs attendus pour le platine.

Ils ont de plus établi un modèle numérique permettant de déterminer la géométrie optimale de la pile. Ces biopiles apparaissent ainsi comme une alternative aux piles à combustibles classiques : la biomasse peut être utilisée à la fois pour fournir le combustible (l'hydrogène) mais également le catalyseur (les enzymes), par nature renouvelable.

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Pour faire face au changement climatique et à ses conséquences sur la productivité des cultures, des chercheurs de l’Inra Occitanie-Toulouse et Nouvelle Aquitaine-Bordeaux ainsi que du CIRAD ont cherché à définir ce que seraient des systèmes de culture « climato-intelligents », c’est-à-dire pouvant atténuer cette menace et s’y adapter. Pour les trois chercheurs, des systèmes de culture climato-intelligents doivent combiner réduction des émissions de gaz à effet de serre, adaptation au changement climatique et sécurisation de la production alimentaire.

Le protoxyde d’azote et le méthane sont les principaux gaz à effet de serre émis par les cultures. D’après cette étude, la manière la plus évidente de limiter l’émission de protoxyde d’azote (N2O) est de réduire l’utilisation d’engrais azotés. Le maintien des rendements passe alors par une utilisation plus juste des quantités nécessaires, la valorisation de produits organiques comme les résidus de culture ou le fractionnement des applications dans le temps.

Les effets en terme de diminution des émissions seraient multipliés puisque la production d’engrais est très consommatrice d’énergie. Une autre option identifiée est l’introduction de légumineuses dans les systèmes de cultures car celles-ci permettent de fixer l’azote atmosphérique et donc de s’affranchir des engrais azotés.

Pour ce qui est du méthane, la principale activité émettrice est la riziculture. La gestion de l’eau y est primordiale : au lieu d’une submersion continue, l’assèchement des rizières à mi-saison ou l’irrigation par intermittence réduirait notoirement les émissions. Pour ce qui est du stockage de carbone, plusieurs mesures favorables ont été évaluées, le non-labour étant la plus connue.

Comme pour toutes les options, les auteurs rappellent que c’est l’ensemble des émissions de gaz à effet de serre qui doivent être prises en compte car le non-labour peut entraîner une plus grande émission de protoxyde d’azote. D’autres moyens pourraient être employés pour stocker davantage de carbone dans la biomasse ou le sol sans pénaliser les rendements : par exemple, l’utilisation de plantes de couverture, la plantation de haies ou l’agroforesterie.

Faire face au changement climatique c’est aussi se préparer à s’y adapter. D’après les auteurs de cette publication, le décalage des dates de semis pour tenir compte des changements de périodes de croissance et de récolte est la technique la plus simple et la moins chère à court terme. La diversification des cultures employées dans la rotation permettrait quant à elle d’augmenter la résilience des exploitations face aux accidents climatiques.

Pour maintenir les rendements, on pourrait logiquement opter pour une irrigation accrue mais une disponibilité en eau plus incertaine et les tensions sur son usage pourraient limiter l’accès à cette ressource. A plus long terme, la sélection de variétés mieux adaptées aux contraintes hydriques et thermiques serait la solution à privilégier.

Article rédigé par Georges Simmonds pour RT Flash

INRA

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Selon une vaste étude épidémiologique canadienne, dirigée par Mahshid Dehghan, de l'Université d'Hamilton (Canada) et présentée dans le cadre du dernier congrès de la Société européenne de cardiologie de Barcelone, un régime pauvre en lipides ne serait pas forcement bénéfique pour la santé et la consommation excessive de sucres augmenterait sensiblement la mortalité globale.

Leur étude (baptisée PURE, pour Prospective Urban Rural Epidemiological) a inclus plus de 135 000 personnes dans 18 pays sur les 5 continents, ayant des niveaux socio-économiques variés. Leurs habitudes alimentaires ont été enregistrées grâce à des questionnaires pendant plus de sept ans, en moyenne.

Premier constat : l'Asie du Sud-Est est la région du monde où la consommation de matières grasses est la plus élevée, suivie de près par l'Europe et l'Amérique du Nord et par le Moyen-Orient. Arrivent en fin l'Afrique et la Chine. Mais après avoir réparti les participants en 5 groupes en fonction de leur niveau de consommation de graisses, les chercheurs ont observé que ceux qui en consomment le moins ont une mortalité plus élevée. A contrario, le groupe des gros consommateurs de graisse a un risque de mortalité prématurée diminué de près d'un quart (23 %) par rapport aux plus petits.

Mais cette étude remet également en question une autre idée reçue et montre que les graisses saturées (présentes dans le beurre, le fromage, la charcuterie) sont associées à une baisse du risque de mortalité, certes moins marquée que les insaturées (graisses végétales et de poissons), mais tout de même significative.

« Si elles ont un effet sur la mortalité totale, les matières grasses, quelles qu'elles soient, n'influencent pas significativement le risque d'événement cardiovasculaire majeur ni la mortalité cardiovasculaire », ajoute Mahshid Dehghan. À l'opposé, les plus gros consommateurs de sucres ont une mortalité globale supérieure de 28 % à celle des consommateurs les plus modérés…

Cette étude recommande de revoir les recommandations actuelles, visant à limiter la consommation de lipides (pas plus de 30 % de l'apport calorique venant de matières grasses et pas plus de 10 % venant des graisses saturées) et Mahshid Dehghan estime même que, si l'on remplaçait 5 % de l'apport calorique venant des glucides par des acides gras polyinsaturés, on diminuerait la mortalité d'environ 12 %...

Article rédigé par Georges Simmonds

The Lancet

|

|

|

|

|

|

|

|

|

On le sait, le phénomène inquiétant de résistance croissante de certaines bactéries aux antibiotiques est considérée par l'OMS comme "l’une des plus graves menaces pesant sur la santé mondiale". C'est pourquoi la découverte de chercheurs italiens dirigés par la Professeure Maffioli est porteuse de grands espoirs.

Ces scientifiques viennent en effet de découvrir un nouvel antibiotique appelé pseudouridimycine (PUM). Contrairement à celles trouvées ces dernières décennies, cette molécule naturelle peut tuer une large gamme de bactéries et plus particulièrement celles dites à Gram négatif.

En France, ces dernières sont responsables de plus de 80 % des décès par infection à l’hôpital. Parmi elles, on compte des espèces comme Escherichia coli et Klebsiella pneumoniae, ainsi que le gonocoque, à l’origine d’une maladie sexuellement transmissible.

Ce nouvel antibiotique possède en outre un mécanisme d'action qui limite considérablement le risque d'apparition rapide d'une résistance de la part des bactéries visées. Il bloque en effet une enzyme commune à toutes les bactéries (la polymérase d’ARN), indispensable pour que celles-ci puissent produire des protéines.

Ce nouveau type d’inhibition ouvre la voie au développement de produits encore plus puissants, dont l’action pourra être combinée avec les autres classes d’antibiotiques existantes. Cette approche paraît d’autant plus prometteuse aux chercheurs que la PUM appartient à la même famille de molécules que les médicaments les plus efficaces connus contre les virus du sida et de l’hépatite C, à savoir des analogues de nucléosides utilisés pour la synthèse des acides nucléiques.

Première preuve d’efficacité in vivo de la PUM : elle a permis de guérir des souris infectées par la bactérie Streptococcus pyogenes pour mimer une péritonite aiguë mortelle, sans présenter de toxicité apparente. "Notre objectif dans les trois ans est maintenant de trouver des produits dérivés de la PUM encore plus efficaces et plus stables", précise Richard H. Ebright, à la tête des chercheurs américains.

Article rédigé par Georges Simmonds pour RT Flash

Cell

|

|

|

|

|

|

|

|

|

Selon une étude anglaise, l’augmentation du risque de démence en cas de parodontite serait de 7 % et perdurerait durant une dizaine d’années ou plus, à l’âge mûr…

La maladie des gencives désigne un certain nombre de conditions qui affectent les gencives dont la gingivite, qui peut provoquer des saignements des gencives, ou la parodontite qui entraîne des dommages importants aux gencives et aux os, avec pour effet une perte dentaire.

Une précédente étude du King’s College de Londres avait déjà montré qu’en cas de démence pré-existante, la maladie des gencives est bien associée à une aggravation des symptômes cognitifs, chez des personnes atteintes a minima de déficience cognitive.

Cependant, le préalable, dans cette précédente étude, à ce lien entre maladie des gencives et aggravation des symptômes de la démence, était que ses participants avaient déjà été diagnostiqués avec une forme de déclin cognitif ou de démence. Cette nouvelle étude révèle que les personnes atteintes de parodontite sur une durée minimum de 10 ans présentent un risque accru de 70 % de développer une forme de démence.

Article rédigé par Georges Simmonds pour RT Flash

Santé Blog

|

|

|

|

|

|

|

|

|

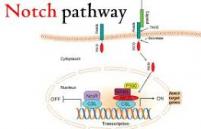

Cellestia Biotech, une jeune pousse issue de l’EPFL (Ecole Polytechnique Fédérale de Lausanne), va commencer les essais d'une molécule destinée à traiter les cancers liés à des mutations du gène Notch. Ce traitement, administrable par voie orale, est le premier à agir en bloquant le problème à son origine, c’est-à-dire dans le noyau de la cellule. Il inhibe la protéine qui favorise la multiplication des cellules cancéreuses, afin qu’un signal ne puisse être transmis.

En effet, une des alternatives aux chimiothérapies aujourd’hui investiguée par les spécialistes est la cascade de signaux générés par des protéines depuis le noyau des cellules. Dans son état normal, le gène Notch est essentiel lors du développement embryonnaire, ainsi que dans la formation et l’entretien des cellules souches.

Dans sa version délétère, la voie de signalisation défectueuse qu’il engendre favorise le développement de cellules cancéreuses et provoque des résistances aux traitements traditionnels. Cette voie de signalisation vicieuse a fait récemment l’objet de plusieurs études qui confirment son lien avec un pronostic négatif pour le cancer du sein, les leucémies et plusieurs types de lymphomes. Environ 250 000 patients dans le monde sont diagnostiqués chaque année avec une maladie liée à une mutation de ce gène.

Afin d’empêcher le gène de s’exprimer, la manière la plus sûre est de le faire taire à son origine, c’est-à-dire d’empêcher la protéine d’activer le signal dans le noyau. La molécule CB-103 découverte par Rajwinder Lehal, alors qu’il effectuait son doctorat dans le laboratoire de Freddy Radtke à l’EPFL, se lie avec elle et l’empêche de faire son travail. Toute les communications de Notch sont ainsi coupées, peu importe la cause de l’activation, conduisant ainsi à la mort des cellules cancéreuses.

Un brevet a été déposé sur cette molécule ainsi que sur le développement et la commercialisation de plusieurs de ses semblables. Suite aux tests in vivo et in vitro, les chercheurs ont constaté une tolérance et une efficacité excellentes pour ce traitement. Il est de plus rapidement absorbé et distribué dans les tissus.

L’étude clinique qui va commencer permettra de vérifier divers paramètres comme la tolérance et la dose adéquate chez des patients adultes avec des tumeurs solides avancées ou métastatiques ainsi que chez des individus adultes avec des tumeurs hématologiques.

Article rédigé par Georges Simmonds pour RT Flash

EPFL

|

|

|

|

|

|

|

|

|

La palpation est l’une des plus anciennes méthodes de diagnostic, permettant au médecin de détecter d’éventuelles dysfonctions par la taille ou la souplesse anormale des organes palpés. La nanopalpation permet désormais d’étudier la structure, la taille et la souplesse des cellules ou des molécules individuelles. Elle passe par l’utilisation d’un microscope à force atomique (AFM), doté d’une sonde flexible qui génère des contraintes mécaniques. L’appareil induit une déformation du matériau biologique (molécule ou cellule), donnant des informations sur son élasticité et sa réponse mécanique.

"La plupart des matériaux vivants – cellules et molécules – sont viscoélastiques et cette propriété signifie que leur réponse dépend de la vitesse ou de la fréquence à laquelle on applique la contrainte" explique Felix Rico, directeur du bio-AFM lab à Marseille. Ce physicien a développé une méthode de nanopalpation à haute fréquence de sollicitation, mille fois plus rapide que celle induite par l’AFM conventionnel.

Au niveau de la cellule, cette technologique représente une avancée permettant de caractériser l’état mécanique des cellules vivantes et de leurs composants les plus petits, en particulier ceux qui forment le squelette des cellules : le cytosquelette. Pourrait-on l’utiliser pour différencier les cellules cancéreuses malignes et bénignes ?

Comme le souligne Felix Rico, "Nous avons testé la nanopalpation à hautes fréquences sur les cellules épithéliales de cancer mammaire. Ce qui nous a permis d’observer que les cellules cancéreuses malignes sont certes plus souples, mais présentent un cystosquelette en tension, tandis que les cellules cancéreuses bénignes sont moins souples avec un cytosquelette détendu ". Une différence subtile, qui pourrait être exploitée comme marqueur diagnostique ou pronostique des cancers.

Article rédigé par Georges Simmonds pour RT Flash

Inserm

|

|

|

|

|

|

|

|

|

Dans une étude récente, des chercheurs néerlandais ont affirmé avoir fixé le "plafond de verre" de la durée de vie humaine à 115,7 ans pour les femmes et à 114,1 ans pour les hommes, malgré l'augmentation de l'espérance de vie.

Des statisticiens des Universités de Tilburg et de Rotterdam ont exploré des données, qui s'étendent sur les trois dernières décennies, de quelque 75.000 Néerlandais dont l'âge exact au moment du décès a été enregistré, a expliqué le professeur John Einmahl, l'un des trois scientifiques qui ont réalisé cette étude. "En moyenne, on vit plus longtemps, mais les plus âgés parmi nous ne sont pas devenus plus âgés au cours des trente dernières années", précise John Einmahl.

L'étude précise que si l'espérance de vie a bien continué à progresser (le nombre des personnes ayant atteint 95 ans aux Pays-Bas a quasiment triplé en 30 ans), le plafond en lui-même n'a pas changé. Les résultats de l'étude néerlandaise viennent compléter ceux de chercheurs basés aux États-Unis qui avaient déterminé un plafond similaire l'an dernier.

Article rédigé par Georges Simmonds pour RT Flash

Daily Times

|

|

|

|

|

|

|

|

|

Des chercheurs de la prestigieuse Université américaine de Stanford ont mis au point un nouveau test sanguin remarquable qui pourrait transformer la surveillance et le traitement des cancers. Cette technologie permet en effet de détecter rapidement des quantités infimes d'ADN cancéreux rejeté et circulant dans le sang ; elle permet également d'identifier avec une grande précision sur le nombre de molécules d'ADN contenant la mutation recherchée et donc sur l’importance de la tumeur du patient.

Ce test de reconnaissance des mutations spécifiques à tout cancer individuel constitue sans aucun doute une avancée vers la médecine de précision ou le traitement personnalisé des cancers.

Ce test sanguin est ainsi capable de détecter des mutations génétiques dans de petites quantités d'ADN libérées par des cellules cancéreuses dans le sang. Appelé test PCR numérique à une seule couleur, il ne nécessite qu'une fraction d'un tube à essai de sang et peut détecter jusqu'à 3 molécules portant une mutation.

Alors qu’aujourd’hui, pour surveiller les tumeurs des patients, les cliniciens ne disposent que de quelques tests sanguins, limités à certains cancers et que tous les patients atteints de cancer nécessitent une surveillance par imagerie qui peut être coûteuse et complexe, ce test moléculaire va permettre une surveillance quasi-quotidienne de la tumeur et de la réponse au traitement.

Ce nouveau test sanguin présente en outre l'avantage majeur d'être simple et peu coûteux, en particulier par rapport au séquençage de l'ADN ; le test pourrait permettre une « surveillance universelle » c’est-à-dire d’un bien plus grand nombre de patients, explique l’auteur principal, le Docteur Hanlee P. Ji, MD, professeur agrégée au Département de médecine de l'Université de Stanford.

Ce test a permis d’identifier l'ADN circulant dérivé de la tumeur de 3 patients sur six. Chez un patient, l'analyse a permis de montrer la présence de 3 mutations différentes. Ces 3 patients, dont les échantillons présentaient de très faibles niveaux d’ADN cancéreux, subissaient un traitement actif au moment de la collecte.

Article rédigé par Georges Simmonds pour RT Flash

Eurekalert

|

|

|

|

|

|

|

|

|

Selon une étude américaine dirigée par Stefan Gravenstein, Professeur à l'Université Brown, l'incidence des pathologies respiratoires associées à la grippe est sensiblement réduite chez les seniors qui ont bénéficié d'un vaccin antigrippal à haute dose, au lieu du vaccin habituel. Disponible depuis 2009, ce vaccin à haute dose contient 4 fois plus d’antigènes que le vaccin standard et pourrait constituer une riposte à la baisse de la réponse immunitaire qui survient au fil du temps après l’âge de 65 ans.

Cette étude en double aveugle contre placebo a été réalisée chez des personnes âgées fragiles vivant dans des structures d’accueil médicalisées. Les patients devaient être âgés de plus de 65 ans. Dans les deux groupes de comparaison, le taux de personnel vacciné était le même.

L'incidence des hospitalisations toutes causes confondues est inférieure, d’environ 8 %, dans les structures dont les résidents avaient bénéficié du vaccin à haute dose. L'étude précise qu'au cours de la saison grippale 2013-14, la souche A(H1N1)pdm09 était dominante et présente dans le vaccin.

Cette souche est généralement associée à une virulence inférieure à celle des souches A/H3N2. Selon ces travaux, la différence significative constatée dans ce contexte de souche moins virulente et moins transmissible souligne à la fois la gravité potentielle de ces souches chez les personnes âgées fragiles et l’intérêt de la vaccination à haute dose, y compris dans ce cadre où la souche virale était moins virulente.

Article rédigé par Georges Simmonds pour RT Flash

Healio

|

|

| ^ Haut |

|

|

|

|

|

|

|

Recherche |

|

|

Recherche & Innovation, Technologies, Transports

|

|

|

|

|

|

|

|

|

|

La société aérospatiale chinoise CASIC (China Aerospace Science and Industry Corporation) travaille à la conception de trains capables d'accélérer jusqu'à 4 000 kilomètres heure. Le système de transport HyperFlight est un train sur un coussin magnétique qui se déplace dans un tunnel sous basse pression. Le système baptisé HyperFlight est développé par la société aérospatiale chinoise, China Aerospace Science and Industry Corporation (CASIC). Si ce projet voit le jour, il sera possible de relier l'est à l'ouest de la Chine en une heure.

Plus de 20 instituts chinois et étrangers collaboreront à la conception de l'HyperFlight. La CASIC a déjà déposé plus de 200 brevets liés à ce système de transport de l'avenir. Le projet se développera en trois étapes. D'abord seront lancés des trains régionaux pouvant atteindre une vitesse de 1 000 kilomètres heure. Ensuite, des liaisons seraient établies entre de grandes mégapoles chinoises, la vitesse des trains pourra alors être doublée. Enfin, l'HyperFlight traversera les frontières de la Chine.

Des projets similaires sont en cours de développement aux États-Unis. Récemment, le prototype de capsule de transport de passagers Hyperloop, propulsé dans un tube sous vide, a atteint la vitesse record de 324 kilomètres heure.

Article rédigé par Georges Simmonds pour RT Flash

Sputnik news

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|