|

|

|

|

|

| NUMERO 878 |

|

|

|

|

|

|

|

Edition du 16 Décembre 2016

|

|

|

|

|

Edito

Un monde sans énergies fossiles en 2050, c'est possible !

La production primaire d'énergie dans le monde a augmenté de 48 % depuis 1990, atteignant à présent les 13,3 gigateps (gigatonnes d’équivalent-pétrole). Mais 85 % de cette énergie reste produite à partir de sources fossiles (pétrole charbon et gaz). Selon l’Agence Internationale de l'Energie, cette production mondiale d’énergie devrait continuer à augmenter d’au moins 45 % d’ici 2050, atteignant 19,3 gigateps, sous le double effet de l’évolution démographique planétaire et du décollage économique dans plusieurs régions du monde.

Parallèlement, l’homme émet à présent de 50 gigatonnes équivalent-carbone par an et la concentration moyenne de CO2 dans l’atmosphère vient de franchir il y a quelques semaines la barre symbolique des 400 ppm, ce qui représente une augmentation de 27 % au cours des 50 dernières années…

Pourtant, si nous voulons atteindre les objectifs ambitieux définis à l’issue de la COP21, en décembre 2015, et limiter ainsi la hausse moyenne des températures à 2°C, nous ne devons pas émettre plus de 1000 milliards de tonnes d’équivalent CO2 d’ici la fin de ce siècle, soit 16 gigatonnes par an, en moyenne, à partir de 2017. Concrètement, cela signifie qu’il va falloir parvenir à baisser d’environ 70 % nos émissions mondiales de CO2 d’ici 2050 puis tendre vers une quasi-élimination de ces émissions de carbone d’origine humaine d’ici la fin du siècle.

Pour résoudre cette équation redoutable qui va consister à décarboner massivement et rapidement notre production d’énergie, l’Humanité doit impérativement sortir des énergies fossiles d'ici 2050. Mais cet objectif, qui était encore jugé par beaucoup utopique et inaccessible il y a quelques années, est en train de devenir réaliste. C’est en tout cas la thèse défendue par une étude que vient de publier, il y a quelques semaines, la prestigieuse université américaine de Stanford. Selon ce travail, produire la totalité de notre énergie à partir de sources renouvelables est non seulement un objectif réalisable du point de vue économique et technologique mais souhaitable du point de vue de l'emploi et des bénéfices sociaux et environnementaux (Voir Stanford).

Cette étude dirigée par Mark Jacobson présente un panorama très complet du paysage énergétique mondial sur 139 États dans le monde. Elle montre que la planète peut changer de moteur énergétique d’ici à 2050 pour passer aux énergies renouvelables et sortir à la fois des énergies fossiles et du nucléaire. Le grand intérêt de ce travail qui tente d’imaginer, à partir des infrastructures énergétiques actuelles dans tous les domaines (agriculture, industrie, transport, chauffage) des 139 pays étudiés, comment passer à des systèmes entièrement alimentés par le vent, l’eau et le soleil.

L’étude prend en également en compte la quantité d’énergie que consomme le système énergétique lui-même pour fonctionner, c’est-à-dire produire et distribuer l'énergie finale. Il faut en effet rappeler qu’actuellement au moins 40 % de l’énergie est perdue au niveau mondial, si l’on fait la différence entre la totalité de l’énergie produite et l’énergie finale réellement consommée en bout de chaîne. Cette perte considérable s’explique notamment par le fait que les énergies fossiles, qui constituent encore plus 80 % de l’énergie consommée dans le monde, doivent être extraites, transportées et distribuées à grands frais jusqu’au consommateur final.

A contrario, les énergies renouvelables, si elles doivent être stockées sous différentes formes et acheminées vers l’utilisateur final, ne nécessitent pas d’extraction, ni de transformation pour être utilisées. Cette différence de nature produit des conséquences concrètes tout à fait considérables puisque l’étude a calculé que le mix énergétique mondial actuel, basé essentiellement sur les énergies fossiles, suppose d’augmenter la production mondiale d’énergie de 40 %, pour atteindre 20 600 GW en 2050. En revanche, un système énergétique mondial entièrement approvisionné par des sources d’énergie renouvelable ne nécessiterait que 11800 GW en 2050, soit une consommation énergétique mondiale diminuée de 42 %...

En analysant ensuite l’ensemble des données sur l’énergie recueillies par l’Agence internationale de l’énergie, cette étude a tenté d'estimer le potentiel de développement des énergies renouvelables et l’évolution des besoins énergétiques dans les différentes régions du monde. Ces prévisions ont également intégré les gains économiques et sociaux attendus, notamment en matière de création d’emplois, de réduction de la pollution de l’air et d’amélioration de la santé globale des habitants.

Le moins que l’on puisse dire est que le résultat de cette étude sérieuse, cohérente et globale est édifiant. Selon les calculs de ces chercheurs, il faudrait en effet, passer à un paysage énergétique mondial entièrement renouvelable, mettre en service 1,6 million de d’éoliennes terrestres de 5 MW (assurant 23,5 % de la production énergétique mondiale), 935.000 éoliennes marines de 5 MW (13,6 %). Le solaire thermique avec stockage assurerait environ 10 % de la production énergétique globale, le solaire photovoltaïque produirait 26 % de l’énergie totale et le solde énergétique serait assuré par les autres sources d’énergie renouvelable, énergie hydraulique, biomasse et énergies des mers. Quant au prix du kilowatt/heure, il serait de l’ordre de 10,1 centimes, en moyenne, contre 9,7 centimes, si la production énergétique mondiale reste essentiellement assurée par les énergies fossiles. Enfin cette étude souligne qu’une telle transition énergétique mondiale permettrait d’éviter au moins 4,6 millions de décès prématurés par an, liés à la pollution provoquée par l’utilisation massive des énergies fossiles.

Cette étude de Stanford prolonge et confirme les travaux publiés en mars dernier par l'IRENA (Agence internationale pour les énergies renouvelables). Selon ces recherches, doubler la part des énergies renouvelables dans le mix énergétique mondial d’ici 2030 permettrait d'économiser 4 200 milliards de dollars. Cette étude de l’Irena a notamment calculé que pour porter la part des énergies renouvelables à 36 % en 2030, il faudrait investir 770 milliards de dollars par an, ce qui augmenterait le coût du système énergétique mondial de 290 millions de dollars par an d'ici à 2030. Mais Irena précise que les économies que permettrait de réaliser cette transition énergétique accélérée seraient 15 fois supérieures au coût total de cette transformation, si l’on prend en considération les millions de vies sauvées chaque année du fait de la diminution drastique de la pollution et l’impact extrêmement positif d’une telle transition sur l’environnement et le climat de la planète. Cette étude souligne en outre qu’un tel passage accéléré vers les énergies renouvelables permettrait de créer au moins 24,4 millions d'emplois et d’augmenter le produit mondial brut de 1 300 milliards de dollars par an.

Heureusement, même si le paysage énergétique mondial reste aujourd’hui dominé par les énergies fossiles, il semble bien que cette transition énergétique mondiale vers les énergies renouvelables s’accélère. À cet égard, le dernier rapport publié par l’AIE il y a quelques semaines (Voir IEA) révèle que les capacités de production des énergies renouvelables ont dépassé celle du charbon pour la première fois de l’histoire en 2015, avec 1 995 GW, contre 1 969 pour le charbon.

Commentant ce basculement, Fatih Birol, directeur exécutif de l’AIE, souligne que « Nous assistons à une transformation des marchés de l’énergie, tirés dorénavant par les énergies renouvelables ». L’accélération de cette transition énergétique a surpris l’AIE qui a revu à la hausse de 13 % ses prévisions de production d’énergies renouvelables pour 2020 et prévoit l’installation de 825 gigawatts de nouvelles capacités d’énergies renouvelables d’ici à 2021, soit 42 % de plus que le niveau atteint en 2015.

L’AIE prévoit par ailleurs que les énergies renouvelables devraient fournir dans cinq ans 28 % de l'électricité mondiale, contre 23 % à la fin 2015. Cette part d’électricité propre atteindra alors 7 600 terra watts/heure (TWh), soit l’équivalent de la production électrique cumulée des États-Unis et de l’Union européenne en 2015. Et pour illustrer cette accélération de la montée en puissance des énergies renouvelables, l’AIE rappelle que, dorénavant, 500 000 panneaux solaires sont installés chaque jour dans le monde. Ce décollage des énergies renouvelables s’explique principalement par le fait que les coûts de production ne cessent de diminuer. Depuis 10 ans les prix des panneaux photovoltaïques ont par exemple chuté de 80 %, et ceux des éoliennes de grande capacité de 40 %. Et cette tendance va se poursuivre : l’AIE prévoit en effet que les coûts de productions de l’énergie solaire photovoltaïque et de l'énergie éolienne baisseront de 25 % d’ici cinq ans et de 50 % d’ici 10 ans.

Une autre étude du The Carbon Tracker Initiative révèle par ailleurs que cette année, pour la première fois, le coût moyen réel des énergies renouvelables est devenu légèrement inférieur à celui du coût moyen de production des énergies fossiles : 6 cents le kilowattheure pour l’éolien terrestre et 7 cents pour le solaire photovoltaïque, contre 7 à 7,5 cents pour le charbon et le gaz (Voir Ecologist).

Il est également très intéressant de souligner que selon l’étude de Stanford, la France est tout à fait en mesure de satisfaire complètement à ses besoins énergétiques à partir des énergies renouvelables d’ici 2050. Pour notre pays, les chercheurs américains proposent un scénario énergétique qui serait composé de 55 % d’éolien terrestre et marin et de 37 % de solaire photovoltaïque et thermique. Le solde énergétique serait assuré par l’hydroélectricité et les énergies marines. Fait remarquable, dans ce scénario « 100 % renouvelable », la consommation totale d’énergie de notre pays serait inférieure de 36 % à son niveau actuel, grâce à la plus grande efficacité énergétique intrinsèque des énergies renouvelables. Toujours dans ce scénario, les panneaux solaires occuperaient 0,3 % du territoire et les éoliennes 2,43 %, ce qui est conforme aux prévisions déjà réalisées par l’Ademe. Les auteurs de l'étude ont également calculé qu'une telle transition énergétique permettrait à la France de réaliser 379 milliards d'euros d’économies chaque année et de créer 334 000 emplois pérennes d’ici 2050. Le prix du kilowattheure en France serait, dans ce scénario, de 9,2 centimes en 2050, contre 10,5 en 2015.

La transition énergétique mondiale proposée dans cette étude américaine pourrait en outre être accélérée par une vague d’innovations de rupture, comme celle annoncée il y a peu par une équipe de recherche de l’Oak Ridge National Laboratory (ORNL), aux États-Unis (Voir Oak Ridge National Laboratory).

Ces chercheurs ont en effet découvert par hasard une méthode pour transformer le dioxyde de carbone (CO2), l’un des principaux gaz à effet de serre, en biocarburant : l’éthanol. « Nous étions en train d’étudier la première étape d’une réaction quand nous nous sommes aperçus que le catalyseur la réalisait tout seul en intégralité », explique Adam Rondinone, chercheur à la tête du projet.

Ce fameux catalyseur est composé de carbone, de cuivre et d’azote, et il a été conçu spécialement par les équipes du laboratoire. Les scientifiques lui ont appliqué un courant électrique, ce qui a déclenché une réaction chimique complexe inversant le processus de combustion et transformant ainsi leur solution de dioxyde de carbone dissout en éthanol. Cette technique offrirait par ailleurs un rendement étonnamment élevé, d’environ 63 %.

Ces expériences ont montré que cette réaction électrochimique offrait la possibilité d’inverser, à température ambiante, le processus de combustion du carburant, qui est quant à lui considéré comme une source majeure d’émissions de gaz à effet de serre. Le procédé présente également l’avantage d’être peu onéreux et pourrait être appliqué assez facilement aux centrales thermiques utilisant des énergies fossiles comme le charbon ou le gaz. Si cette découverte tient ses promesses, il deviendrait possible de produire et d’utiliser de l’éthanol comme carburant au sein de nos véhicules actuels, qui n’auraient même pas besoin d’être modifiés pour l’occasion. Mais il serait également possible de stocker facilement et à faible coût sous forme d'éthanol la production excédentaire d’électricité issue des énergies renouvelables et liée au caractère intermittent de ces sources d’énergie.

Autre innovation majeure qui pourrait avoir un impact considérable dans le domaine des transports, l’e-diesel, mis au point par Audi. Le constructeur allemand a en effet réussi, en coopération avec Sunfire, à produire en 2015 une énergie synthétique propre, à partir d’eau, de CO2, et d’hydrogène. La création de l’e-diesel ne nécessite que deux matières premières : l’eau et le dioxyde de carbone. L’intérêt écologique du e-diesel d’Audi est d’utiliser le dioxyde de carbone, gaz à effet de serre habituellement produit par la combustion des moteurs thermiques, comme une matière première. Le cycle du carburant d’Audi est alors neutre pour l’atmosphère puisque le CO2 émis par la voiture diesel correspond au CO2 capté pour la production du e-diesel Audi.

Il faut évoquer le remarquable processus de photosynthèse artificielle présenté il y a quelques mois par l’équipe du Professeur Daniel Nocera, professeur des sciences de l’énergie à l’Université de Harvard et inventeur prolifique. Ce système permet la fabrication de combustibles liquides à partir de la lumière du soleil, du dioxyde de carbone et de l’eau. Il utilise un nouveau catalyseur haute performance à base de cobalt nécessitant des courants plus faibles pour réaliser l’électrolyse de l’eau. Il devient ainsi possible de « casser » les molécules d’eau grâce à l’énergie solaire.

Quant à la deuxième étape réalisée par cette « feuille artificielle » elle est assurée par une bactérie autotrophe (qui fixe le CO2), bien connue des microbiologistes : Ralstonia eutropha. Cette bactérie présente dans le sol et l’eau possède l’étonnante propriété de pouvoir utiliser l’hydrogène comme source d’énergie en présence d’oxygène. Les chercheurs sont parvenus à modifier génétiquement cette bactérie afin qu’elle produise de l’isopropanol et de l’isobutanol, deux alcools qui présentent des densités énergétiques proches de celle de l’essence. Bien que cette feuille bionique ait pour l’instant un rendement énergétique assez faible - environ 7 % - ce système pourrait être tout à fait rentable à un niveau de production industrielle car l’énergie solaire qui l’alimente est inépuisable…et gratuite.

Dans le domaine de l'énergie solaire, les cellules à base de pérovskites vont être, d'ici seulement quelques années, à l'origine d'une nouvelle rupture technologique et industrielle en permettant la construction de panneaux solaires à haut rendement (plus de 20 %) mais cinq fois moins chers que les panneaux actuels à base de silicium. Cet été, une équipe franco-américaine a même franchi une nouvelle étape dans cette voie prometteuse en annonçant qu'elle avait mis au point une pérovskite hybride organométallique capable de s'autoréparer, ce qui lève l'un des verrous majeurs à l'utilisation à grand échelle de ce nouveau type de panneaux solaires.

Mais l'éolien n'est pas en reste et une collaboration scientifique regroupant plusieurs universités, dont le laboratoire national Sandia (Nouveau Mexique), travaille sur la conception d'une nouvelle génération d'éolienne géante d'une puissance de 50 MW qui pourra alimenter 50 000 foyers en électricité. En matière d'éoliennes marines, la mise au point d'éoliennes flottantes stables et sûres, comme celles testées actuellement au large du Portugal par la filiale métal d'Eiffage, va permettre prochainement de repousser à des fonds de 200 mètres la zone possible d'implantation d'éoliennes marines, ce qui va multiplier par trois le nombre de machines potentiellement installables en mer.

Mais la révolution technologique en cours dans le domaine des énergies renouvelables est loin de se limiter à la production propre de biocarburant, au solaire et à l'éolien et concerne également les énergies marines. En juillet dernier, des chercheurs de l'EPFL de Lausanne en Suisse ont ainsi publié une étude qui montre qu'il est possible, en utilisant un nouveau type de nanomembrane composée de Disulfure de molybdène, de multiplier par un facteur 1000 le rendement énergétique de l'énergie osmotique, qui résulte d'une différence de concentration ionique entre l'eau douce et l'eau salée. Ces recherches montrent qu'on peut espérer, avec une membrane d’un mètre carré, dont 30 % de la surface serait couverte de nanopores, produire 1MW, soit de quoi alimenter 50 000 ampoules économiques standard....Si ce type de membrane peut être produite à un coût suffisamment bas, l’énergie osmotique pourrait jouer, d'ici une dizaine d'années, un rôle majeur dans la production d’énergie renouvelable car, contrairement à l’éolien et au solaire, elle peut être produite par tout temps.

Toujours en juillet dernier, le physicien français Alain Elayi a présenté une remarquable innovation technologique qui permet de produire de manière propre de l'électricité en quantité avec de l'eau. En utilisant de manière ingénieuse la différence de pression et de température entre un réservoir d'eau et une grande étendue d'eau située en dessous, ce scientifique a montré qu'il était possible de produire une quantité importante de vapeur d'eau à température ambiante sans apport d'énergie. Elayi montre qu’il est même possible d'accélérer ce phénomène d'évaporation rapide en évacuant l'eau de surface du réservoir. L'énergie ainsi obtenue par l'évaporation de l'eau est de « 2,5 millions de joules par kilogramme d'eau évaporée », selon Alain Elayi. Cette technique simple et peu coûteuse à mettre en œuvre pourrait permettre, selon son concepteur de produire de l’énergie propre en économisant 92 % de l'énergie nécessaire pour chauffer l'eau. En outre, « Ce système permet également de dessaler de l'eau de mer et ouvre des perspectives intéressantes pour l'irrigation », estime Alain Elayi.

Notre Pays qui a la chance extraordinaire de posséder un gisement énergétique potentiel considérable aussi bien dans l’éolien que dans le solaire, la biomasse et les énergies marines, doit sans plus attendre prendre la tête de cette transition énergétique mondiale inévitable et irréversible et se donner l’objectif ambitieux de devenir, avant le milieu de ce siècle, le premier État produisant la totalité de son énergie de manière propre et durable et ce sans se laisser perturber par une nouvelle politique énergétique que serait tenté de lancer le nouveau Président des Etats-Unis.

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

TIC |

|

|

Information et Communication

|

|

|

|

|

|

|

|

|

|

L’hôpital pour enfants Alder Hey à Liverpool va devenir l’un des premiers au monde à utiliser les capacités de diagnostic de Watson, le superordinateur d’IBM. L’intelligence artificielle permettra d’analyser rapidement l’historique médical des patients tout en se référant à de vastes archives de connaissances scientifiques. En effet, le système a déjà « lu » presque 15 millions de pages de littérature médicale et peut analyser les dossiers des patients et questionnaires médicaux pour suggérer diagnostics et traitements.

La première étape sera de développer un agent conversationnel (ou « chatbot ») qui répondra aux questions des patients et de leurs parents. Ceux-ci pourront converser avec le programme et trouver réponse à toutes leurs questions, de la nourriture et jeux de l’hôpital en passant par les procédures, anesthésiants et opérations chirurgicales.

Iain Hennessey, chirurgien pédiatrique et directeur clinique de l’innovation à Alder Hey, commente le dispositif : "Il y a beaucoup de questions que les gens ne posent pas au docteur parce qu’ils sont gênés, ne veulent pas avoir l’air bêtes ou nous faire perdre notre temps. Les gens sont aussi plus prompts à s’épancher quand ils parlent à une machine". Il continue : "Le chatbot peut aider à atténuer les peurs des enfants, ce qui signifie que nous pourrons opérer avec moins d’anesthésiants et donc moins de risques…"

Le moment venu, Watson sera également utilisé pour analyser les dossiers médicaux afin d’aider à établir des diagnostics, sans pour autant remplacer l’expertise humaine. Chaque année, l’hôpital Alder Hey soigne environ 270.000 enfants.

Article rédigé par Georges Simmonds pour RT Flash

Business Cloud

|

|

|

|

|

|

|

|

|

Après une expérimentation réussie auprès de plus de 500 personnes, la Société Générale devient l’une des premières banques mondiales et la première en France à proposer à ses clients particuliers ces cartes nouvelle génération dotées d’un cryptogramme visuel dynamique.

Cette solution innovante, MOTION CODETM, développée par Oberthur Technologies, consiste à remplacer les 3 chiffres du cryptogramme imprimés au dos de la carte par un petit écran affichant un nouveau code « dynamique » toutes les trois heures. Ainsi, en cas de piratage des données de la carte bancaire, les 3 chiffres du cryptogramme deviennent rapidement obsolètes, empêchant les fraudeurs de réutiliser les données sur les sites de e-commerce. Rassurante pour le client, cette solution est également simple puisqu’elle ne modifie en rien le parcours d’achat sur Internet.

Cette nouvelle carte à cryptogramme modifiable devrait limiter la fraude sur Internet, fondée essentiellement sur l'usurpation du code à trois chiffres présent au dos des cartes bancaires. Mais, pour l'instant, Société Générale n'envisage pas de déployer cette technologie à l'ensemble de son parc de cartes bancaires. En matière de sécurisation des cartes bancaires, d'autres solutions font également leur apparition, comme l'authentification des porteurs par biométrie vocale "Talk to Pay", proposée par la Banque postale.

Article rédigé par Georges Simmonds pour RT Flash

GSM

|

|

| ^ Haut |

|

|

|

|

|

|

|

Avenir |

|

|

Nanotechnologies et Robotique

|

|

|

|

|

|

|

|

|

|

Nanobiotix, société française pionnière en nanomédecine développant de nouvelles approches thérapeutiques pour le traitement local du cancer, a présenté des données précliniques démontrant que son produit NBTXR3 amplificateur de radiothérapie, peut stimuler activement le système immunitaire afin d’attaquer les cellules tumorales.

Ces données, issues du programme préclinique en cours en immuno-oncologie, ont été présentées lors du 31ème congrès annuel de la Society for Immunotherapy of Cancer (SITC), une conférence internationale majeure d’immuno-oncologie qui s’est tenue à National Harbor dans le Maryland du 9 au 13 novembre 2016 (Paris S., Pottier A., Levy L., and Lu B. Hafnium oxide nanoparticles, a radiation enhancer for in situ cancer vaccine).

Laurent Levy, CEO de Nanobiotix, a commenté : « Ces données prometteuses montrent que le produit NBTXR3 pourrait changer la donne dans les combinaisons en immuno-oncologie. Elles ouvrent des perspectives de synergies entre NBTXR3, la radiothérapie et les immunothérapies, et offrent des opportunités de collaborations avec les industriels développant des solutions en oncologie.

Lors de cette présentation, les scientifiques de Nanobiotix et le Docteur Bo Lu, Directeur du département « Molecular Radiation Biology » au sein du département de radio-oncologie de l’Hôpital Universitaire Thomas Jefferson de Philadelphie, ont présenté des résultats qui montrent que NBTXR3 combiné à la radiothérapie déclenche, dans différentes lignées cellulaires cancéreuses, une augmentation importante de la mort cellulaire immunogénique (Immunogenic Cell Death - ICD) comparée à la radiothérapie seule, au sein de modèles radiorésistants et radiosensibles.

Dans une seconde expérience, un phénomène appelé effet abscopal a été observé (i.e. un effet provoqué par une irradiation sur des tissus hors du champ de la zone irradiée). Deux tumeurs ont été implantées dans chaque flanc d’une souris. Alors qu’une seule de ces tumeurs a été traitée avec NBTXR3 en combinaison avec la radiothérapie, les deux tumeurs ont montré une réduction de volume. Plus spécifiquement, l’étude a démontré que l’utilisation de NBTXR3 combinée à la radiothérapie a eu un impact sur le contrôle de la tumeur non-traitée et provoqué une amélioration statistiquement significative de la survie globale.

Article rédigé par Georges Simmonds pour RT Flash

Boursorama

|

|

|

|

|

|

|

|

|

En 2016, près de 2,6 personnes par jour en moyenne ont été tuées par balle par la police américaine. Le Washington Post chiffre également le nombre total de ces victimes : 824 à l’heure actuelle pour l’année en cours. C’est pour réduire ce nombre et apprendre aux forces de l’ordre à mieux appréhender certaines situations dangereuses qu’a été créé BEST. Le simulateur utilise la réalité virtuelle pour entraîner les policiers et leur permettre d'éviter le plus possible d'utiliser leurs armes.

L’objectif de BEST (pour “Behavior, ethics, strategy and tactics”, autrement dit Comportement, éthique, stratégie et tactiques), est de proposer des méthodes pour analyser les situations et conduire à une désescalade de la violence. Par exemple, le policier sera confronté avec l’outil à des cas de personnes souffrant de problèmes mentaux : il devra distinguer les expressions de panique de celles de brutalité.

En plus de sauver des vies, la réalité virtuelle pourrait aussi faire économiser de l’argent au contribuable à qui le procès, l’arrestation de l’agent et la compensation financière des victimes, coûtent jusqu’à deux millions de dollars. Un argument secondaire mais qui pourrait faire mouche. La réalité virtuelle s’ancre ainsi dans la smart city. La justice britannique envisage aussi d’en faire usage pour “transporter” les jurés sur les scènes de crime et les aider à comprendre le dossier.

Article rédigé par Georges Simmonds pour RT Flash

Best

|

|

| ^ Haut |

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

Des chercheurs de l’Université d’Oxford ont montré qu'il est possible d'utiliser la lumière pour stocker des données de manière permanente. Ces scientifiques travaillent sur une puce photonique, faite d’un matériau présent dans les DVD réinscriptibles, et qui permettrait de lutter contre la perte de mémoire, d’améliorer la puissance des CPU, et d’augmenter la capacité de stockage. Concrètement, la puce photonique utiliserait des photons plutôt que des électrons pour stocker des données de manière permanente. Actuellement, les puces électroniques utilisées quotidiennement sont rapides mais restent très lentes comparées à une potentielle puce photonique.

Tout comme un ordinateur quantique démultiplierait la puissance de calcul, une puce utilisant les photons et non les électrons permettrait de déplacer les données à une vitesse très rapide. En effet, les électrons "s’entrechoquent" quand ils se déplacent dans les composants d’une puce électronique, ralentissant le transfert de données et chauffant le matériel. Or, les photons, qui voyagent à la vitesse de la lumière, ne s’entrechoqueraient pas, et le transfert serait quasi-instantané, ce qui rendrait la puce presque immortelle.

Les chercheurs menés par Harish Bhaskaran utilisent le GST (germanium-antimony-tellurium), une fine couche d’alliage de germanium, d’antimoine et de tellure, qui se trouve dans les CD et DVD réinscriptibles. Bombardé par un laser, comme le font les lecteurs de CD/DVD (mais avec une faible intensité), le film GST change sa structure atomique, absorbant puis reflétant alors la lumière.

Les scientifiques d’Oxford ont tenté d’utiliser le GST pour stocker et lire des données, de manière permanente. Pour cela, ils ont équipé une puce électronique standard d’un appareil de nitrure de silicium (un guide à ondes), qui canalise et permet de transférer des pulsations de lumière. Puis ils ont placé un film GST, d’une taille nano, au-dessus de l’appareil.

En maintenant le champ électromagnétique de la lumière à une intensité modérée pour éviter de “faire fondre” le film GST, et en envoyant de faibles pulsations de lumière via le “guide à ondes”, les scientifiques ont réussi à écrire des données sur la puce et à les lire.

En envoyant plusieurs longueurs d’onde de lumière en même temps à travers le guide à ondes - la lumière se diffusant partout en même temps -, les chercheurs ont même réussi à écrire et à lire des données simultanément. Exactement comme un ordinateur quantique serait capable d’effectuer plusieurs calculs en même temps. Cette puce photonique permettrait d’augmenter drastiquement les données qu’on peut stocker sur un support. Elle serait en outre de 50 à 100 fois plus rapide que nos processeurs actuels.

Article rédigé par Georges Simmonds pour RT Flash

Nature

|

|

|

|

|

|

|

|

|

Une expérience réalisée sur de l’hélium par une équipe de recherche impliquant des laboratoires du CEA, du CNRS, de l’Université Pierre & Marie Curie (UPMC) 1 et de l’Université Autonome de Madrid (UAM), a permis d'observer, pour la première fois en temps réel, tous les détails de l’émission d’un photoélectron par un atome d’hélium. Cette observation de l'effet photoélectrique pourrait permettre de contrôler plus finement certaines réactions chimiques ou le déplacement des électrons au sein de nanostructures.

À première vue, l’effet photoélectrique expliqué par Albert Einstein en 1905 paraît simple. Un atome absorbe un photon ultra-violet (UV) ou X et répond à cette excitation par l’émission quasi-instantanée d’un électron (appelé photoélectron). Or pour certaines énergies, il existe des états électroniques où les deux électrons de l'atome d'hélium sont excités. Ceci fait qu'il existe alors deux « chemins » énergétiques en compétition, conduisant à l'émission du photoélectron. A ces énergies, le spectre d'absorption de la lumière par l'hélium comporte un pic au profil asymétrique, dont la largeur indique la durée complète de la photoionisation : 17 femtosecondes (10-15 s). Le physicien italien Ugo Fano a décrit ce phénomène et donné son nom à ce profil caractéristique.

Observer le phénomène en temps réel est donc un véritable défi expérimental. Les chercheurs ont relevé ce défi en excitant des atomes d’hélium avec des impulsions ultracourtes d'un faisceau laser infrarouge intense. Ils ont ainsi pu mesurer le spectre en énergie des photoélectrons émis, à la résolution temporelle des impulsions du laser : la femtoseconde.

Le profil du spectre montre initialement un pic unique (ionisation par le chemin le plus direct), qui se dédouble après un retard de 7-8 femtosecondes, révélant l'interférence entre les deux chemins d'ionisation. Le « film » de la photoionisation de l’atome d'hélium est ainsi reconstitué par une trentaine d’ « images », séparées chacune d’une femtoseconde. Le procédé mis en œuvre pourrait être appliqué à d’autres atomes, à des molécules de tailles diverses (biomolécules) et à des nanostructures.

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Les émissions mondiales de dioxyde de carbone (CO2) sont restées à un niveau quasi identique pour la troisième année consécutive en 2016, selon une étude internationale du Global Carbon Project à l'occasion de la COP22 à Marrakech. Les émissions de CO2 issues de combustibles fossiles et de l'industrie ont augmenté de 0,2 % en 2016 par rapport à 2015, et s'établissent à 36,4 milliards de tonnes, selon des chiffres encore préliminaires. Dans les années 2000, elles progressaient encore à un rythme de 3 %.

Le dioxyde de carbone est le principal gaz à effet de serre produit par les activités humaines. Le Global Carbon Project, qui regroupe des chercheurs sur le changement climatique, a donc salué la stagnation des émissions alors que la croissance mondiale se poursuit, même s'il estime qu'il faut rester prudent.

Reste que l'année 2016 devrait battre un nouveau record de chaleur avec une température planétaire moyenne supérieure d'environ 1,2°C au niveau de l'ère pré-industrielle, a annoncé récemment l'Organisation météorologique mondiale (OMM). "Tout semble indiquer que 2016 sera l'année la plus chaude" avec une température moyenne "supérieure au record établi en 2015", précise l'organisation. Pour limiter à moins de deux degrés la hausse de la température mondiale, il faudrait "une réduction des émissions de 0,9 % par an jusqu’en 2030", indiquent les chercheurs.

Article rédigé par Georges Simmonds pour RT Flash

WMO

|

|

|

|

|

|

|

|

|

Les insectes seront-ils une part essentielle de l'alimention humaine dans le futur ? C'est bien possible, si l'on tient compte de leur facilité d'élevage, de leur forte concentration en protéines et de leur faible empreinte carbone qui permet de réduire considérablement les émissions de gaz à effet de serre, responsables du réchauffement climatique, puisque l'élevage, notamment dans ses formes industrielles, représente la principale activité humaine source de ces émissions.

Ainsi, anticipant la tendance, certaines industries agroalimentaires, accompagnées de certains chefs cuisiniers, se lancent dans la préparation de toutes sortes de plats à base d'insectes. La gamme est large : des simples vers de farine grillés et agrémentés d'épices aux biscuits, craquelins, voire muffins, où la farine issue d'insectes broyés remplace en partie la farine de blé ou d'autres céréales.

S'il est établi que ces produits apportent des protéines en bonnes quantités, couvrant l'ensemble des besoins en acides aminés de l'organisme humain, il restait à démontrer que les insectes contiennent suffisamment de minéraux essentiels.

Une étude du King's College de Londres et de l'Université Ningbo, en Chine,vient d'apporter une première réponse. Ces recherches ont comparé les apports nutritionnels de quatre espèces d'insectes avec celles du faux-filet et le résultat est étonnant ! Le grillon provençal (Gryllus bimaculatus) rivaliserait en effet avec la viande de bœuf en ce qui concerne les contenus en fer, calcium et manganèse, et présente, de même que le criquet Sphenarium purpurescens et les vers de farine (Tenebrio molitor), de bons niveaux des autres minéraux. En analysant l'assimilation des minéraux dans une culture de cellules humaines mimant le fonctionnement du système digestif, les chercheurs ont même constaté une meilleure assimilation du fer depuis la chair de grillon ou de sauterelle que de bœuf ! Cette étude confirme que les insectes pourraient, en théorie, se substituer largement à la viande dans l'alimention humaine, y compris au point de vue des minéraux.

Article rédigé par Georges Simmonds pour RT Flash

JAFC

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Une équipe de recherche dirigée par Marc Teichmann et Antoni Valero-Cabré, directeur de recherche au CNRS, tous deux rattachés à l’Institut du cerveau et de la moelle épinière (AP-HP/CNRS/UPMC/Inserm), a montré, dans un étude en double aveugle contre placebo, que la stimulation trans-crânienne par courant direct, déjà utilisée pour traiter de nombreux troubles neurologiques ou psychiatriques, serait bénéfique dans le traitement de l’aphasie primaire progressive.

L’aphasie primaire progressive (APP) est une maladie dégénérative qui se caractérise par une perte progressive du langage. La forme la plus fréquente de l’APP, dite « sémantique », est définie par une perte progressive des concepts et du sens des mots. Indépendamment de leur origine, dégénérative ou post-AVC, il n’y a pas de traitement validé pour les aphasies. Les études réalisées jusqu’à maintenant s’appuyaient sur de trop petites cohortes (souvent moins de 6 patients) ou sur des études de cas individuels, rendant difficile l’interprétation des résultats.

La tDCS est une stimulation non-invasive consistant à faire passer un courant continu de faible intensité au moyen de deux électrodes placées sur la peau du crâne. Comme elle ne génère pas de sensations particulières sur la région stimulée, ni les patients ni les médecins ne peuvent différencier la stimulation active du placebo. Les effets cliniques à court terme de trois types de stimulation (anodal-excitatrice du cortex temporal antérieur gauche ; cathodal-inhibitrice du cortex temporal antérieur droit ; stimulation placebo) ont été évalués lors de trois séances espacées d’une semaine. Les effets des trois types de stimulation ont ainsi pu être comparés.

L’effet des stimulations a été évalué par un test sémantique multi-dimensions. L’analyse du contraste avant/après stimulation, en comparant la tDCS gauche et droite à la stimulation placebo a montré plusieurs effets cognitifs significatifs. Il faut noter que la tDCS est moins coûteuse et plus facile d’utilisation que d’autres méthodes de modulation cérébrale non-invasive comme la stimulation magnétique transcrânienne (TMS).

Cette étude pré-thérapeutique suscite maintenant l’espoir de développer des applications cliniques avec des effets plus durables pour les patients atteints d’aphasies d’origine dégénérative. Un protocole à ambition thérapeutique, utilisant des stimulations répétées pendant 10 jours pour induire un effet de plusieurs mois, promu par des mécanismes de neuroplasticité, a été élaboré et a obtenu récemment une promotion de l’AP-HP. A terme, ces traitements par stimulation pourraient être personnalisés en fonction des paramètres crâniens, de la charge et de la distribution lésionnelles de chaque patient.

Article rédigé par Georges Simmonds pour RT Flash

CNRS

|

|

|

|

|

|

|

|

|

Une étude américaine a montré que la première infection grippale construit l'immunité à vie, qui développe, plus loin, le concept d’empreinte immunitaire. Les chercheurs montrent qu’une première exposition à une souche d’un certain sous-type conditionne en effet la sensibilité à d’autres souches d’autres sous-types : ainsi avoir d’abord été exposé aux sous-type H1 ou H2 protège contre les virus H5N1 aviaires...

Dans ces travaux, les scientifiques ont utilisé un modèle mathématique de l'effet protecteur de cette toute première exposition qui, bien entendu, en fonction des générations, des localisations et des souches alors en circulation, peut permettre de prédire la gravité de futures pandémies et de cibler les groupes les plus à risque.

Les chercheurs de l'Université de Californie, de l'Université de l'Arizona et du Fogarty International Center (Maryland) rappellent que les virus grippaux A (et B) transportent 2 groupes de protéines à leur surface, H (ou HA pour hémagglutinine) et N (ou NA pour neuraminidase). Les protéines H semblent pouvoir « imprimer une immunité à vie » : ainsi, une personne exposée à un virus H5 à la petite enfance, sera moins sensible à un virus porteur de H5, mais plus à un virus H7.

Les scientifiques ont utilisé ici les données de cas humains d’infection aux virus grippaux A H5N1 et H7N9 pour regarder comment la première rencontre avec un virus de ce groupe peut apporter une protection à vie contre les autres virus du même groupe A, H5 ou H7. Les chercheurs ont identifié pour chaque année, de 1918 à 2015 et pour 6 pays (Chine, Égypte, Cambodge, Indonésie, Thaïlande et Vietnam), à quel virus de la grippe A les populations avaient probablement été exposées, puis recueilli des données sur les cas connus de H5N1 et H7N9 et leurs distributions par tranches d’âge.

Cette énorme analyse a permis de montrer qu'en termes d’exposition, la souche H1N1 a dominé entre 1918 et 1957 puis H3N2 particulièrement depuis 1968, à l'exception des pics pandémiques de H1N1 de 1977 et 2009. Cette étude montre également qu'il existe une prédominance de H7N9 chez les personnes nées dans la première moitié du 20ème siècle, et une prédominance de H5N1 chez les personnes nées autour de 1968.

Ces résultats contribuent à expliquer la sévérité de certaines épidémies : ainsi la pandémie de grippe massive de 1918 à souche H1N1 a entraîné des taux de décès élevés chez les jeunes adultes, nés entre 1880 et 1900, une période durant laquelle H3 était la souche dominante. En revanche, ces mêmes personnes étaient mieux protégées en 1968, durant l’épidémie de grippe H3 N2.

Article rédigé par Georges Simmonds pour RT Flash

Science Mag

|

|

|

|

|

|

|

|

|

Des chercheurs japonais de l’institut Riken du cerveau ont identifié une anomalie caractéristique du développement neuronal de cellules d’origine schizophrénique. Leurs travaux ont ciblé un gène associé à la schizophrénie, responsable d’une différenciation anormale des neurones qui conduit à un déséquilibre numéraire entre neurones et astrocytes.

De nombreux facteurs sont connus pour contribuer au développement de la schizophrénie. Récemment, une région spécifique du chromosome 22 a été identifiée. Les petites délétions qui y sont observées semblent constituer un facteur de risque particulier pour le développement de la maladie. En effet, ces modifications génétiques ont un impact direct sur le développement et la fonction des cellules neuronales.

En utilisant des cellules IPS d’origine humaine, le Professeur Takeo Yoshikawa et son équipe du Brain Science Institute du Riken ont pu s’intéresser en détail à l’effet de ces mutations sur le développement des cellules du cerveau. De deux sources différentes, les premières cellules IPS étaient issues de patients sains et les secondes provenaient de patients schizophréniques.

Les premiers résultats de la culture cellulaire ont immédiatement mis en évidence une différence entre les deux groupes de cellules. Pour les cellules dérivées de patients schizophrènes, les neuropshères générées - groupes de cellules formées de cellules souches neuronales et de cellules gliales – étaient 30 % plus petites que les neurosphères produites à partir des cellules dérivées de personnes saines. Après la spécialisation des cellules, cette différence s’est traduite par une proportion 10 % plus faible de neurones et par 13 % d’astrocytes en plus pour les cellules IPS d’origine schizophrénique en opposition aux cellules IPS d’origine saine.

Les chercheurs se sont ensuite penchés sur le gène dgcr8, localisé dans la région spécifique du chromosome 22 et connu pour être associé à des neurosphères de plus petite taille. Ils ont d’abord confirmé que l’expression de ce gène était réduite dans les neurosphères issues des cellules IPS dérivées de patients schizophrènes et ont ensuite démontré que la délétion du gène était associée à une proportion plus importante de la protéine p38α, conduisant à une orientation de la différenciation ces cellules souches neuronales davantage vers le type astrocyte.

Ils ont validé leur observations in vivo après avoir trouvé qu’il y avait plus de marqueurs d’astrocytes et moins de marqueurs de neurones dans la région du cortex frontal de cerveaux de patients schizophrènes comparés à ceux de personnes saines. Enfin, ils se sont intéressés à l’enzyme MAP kinase 14 dont l’inhibition conduit à une forme non phosphorylée de la protéine p38α et à une amélioration du déséquilibre entre neurones et astrocytes. Si cibler cette enzyme pourrait constituer une possible thérapie, le Professeur Yoshikawa rappelle néanmoins que toutes les formes de schizophrénie n’impliquent pas une délétion dans la région du chromosome 22.

Article rédigé par Georges Simmonds pour RT Flash

NIH

|

|

|

|

|

|

|

|

|

Le pronostic du cancer de la vessie a peu progressé au cours des dernières décennies, malgré d’importantes avancées en biologie, dans les techniques chirurgicales ou d’imagerie et dans la prise en charge post-chirurgicale. La cystectomie radicale obtient de bons résultats et permet une survie prolongée pour les patients atteints d’un cancer localisé, tandis que le pronostic reste sombre pour plus de la moitié des patients dont le cancer est avancé ou métastasé.

La chimiothérapie péri-opératoire est recommandée en cas de cancer à haut risque, mais son efficacité incertaine et sa toxicité font que son intérêt est encore l’objet de débats. Les éléments cliniques ne permettent pas toujours d’apprécier le risque évolutif réel de la tumeur et l’on ne dispose pas actuellement de biomarqueurs tissulaires ou sanguins qui permettraient de prédire le risque de récidive après cystectomie et qui distingueraient les patients relevant d’une surveillance continue de ceux justifiant d’une prise en charge multimodale post-chirurgicale plus agressive.

Mais une récente étude allemande s'est interessée aux cellules tumorales circulantes dans le sang des patients atteints de cancer de la vessie et a montré que la présence de ces cellules pouvait orienter le pronostic et décider de l’administration ou non de chimiothérapie adjuvante.

Au total, 226 patients ont été enrôlés, atteints d’un cancer urothélial et traités par cystectomie radicale. Parmi eux, 50 ont reçu une chimiothérapie adjuvante à base de sels de platine. Les données ne sont finalement valables que pour 185 patients. Des cellules tumorales circulantes avaient été retrouvées avant le traitement chez 41 d’entre eux.

Après un suivi de 31 mois, il apparaît que, pour les patients qui n‘ont pas bénéficié de chimiothérapie, la présence de cellules tumorales circulantes est associée à un risque supérieur de récidive (Hazard Ratio HR 4,9), de mortalité spécifique et de mortalité totale (HR 4,2).

Cette différence ne se retrouve pas pour les patients qui ont bénéficié de la chimiothérapie, chez lesquels la présence ou non de cellules circulantes n’est pas associée au pronostic. Il a déjà été démontré, pour d’autres tumeurs, qu’il était possible de distinguer les patients à risque à partir des cellules tumorales circulantes. Cette étude confirme qu’elles sont susceptibles d’être utilisées comme des biomarqueurs pour guider la décision d’une chimiothérapie systémique.

Article rédigé par Georges Simmonds pour RT Flash

IJC

|

|

|

|

|

|

|

|

|

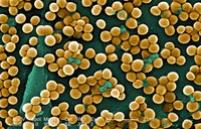

Hôte habituel de notre organisme, le staphylocoque doré (S. aureus) peut tout aussi bien être inoffensif que pathogène, sans que l'on sache exactement ce qui favorise le passage d'un état à l'autre. Deux équipes de l'Inserm ont collaboré pour en détailler les mécanismes, en s'intéressant spécifiquement aux ulcères de pied diabétique : ces plaies, fréquentes chez les personnes souffrant de diabète depuis de nombreuses années, sont souvent colonisées par S. aureus. Certaines restent saines, d'autres se compliquent à la suite de l'invasion des cellules des tissus profonds, notamment osseux, par la bactérie.

Les chercheurs ont montré que cette dichotomie était liée à la présence d'un prophage dénommé ROSA-like : lorsque ce dernier infecte S. aureus, il maintient le microorganisme dans un état inoffensif. Si la bactérie en est exempte, elle peut devenir invasive.

Pour Jean-Philippe Rasigade, auteur principal de cette étude : "Il y a toutes les raisons de croire que ce mécanisme est identique quelles que soient la nature et la localisation de la plaie. S'il est confirmé que ce prophage est absent de toutes les souches de S. aureus invasives, il constituerait à la fois un marqueur prédictif du risque d'infection et une cible potentielle pour développer de nouveaux traitements antibiotiques".

Au démarrage de ces travaux, les scientifiques avaient constaté que le caractère invasif de S. aureus était corrélé à la lignée de la bactérie : certaines étaient invasives, d'autres non. Pour les différencier, ils ont analysé le matériel génétique d'une des souches les moins invasives, CC5/8.

Pour ce faire, un modèle expérimental a été développé dans lequel la souche CC5/8 pouvait expulser le prophage. Dès lors, la lignée est devenue pathogène in vitro sur des cellules de tissu osseux. Si la capacité d'expulsion du prophage n'existe pas dans la nature, elle a néanmoins permis de prouver la corrélation entre la présence du prophage et l'invasivité de la bactérie ainsi que son pouvoir pathogène.

L'équipe du Professeur Jean-Philippe Lavigne cherche aujourd'hui à en détailler les mécanismes biologiques : "D'ores et déjà on sait que le S. aureus porteur du prophage n'est plus capable de capter le fer". Une fois la cascade biologique entièrement décrite, elle pourra constituer une potentielle cible thérapeutique pour combattre les infections à S. aureus.

Article rédigé par Georges Simmonds pour RT Flash

JID

|

|

|

|

|

|

|

|

|

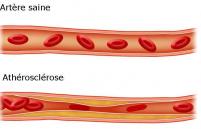

On sait à présent que l’athérosclérose et le psoriasis ont en commun certains mécanismes inflammatoires et il est important de savoir si les traitements anti-inflammatoires des psoriasis sévères agissent sur le risque cardiovasculaire, notamment coronarien. C'est ce qu'a fait une étude danoise menée sur 56 patients psoriasiques, dont 71 % d’hommes, candidats à un traitement par Biologique. Vingt-huit patients l’ont effectivement suivi (anti-TNF-alpha ou anti-IL12/IL23), tandis que 28 autres ont préféré ne pas le prendre, pour des raisons personnelles.

Dans ces deux groupes de patients, qui n’avaient pas de maladie cardiaque, le risque coronarien a été mesuré à deux reprises, à 13 mois d’intervalle. Les auteurs ont évalué le score calcique coronarien, et étudié morphologiquement les artères coronaires par angioscanner. Globalement, l’athérosclérose a progressé lentement dans le groupe témoin, tandis que cette progression était atténuée dans le groupe traité.

Par exemple, le score calcique coronaire a diminué de 16 en un an dans le groupe traité (non significatif) tandis qu’il progressait de 14 dans le groupe témoin. La même évolution a été constatée dans l’étude des rétrécissements coronaires et du volume et de la souplesse des parois artérielles. Il est donc possible de conclure que le traitement du psoriasis par Biologique, notamment anti-TNF-alpha, est susceptible de diminuer la progression de l’athérosclérose coronarienne asymptomatique.

Article rédigé par Georges Simmonds pour RT Flash

ResearchGate

|

|

|

|

|

|

|

|

|

Selon une vaste étude britannique, le nombre d’hypertendus est passé de 594 millions en 1975 (un terrien sur 8) à plus d’1,1 milliard en 2015, soit un terrien sur sept, en raison d’une forte hausse de cette pathologie en Asie du sud et en Afrique subsaharienne.

En se basant sur des données issues de quelque 1.500 études, portant sur 19 millions d’adultes vivant dans 200 pays, elle montre que des pays comme le Canada, le Royaume-Uni, le Pérou et Singapour sont ceux qui avaient le moins d’adultes hypertendus en 2015, soit 1 homme sur 5 et 1 femme sur 8.

A l’inverse, l’hypertension touchait un homme adulte sur trois dans des pays d’Europe de l’Est comme la Croatie, la Hongrie, la Slovénie ou la Lituanie, et une femme adulte sur trois dans la plupart des pays d’Afrique de l’Ouest et du centre (Niger, Tchad, Mali…). Au total, sur les 1,1 milliard de personnes souffrant d’hypertension en 2015, plus de la moitié (590 millions) vivait en Asie, dont 199 millions en Inde et 226 millions en Chine.

« L’hypertension est le principal facteur de risque des accidents vasculaires cérébraux (AVC) et des maladies cardiovasculaires et tue environ 7,5 millions de personnes chaque année dans le monde », souligne le Professeur Majid Ezzati, de l’Imperial College de Londres (Royaume-Uni), principal auteur de l’étude. Néanmoins, le spécialiste estime que « des réductions substantielles de la tension artérielle » devraient être « possibles » à l’avenir dans les pays pauvres « à l’instar de ce qui s’est passé dans les pays à hauts revenus au cours des 40 dernières années ».

Article rédigé par Georges Simmonds pour RT Flash

The Lancet

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|