|

|

Edito

Le développement d’embryons humains in vitro doit nous interroger

Le développement de l’embryon humain constitue l’un des mécanismes les plus extraordinaires et les plus fascinants de la biologie et il n’a cessé de passionner les chercheurs depuis plus d’un siècle. Si l’embryogénèse recèle encore bien des mystères, plusieurs avancées fondamentales récentes sont venues éclairer ce processus déterminant dans le domaine de la fécondité et de la fertilité.

Au début de l’année, des chercheurs du Centre de recherche du Centre hospitalier de l’Université de Montréal (CRCHUM) ont découvrent un élément important pour comprendre comment certaines anomalies surviennent dans le développement de l’embryon.

« Environ la moitié des embryons générés lors des traitements de fertilité contiennent des cellules qui présentent un nombre anormal de chromosomes. On les appelle des embryons en mosaïque. Ils sont considérés de mauvaise qualité, et il est généralement recommandé de ne pas les transférer chez la femme. Nous avons étudié les embryons de souris, et nous avons trouvé par quel mécanisme les cellules défectueuses se divisent et persistent dans le développement de l’embryon », explique Greg FitzHarris, chercheur au CRCHUM et professeur à l’Université de Montréal.

L’aneuploïdie, caractérisée par un nombre anormal de chromosomes dans la cellule, est une anomalie connue depuis longtemps par les scientifiques et elle est généralement associée à l’infertilité dans les ovocytes et les embryons. Mais jusqu’à présent, on ne comprenait pas pourquoi cette aneuploïdie apparaissait.

En ayant recours à des nouvelles techniques de microscopie, ces chercheurs ont découvert que ces cellules défectueuses présentaient une structure particulière : le micronucleus. C’est un petit noyau, une sorte de satellite que l’on trouve à côté du noyau principal. Il contient du matériel génétique provenant du noyau principal. « En suivant une séquence de divisions cellulaires dans le développement d’un embryon présentant un micronucleus, nous avons observé qu’une cellule hérite forcément du micronucleus. Cela suggère que le micronucleus génère l’aneuploïdie, qui cause à son tour les mosaïques embryonnaires », souligne le Professeur FitzHarris.

Selon cette équipe, ce mécanisme découvert chez la souris est très probablement également présent chez l’homme et il pourrait, à terme, permettre un dépistage très précoce, non invasif et beaucoup plus facile de l’aneuploïdie », sans avoir recours à une biopsie de l’embryon, comme cela est le cas actuellement.

Greg FitzHarris souligne cependant que la question de la discrimination des embryons en mosaïque reste scientifiquement controversée. Pour certains biologistes, ces embryons défectueux ne doivent pas être utilisés. Mais d’autres chercheurs et médecins soulignent que des enfants en bonne santé sont probablement issus d’embryons en mosaïque, ce qui renforce l’hypothèse selon laquelle les embryons peuvent se réparer naturellement. Reste qu’au-delà de cette question sur l’utilisation des embryons en mosaïque, cette découverte d’un nouveau mécanisme à l’œuvre dans le développement de l’embryon ouvre la voie vers un nouveau champ de recherche, surtout quand on sait que moins de la moitié des embryons transférés conduisent à une grossesse et qu’il est donc essentiel de parvenir à sélectionner le plus rapidement possible les meilleurs embryons pour augmenter les chances de fécondation..

Il y a deux mois, des recherches menées sur la souris ont permis de franchir une nouvelle étape dans la compréhension du développement embryonnaire (Voir Nature). Des chercheurs de l'Université de Cambridge, de Louvain et du Wellcome Trust ont en effet montré que des embryons contenant des cellules avec un nombre anormal de chromosomes peuvent encore se développer sainement.

Dans ces recherches, les scientifiques se sont concentrés sur la phase qui se déroule immédiatement après la fertilisation de l’ovule par le spermatozoïde, lorsque les 2 cellules sexuelles se multiplient avant de se spécialiser et de former un petit amas de cellules. Celui-ci se développe tout en voyageant dans la trompe de Fallope pour s’implanter environ 9 jours après la fécondation. Les chercheurs ont observé, qu’à ce stade, les embryons précoces contiennent des cellules euploïdes, c’est-à-dire qui contiennent un nombre normal de chromosomes, soit 23 paires et des cellules aneuploïdes, qui à la suite d'une mutation ne contiennent pas le nombre normal de chromosomes.

Les chercheurs savaient que malgré cette anomalie génétique, l’embryon pouvait quand même être viable dans certaines circonstances mais ne comprenaient pas pourquoi. Ces recherches ont montré que des embryons de souris présentant un taux élevé de cellules aneuploïdes défectueuses étaient bien capables de se développer normalement et de devenir des souriceaux en bonne santé. Ces travaux ont notamment permis de découvrir un mécanisme naturel d’autodestruction des cellules défectueuses qui laisse les cellules saines poursuivre leur développement, normalement, ce qui permet dans certains cas à l'embryon de croître sainement.

Les chercheurs ont par ailleurs établi que, de manière logique, plus le taux de cellules défectueuses est élevé, plus les chances de développement normal de l’embryon diminuent. En conclusion, des embryons présentant « un mélange de cellules aneuploïdes et euploïdes » peuvent se développer et s’implanter dans l'utérus avec succès. Même si ces données devront bien entendu être confirmées chez l’Homme, elles ouvrent, dans le prolongement des travaux canadiens, une nouvelle voie très prometteuse de prédiction possible d’un développement sain de l’embryon, ce qui devrait permettre, d’ici quelques années, de rendre les techniques de fécondation in vitro plus sûres, plus fiables et plus efficaces.

Début avril, ce sont cette fois des chercheurs chinois qui ont créé l’événement en annonçant qu'ils avaient réussi à modifier génétiquement des embryons humains afin de les rendre résistants à l’infection du VIH. Dans leur publication, ces scientifiques précisent qu’ils ont eu recours aux puissantes techniques de CRISPR dans des embryons non viables. En avril 2015, une première équipe chinoise avait déjà créé la surprise en réalisant la première modification génétique sur des embryons humains pour traiter une maladie du sang.

Dans ces nouvelles recherches chinoises, les chercheurs qui travaillent à la Guangzhou Medical University ont collecté 213 ovules humains au cours de l’année 2014. Les ovules donnés par 87 patientes étaient inadaptés pour la fertilisation parce qu’elles avaient une paire de chromosomes supplémentaires. L’équipe chinoise a utilisé la technique du CRISPR-Cas9 pour introduire une mutation dans les embryons qui paralysent un gène de cellule immunitaire appelé CCR5. Certaines personnes possèdent naturellement cette mutation qui modifie la protéine CCR5, ce qui empêche le virus du Sida d’infecter les cellules. L’analyse génétique a montré que 4 sur 26 embryons humains ont pu être modifiés. Mais les autres n’ont pas acquis cette mutation tandis que d’autres ont subi des mutations différentes.

Mais ces expérimentations chinoises ont fait l’objet de vives réserves et de sérieuses critiques de la part de plusieurs chercheurs américains et européens qui contestent leur réelle utilité scientifique. George Daley, biologiste réputé dans le domaine des cellules-souches à l’hôpital de Boston, a déclaré que cette étude chinoise montrait simplement qu’il était possible d’utiliser CRISPR pour introduire une modification génétique avec succès. « Cet article est une preuve de plus que le CRISPR fonctionne avec les embryons humains, ce que nous savions déjà et ne présente pas un grand intérêt scientifique », souligne ce chercheur. Xiao-Jiang Li, neuroscientifique à l’Université d’Emory à Atlanta, est tout aussi critique et pense que les chercheurs devraient tester ces techniques dans des primates non humains avant de les tester sur des humains. En revanche, d’autres scientifiques, comme Tetsuya Ishii, biologiste à l’Université d’Hokkaido au Japon, ne voit pas de problèmes éthiques dans ces travaux chinois.

Il y a quelques jours, une équipe internationale de recherche, associant des chercheurs américains de l’Université Rockefeller et des chercheurs anglais de l’Université de Cambridge, a réussi à développer des embryons humains in vitro pendant une durée record de treize jours avant d'arrêter l'expérience, afin de respecter la limite des 14 jours de recherche sur l'embryon actuellement en vigueur dans plusieurs pays (Voir Nature). Pour parvenir à ce résultat, les chercheurs précisent qu’ils ont mis au point de nouvelles techniques de culture imitant l’environnement utérin et que les embryons développés in vitro pendant 13 jours n’ont eu « aucun contact avec des cellules maternelles. « Ce résultat montre la possibilité d’un auto-développement de l’embryon humain mais, à ce stade des recherches, nous n’avons pas la certitude que les embryons étudiés présentent un développement parfaitement similaire à ceux développés dans l’utérus d’une femme », précise le Professeur Magdalena Zernicka-Goetz, responsable de la partie des travaux menés en Grande Bretagne, qui poursuit « L’impossibilité pour un embryon de s'implanter dans l'utérus est une cause majeure de fausses couches précoces, c’est pourquoi ces recherches sont si importantes ».

Mais si ces recherches récentes sur l'embryon constituent d’impressionnantes avancées scientifiques et sont riches de promesses pour mieux lutter contre l’infertilité et mieux comprendre de nombreuses pathologies, elles posent de redoutables problèmes éthiques qu’il va bien falloir affronter. Actuellement, certains pays, comme les Etats-Unis, le Royaume-Uni et l'Australie, limitent la recherche à 14 jours. En France, la recherche sur l'embryon est autorisée depuis 2013, mais strictement encadrée par les lois de bioéthique et contrôlée par l'agence de biomédecine. Dans la fécondation in vitro (FIV), les embryons, développés en éprouvette, doivent être implantés au plus tard le septième jour dans l'utérus de la femme pour pouvoir survivre. Habituellement, plusieurs embryons sont développés pour une seule femme. Un ou deux sont réimplantés pour une tentative de grossesse. Les autres sont congelés pour être utilisés ultérieurement en cas d'échec de l'implantation précédente, de fausse-couche ou de volonté d'une nouvelle grossesse. Seuls les embryons dits « surnuméraires » peuvent être utilisé à des fins scientifiques.

Mais cette démonstration spectaculaire de la possibilité de développer in vitro un embryon humain viable va évidemment relancer le débat éthique sur cette question délicate de l’utilisation des embryons à des fins scientifiques. Pour Magdalena Zernicka-Goetz, « Il faut ouvrir le débat sur une possible extension à 16 jours du développement de l'embryon in vitro, pour étudier la troisième étape de formation de l'embryon ».

En France, l'Académie nationale de médecine a adopté fin avril une position favorable au développement des recherches utilisant la récente technique d'édition du génome, y compris sur l'embryon humain et les cellules reproductrices. En revanche, elle recommande le maintien de la législation française actuelle interdisant "toute intervention sur la structure de l'ADN ayant pour conséquence de modifier le génome de la descendance".

Evoquant le puissant outil Crispr-Cas9, mis au point en 2012 et qui permet de couper l'ADN à un endroit précis et d'introduire des changements dans le génome d'une cellule ou d'un organisme, l’Académie souligne clairement que, « dans l’état actuel des connaissances, cette technique ne doit pas être utilisée sur l'embryon ou les cellules germinales dans le cadre d'applications cliniques ». Néanmoins, l’Académie laisse une porte entre-ouverte en laissant entendre que, si un jour il est établi scientifiquement que cette technique remarquable peut être utilisée de manière sûre pour éviter la transmission d’une pathologie génétique grave à un enfant, elle pourrait revoir sa position.

Ce rapport, rédigé par Pierre Jouannet, professeur émérite à l'Université Paris-Descartes, précise en outre que « Les recherches sur l'embryon humain et les cellules germinales devraient être possibles quand elles sont médicalement et scientifiquement justifiées ». Rappelons qu’en France, le nouveau cadre législatif en matière bioéthique prévoit en matière d’expérimentation sur l’embryon un système plus souple qu’auparavant, reposant sur le principe des autorisations sous conditions.

Tant que les techniques de manipulation du génome étaient peu efficaces dans le domaine de la modification des embryons ou des cellules germinales (qui donnent spermatozoïdes et ovules) et que le développement de l’embryon in vitro était limité à quelques jours, le cadre éthique restait assez abstrait et pouvait être uniforme et relativement simple. Mais ces récentes et extraordinaires avancées de la biologie changent complètement la donne et, que cela nous plaise ou non, elles vont évidemment modifier radicalement l’approche et la conception que nous pouvons avoir de la vie dans sa genèse et son déploiement jusqu’à l’émergence de la conscience.

Il y a quelques jours, Françoise Baylis, titulaire de la chaire canadienne de recherche en bioéthique et philosophie à l’Université Dalhousie, a publié sur cette question un remarquable article qui mérite réflexion (Voir Impact Ethics). Cette chercheuse souligne en effet avec beaucoup de pertinence que la règle de la limite unique des 14 jours, instaurée au niveau international depuis 20 ans pour le développement des embryons humains in vitro, était tenable tant que les scientifiques étaient incapables de conserver les embryons humains vivants en dehors du corps pendant plus de quelques jours (aucune équipe scientifique n’avait réussi jusqu’à la percée récente de ces derniers jours à développer un embryon humain in vitro pendant plus de neuf jours).

Mais à présent que les scientifiques ont montré qu’il était possible de développer un embryon humain viable in vitro, sans doute bien au-delà de cette fameuse limite des 14 jours, nos sociétés sont face à un redoutable problème éthique qui n’a pas de solutions simples. Françoise Baylis pense que nous devons prendre acte de cette rupture scientifique et médicale qu’il n’est plus possible de maintenir en l’état cette règle uniforme des 14 jours, sous peine de dissuader ou de retarder des recherches d’un intérêt absolument fondamental à la fois pour la compréhension profonde de pathologies lourdes et graves, qu’il s’agisse du cancer, de maladies neurodégénératives ou de certains troubles sévères, comme l’autisme et pour l’ouverture de nouvelles voies thérapeutiques révolutionnaires.

Mais il ne saurait non plus être question, sous peine d’ouvrir la porte en grand à des dérives bioéthiques inacceptables, de reculer sensiblement cette limite des 14 jours pour tous les types d’expérimentations touchant à l’embryon humain et qui relèvent de champs et de finalités scientifiques et médicales très différents.

La solution que propose Françoise Baylis pour surmonter ce dilemme est à la fois pragmatique et novatrice : elle consiste à envisager l’élaboration de règles différentes pour diverses catégories de recherche, en fonction de leurs objectifs. Dans ce nouveau cadre éthique différencié, certaines recherches sur l’embryon seraient autorisées moins de 14 jours mais d’autres pourraient l’être au-delà de cette limite, à condition par exemple qu’elles répondent à une finalité thérapeutique très forte.

Cette piste de réflexion, avance Françoise Baylis, pourrait « faire progresser à la fois la science et l’éthique » et c’est bien là tout l’enjeu de ce débat scientifique, démocratique et philosophique majeur qui va animer notre société, à présent confrontée à une accélération sans précédent des progrès des sciences de la vie : comment poursuivre et favoriser ces recherches, qui recèlent un potentiel thérapeutique que nous imaginons à peine, sans renoncer en aucune façon à reconnaître et à respecter la singularité et la dignité irréductible de chaque être humain ?

René TRÉGOUËT

Sénateur honoraire

Fondateur du Groupe de Prospective du Sénat

|

|

|

|

|

|

|

|

Matière |

|

|

Matière et Energie

|

|

|

|

|

|

|

|

|

|

L'histoire des sciences nous montre que les grandes découvertes peuvent naître d’une erreur : c'est par exemple le cas de la découverte de la pénicilline par Fleming en 1928. Cette fois, ce sont des chercheurs de l’Université de Californie à Irvine qui ont découvert comment prolonger la vie de nos batteries. D’habitude, les batteries à base de lithium peuvent supporter environ 7 000 charges et décharges avant de devenir inutilisables. Les chercheurs ont donc travaillé à la mise au point d’une alternative en utilisant des nanofils d’or, des fils plus que microscopiques sur lesquels la science fonde de grands espoirs depuis un moment déjà.

Mais ces fils sont extrêmement fragiles et se détériorent assez rapidement. Ils se trouvaient donc dans une impasse, jusqu’à ce que l’une des étudiantes travaillant sur ce projet, Mya Le Thai, manipule les nanofils avec un gel provenant d’une opération d’électrolyse sur les mains. Elle a alors découvert qu’ainsi protégées ces batteries étaient capables de tenir des centaines de milliers de cycles. Partant de cet « accident », l’équipe de chercheurs a installé le nanofil d’or dans une enveloppe conçue en dioxyde de manganèse et remplacé le lithium par un gel électrolyte.

Après plusieurs mois de tests, ils ont confirmé que ces nouvelles batteries tenaient 200 000 cycles avec une dégradation de seulement 5 % de leurs capacités. Mais les recherches ne vont pas s’arrêter là car, "pour l’instant", indique Reginald Penner, responsable de cette étude, "nous n’avons pas encore tout compris du fonctionnement de ces batteries".

D’ici quelques années, si la fabrication de telles batteries à base de nanofils d’or n’est pas trop coûteuse, on pourrait profiter bien plus longtemps de nos appareils mobiles. Mais cette technologie pourrait aussi permettre à des voitures électriques de rouler plus longtemps…

Article rédigé par Georges Simmonds pour RT Flash

UCI

|

|

|

|

|

|

|

|

|

Aujourd'hui, la part du renouvelable représente 14 % de la production énergétique en France. En 2020, l'objectif est de porter cette proportion à 23 %. Le stockage de cette énergie est un enjeu, évoqué notamment dans la loi sur la Transition énergétique. "A partir du moment où le parc du renouvelable devient important, l'hydrogène est le seul moyen connu pour stocker en grande quantité", explique Philippe Boucly, vice-Président de l'AFHYPAC (Association Française pour l'Hydrogène et les Piles à Combustible) et conseiller spécial chez GRTgaz.

Le "power to gas", la conversion de cette électricité issue du renouvelable (éolien et photovoltaïque), en un autre vecteur énergétique, est une solution pour la stocker. Modifier l'électricité en gaz et plus particulièrement en hydrogène permet de réutiliser cette énergie plus tard, lorsque les utilisateurs en auront besoin.

Cet hydrogène, transformé par électrolyse et ensuite injecté dans le réseau gazier peut ainsi être stocké. Mais selon l'ADEME, la quantité d'hydrogène injectable dans le réseau est limitée à 2 %. Une régulation liée aux préoccupations de sécurité, de fuites et de compatibilité. L'agence environnementale avait alors prévenu que ce gaz transformé ne dépassera pas 15 à 20 % de l'énergie disponible dans le pays.

Dans le Grand port maritime de Marseille, le projet "Jupiter 1000" a été lancé fin mars. Il s'agit du premier démonstrateur de conversion d'électricité issu du renouvelable en gaz en France. D'un coût de 30 millions d'euros, Jupiter 1000 devrait être mis en service en 2018. Le but de ce test est d'étudier la viabilité technique et économique du power to gas en France.

Article rédigé par Georges Simmonds pour RT Flash

La Tribune

|

|

|

|

|

|

|

|

|

Une équipe de recherche allemande du centre de recherche en technologies énergétiques EWE "Next Energy" d’Oldenbourg (Basse-Saxe) a développé le concept "ResiFlow" de batteries électrochimiques "redox vanadium" pour le stockage domestique de l’énergie solaire. La mise sur le marché de ce système est actuellement en cours de préparation.

La combinaison entre une installation photovoltaïque et un système de stockage permet une utilisation de l’énergie solaire aussi pendant la nuit. Les batteries redox vanadium (ou batterie à oxydoréduction au vanadium), sont un type de batterie rechargeable qui utilise le vanadium dans différents états d’oxydation pour stocker l’énergie sous forme de potentiels chimiques. Les batteries à flux stockent l’électricité et la génèrent par réaction d’oxydoréduction. Elles présentent deux compartiments (les cellules de puissance), séparés par une membrane, où sont plongés des collecteurs de courant (les électrodes). La membrane permet l’échange de protons entre les deux compartiments anodique et cathodique, où les solutions électrolytiques sont susceptibles d’être réduites et oxydées.

Les concepteurs de "ResiFlow" avancent les avantages suivant pour leur technologie : la capacité de stockage est paramétrable, simplement en ajoutant de nouvelles unités, la batterie peut être laissée déchargée sur de longues périodes sans se dégrader, elle dispose de deux types de rechargement : rapide par raccrochement de l’électrolyte à une pompe, ou lent en la branchant à une prise de courant.

La réactivité de ces batteries les rend adaptées aux applications nécessitant des stockages rapides, comme une réponse à un pic de consommation (fourniture d’énergie), ou un lissage de la production de sources intermittentes comme les centrales solaires ou éoliennes (stockage d’énergie). L’autodécharge et la maintenance se veulent limitées pour permettre d’introduire ces batteries au sein des foyers.

Les scientifiques ont rendu possible une utilisation à petite échelle de la technologie redox vanadium grâce à un nouveau concept d’étanchéité des compartiments. Cette innovation permet de simplifier la production de l’unité centrale de conversion, mais pourrait aussi réduire, dans le futur, les dimensions et le poids des unités.

En outre, l’efficacité de l’unité de conversion a été augmentée par un procédé breveté pour l’activation de l’électrode de feutre. En effet, dans son état non traité, cette dernière est hydrophobe et inhibe le transport de substances à sa surface. Cependant, avec le nouveau procédé de traitement de surface mis au point, la surface de l’électrode perd ce caractère, ce qui rend toute son efficacité au feutre.

Article rédigé par Georges Simmonds pour RT Flash

IDw

|

|

|

|

|

|

|

|

|

Fondée début 2013, la start-up italienne Watly entend "transformer les conditions de vie des millions de personnes" vivant en Afrique en leur facilitant l'accès à l'énergie et à d'autres services. Pour y parvenir, le président de la société, Marco Attisani, a lancé un vaste défi à ses ingénieurs. Il leur a demandé d'inventer un équipement exclusivement alimenté grâce à l'énergie solaire, qui soit à la fois capable de produire de l'électricité et de l'eau potable. Deux ressources qui font cruellement défaut dans certaines régions d'Afrique.

Le résultat de ces recherches s'appelle "Watly", dont le nom est issu de la contraction des termes anglais "water", "friendly" et "lively". Présentée sous la forme d'un cylindre mesurant 40 mètres de long et pesant près de 15 tonnes, la dernière version de l'appareil, désormais nommé "Watly 3.0" est capable de purifier et de dessaler jusqu'à 5.000 litres d'eau par jour -à condition de remplir ses réservoirs- de produire suffisamment d'électricité pour 3.000 personnes et d'offrir une connexion Internet de bonne qualité. Des performances garanties par la société pendant 15 ans.

Cette dernière évolution devrait être commercialisée auprès d'ONG ou de gouvernements à partir du mois de juin. Marco Attisani estime le coût de fabrication d'une unité à 400.000 euros. En parallèle du lancement commercial, les dirigeants de Watly souhaitent renouveler au cours de l'été 2016 une expérimentation menée au Ghana l'an passé. En 2015, la firme avait alors installé au sein de la ville d'Adenta la version 2.0 de son "super générateur" afin de mener une série de tests en conditions réelles, et surtout d'observer les réactions de la population face à cette technologie.

Article rédigé par Georges Simmonds pour RT Flash

Watly

|

|

|

|

|

|

|

|

|

Notre voisin italien est devenu le premier pays au monde pour l’utilisation de l’énergie solaire photovoltaïque qui couvre désormais 8 % de ses besoins énergétiques, d’après le dernier rapport de l’Agence Internationale de l’Energie (IEA). Dans ce palmarès, derrière l’Italie se trouvent la Grèce avec une couverture de 7,4 % et l’Allemagne avec 7,1 %. La première place de la croissance la plus rapide dans ce domaine sur un an reste à la Chine avec 15 GW (gigawatt), suivie par le Japon et ses 11 GW, puis les Etats-Unis, et l’UE, ex-aequo avec 7 GW. En 2015, la production mondiale d’énergie solaire photovoltaïque a ainsi augmenté de 50 GW. La Chine ou les Etats-Unis ont beaucoup de retard à rattraper, avec une couverture des besoins énergétiques d’1 % environ grâce au soleil.

L’Italie est dans ce domaine largement en avance, notamment grâce à des efforts lancés depuis 2007 et poursuivis par les gouvernements successifs. Développement du parc de panneaux solaires et incitations fiscales ont permis une contribution record de 43 % de la production électrique en 2014. Un pourcentage que le gouvernement entend porter très prochainement à 50 %.

L'Italie a initié depuis longtemps un parcours vertueux en la matière. Ses émissions polluantes ont baissé de plus de 16 % par rapport à 1990. Elle s’est également placée en pointe lors des dernières négociations sur le climat de Paris, lors de la conférence de la COP21, consciente qu’une lutte efficace contre le changement climatique pourrait lui permettre une augmentation d’1,5 % de son PIB.

Article rédigé par Georges Simmonds pour RT Flash

Repubblica

|

|

|

|

|

|

|

|

|

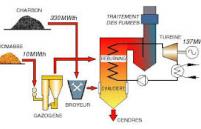

EDF explore de nouvelles pistes d’exploitation lui permettant d’optimiser son bilan écologique et énergétique via la co-combustion de biomasse et de charbon. Un programme de recherche prometteur qui démontre aujourd’hui tout le potentiel énergétique de la biomasse et son adaptabilité aux moyens de production existants.

La biomasse représente l’ensemble de la matière organique (d’origine végétale aussi bien qu’animale) et peut être issue des forêts, des milieux marins et aquatiques, ou encore des déchets organiques. C’est une source d’énergie inépuisable et, surtout, très peu émettrice de gaz à effet de serre. Elle est en effet la première source d’énergie renouvelable en France, devant l’éolien, le solaire et même l’hydraulique, et sert désormais aussi bien pour se chauffer que pour produire de l’électricité.

Le ministère de l’Ecologie a lancé au début du mois de février un appel d’offres sur trois ans (180 MW au total), destiné à privilégier le développement « des technologies de cogénération à haut rendement ». Il s'agit de faire évoluer le dispositif de soutien des filières « bois-énergie » (50 MW par an) et « méthanisation » (10 MW par an), afin d’améliorer l’intégration des installations au système électrique et de se conformer aux lignes directrices européennes en matière d’énergie et d’environnement.

Le cahier des charges contient des mesures visant à éviter les conflits d’usage des forêts et des terres agricoles pour les matières premières utilisées par les installations. Le soutien financier sera apporté sous la forme d’un complément de rémunération.

De son côté, l’énergéticien EDF a lancé au sein de la centrale de Cordemais un programme expérimental baptisé « biomasse et ancrage territorial » destiné à étudier l’intégration de cette source d’énergie renouvelable aux exploitations thermiques existantes. 500 tonnes de biomasse torréfiée, issue de résidus de scieries, ont donc été injectées progressivement durant trois jours dans la chaudière de l’unité de production n°4 de Cordemais, avec pour résultat une baisse immédiate de 17 % des émissions de C02.

Comme l’explique le directeur de la centrale EDF, Denis Florenty, « notre objectif était de prouver qu’il est possible d’injecter un combustible d’origine renouvelable et donc de réduire notre impact CO2 sans avoir à réaliser de modification et d’investissement supplémentaire sur nos installations ».

Inscrit dans le cadre d’un projet de recherche international, mené par l’organisme de recherche canadien CEATI, cette démonstration organisée mi-février avait donc pour objectif premier de tester de nouvelles pistes de développement complémentaires, dans le sens d’une exploitation thermique plus durable. Lors de ces premiers essais, la biomasse représentait 20 % du combustible.

D’autres essais pourraient être envisagés à l’avenir avec de la biomasse locale constituée de matières organiques locales, comme les déchets verts ou les plantes invasives très présentes aux alentours de la centrale.

Un tel projet ouvre la voie à de nouvelles perspectives en matière d’approvisionnement via le recours à des produits non valorisés, et pourrait permettre à terme de développer de nouvelles activités autour des activités historiques, et de combiner rentabilité économique, retombées pour l’économie locale et, surtout, bénéfices écologiques. Il s’intègre de plus parfaitement dans le cadre des nouveaux objectifs du groupe EDF en matière d’énergies renouvelables, à savoir doubler sa capacité de production d’électricité renouvelable, d’ici à 2030, de 28 GW à plus de 50 GW.

Article rédigé par Georges Simmonds pour RT Flash

EDA

|

|

|

|

|

|

|

|

|

La puissance du parc européen a atteint les 100 GWe en 2016. Une croissance extrêmement rapide due en grande partie à la baisse de coût de la technologie et aux soutiens publics. Le solaire devient donc la technologie énergétique qui progresse le plus rapidement en Europe.

Selon l’Association européenne des industriels du secteur, le Vieux monde a raccordé à ses réseaux électriques plus de 100 gigawatts crête de capacité installée photovoltaïque. A titre de comparaison, la capacité de production d’électricité française tourne autour de 140 GWe.

Si la puissance reste inférieure de 40 % à celle de l’éolien, avec ses 14 300 MW installés en 2016, son rythme de déploiement en Europe est bien plus rapide. Entre 2005 et 2016, la puissance du parc éolien européen a un peu plus que triplé. Durant cette décennie, la puissance photovoltaïque est passée de 3 à plus de 100 GWe : une multiplication par 33 !

C’est la baisse de 80 % des coûts en 10 ans et les soutiens publics (tarifs d’achat le plus souvent) qui ont permis cette explosion du solaire, reconnaît SolarPower Europe qui espère que la réforme en cours du marché communautaire de l’électricité et les objectifs fixés par la directive Energies renouvelables permettront la mise en service de 100 nouveaux GWe d’ici à 2020.

Article rédigé par Georges Simmonds pour RT Flash

Euractiv

|

|

| ^ Haut |

|

|

|

|

|

|

|

Terre |

|

|

Sciences de la Terre, Environnement et Climat

|

|

|

|

|

|

|

|

|

|

Selon une étude allemande, deux éruptions volcaniques survenues à quelques années d'intervalle au VIe siècle ont obscurci le ciel de l'Europe pendant plus d'une année, et abaissé la température de deux degrés avec des conséquences dramatiques sur l'agriculture.

La survenue de ces éruptions au début du Moyen-Age, en 536 et en 540, correspond à une ère de déclin social et de turbulences, selon ces travaux qui ont associé science climatique, archéologie et histoire pour la reconstituer. "Prises ensemble, les deux éruptions ont probablement été les événements volcaniques les plus puissants ayant affecté le climat dans l'hémisphère nord dans ces 1.500 dernières années", souligne Matthew Toohey, du Centre de recherche sur les océans GEOMAR Helmholtz à Kiel, (Allemagne) qui a dirigé les recherches.

L'impact combiné des deux éruptions a abaissé la température de deux degrés Celsius pendant ce qui a sans doute été la décennie la plus froide des deux derniers millénaires, a-t-il ajouté au cours d'une réunion de l'European Geosciences Union à Vienne.

Cette chute brutale de la température, causée par l'écran formé devant le soleil par des particules de soufre, a eu un effet dévastateur sur l'agriculture, provoquant une famine dans la plus grande partie de l'Europe et au-delà.

La première pandémie de peste sur ce continent a eu lieu un an seulement après la deuxième éruption, mais on ne sait pas si l'hiver volcanique a joué un rôle direct dans la propagation de la maladie, ont souligné cette semaine M. Toohey et ses collègues dans la revue Climatic Change.

De nombreux récits contemporains des éruptions - dont un de l'historien byzantin Procope de Césarée - ont décrit un "mystérieux nuage" ayant envahi le ciel en 536. "Le soleil a émis une lumière sans brillance, comme la Lune, pendant toute cette année", écrivit Procope, comparant la situation à une interminable éclipse. Les écrits historiques évoquent une famine dévastatrice les années suivantes et un effondrement des structures sociales dans une grande partie du nord de l'Europe.

Ce n'est que récemment que les scientifiques ont apporté la preuve que l'assombrissement solaire avait été dû à deux éruptions volcaniques. Cette preuve est venue du Groenland et de l'Antarctique, sous la forme de carottes de glace qui, en encapsulant des particules de l'atmosphère, permettent de remonter le temps sur des milliers d'années. Non seulement les traces de soufre ont indiqué avec précision les dates des deux éruptions mais les carottes ont aussi révélé que la première avait eu lieu dans l'hémisphère nord et la deuxième quelque part dans les tropiques.

Article rédigé par Georges Simmonds pour RT Flash

Phys

|

|

|

|

|

|

|

|

|

Principal gaz à effet de serre, le CO2 peut aussi contribuer à… limiter le réchauffement climatique. Déjà utilisé comme fluide frigorigène « propre » dans des supermarchés, il se révèle aussi être un agent de transport d’énergie efficace pour le chauffage et la climatisation des bâtiments, et ce, surtout en milieu urbain. Des chercheurs de l’EPFL démontrent le potentiel d’un tel réseau de distribution de chaleur et de froid : une économie d’énergie finale de plus de 80 %.

En Europe, le secteur du bâtiment engendre 40 % de la consommation d’énergie finale et environ un tiers des émissions de gaz à effet de serre. La Suisse ne fait pas exception. En outre, dans une ville comme Genève ou Lausanne, le parc immobilier très hétérogène requiert des besoins de chauffage et de climatisation très divers.

Par exemple, afin de fournir une chaleur confortable, un vieux radiateur doit atteindre au moins 50 degrés tandis qu’un chauffage au sol n’a besoin que de 30 degrés. Par ailleurs, en été, les climatiseurs d’une grande surface fonctionnent à plein régime, dégageant de la chaleur, tandis qu’à quelques mètres de là, une chaudière à gaz assurera l’eau chaude sanitaire à tous les étages.

Un chercheur suisse, Samuel Henchoz, du Groupe d’ingénierie des processus industriels et des systèmes énergétiques, propose un nouveau concept qui repose sur la circulation d’un fluide frigorigène à l’état saturé, en l’occurrence du CO2 sous pression, entre les bâtiments. Comme dans un frigo, le CO2 à l’état liquide s’évapore dans un échangeur de chaleur pour produire du froid. Pour fournir de la chaleur, il fait l’inverse : à l’état gazeux, il restitue sa chaleur dans un échangeur.

Dans le système proposé, du CO2 circule à une température d’environ 15 degrés, proche de son point de saturation entre l’état liquide et gazeux. Etant comparable à la température du sous-sol, cela limite les besoins d’isolation des conduites. Ne craignant pas le gel, celles-ci pourraient même être installées sous les trottoirs. En outre, le gaz étant sous pression et de haute densité énergétique, les conduites peuvent être nettement plus petites que celles d’un réseau à base d’eau.

Autre avantage de ce procédé, le fluide frigorigène récupère la chaleur émise par les refroidisseurs sur son parcours, réduisant d’autant la contribution de la centrale à distance. Le chercheur a effectué une analyse sur un quartier du centre de Genève. Il a comparé les performances énergétiques et la profitabilité économique de cinq variantes de réseaux à fluide frigorigène, un réseau à eau froide et le mélange de systèmes de conversion actuellement utilisés.

Résultat : le système actuel comprenant des chaudières et des unités de réfrigération ordinaires est le pire. Toutes les variantes étudiées permettraient une économie d’énergie finale supérieure à 80 %. La variante la plus prometteuse utilise le CO2 comme fluide de transfert et une pompe à chaleur au CO2 pour les ajustements de température.

Elle coûterait initialement entre 27 et 35 millions de francs pour le quartier étudié et deviendrait rentable 4 à 6 ans après sa mise en service. La seconde meilleure option, bien que plus chère, est un réseau à eau froide, présentant des avantages en matière de sécurité et de disponibilité des composants. "Contrairement aux fluides frigorigènes synthétiques, le CO2 est naturel, bon marché, non inflammable et non toxique, rappelle Samuel Henchoz. Cependant, il doit circuler sous une pression de 50 bars, ce qui est inédit et demande une adaptation des normes officielles".

Article rédigé par Georges Simmonds pour RT Flash

EPFL

|

|

| ^ Haut |

|

|

|

|

|

|

|

Vivant |

|

|

Santé, Médecine et Sciences du Vivant

|

|

|

|

|

|

|

|

|

|

Des chercheurs de l’Université de Lund en Suède ont montré que les protéines matricielles oligomériques du cartilage (COMP pour Cartilage Oligomeric Matrix Protein), qui existent principalement dans le cartilage, peuvent également être observées dans des tumeurs chez des patientes atteintes de cancer du sein. La présence de ces protéines dans les cellules tumorales est associée à un pronostic défavorable. Des études sur des souris ont également démontré que la protéine COMP contribue au développement et à la métastase du cancer du sein.

COMP est une protéine qui jusqu’ici a principalement été étudiée dans les tissus du cartilage, où elle contribue à son développement et à sa structure. COMP est aussi utilisée comme un marqueur de lésions du cartilage dans les maladies articulaires.

C’est en faisant une recherche dans une base de données que le groupe de chercheurs a découvert un lien entre COMP et le cancer du sein, ce qui a suscité leur intérêt et les a menés à construire cette étude.

« Nous ne nous attendions pas à trouver une relation entre COMP et le cancer du sein, et nous avons été surpris de voir l’effet important qu’elle a eu sur le développement du cancer chez les souris », nous dit Emelie Englund, docteur en sciences médicales au département de médecine translationnelle de Université de Lund. Les résultats ont été obtenus grâce à une étude clinique des tissus mammaires de plus de 600 femmes atteintes d’un cancer du sein.

Diverses quantités de COMP ont été retrouvées dans les tumeurs et dans les tissus avoisinants, mais jamais dans les tissus mammaires sains. Une concentration de COMP élevée dans ces tissus est associée à une augmentation du nombre de métastases, à une probabilité plus importante de rechute, et à une augmentation de la mortalité chez ces patientes. « Nous avons vu une association claire entre des niveaux élevés de COMP et un pronostic du cancer du sein moins bon. COMP a le potentiel de devenir un indicateur pour les cancers du sein agressifs, et ainsi fournir des informations précieuses en amont de la décision pour un traitement plus approprié », nous explique Anna Blom, professeur de chimie des protéines à l’Université de Lund.

Suite à cette étude clinique, le groupe a continué ses recherches sur les mécanismes moléculaires qui pourraient expliquer l’influence de COMP sur le développement du cancer du sein.

Ces études, dont une sur des souris, ont montré que la présence de COMP contribue non seulement à une croissance plus rapide de la tumeur primaire, mais également à la formation de métastases. COMP permet aux cellules de devenir plus résistantes et insensibles au phénomène d’apoptose (mort cellulaire programmée).

Le groupe de chercheurs compte maintenant entreprendre des études plus poussées sur ces métabolismes cellulaires. Les résultats préliminaires indiquent que la présence de cette protéine pourrait aussi être importante dans le développement du cancer de la prostate.

Article rédigé par Georges Simmonds pour RT Flash

Lund University

|

|

|

|

|

|

|

|

|

Une nouvelle forme orale double face développée par une équipe du Massachusetts Institute of Technology permet de libérer dans l’organisme un principe actif beaucoup plus longtemps que toute autre pilule ou comprimé classique. En effet, avec sa face muco-adhésive, le comprimé se colle à la muqueuse intestinale, et avec sa face omniphobique, il repousse les liquides et les aliments susceptibles de l’entraîner et de l’évacuer.

Les comprimés ou formes orales classiques, même à libération prolongée, ont l’inconvénient de ne pas rester assez longtemps dans le tractus digestif pour libérer toute leur dose de principe actif, car ils se font entraîner par la nourriture et les liquides présents dans l’estomac et les intestins. La pilule double face permet ainsi de libérer plus de substance active et de réduire significativement la fréquence d’administration de doses de médicament et, au final, d’améliorer l’observance.

Dans le détail, la face adhésive est composée de carbopol, un polymère muco-adhésif qui montre une forte adhésion lorsqu’il est mouillé ; la face omniphobique comporte un surfaçage fluoré et lubrifié. Un système de pression permet de combiner les deux faces et les principes actifs peuvent être intégrés dans l’une des couches, ou entre les deux couches du dispositif. Testée sur du tissu intestinal de porc, la pilule double face s’est montrée capable de rester attachée jusqu’à 10 minutes aux tissus intestinaux. D’autres tests in vivo sont prévus chez l’animal.

Article rédigé par Georges Simmonds pour RT Flash

Wiley

|

|

|

|

|

|

|

|

|

Des chercheurs d’une unité Inserm de Clermont-Ferrand viennent d’ouvrir une nouvelle piste thérapeutique pour lutter contre la maladie de Crohn en montrant comment les cellules épithéliales intestinales empêchent des bactéries pro-inflammatoires de se multiplier.

La maladie de Crohn est due à une réaction immunitaire exacerbée contre des bactéries de la flore intestinale. Elle dépend à la fois de facteurs génétiques, environnementaux et microbiens. La composition de la flore intestinale semble notamment jouer un rôle important dans la pathogenèse. Ainsi, près de 40 % des patients présentent une surpopulation de bactéries E. coli nommée AIEC (pour Adhérent-Invasive Escherichia coli), contre seulement 6 % des individus de la population générale.

Or, ces bactéries ont la capacité de traverser le mucus qui tapisse la paroi intestinale et d’envahir les cellules épithéliales qui constituent cette paroi. Cela provoque une réponse immunitaire forte, avec la production de plusieurs médiateurs d’inflammation qui contribuent à la maladie.

Pour se défendre contre cette invasion, les cellules épithéliales intestinales déclenchent un mécanisme d’autophagie, consistant à repérer la bactérie qui s’est introduite et à l’isoler dans une vacuole qui, en fusionnant avec le lysosome, entraîne la dégradation du pathogène. Une réaction précieuse pour lutter contre l’inflammation associée à cette infection. Seulement voilà, les chercheurs ne comprenaient pas comment ce mécanisme était activé…

Pour le découvrir, ils ont travaillé sur des cellules en culture et des modèles murins infectés par une souche AIEC. Mais surtout, ils ont étudié le rôle d’une voie de signalisation déjà utilisée par ces cellules pour se défendre d’autres bactéries intestinales, à savoir Shigella et Salmonella, la voie EIF2AK4-EIF2A/eIF2α-ATF4 .

"En cas d’infection par Shigella ou Salmonella, une carence en acides aminés active le facteur de transcription ATF4, qui provoque lui-même l’expression de gènes impliqués dans l’autophagie, explique Hang Nguyen, responsable de ces travaux. Nous avons voulu savoir si cette même voie était impliquée dans la lutte contre les AIEC".

En procédant à différentes expériences, les chercheurs ont constaté que le fait d’inhiber la voie EIF2AK4-EIF2A/eIF2α-ATF4 entraîne une augmentation considérable de la prolifération intracellulaire des bactéries AIEC dans les cellules épithéliales. A l’inverse, la stimuler empêche les bactéries de se multiplier. Ils ont ensuite étudié le niveau d’activation de cette voie dans des biopsies de patients : elle s’est avérée inactivée dans les zones enflammées du tissu intestinal et, au contraire, en bon état de marche dans les zones non enflammées. Moduler le niveau de cette réponse autophagique chez les patients porteurs de bactéries AIEC pourrait donc aider à contrôler l’inflammation.

Article rédigé par Georges Simmonds pour RT Flash

Autophagy

|

|

|

|

|

|

|

|

|

Une vaste étude américaine confirme que le fait de pratiquer la musculation seulement deux fois par semaine permettrait aux seniors de vivre plus longtemps. Si de précédentes études avaient démontré les bénéfices de l'activité physique en général chez les seniors, elles n'avaient pas permis de récolter beaucoup d'informations sur les bénéfices de la musculation.

Des études de moindre envergure avaient permis de vérifier que la musculation était utile à ceux qui souffraient de maladies chroniques comme le diabète, l'ostéoporose, la sciatique et l'obésité. Une plus grande force musculaire est associée à un abaissement du risque de mortalité. Cette étude est cependant la première à mettre en évidence un lien entre une force musculaire accrue et un risque abaissé de mortalité sur un échantillon si important, si représentatif et sur une période aussi longue.

Menée par des équipes des Penn State College of Medicine, Penn State Health Milton S. Hershey Medical Center et Columbia University, l'étude se penche sur des données recueillies entre 1997 à 2001 par la National Health Interview Survey (NHIS). Elles concernent 30.000 adultes âgés de 65 ans et plus dans chaque état des États-Unis.

L'équipe a observé qu'un peu plus de 9 % des seniors rapportaient faire de la musculation au moins deux fois par semaine. Cela représente une petite partie de la population, mais le chiffre s'avère supérieur à celui auquel s'attendaient les chercheurs. Ceux-ci ont suivi ce groupe pendant 15 ans et se sont appuyés sur des certificats de décès pour savoir qui était décédé en 2011.

Par rapport à ceux qui ne pratiquaient par la musculation, ceux qui le faisaient au moins deux fois par semaine étaient moins exposés aux arrêts cardiaques mortels (-41 %), de cancers fatals (-19 %) et plus largement aux maladies mortelles (-46 %). Ceux qui pratiquent la musculation bénéficient d'un accroissement de l'espérance de vie plus important que ceux qui font de l'exercice autrement. Selon l'équipe, ces résultats suggèrent que les bienfaits de la musculation vont bien au-delà du simple accroissement ou renforcement de la masse musculaire.

Article rédigé par Georges Simmonds pour RT Flash

Penn State News

|

|

|

|

|

|

|

|

|

Les chercheurs de la faculté de médecine et de chirurgie de l’Université Catholique du Sacré Coeur, en collaboration avec l’Institut des Systèmes Complexes du Conseil National des Recherches (Isc-Cnr, Rome), ont découvert un nouveau désinfectant hospitalier : il s’agit d’un composé (gel ou liquide) à base de graphène, un nanomatériau constitué de carbone, que l’on trouve dans les mines de crayon en graphite.

L’équipe de recherche formée de Marco De Spirito, Massimiliano Papi, Maurizio Sanguinetti et Francesca Bugli, ainsi que Claudio Conti, directeur de l’Isc-Cnr, a découvert que le graphène, et plus encore l’oxyde de graphène, peut anéantir les bactéries et les champignons tueurs des hôpitaux comme le Staphylococcus aureus et le Candida albicans. L’étude a été présentée par Valentina Palmieri à l’occasion du 60ème congrès annuel de la Société de Biophysique qui se déroulait au mois de mars à Los Angeles.

L’équipe a observé l’effet de l’oxyde de graphène sur trois bactéries : le Staphylococcus aureus et l’Enterococcus faecalis, causes d’infections opportunistes et nosocomiales, et la bactérie Escherichia coli, qui provoque de graves intoxications alimentaires.

Les chercheurs ont démontré que l’oxyde de graphène est capable d’éliminer presque 90 % des S.aureus et E. faecalis, et 50 % des E. coli, en moins de deux heures. Le graphène a un triple mécanisme d’action : il peut tailler la paroi bactérienne, isoler les bactéries ou les empêcher de se multiplier en les “suffoquant”.

C’est cette triple action qui le rend plus efficace que les autres agents antibactériens déjà en usage. Le graphène a également le double avantage d’être un matériau respectueux de l’environnement et d’être disponible à des prix contenus. Enfin, le graphène pourrait être utilisé pour recouvrir les instruments médicaux et chirurgicaux et, de cette façon, contribuer à réduire les infections, surtout après une intervention chirurgicale, autrement que par l’administration d’antibiotiques.

Article rédigé par Georges Simmonds pour RT Flash

CNR

|

|

|

|

|

|

|

|

|

A Toulouse, au laboratoire CNRS du LAAS, une équipe travaille sur la mise au point de micropuces électroniques capables de repérer dans le sang ou la salive des molécules cancéreuses aujourd'hui indétectables. Des puces électroniques pas plus grosses que le diamètre d'un cheveu pour détecter et combattre le cancer, de la science-fiction ? Pas pour l'équipe NanoBioSystèmes (NBS), au LAAS CNRS (Laboratoire d'analyse et d'architecture des systèmes/Centre national de la recherche scientifique) de Toulouse.

Depuis deux ans, elle travaille à la mise au point de BioMEMS, des microsystèmes électro mécaniques dans le domaine de la santé. L'idée est de parvenir à concevoir des MEMS (Micro-Electro-Mechanical Systems), microsystèmes électromécaniques, pour détecter à coup sûr les cellules cancéreuses, même en infime quantité !

En lien avec l'équipe de Pierre Cordelier au Centre de recherche en cancérologie de Toulouse (CRCT/Inserm) et sur un financement Idex (initiatives d'excellence, Université fédérale de Toulouse), des ingénieurs physiciens du LAAS cherchent à concevoir des BioMEMS capables de détecter plus tôt le cancer du pancréas. L'enjeu est d'importance pour une maladie dont le diagnostic est souvent posé trop tardivement.

Travailler sur cette nouvelle classe de biomarqueurs est très pertinente : "les micros ARN sont des molécules très robustes, plus facilement manipulables que les protéines. Les possibilités pour les nouvelles technologies sont incroyables", souligne Thierry Leïchlé, responsable adjoint de l'équipe NanoBioSystèmes au LAAS.

Dans la vaste salle blanche du laboratoire toulousain, les premières puces prennent forme sur les plaques de silicium. "Nos capteurs MEMS ne sont pas plus grands que le diamètre d'un cheveu. Ils fonctionnent comme une microbalance intelligente capable de détecter une molécule spécifique.

Une plaque de 10 cm de diamètre contient des centaines de puces pouvant être équipées de plusieurs détecteurs. La fabrication à grande échelle permet de réduire les coûts et laisse imaginer, à plus long terme, la possibilité de réaliser les tests à domicile avec un lecteur électronique de liquide physiologique (sang, salive) et des puces à usage unique vendues en pharmacie. Un tel dispositif ‘‘au pied du patient'' pourra permettre une médecine vraiment personnalisée avec un cocktail thérapeutique adapté" complète Thierry Leïchlé.

Article rédigé par Georges Simmonds pour RT Flash

Laas

|

|

|

|

|

|

|

|

|

Une équipe de recherche française « Développement et plasticité du cerveau neuroendocrine » dirigée par Vincent Prévot, Directeur de recherche Inserm (Centre Jean-Pierre Aubert, Lille), vient de découvrir que des ARN particuliers de petite taille sont responsables du contrôle de l’expression de la gonadolibérine ou GnRH (Gonadotropin Releasing Hormone), une neurohormone qui pilote la maturation sexuelle, l’apparition de la puberté et la fertilité à l’âge adulte.

L’intervention des micro-ARNs, transcrits de l’ADN, s’opère autour de la naissance et marque une étape clé du développement postnatal. Une défaillance de l’action de ces micro-ARNs entraîne une perturbation, voire l’arrêt total de la production de GnRH par les neurones de l’hypothalamus qui la synthétise, et ainsi une infertilité. Dans les cas les plus graves, une stérilité peut intervenir.

La fonction de reproduction est déterminée par des événements qui prennent place dans le cerveau. La gamétogenèse (la production de spermatozoïdes et d’ovocytes) et les secrétions hormonales des ovaires et des testicules dépendent étroitement de l’hypophyse, une petite glande située sous le cerveau auquel elle est reliée par un réseau capillaire. Cette dernière est elle-même sous le contrôle du « chef d’orchestre » des glandes situé à la base du cerveau, l’hypothalamus.

Au cours du développement postnatal, l’activation d’une poignée de neurones très spécialisés (les neurones à GnRH) de l’hypothalamus entraîne la synthèse d’une hormone, la gonadolibérine ou GnRH (Gonadotropin Releasing Hormone) et ce processus conduit à l’apparition de la puberté.

Cette étape, appelée « mini-puberté » constitue la première activation de l’axe reproducteur par le cerveau. Elle survient entre le premier et le troisième mois de vie chez le nourrisson et conditionne le bon déroulement de la maturation sexuelle. Au moment de la puberté, la GnRH stimule la synthèse par l’hypophyse d’autres hormones, qui à leur tour vont passer dans le sang pour promouvoir la croissance des gonades (ovaires, testicules), puis pour assurer la fonction reproductive.

Ces 30 dernières années, la découverte de mutations dans différentes parties du génome de patients souffrant de troubles de la puberté a permis d’identifier quelques gènes impliqués dans ce processus. Cependant, les médecins et les scientifiques estiment que ces gènes ne sont responsables que d’un tiers des problèmes de puberté rencontrés chez les patients. La découverte de l’implication des micro-ARNs ouvre d’importantes perspectives médicales pour la prise en charge de ces patients aussi bien d’un point de vue diagnostique que thérapeutique.

Les micro-ARNs sont des ARN non-codants de petites tailles transcrits à partir de notre ADN. Contrairement aux ARN messagers (ARNm), ils ne sont pas traduits en protéines. De ce fait, les micro-ARNs ne font pas partie du « génome codant » et constituent ce que certains appellent l’épi-génome. Les régulations opérées par les micro-ARN sur l’expression des gènes, comme celui de la GnRH, sont donc considérées comme étant des régulations de type « épi-génétique ».

Les recherches menées par l’équipe de Vincent Prévot chez la souris montrent que la naissance induit un changement radical de l’expression des micro-ARNs dans les neurones à GnRH de l’hypothalamus. Cette modification du profil d’expression des micro-ARNs est indispensable à l’inhibition de l’expression des facteurs de transcription (protéines qui activent ou inhibent l’expression de gènes) qui ont un effet répresseur sur l’expression de la GnRH.

Cette inhibition de facteurs inhibiteurs va permettre l’augmentation de la production de GnRH qui est indispensable à la maturation sexuelle infantile et juvénile et à la survenue de la puberté. En effet, en l’absence de micro-ARNs, l’expression des facteurs de transcriptions inhibant l’expression de GnRH augmente et entraîne l’extinction de la synthèse de GnRH par le cerveau, ce qui conduit à l’arrêt de la maturation sexuelle, l’absence de puberté et à une stérilité totale chez les individus adultes.

L’analyse du gène de la GnRH chez l’homme montre que des phénomènes analogues pourraient se produire dans notre propre espèce. Le mécanisme élucidé par cette équipe pourrait donc expliquer l’absence de puberté et l’infertilité chez certains patients pour qui aucune mutation ou polymorphisme (variation dans la séquence d’ADN) n’a été identifiée dans le génome codant.

Article rédigé par Georges Simmonds pour RT Flash

Inserm

|

|

|

|

|

|

|

|

|

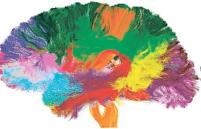

Des chercheurs américains ont réussi la prouesse d'établir un altlas du cerveau d'une précision sans précédent qui cartographie la façon dont le cerveau représente le sens de la langue parlée, mot par mot. L'exploit est d'autant plus remarquable qu'il s'agit d'une cartographie en temps réel de notre cerveau, en train de déchiffrer des mots. Mais surtout elle montre que le langage n’est pas limité comme on le croyait à certaines zones précises du cerveau, situées plutôt dans l’hémisphère gauche. Ces travaux montrent en effet que pour comprendre le langage, nous utilisons un nombre impressionnant de régions du cerveau, réparties dans des zones très éloignées les unes des autres.

Jack Gallant, neuroscientifique à l’Université de Berkeley, et ses collègues, dont l’auteur principal Alex Huth, ont voulu savoir comment notre cerveau réagit quand on nous raconte une histoire. Gallant décrit les ambitions de sa recherche au Guardian : « Notre objectif était de construire un atlas géant qui montre comment un aspect spécifique de la langue est représenté dans le cerveau, dans ce cas, la sémantique, ou la signification des mots ».

Pour ce faire, ils ont demandé à sept participants d’écouter un célèbre programme de contes diffusés à la radio : The Moth Radio Hour. Ils ont relié chaque participant à un IRM fonctionnel, une machine qui mesure le flux sanguin et l’activité des neurones dans le cerveau. Ainsi équipés, il était possible de voir les cerveaux des participants en action et de représenter sur des cartes l’activité qui s’y déployait. Ils ont ensuite associé les transcriptions mot à mot des contes entendus par les participants aux cartes produites par l’IRM. Les chercheurs ont pu ainsi détecter comment chaque mot déclenchait telle ou telle zone du cerveau.

En rassemblant les informations de tous les participants dans un modèle statistique, les chercheurs sont parvenus à créer un atlas du cerveau, un modèle 3D qui montre quelles zones sont allumées par tous les participants en réaction à des mots.

Les chercheurs de Berkeley ont découvert que les mots déclenchaient plus d’une centaine de zones différentes dans le cerveau. Certaines régions étant même systématiquement activées par tous les participants par certains mots. Ainsi, par exemple, des mots connotant des lieux activent certaines zones alors que les mots connotant des chiffres ou des quantités en allument d’autres.

Cette recherche montre que chaque mot déclenche plusieurs zones du cerveau, comme une sorte de réseau qui représenterait la signification de chaque mot que nous utilisons. À droite, près du sommet de la tête, se situe l'un des endroits du cerveau activé par les termes de l’univers de la famille : "femme", "mari", "enfants", "parents". Chaque mot est représenté par plus d'un spot parce que les mots ont tendance à avoir plusieurs significations. Ce qui est frappant dans cette étude, c’est que les atlas du cerveau étaient similaires pour tous les participants, ce qui suggère que leurs cerveaux ont organisé le sens des mots de la même manière.

Article rédigé par Georges Simmonds pour RT Flash

Nature

Atlas

|

|

| ^ Haut |

|

|

|

|

|

| VOTRE INSCRIPTION |

|

Vous recevez cette lettre car vous êtes inscrits à la newsletter RTFLash. Les articles que vous recevez correspondent aux centres d'intérêts spécifiés dans votre compte.

Désinscription Cliquez sur ce lien pour vous désinscrire.

Mon compte pour créer ou accéder à votre compte et modifier vos centres d'intérêts.

|

|

|

|

|

|